Coursera吴恩达《卷积神经网络》课程笔记(2)-- 深度卷积模型:案例研究

《Convolutional Neural Networks》是Andrw Ng深度学习专项课程中的第四门课。这门课主要介绍卷积神经网络(CNN)的基本概念、模型和具体应用。该门课共有4周课时,所以我将分成4次笔记来总结,这是第2节笔记。

本周课程将主要介绍几个典型的CNN案例。通过对具体CNN模型及案例的研究,来帮助我们理解知识并训练实际的模型。

典型的CNN模型包括:

LeNet-5

AlexNet

VGG

除了这些性能良好的CNN模型之外,我们还会介绍Residual Network(ResNet)。其特点是可以构建很深很深的神经网络(目前最深的好像有152层)。

另外,还会介绍Inception Neural Network。接下来,我们将一一讲解。

LeNet-5模型是Yann LeCun教授于1998年提出来的,它是第一个成功应用于数字识别问题的卷积神经网络。在MNIST数据中,它的准确率达到大约99.2%。

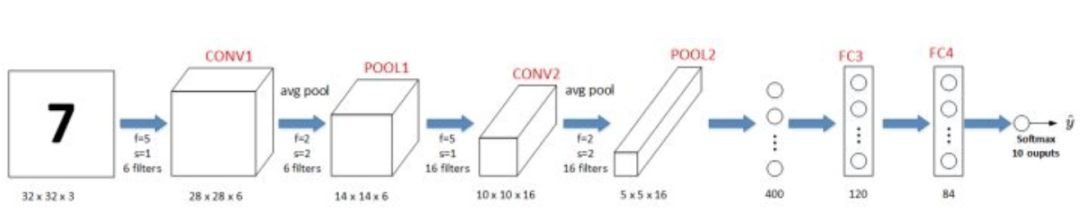

典型的LeNet-5结构包含CONV layer,POOL layer和FC layer,顺序一般是CONV layer->POOL layer->CONV layer->POOL layer->FC layer->FC layer->OUTPUT layer,即 y^。下图所示的是一个数字识别的LeNet-5的模型结构:

该LeNet模型总共包含了大约6万个参数。值得一提的是,当时Yann LeCun提出的LeNet-5模型池化层使用的是average pool,而且各层激活函数一般是Sigmoid和tanh。现在,我们可以根据需要,做出改进,使用max pool和激活函数ReLU。

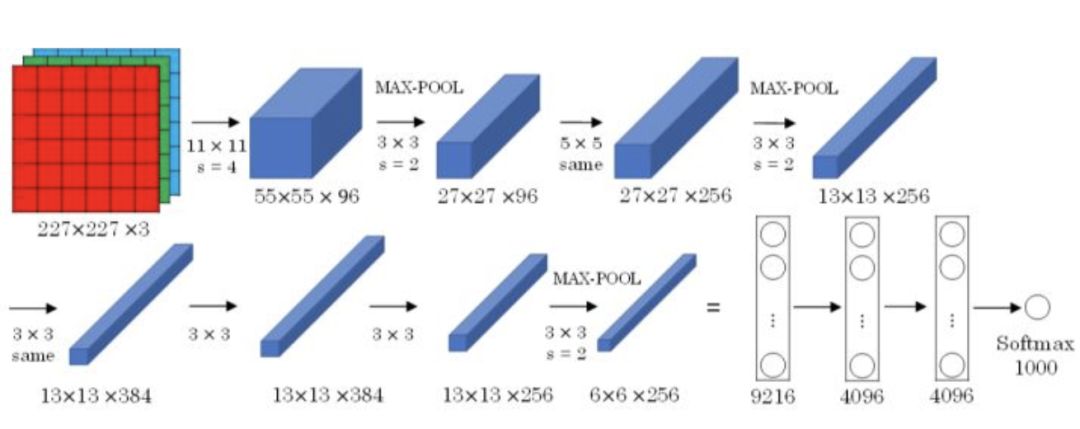

AlexNet模型是由Alex Krizhevsky、Ilya Sutskever和Geoffrey Hinton共同提出的,其结构如下所示:

AlexNet模型与LeNet-5模型类似,只是要复杂一些,总共包含了大约6千万个参数。同样可以根据实际情况使用激活函数ReLU。原作者还提到了一种优化技巧,叫做Local Response Normalization(LRN)。 而在实际应用中,LRN的效果并不突出。

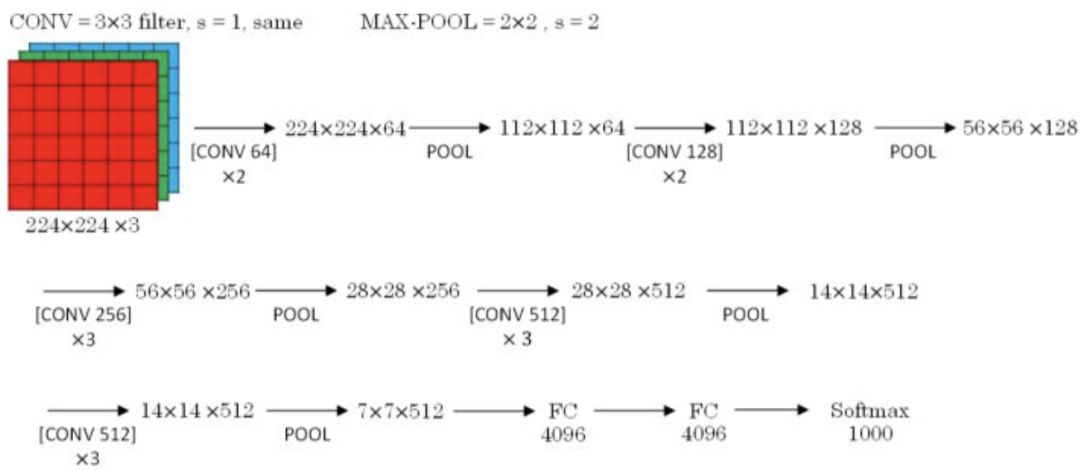

VGG-16模型更加复杂一些,一般情况下,其CONV layer和POOL layer设置如下:

CONV = 3x3 filters, s = 1, same

MAX-POOL = 2x2, s = 2

VGG-16结构如下所示:

VGG-16的参数多达1亿3千万。

转自:机器学习算法与自然语言处理

完整内容请点击“阅读原文”