【Google 大脑】使用上千个优化任务学习超参数搜索策略,Using a thousand optimization task

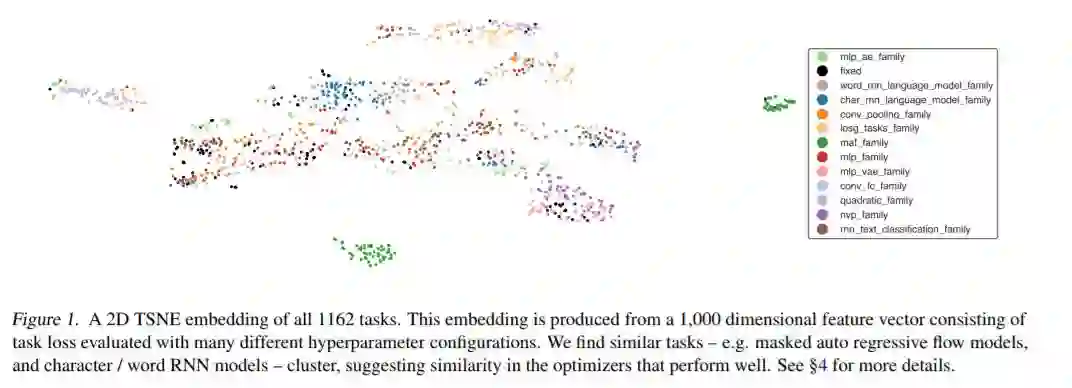

我们提供TaskSet,一个用于训练和评估优化器的任务数据集。TaskSet在规模和多样性上都是独一无二的,它包含了超过1000个任务,从使用全连接或卷积神经网络的图像分类,到变分自编码器,再到各种数据集上的非卷保存流。作为此类数据集的一个示例应用程序,我们将探索元学习一个超参数的有序列表并按顺序进行尝试。通过从使用TaskSet生成的数据中学习这个超参数列表,我们实现了比随机搜索更大的样本效率提升。接下来,我们利用任务集的多样性和我们学习超参数列表的方法,对这些列表在各种环境下的泛化进行了实证研究,包括使用Resnet50的ImageNet分类和使用transformer的LM1B语言建模。作为这项工作的一部分,我们为所有的任务提供了开源代码,并为这些问题提供了2900万条训练曲线和相应的超参数。

https://www.zhuanzhi.ai/paper/fd6cde61607aad0a7bb871694b61a08e

专知便捷查看

便捷下载,请关注专知公众号(点击上方蓝色专知关注)

后台回复“HSS” 就可以获取《【Google 大脑】使用上千个优化任务学习超参数搜索策略,Using a thousand optimization task》论文专知下载链接

登录查看更多

相关内容

专知会员服务

21+阅读 · 2020年3月28日

Arxiv

7+阅读 · 2019年2月8日