Python网络爬虫与信息抽取笔记05 爬虫实战1

【导读】我们在上一节的内容中已经为大家对Robots协议进行讨论,这一节将主要实战爬虫。本文内容讨论了实战爬虫的三个例子:爬取京东网页,爬取亚马逊网页以及搜索引擎关键词提交接口。话不多说,让我们一起学习这些内容吧。

Python网络爬虫与信息抽取笔记01 课程框架和Python IDE工具

Python网络爬虫与信息抽取笔记02 requests库入门

视频网址:

https://www.bilibili.com/video/av9784617?from=search&seid=240663710546169136

http://www.icourse163.org/course/BIT-1001870001?tid=1001962001

Python网络爬虫与信息抽取05 爬虫实战1

1.爬虫引发的问题

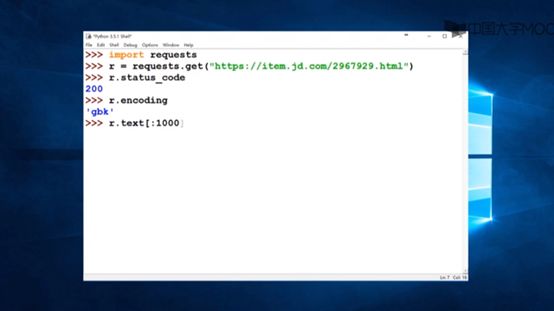

先爬取京东的商品网页,https://item.jd.com/2967929.html

输入以前介绍的指令

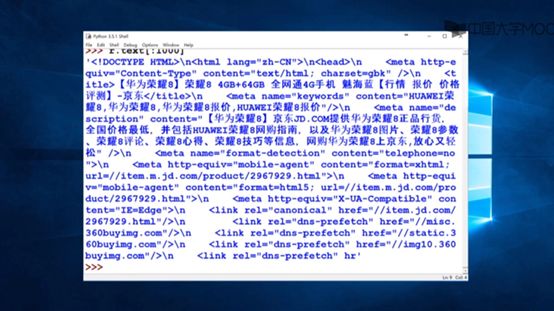

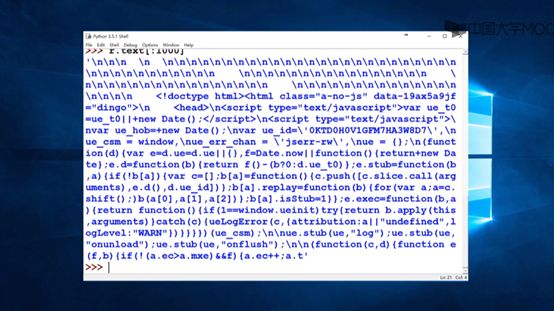

输入r.text[:1000],查看前1000个字符

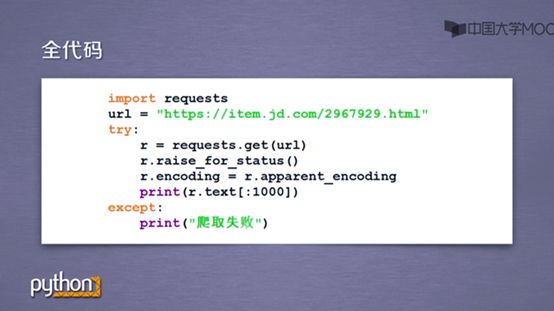

于是我们可以写个用之前的爬虫框架,将京东的网址代入其中

2.爬取亚马逊网页

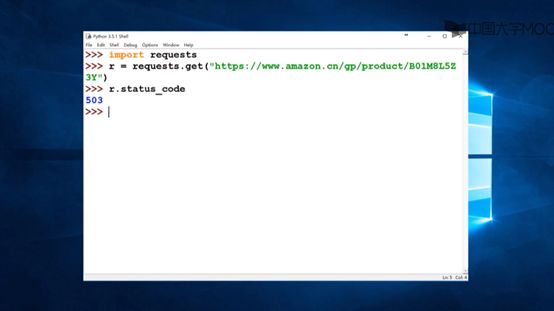

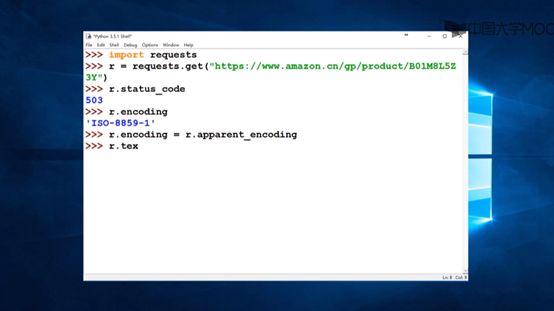

接下来对亚马逊商品页面爬取,https://www.amazon.cn/gp/product/B01M8L5Z3Y

输入之前的指令,会发现返回服务器返回503,说明爬取失败,为什么呢

我们继续输入指令,看看服务器响应的内容是什么

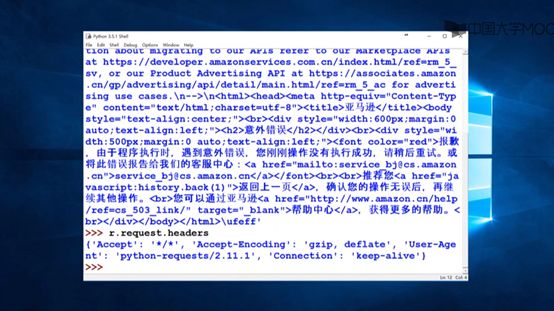

发现访问失败

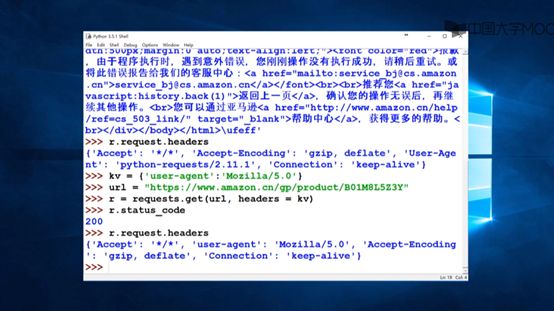

查看r.request.headers的内容,发现爬虫直接告诉了服务器自己是爬虫,所以我们需要伪装一下

换上浏览器的头后成功访问

于是,访问亚马逊网页爬虫框架

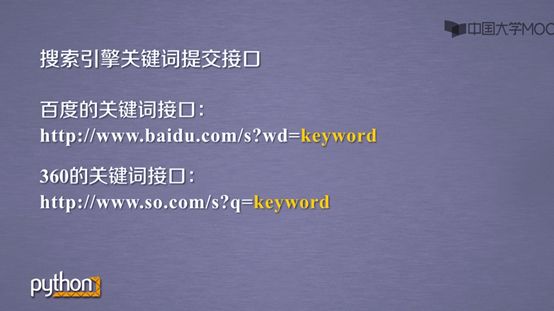

3.搜索引擎关键词提交接口

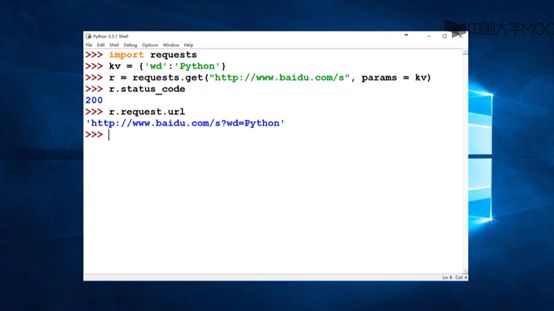

我们还可以爬取百度,需要提交自己要爬取的关键词

例如想百度python,就用之前介绍的params参数来实现

访问百度的全代码

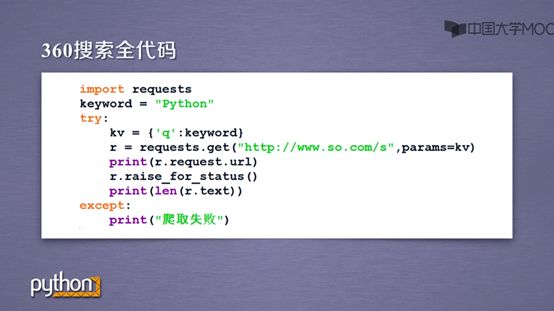

360的也同理

参考链接:

http://www.icourse163.org/course/BIT-1001870001?tid=1001962001

更多教程资料请访问:人工智能知识资料全集

-END-

专 · 知

人工智能领域主题知识资料查看与加入专知人工智能服务群:

【专知AI服务计划】专知AI知识技术服务会员群加入与人工智能领域26个主题知识资料全集获取

[点击上面图片加入会员]

请PC登录www.zhuanzhi.ai或者点击阅读原文,注册登录专知,获取更多AI知识资料!

请加专知小助手微信(扫一扫如下二维码添加),加入专知主题群(请备注主题类型:AI、NLP、CV、 KG等)交流~

请关注专知公众号,获取人工智能的专业知识!

点击“阅读原文”,使用专知