神仙打架!LeCun、Jeff Dean等大神激辩AGI和深度学习

新智元推荐

新智元推荐

来源:AI前线(ID: ai-front)

作者: TRISTAN GREENE 编译&编辑|Debra

【新智元导读】最近,推特上掀起了一场 AI 领域的大论战,AI 大神们连打几个回合,讨论 AGI(通用人工智能)和深度学习之间的关系。一时间,Yann LeCun、Jeff Dean、Gary Marcus 等大神都卷入这场讨论中,宛如神仙打架。

红方:反方,纽约大学教授 Gary Marcus,论点 “打倒深度学习”;

蓝方:正方,FAIR 主任 Yann LeCun,论点 “给我们看看你有什么成果”。

这场推特大战,大有一劳永逸,决定 AI 研究命运的架势。

在过去一周左右的时间里,这两位 AI 专家在推特上 “大战” 了几个回合,以友好但不失风趣的辩论探讨通往通用人工智能之路。

Gary Marcus:既然你加入了符号处理的阵营,我拜托你认真读下我的论文《深度学习:一些批判建议》,再来跟我讨论你不同意的观点。

Yann LeCun:我不明白的是你为什么对深度学习抱有这么大的敌意,我们有分歧的是它在前进道路上有多重要,但是现在我们显然都认为深度学习是解决方案的一部分。

Gary Marcus:我不是对深度学习有敌意,而是深度学习本身。我已经为这两者之间的差别解释了 26 年了。

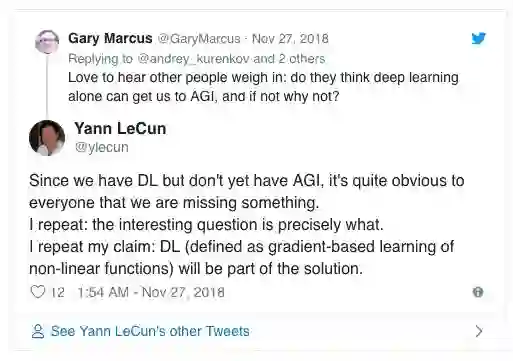

Gary Marcus:欢迎更多人加入辩论:你认为仅靠深度学习能通向 AGI 吗?如果不能理由是什么?

Yann LeCun:因为现在有深度学习,但还没有实现 AGI,很明显我们忽略了一些东西。我重复一下:这个有趣的问题很明确。我重复下我的观点:深度学习(定义为基于梯度的非线性函数学习)将会是解决方案的一部分。

可能有人不太熟悉这个术语:AGI 是指机器获得人类水平的智能。这场争论的焦点在于,一个特定的人工智能发展模式是否必然是通向 AGI 的途径。其实问题比这复杂得多,但要点是:LeCun 强烈认为深度学习将成为通向 AGI 解决方案的一部分。 当然,Gary Marcus 对此表示不同意。

Peter Jung:有一件事困扰着我:我们究竟对于这种符号处理能力应用于日常生活的需求有多大?古文明(如巴比伦人)真的需要使用这些东西来创建文明吗?

Gary Marcus:给我看看发明数学和天文学的深度网络,如果有我能把帽子吃了,或者给你最喜欢的慈善机构捐钱。

虽然从点赞和转发来看,这并不算社交媒体上一个现象级的大事,但成就历史的事件往往在当时并不是社会讨论的主流。

这场辩论的发起者 LeCun 和 Marcus 并不是我们熟悉的网红,而在机器学习领域,他们的影响力非同一般。

而且,当 AI 领域的大神们的观点产生碰撞时,就会产生戏剧性的效果。另外,这场辩论更是有更深一层的含义:这是一次典型的大型科技公司和学术研究之间的对抗。

在 FAIR,LeCun 负责紧跟先进的机器学习的最新发展。他曾经在日常工作之外,狠批机器人索菲亚并非真正的 AI。

Gary Marcus 在纽约大学教授心理学和神经科学,这使他成为人工智能方面的专家。他写过一篇严厉批评深度学习的文章。文章标题并不是《它不是‘深度学习:你最近为我做了什么?’》,副标题也不是《‘ImageNET:真无聊’》。如果真是这样的话也挺有趣的,但实际上文章标题还是挺平平无奇:《深度学习:一些批判性建议》(https://arxiv.org/abs/1801.00631)。

不过,在 11 月的 Great AI 辩论中,参与的 AI 大神不仅有 LeCun 和 Marcus,和所有精彩的表演一样,这场辩论还有很多名人陆续加入。

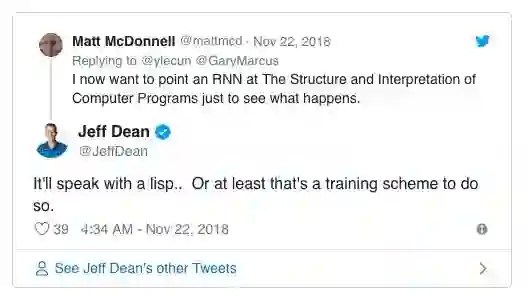

Matt McDonnell: 现在我想在 “计算机程序的构造和解释” 项目里加一个 RNN,看看会发生什么。

Jeff Dean:它会口齿不清... 或者至少是一个训练项目。

谷歌的 Jeff Dean 也出现了。他帮助谷歌创建了谷歌大脑项目。

OpenAI 策略总监 Jack Clark 也加入进来。他还是 Import AI 周报的作者。

随后,图灵奖得主 Judea Pearl、机器学习先驱之一 Thomas Dietterich 也加入论战。

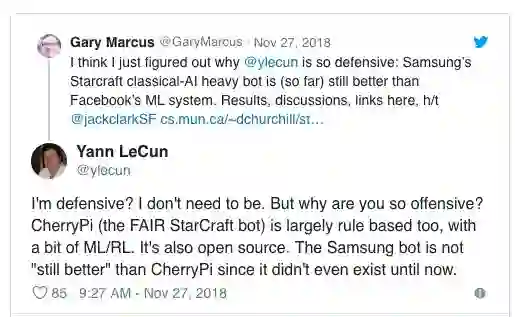

Gary Marcus:我想我知道为什么 LeCun 为什么这么抵触了:三星经典的《星际争霸》AI 机器人仍然比 Facebook 的机器学习系统强。@Jack Clark 比赛结果、讨论、链接在这儿 https://t.co/1GQOg10rRz

Yann LeCun:我有抵触情绪?不,我不需要这样。但你为什么有这么大的敌意呢?CherryPi(FAIR 星际争霸机器人)是基于规则的,加上一点机器学习 / 强化学习。它也是开源的。三星机器人不是 “仍然” 比 CherryPi 强,因为此前它还不存在。

Gary Marcus:哈哈,我开玩笑的,但这和你昨天所的话截然相反:“关于 Facebook 和谷歌的争论在于深度学习... 很难找到任何用操作码写的符号 AI。”

Thomas G. Dietterich:我不认为 Facebook 把《星际争霸》当作操作码。

不久前,FAIR 宣布将机器人 CherryPi 开源,使用结合了规则 / 搜索和深度学习(模仿学习和 RL)的模块化架构。Yann LeCun 表示,将这个机器人开源旨在逐步增强学习的作用,并称它可能是目前世界上最好的星际争霸机器人。然而,就在最近一次《星际争霸》锦标赛中,三星的手写机器人却打败了一众 AI 机器人,包括 Facebook 的 CherryPi。

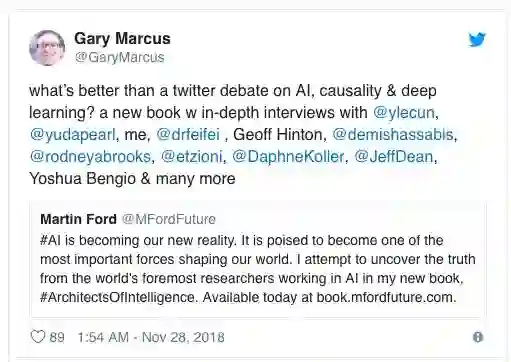

这场讨论的源头不知从何而来,但最近对于 AGI 的热议可能源自 Martin Ford 的新书 Architects of Intelligence (链接见文末)。在这本书中,作者采访了全球 25 位 AI 领域的顶级专家,包括 LeCun, Marcus 和 Dean。

Gary Marcus 还转发了 Martin Ford 关于新书的推特。

Martin Ford 表示,通过写这本书,他最大的收获是看到了专家们对人工智能领域的看法有多么的不同。

看来,是 Martin 抛出了这个话题,Marcus 和 LeCun 让这个话题发酵。当然,通往 AGI 之路的方法并没有在一周的讨论中就得出结论,但是这场历史性的对话可能在未来的某一天被载入电子博物馆的档案中。在如今这个每个人都可以联网的时代,观看这些 Ai 领域的大神们讨论 AGI 的未来,就好像在观看当初物理学家们讨论曼哈顿计划的早期设想一样精彩。

屏幕前的你有什么想法呢?要不要也一起加入讨论?

原文链接:

https://thenextweb.com/artificial-intelligence/2018/11/29/world-renowned-ai-experts-duke-it-out-on-twitter/

Architects of Intelligence by Martin Ford:

https://www.amazon.com/Architects-Intelligence-truth-people-building-ebook/dp/B07H8L8T2J

本文经授权转载自AI前线,ID: ai-front

【加入社群】

新智元 AI 技术 + 产业社群招募中,欢迎对 AI 技术 + 产业落地感兴趣的同学,加小助手微信号:aiera2015_2 入群;通过审核后我们将邀请进群,加入社群后务必修改群备注(姓名 - 公司 - 职位;专业群审核较严,敬请谅解)。