详解预训练模型、信息抽取、文本生成、知识图谱、对话系统技术

我们正处在信息爆炸的时代、面对每天铺天盖地的网络资源和论文、很多时候我们面临的问题并不是缺资源,而是找准资源并高效学习。其次,即便网络上的资源非常多,学习是需要成本的,而且越有深度的内容越难找到好的学习资源。如果一门课程帮助你清晰地梳理知识体系,而且把有深度的知识点脉络讲清楚,这就是节省最大的成本。为了迎合大家学习的需求,我们这次重磅推出了《自然语言处理高阶研修》。

首先,全网不可能找得到另外一门系统性的训练营具备如此的深度和广度,这里包括国外的课程,所以从内容的角度来讲是非常稀缺的内容。

课程覆盖了从预训练模型、对话系统、信息抽取、知识图谱、文本生成所有必要的技术应用和学术前沿,30+项目案例帮助你在实战中学习成长。课程采用全程直播授课模式,博导级大咖全程辅导答疑、帮你告别疑难困惑。

适合什么样的人来参加呐?

-

从事AI行业多年,但技术上感觉不够深入, 遇到了瓶颈; -

停留在使用模型/工具上,很难基于业务场景来 提出新的模型; -

对于机器学习背后的优化理论、前沿的 技术不够深入; -

计划从事尖端的科研、研究工作、 申请AI领域研究生、博士生; -

打算进入顶尖的AI公司如Google,Facebook,Amazon, 阿里等; -

读ICML,IJCAI等会议文章比较吃力,似懂非懂, 无法把每个细节理解透。

如果对课程感兴趣,请联系

添加课程顾问小姐姐微信

报名、课程咨询

👇👇👇

01 课程大纲

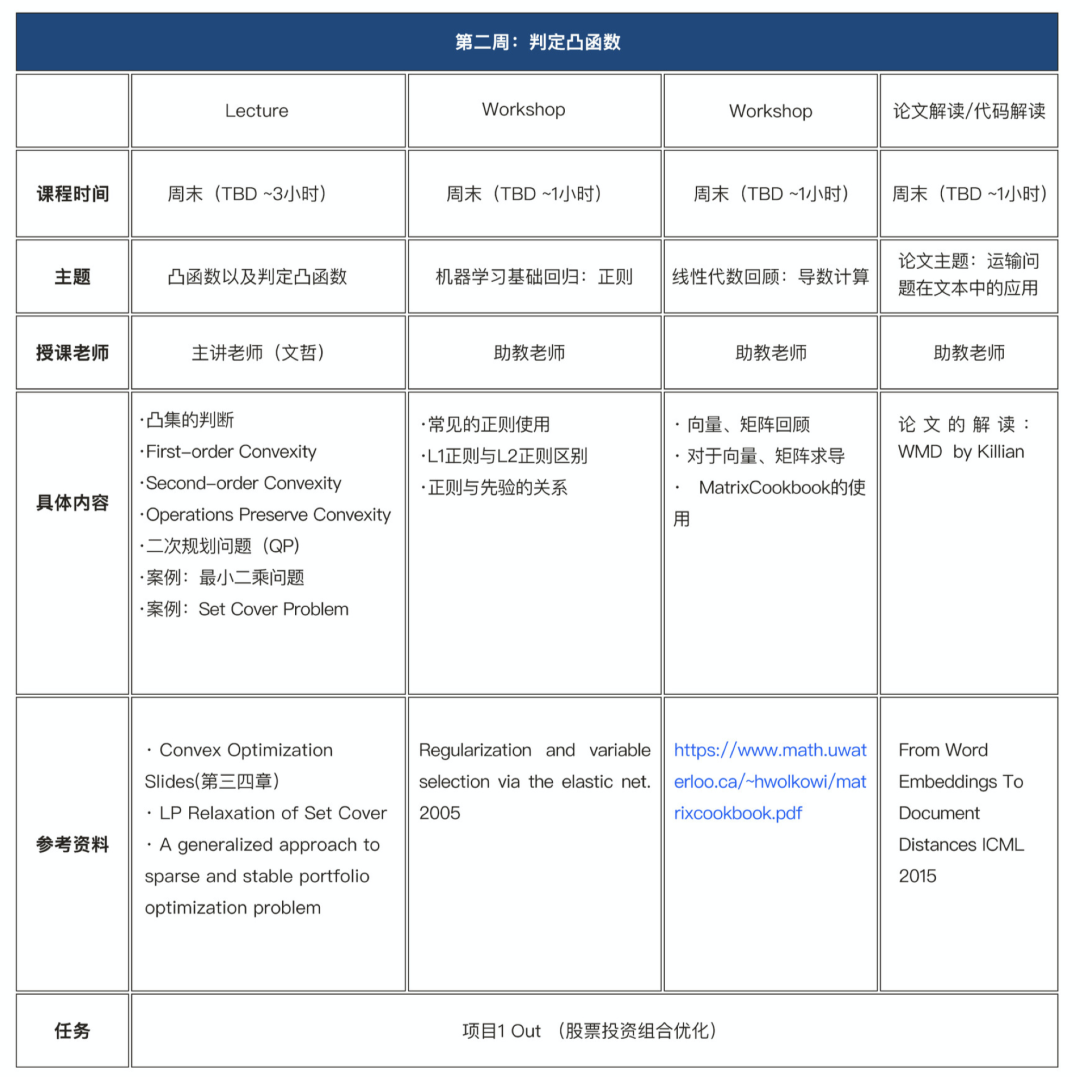

课程内容上做了大幅度的更新,课程采用全程直播授课模式。带你全面掌握自然语言处理技术,能够灵活应用在自己的工作中;深入理解前沿的技术,为后续的科研打下基础;快速掌握理解预训练技术、对话技术、生成技术以及知识图谱的常用技术;通过完成一系列课题,有可能成为一个创业项目或者转换成你的科研论文。

模块一 预训练模型

第一章:预训练模型基础

| 预训练模型基础、语言模型回顾

| N-gram、Neural语言模型回顾

| 预训练方法的发展历程

| 预训练和transfer learning

| Pre-BERT时代的transfer learning

| word2vec,transfer learning in NER

| Post-BERT时代的transfer learning

| Pre-train fine-tune范式

第二章:ELmo与BERT

| Elmo、Transformer、BERT

| 更强的BERT:RoBERTa

| 基于Elmo和BERT的NLP下游任务

| Huggingface Transformers库介绍

| 构建基于BERT的情感分类器

第三章: GPT系列模型

| GPT、GPT2、GPT3

| 基于GPT的fine-tuning

| 基于GPT的Zero-shot learning

| 基于GPT模型的文本生成实战

| Top-k + Top-p 采样

| 基于给定Prompt生成续写文本

第四章: Transformer-XL与XLNet

| 处理长文本

| Transformer-XL

| 相对位置编码

| Permutation Language Model

| Two-stream attention

| XLNet

| 更进阶的预训练任务:MPNet

第五章:其他前沿的预训练模型

| 考虑知识的预训练模型:ERINE

| 对话预训练模型:PLATO2, DialoGPT

| SpanBERT

| MASS,UniLM

| BART,T5

| 实现基于T5的文本分类模型

第六章: 低计算量下模型微调和对比学习

| 低计算量情况下的预训练模型微调

| Adapter-based fine-tuning,

| Prompt-search,P-tuning

| 基于对比学习的预训练

| 对比学习目标:Triplet Loss,InfoNCE Loss

| 对比学习在NLP中的前沿应用:SimCSE

第七章:多模态预训练和挑战

| 多模态预训练模型

| 多模态匹配模型:CLIP,文澜

| VQ-VAE

| 多模态生成模型:DALLE,CogView

| 预训练模型面临的挑战及其前沿进展

| 模型并行带来的挑战

| 对于Transformer的改进:Reformer

模块二 对话系统

第一章:对话系统综述

| 对话系统发展历程

| 对话系统的主要应用场景

| 常见的对话系统类别以及采用的技术

| 对话系统前沿的技术介绍

| 基础:语言模型

| 基础:基于神经网络的语言模型

第二章:对话系统综述

| 任务型对话系统的总体架构

| 案例:订票系统的搭建

| 自然语言理解模块简介

| 对话管理模块技术

| 对话生成模型技术

| 基于神经网络的文本分类和序列标注

第三章:自然语言处理理解模块

| 自然语言理解模块面临的挑战

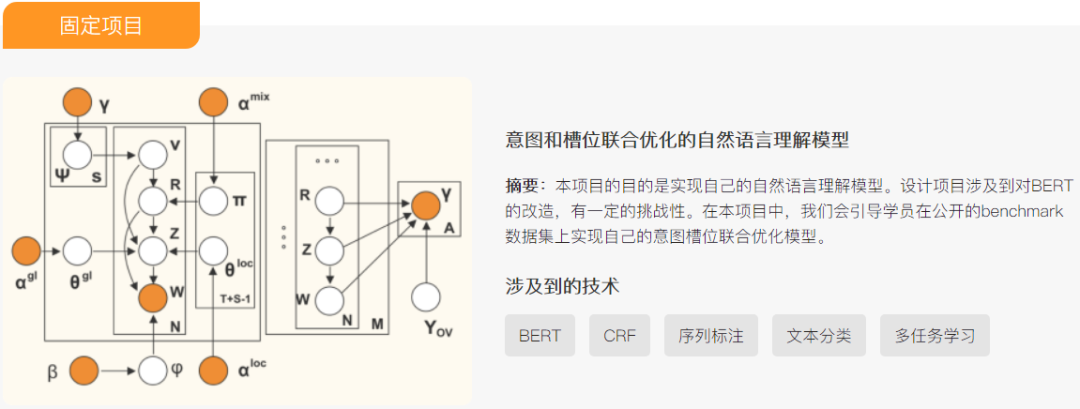

| NLU模型中意图和槽位的联合识别

| 考虑长上下文的NLU

| NLU中的OOD检测

| NLU模型的可扩展性和少样本学习

| 少样本学习方法介绍

| 孪生网络、匹配网络、原型网络

第四章:对话管理和对话生成

| 对话状态追踪

| 对话策略详解

| POMDP技术

| 对话管理的最新研究进展

| 基于RL的对话管理

| 对话生成技术

| 端到端的对话系统

| 基于预训练模型的DST

第五章:闲聊对话系统

| 闲聊对话系统基础技术

| 基于检索的闲聊对话系统

| 基于生成的闲聊对话系统

| 融合检索和生成的闲聊对话系统

| Protoype rewriting, Retrieval augmented generation

| 闲聊对话系统的主要应用场景

| 闲聊对话系统技术所面临的主要挑战

| FAQ系统实战,实现一个自己的FAQ系统

| 基于RNN/Transformer/BERT的文本匹配模型

第六章:对话系统进阶

| 情感/共情对话系统

| 生成带情绪的回复

| 个性化对话生成

| 生成符合特定个性人设的回复

| 风格化对话生成

| 对话回复的多样性

| Label Smoothing, Adaptive label smoothing

| Top-K Sampling, Nuclear Sampling

| Non-autoregressive 算法在生成模型中的应用

| 基于Transformer的对话生成模型

| TransferTransfo

第七章:开源对话系统架构RASA详解

| RASA的主要架构

| 基于RASA搭建自己的对话系统

| 多模态对话、VQA

| 考虑图像模态的对话回复检索和生成

| 基于预训练模型的对话系统

| 基于GPT模型的对话模型

| Meena,PLA

模块三 信息抽取&知识图谱

第一章:知识图谱与图数据模型

| 知识图谱:搜索引擎,数据整合,AI

| 实体抽取、关系抽取、词向量

| graph embedding

| 图数据模型:RDF, Cyper

| 结构化数据的关系抽取

| 介绍关系抽取的基本方法

| 介绍结构化数据的信息过滤

第二章:知识图谱的设计

| RDF和Property graph的设计

| 创建KG:数据处理、文本和图像

| 推断用到的基本方法

| Path detection

| Centrality and community Detection

| 图结构嵌入方法

| 重要性的基本方法:node,edge

第三章:关系抽取和预测

| Hand-built patterns

| Bootstrapping methods

| Supervised methods

| Distant supervision

| Unsupervised methods

| 实体识别的基本方法

第四章:低资源信息抽取和推断

| Low-resource NER

| Low-resource structured models

| Learning multi-lingual Embeddings

| Deepath

| DIVA

| Generic Statistical Relational Entity Resolution in Knowledge Graphs

第五章:结构化预测模型

| Sequence labeling

| 结构化数据类别:Dependency,constituency

| Stack LSTM

| Stack RNNS

| Tree-structure LSTM

第六章:图挖掘的热门应用

| 基本图概念

| Link Prediction

| Recommendation system

| Anomaly detection

| Gated Graph Sequence Neural Networks

模块四 文本生成

第一章:Seq2Seq模型与机器翻译

| Seq2seq 模型与机器翻译任务

| 机器翻译中未登录词UNK与subword

| 文本生成coverage

| length normalization

| 低资源语言生成

| 多任务学习

| Tearch Force Model

第二章:文本摘要生成(1)

| 摘要生成技术类别

| 生成式摘要生成技术

| 抽取式摘要生成技术

| 基于CNN的文本生成

| 基于RNN的文本生成

第三章:文本摘要生成(2)

| Pointer Network 及其应用

| CopyNet 于工业界的落地

| Length Normalization

| Coverage Normalization

| Text summarization 前沿研究

第四章:Creative Writing

| 可控性文本生成

| Story Telling 与预先训练GPT

| 诗词,歌词,藏头诗等文本生成

| 创作性文本生成技巧

第五章:多模态文本生成

| ResNet

| Inception 等预训练图片特征抽取模型

| Image Caption 及其应用

| Table2text

| 图神经网络与文本生成

第六章:对抗式文本生成与NL2sql

| 对抗生成网络 GAN模型

| 强化学习基础

| 基于 Policy Gradient 的强化学习

| SeqGAN

| NL2sql :自然语言转SQL