LAWS=杀人机器?

War does not determine who is right

only who is left.

...

社会对自动化机器人的争论多与社会就业相关,如果不想出现生产事故,只能多花时间对机器人技术实验。而另一个关于自动化机器人的争论则围绕在是否应该在战争中使用。

图片|冷兵器时代的战争鲜血近在咫尺

千载之下,人类文明过去从青铜到铁器,从冷兵器到火器,冶金技术、战马、战车、火药、火炮、飞机、原子弹和计算机...每每这些新事物的出现对战争的成败起到决定性作用。然兵者凶器也,文明的初衷是为了美好生活,而战争却成了屠戮生命的机器。不论愿意与否,机器人和AI可能会再次改变战争的形态。

图片|美军在阿富汗使用无人机空袭造成平民伤亡

...

LAWS

Yes or No?

...

我们应不应该通过编程来制造出一个能够自主决策的武器?支持者认为机器人决策能减少士兵和无辜平民死亡的数量,因为机器人不受情感因素判断,同情、疲劳或者对战争的恐惧等,这些情绪可能会让士兵对当下情势做出错误判断,而对于一个机器来说,只要计算速度够快,决断只是一瞬间的事情。

即便事实如此,不过这个并不是世界各国军队投入研发AI机器人的主要动机。对于他们来说,自主机器人有三个优势。第一,他们能够比人类士兵更加高效的完成任务。第二,军队会担心他们的竞争对手先拥有这些技术从而在战争中获得优势,上世纪的二战就是前车之鉴。第三,在执行一些危险任务时,可以减少军队伤亡。最后有一个让人不寒而栗的副作用,随着技术的进步,战争成本更低,军事打击可能因此频发。

其实目前对于战争机器人最核心的问题是,是否应该允许机器独立决定杀掉哪些人。毫无疑问我们能够造出杀人机器,没人会怀疑我们到底能不能,而是我们应不应该。

图片|1980年联合国签署《特定常规武器公约》

已经有超过一千名科学家签署了一份公开声明,表示应该禁止完全自主的武器系统。已故科学家史蒂芬霍金教授同样在这份公开声明上签字,同时在2014年写过一篇文章,文章中表明AI军备竞赛可能会危及人类种族。

对于是否该建立自主武器系统引发的激烈讨论,看上去有些虚伪。“机器人是不是应该被赋予做杀人决定的权利”的论题,从某种意义上来说,过去的一个多世纪已经做出过回答,曾经被广泛使用的地雷,不论面对士兵或是儿童都一视同仁,它有一个基本的自主思想:如果重量超过五十磅就会引爆。如果有一家机构研发出一种能够分辨儿童和士兵之间差异的地雷,可能是按照体重或是步伐长短,或者能在爆炸之前嗅出火药的味道,无疑能够降低有效杀伤的成本。

于是很快有人能够以“减少无谓伤害”的理由去研发各种不同形式的战争机器。过往的无人机战争、洲际导弹同样耐人寻味。它们引导出的结论——我们不太可能拒绝更具辨别力的自主战争机器。关于自主武器,美国有一种假装是“谨慎和负责任”的政策,但实际上是为自主武器的早期使用及发展扫清障碍。

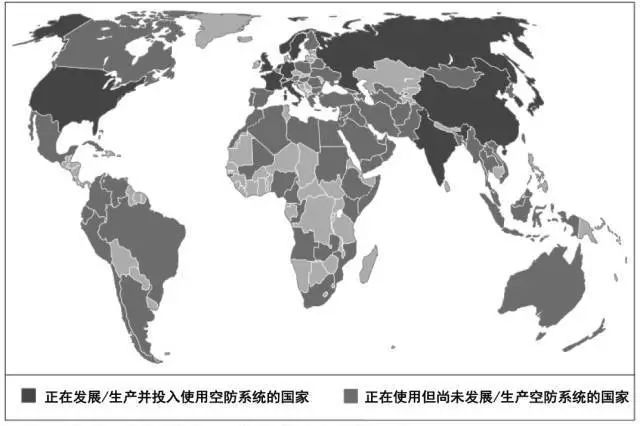

图片|拥有“自动化”或“半自动化”防控系统的国家

数据来源:SIPRI数据库,武器系统自主性

不过“事与愿违”的是这些武器系统构建起来的威胁却是实实在在的。2014年,联合国就“自主致命武器系统”(LAWS)举行会议,会议发布报告认为恐怖分子很可能会利用自主武器进行恐怖活动。在2017年5月份召开的致命性自主武器系统专家会议上,巴基斯坦用了长达5页纸的内容表达了对未来自主武器系统的深切担忧。

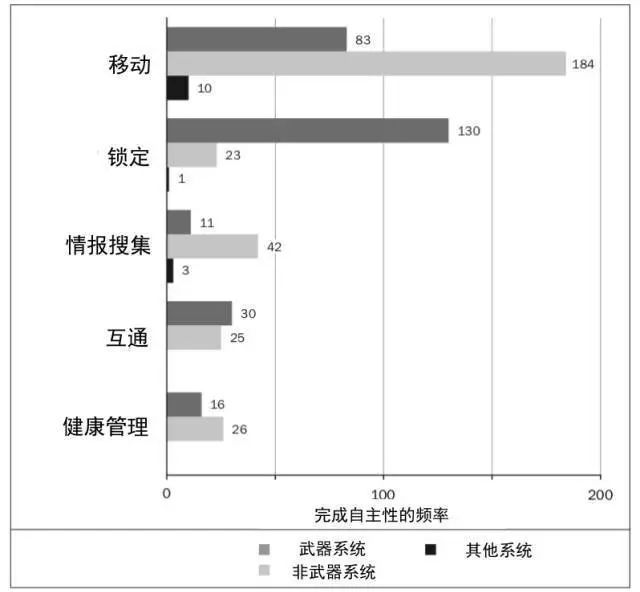

图片|现有军事系统中的按功能分类的自主性功能

数据来源:SIPRI数据库,武器系统自主性

每个国家耗费最多的就是军费,地球上可能至少有二十个国家正在研究自主武器,世界各地目前也不同程度的利用自主武器系统。俄罗斯正在开发一种机器人,能够使用雷达、热成像和摄像机,在四英里以外探测并拍摄人体。美国的地面无人系统,如角斗士多用途无人战车已大量列装海军陆战队。执行侦察、战场运输和排雷等任务的专用机器人如第一眼、非洲猎豹等也投入了使用。一家韩国公司已经出售了价值四千万美元的自动炮塔,这个炮塔能够向两英里范围内的任何潜在目标发出“转身离开或我们要射击了”的信号,颇有一点“别动我们要开枪了”的味道,这也是国际法的规定,因客户需求,这个炮塔增加需要一个人来判断是否射击的人工干预功能。

...

大开杀戒

or

止戈为武

...

如果LAWS仅是个人意愿,问题反而简单,但如果是集体意愿,靠几百个联名看上去则像叩阙式的无奈。

核武器之所以能被控制的部分原因是它的技术和触发方式清楚简单,操控和爆炸核装置都可以人为控制,没有灰色地带。而LAWS则不同,地雷和终结者之间的区别只是程度问题而已。

图片|美军未来战斗系统骡子无人车

常用的GPS技术的设计有底层的内置限制,它不适用于运行速度超过每小时1200英里或高于6万英尺的物体,这是为了防止它被用来为导弹导航。但是软件技术并没有限制,自主武器系统中的人工智能可能会被广泛使用,和普通武器相比自然昂贵,但是和大型的常规武器系统相比则看上去更物美价廉,更何况能够提高效率。

所以考虑到成本和效率的问题,自主武器系统被禁止的概率显然不高,即使不赋予机器自主射击的权利,同样可以通过编程让人类来选择是否射击以摧毁目标的决定,批准步骤同样可以通过翻转开关选择开启或者关闭,这些科幻片里的常见场景无疑终将发生。

原子弹帮助美国人赢得了七十年前的战争,上世纪和苏联冷战依旧历历在目。在这一场AI军备战中,人工智能机器人被认为对国家安全造成强大威胁,其展现出的先进技术让人感到恐惧,因此一些国家并不敢冒险不去尝试。AI技术对于战争来说究竟是大开杀戒还是止戈为武,人们依旧深怀恐惧,不过现在讨论的方向应该是自主性和自主程度,以及决策代码的可解释性,而非“自主性武器”或者“自主性致命武器”这样笼统的概念。

原文|Byron Reese

编译|三七

从以太猫到一起来捉妖,游戏会是区块链的杀手级应用吗?

推荐阅读

比人工智能威胁更可怕的是,那些曾被你抛弃的互联网软件

尼克谈人工智能的历史、现实与未来