为什么机器学习模型会失败?

本文最初发表于 Towards Data Science 博客,经原作者 Delgado Panadero 授权,InfoQ 中文站翻译并分享。

本文通过一个真实的例子,分析了模型选择不当还是训练数据噪声导致了模型性能不佳。

在机器学习中,当你建立和训练一个模型并检验其准确性时,一个最常见的问题就是“准确性是我能从数据中得到的最好的,还是能找到一个更好的模型呢?”

此外,一旦模型被部署,下一个常见的问题就是“为什么模型会失败?”。有时候,这两个问题都无法回答,但有时我们可以通过研究模型误差的统计分布,找出预处理错误、模型偏差,以及数据泄露等。

在本教程中,我们将解释并演示如何统计分析模型结果,以找出示例中错误的原因。

在这个案例中,我们将使用来自 Driven Data 竞赛 的数据,通过一系列社会经济变量来预测一个民族是否处于贫困状态。

这个业务案例的价值不仅在于能够用机器学习模型来预测贫困状况,而且还在于通过社会经济变量对衡量贫困状态的预测程度,并从特征上分析原因。

数据由一组九个描述性变量组成,其中四个是类别变量,另外五个是数值变量(但其中一个似乎是一个 id,所以我们将舍弃它)。

import pandas as pdpd.set_option('display.max_columns', None)train = pd.read_csv('train.csv', index_col='id')print(train)

返回结果如下:

Unnamed: 0 kjkrfgld bpowgknt raksnhjf vwpsxrgk omtioxzz yfmzwkruid29252 2225 KfoTG zPfZR DtMvg NaN 12.0 -3.098286 1598 ljBjd THHLT DtMvg esAQH 21.0 -2.049040 7896 Lsuai zPfZR zeYAm ZCIYy 12.0 -3.035261 1458 KfoTG mDadf zeYAm ZCIYy 12.0 -1.098833 1817 KfoTG THHLT DtMvg ARuYG 21.0 -4.0tiwrsloh weioazcf poorid29252 -1.0 0.5 False98286 -5.0 -9.5 True49040 -5.0 -9.5 True35261 -5.0 -9.5 False98833 -5.0 -9.5 True

数据分布可以在下面看到:

图由作者提供。数据集中所有特征的配对图,以目标为颜色。黄色块代表 False,紫色块表示 True。

通过某些预处理(NaN 值插补、缩放、分类编码等等),我们将对一个支持向量机模型进行训练(通常在独热编码的高维数据中工作良好)。

from sklearn.pipeline import Pipelinefrom sklearn.preprocessing import RobustScalerfrom sklearn.neighbors import KNeighborsClassifiermodel = Pipeline(steps=preprocess+[('scaler', RobustScaler()),('estimator', KNeighborsClassifier(n_neighbors=5))])model.fit(X_train, y_train)y_pred = model.predict(X_test)print(classification_report(y_test,y_pred))`

返回结果如下:

precision recall f1-score supportFalse 0.73 0.77 0.75 891True 0.70 0.66 0.68 750accuracy 0.72 1641macro avg 0.72 0.71 0.71 1641weighted avg 0.72 0.72 0.72 1641

就二元分类问题而言,0.72 的准确率并不高。相比之下,召回率和查准率看起来是平衡的,这使得我们认为,这个模型不是一个有利于任何类别的先验偏见。

想要改进这个模型,下一步就是尝试其他机器学习模型和超参数,看看我们是否找到任何可以提高性能的配置(甚至只是检查性能是否保持稳定)。

在不同的函数族集中,我们将使用另外两个模型。KNN 模型,对于学习局部模型的影响是一个很好的选择,还有梯度提升树,它也是机器学习中容量最大的模型之一。

from sklearn.pipeline import Pipelinefrom sklearn.preprocessing import RobustScalerfrom sklearn.neighbors import KNeighborsClassifiermodel = Pipeline(steps=preprocess+[('scaler', RobustScaler()),('estimator', KNeighborsClassifier(n_neighbors=5))])model.fit(X_train, y_train)y_pred = model.predict(X_test)print(classification_report(y_test,y_pred))

返回结果如下:

precision recall f1-score supportFalse 0.71 0.74 0.72 891True 0.67 0.63 0.65 750accuracy 0.69 1641macro avg 0.69 0.69 0.69 1641weighted avg 0.69 0.69 0.69 1641

from sklearn.pipeline import Pipelinefrom sklearn.ensemble import GradientBoostingClassifiermodel = Pipeline(steps=preprocess+[('estimator',GradientBoostingClassifier(max_depth=5,n_estimators=100))])model.fit(X_train, y_train)y_pred = model.predict(X_test)print(classification_report(y_test,y_pred))

返回结果如下:

precision recall f1-score supportFalse 0.76 0.78 0.77 891True 0.73 0.70 0.72 750accuracy 0.74 1641macro avg 0.74 0.74 0.74 1641weighted avg 0.74 0.74 0.74 1641

我们可以看到,其他两个模型的表现似乎都非常相似。这就提出了以下问题:

这就是我们用机器学习模型所能预测的最好结果吗?

除了检查性能的一般指标外,分析模型的输出分布也很重要。不但要检查测试数据集的分布,也要检查训练数据集的分布。这是因为我们不想看到模型的表现,而是想看看它是否也学会了如何分割训练数据。

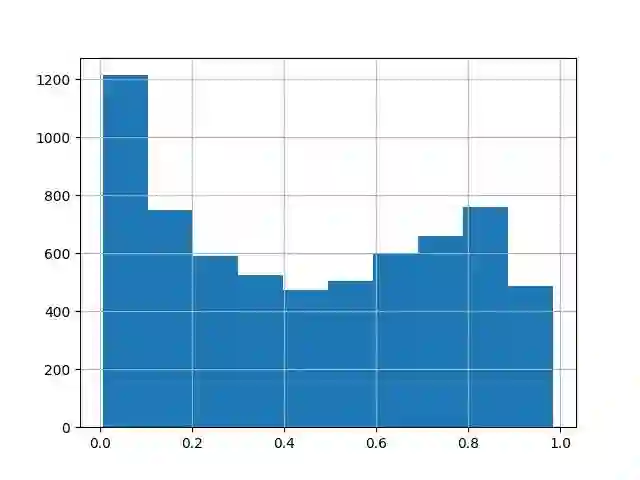

import matplotlib.pyplot as pltpd.DataFrame(model.predict_proba(X_train))[1].hist()plt.show()

图由作者提供。对训练集进行评估的模型输出分布。

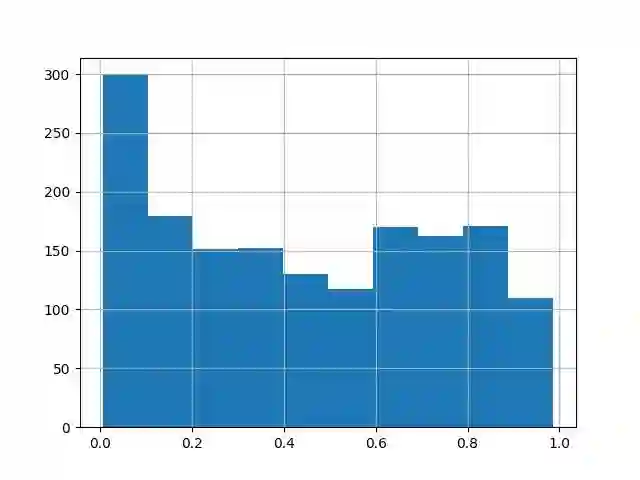

pd.DataFrame(model.predict_proba(X_test))[1].hist()plt.show()

图由作者提供。对测试集进行评估的模型输出分布。

可见,预测为 0 的数量具有较高的峰值,这表示存在一个数据子集,模型非常确定它的标签是 0,除此之外,分布看起来比较均匀。

如果模型知道一定要区分这两个标签,分布会有两个峰值,一个在 0 附近,另一个在 1 附近。因此,我们可以看到,模型并没有正确地学习模式来区分数据。

我们已经看到,该模型还没有学会明确地区分这两个类别,但我们还没有看到它是否在不自信的情况下也能猜到预测结果,还是一直失败。

此外,重要的是要检查模型是否更倾向于一类或另一类的失败。为检验这两个方面,我们可以绘制预测值与目标值偏差的分布图:

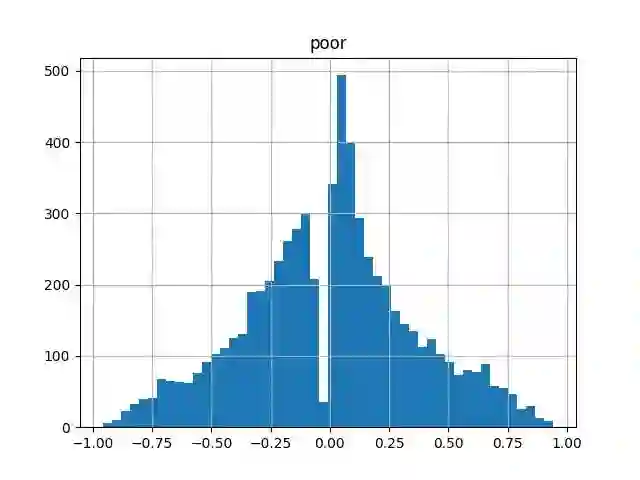

train_proba = model.predict_proba(X_train)[:,1]pd.DataFrame(train_proba-y_train.astype(int)).hist(bins=50)plt.show()

图由作者提供。通过训练集评估的模型置信度输出与基准真相的偏差。

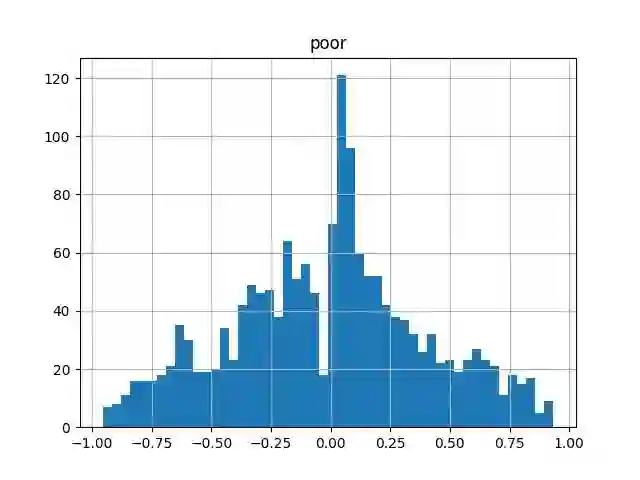

test_proba = model.predict_proba(X_test)[:,1]pd.DataFrame(test_proba-y_test.astype(int)).hist(bins=50)plt.show()

图由作者提供。通过测试集评估的模型置信度输出与基准真相的偏差。

从这两张图中,我们可以看到,偏差分布似乎是对称的,并且以零点为中心。差距只是在零点,因为模型从来没有返回 0 和 1 的准确值,所以我们不必担心这个问题。

如果模型的误差来自于训练数据的统计 / 测量噪声误差,而不是偏置误差,则我们会期望偏差分布遵循高斯分布。

这一分布与高斯分布相似,在零点处有一个较高的峰值,但这个峰值可能是因为模型预测的零点数量较多(也就是说,模型已经学会了一种模式来区分 0 和 1 类别的子集)。

由于训练数据中存在的统计噪声,我们必须确保模型预测的偏差符合高斯分布,然后才能证明其偏差。

import scipyscipy.stats.normaltest(train_proba-y_train.astype(int))

返回结果如下:

NormaltestResult(statistic=15.602215177113427, pvalue=0.00040928141243470884)当 P-value=0.0004 时,我们可以假设预测与目标的偏差遵循高斯分布,这样从训练数据中的噪声导致模型误差的理论是合理的。

如前所述,这一业务案例的目的不仅仅是要预测模型发生的原因,还包括与之相关的社会经济变量。

可解释的模型不仅能预测未见过的数据,还能让你了解特征如何影响模型(全局可解释性),以及为什么某些预测会如此(局部可解释性)。

尽管如此,一个模型的可解释性仍然可以帮助我们理解为什么它能做出预测,以及为什么它会失败。从梯度提升模型中,我们可以提取全局可解释性如下:

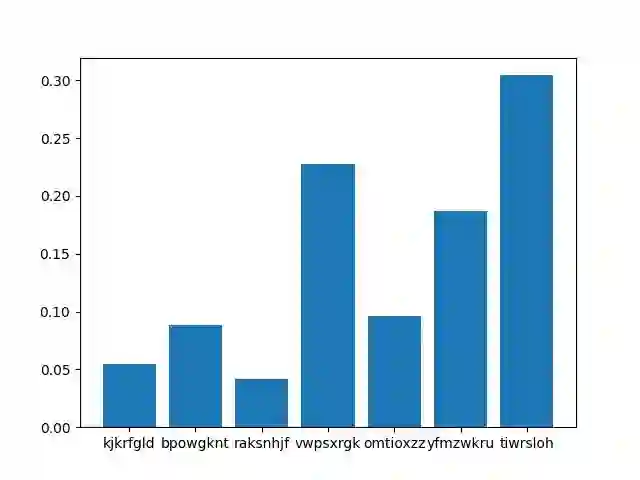

cols = X_train.columnsvals= dict(model.steps)['estimator'].feature_importances_plt.figure()plt.bar(cols, vals)plt.show()

图由作者提供。梯度提升特征输入。

接下来,我们将进行相同的特征重要性分析,但是只对数据的一个子集进行训练。具体地说,我们将只使用明显为零的数据(那些模型之前明确预测为零的数据)来训练模型的零类别。

zero_mask = model.predict_proba(X_train)[:,1]<=0.1one_mask = y_train==1mask = np.logical_or(zero_mask,one_mask)X_train = X_train.loc[mask,:]y_train = y_train.loc[mask]model.fit(X_train,y_train)

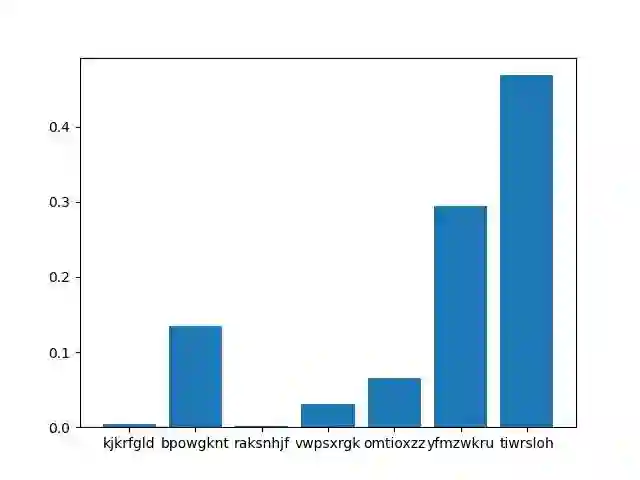

现在特征的重要性是:

图由作者提供。在模型表现最好的训练集子样本上训练的梯度提升特征导入。

我们可以看到,现在,tiwrsloh和 yfmzwkru 这两个变量的重要性增加了,而vwpsxrgk 的数值却下降了。这意味着,拥有一个子集的人口显然不是穷人(类别 0),可以通过这两个变量从穷人的变量和 vwpsxrgk在许多情况下可能很重要,但不具备决定性。

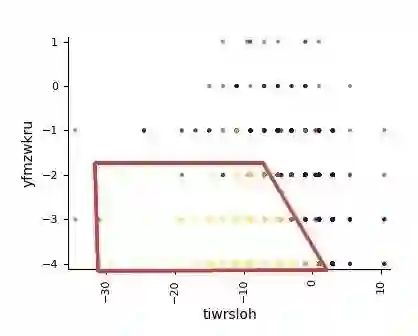

如果我们绘制这两个特征的过滤值,我们可以看到:

图由作者提供,对模型明确检测到非贫困的特征区域进行分割并表征。

对于这两个特征,模型已经学会了区分两个类别,同时,对于这些变量的其他值,在整个数据集中,类别 0 和类别 1 是混合的,所以不能明确区分。

我们还可以从前面的图表中找出一个明显的非贫困人口子集的特征,即tiwrsloh<0 和 yfmzwkru<-2 的人。

我们分析了在给定的数据集中检测贫困的问题,并在给定的社会经济数据中分析其原因,发现贫困并不容易预测,但是,我们可以对某些特定数据进行定义,以明确确定人们的贫困状况:tiwrsloh<0 和 yfmzwkru<-2。

我们尝试了许多不同的模型和配置,在 0.75 的时候性能就会处于平稳状态。通过这一点,再加上模型预测和误差偏差分布的统计学性质,我们可以得出结论,问题在于缺乏从训练数据中预测目标的能力。所以不可能建立一个更好的模型。

我们用一个真实的例子解决了模型不能得到足够好的结果的问题。在这种情况下,我们的目标是尝试了解模型无法理解的问题是在数据中还是在模型中。

回答这一问题的过程是:

尝试不同的函数族模型和超参数,并确认所有的下降在性能上处于平稳状态。

为得到最好的解释,计算模型的输出分布和目标的偏差分布。如果数据是问题所在,则输出必须是均匀的,并且偏差必须遵循高斯分布。

尽管数据是问题所在,但试着从模型输出和偏差分布中找到一个模型表现良好的区域。尝试对这个区域进行分割和定性,例如,用这个子集重新训练模型,并提取其可解释性。

此外,在表征某些子集时,我们可以尝试从业务知识中思考,问题是来自数据的统计 / 测量噪音,还是来自缺乏预测因变量所需的一些特征值。

作者介绍:

Delgado Panadero,研究人工智能的物理学家。

原文链接:

https://towardsdatascience.com/my-ml-model-fails-why-is-it-the-data-d8fbfc50c254

点击底部阅读原文访问 InfoQ 官网,获取更多精彩内容!

这个重要开源项目全靠一位低调的“怪老头”维护!他和比尔盖茨一样撑起了计算机世界

独家专访腾讯云CTO王慧星:云技术变革上下二十年

数据中台与湖仓一体能碰出怎样的火花?网易数帆实时数据湖Arctic的新探索

流行20年的架构设计原则SOLID可能已经不适合微服务了

InfoQ 100 位优质创作者签约计划第二季火热进行中!欢迎各位同学踊跃报名~ 签约豪华大礼包、专属身份标志、百万流量扶持等好礼,等您来拿!

活动链接:http://gk.link/a/10KyO

点个在看少个 bug 👇