【团队新作】自动化所陶建华团队: 基于真实环境的面部表情分析

随着人工智能的发展,构建更加自然的人机交互系统(human machine interaction (HMI) systems)跃升为一大研究热点。受心理学的启发,Prendinger、Martinovski和Traum等研究者指出,关注对话主体或对话系统中的情感信息可以有效提升对话满意度,同时减少对话系统出现崩溃的情况。

图片来自网络

因此,作为人机交互领域的重要研究方向,情感识别吸引了越来越多的目光,而面部表情识别因具有很大的应用价值,更是备受瞩目。例如,不同用户每天都会上传大量图像,这些图像中所呈现的情感状态对于完善推荐系统非常有用,可决定是否向用户推荐相关产品信息。为了自动识别面部图像的情感状态,面部表情识别技术是关键。

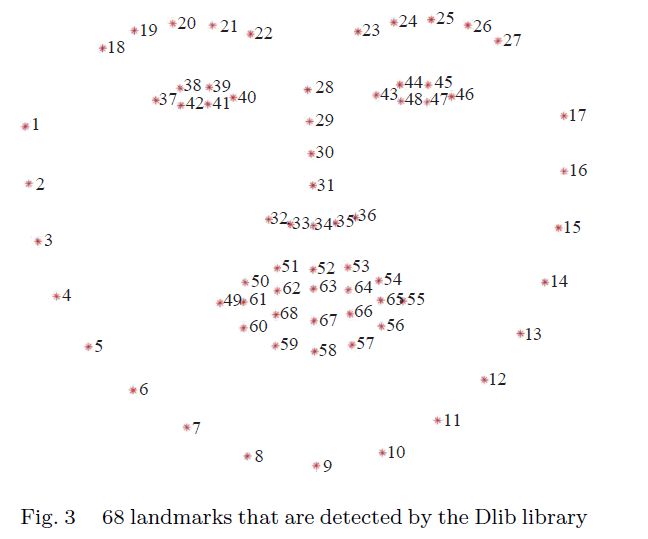

过去识别面部表情包含多个步骤,需借助手工提取的面部特征,分类器和融合方法。通常,面部特征可以分为两部分:外观特征和几何特征。外观特征研究广泛,包含了方向梯度直方图、局部二值模式、局部相位量化以及尺度不变特征变换。几何特征考虑了头部姿势与人脸关键点坐标。

图片来自论文

然而,多步预测方法中各步的目标不一致,同时学界对于情感识别中提取特征的标准也没有达成一致。为了正确应对这些问题,端到端方法取代了多步法,并成为解决诸如图像分类、机器翻译、场景分类、图片标题生成以及语音合成等众多问题时所能采取的最先进的方法。在端对端面部表情识别系统中,将标准大小的原始图片作为输入的数据,情感标签作为输出的结果。端对端图像分类器,包括AlexNet、VGG、GoogLeNet、ResNet、DenseNet以及模型的其他变化形式,在经过训练后,能根据输入图片得出对应的情感预测结果。

尽管研究者们在提升面部表情识别的性能方面做出了很大努力,但当前研究仍然面临诸多挑战。现实生活中,研究者很难得到不受其他物体遮挡的面部图像。此外,人们的面部也并非时刻保持正向,光照并非时刻达到最佳。因此,在表情识别任务中,获取没有任何干扰的正面人脸成为一大难题。

鉴于前人相关研究存在很多局限性,本研究集中讨论了真实场景中,由不同区域人脸数据生成的情感预测结果的真实性。例如,当只能获取嘴部区域数据时,表情分类器的预测结果为"快乐",但我们如何计算预测结果的可信值呢?这一问题可以转换成:有多少关于"快乐"的信息可以通过嘴部表达出来?

图片来自Springer

本研究将整个面部划分为六个子区域:鼻部、嘴部、眼部、鼻子至嘴之间、鼻子至眼睛之间,以及嘴巴至眼睛之间。此外,本研究还分析了在现实场景中,不同面部区域对表达不同表情所起到的作用。借助CAM技术,进行情感识别时,面部相关区域得以视觉化。为取得更有说服力的结果,实验分别在三个不同数据库中开展:FER+、RAF-DB 以及ExpW数据集。

本研究与Busso的研究有相似之处,他把人脸分为前额、眉毛、眼睛下部、右脸颊、左脸颊五个部分,而后每个区域均由单独的分类器进行表情分类。但是他的实验在可控制条件的实验室环境中进行,而本研究的实验均在真实场景中开展,同时,还将面部划分为更小的区域,评价方法也更多样。

研究成果可以与心理学相结合,对于研究人的行为具有重要作用,而且还可拓展至情感表达的理解当中。

Expression Analysis Based on Face Regions in Read-world Conditions

基于真实环境的面部表情分析

Zheng Lian, Ya Li, Jian-Hua Tao, Jian Huang, Ming-Yue Niu

英文摘要:

Facial emotion recognition is an essential and important aspect of the field of human-machine interaction. Past research on facial emotion recognition focuses on the laboratory environment. However, it faces many challenges in real-world conditions, i.e., illumination changes, large pose variations and partial or full occlusions. Those challenges lead to different face areas with different degrees of sharpness and completeness. Inspired by this fact, we focus on the authenticity of predictions generated by different <emotion, region> pairs. For example, if only the mouth areas are available and the emotion classifier predicts happiness, then there is a question of how to judge the authenticity of predictions. This problem can be converted into the contribution of different face areas to different emotions. In this paper, we divide the whole face into six areas: nose areas, mouth areas, eyes areas, nose to mouth areas, nose to eyes areas and mouth to eyes areas. To obtain more convincing results, our experiments are conducted on three different databases: facial expression recognition + ( FER+), real-world affective faces database (RAF-DB) and expression in-the-wild (ExpW) dataset. Through analysis of the classification accuracy, the confusion matrix and the class activation map (CAM), we can establish convincing results. To sum up, the contributions of this paper lie in two areas: 1) We visualize concerned areas of human faces in emotion recognition; 2) We analyze the contribution of different face areas to different emotions in real-world conditions through experimental analysis. Our findings can be combined with findings in psychology to promote the understanding of emotional expressions.

关键词:

Facial emotion analysis, face areas, class activation map, confusion matrix, concerned area.

全文下载:

https://link.springer.com/article/10.1007/s11633-019-1176-9

更多精彩内容,欢迎关注

中科院自动化所官方网站:

http://www.ia.ac.cn

欢迎后台留言、推荐您感兴趣的话题、内容或资讯,小编恭候您的意见和建议!如需转载或投稿,请后台私信。

审稿:连政

编辑:鲁宁、欧梨成

点击"阅读原文"下载论文全文