从有偏见的用户互动中学习的推荐系统已被广泛部署,以帮助用户快速从一组物品中找到他们需要的内容。主要的推荐方法依赖于监督学习模型,以预测用户对物品的评分或用户与物品互动的概率。此外,强化学习模型对于改进推荐系统中的长期用户参与至关重要。在实践中,这两种推荐方法通常都是基于用户互动日志进行训练的,因此受到用户互动日志中存在的偏见的影响。本论文涉及到现实世界用户行为中复杂形式的偏见,并旨在减轻对基于强化学习的推荐方法的偏见的影响。

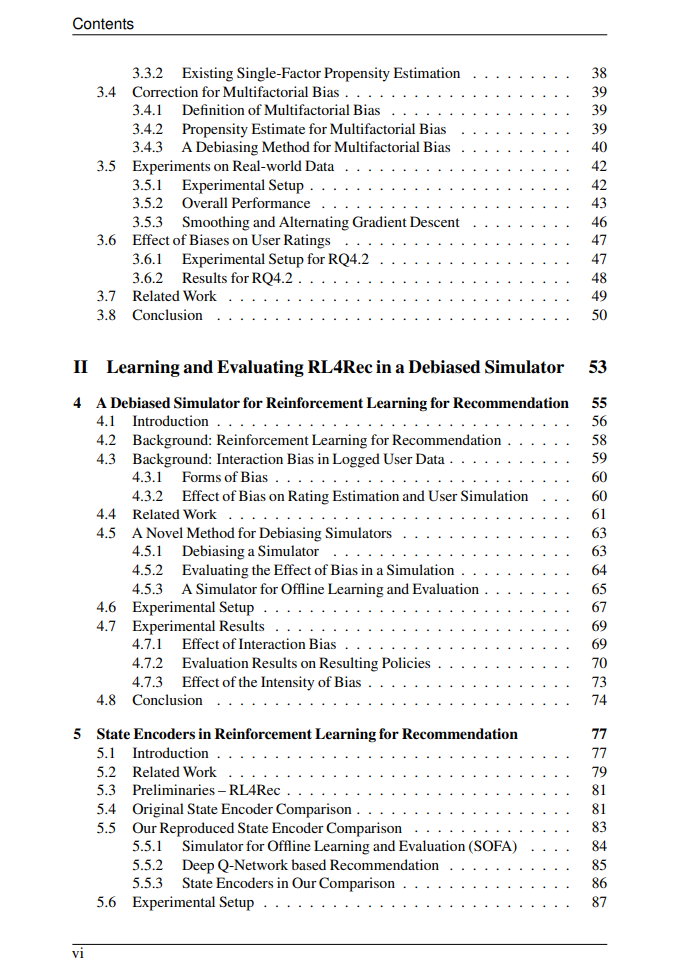

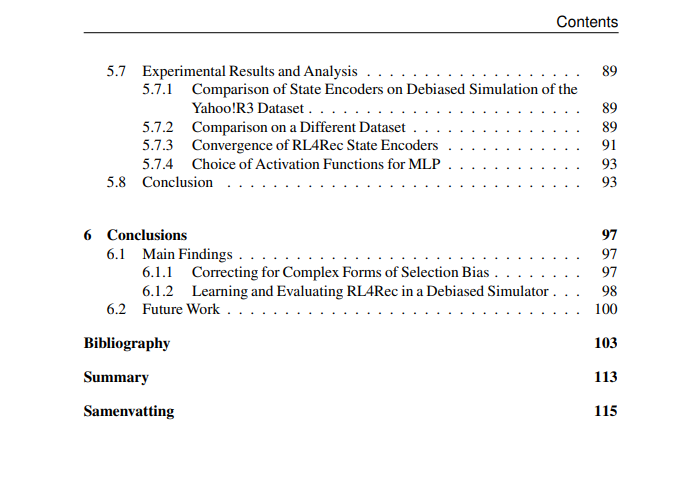

论文的第一部分包括两个研究章节,分别致力于解决特定形式的偏见:动态选择偏见和多因素偏见。为了减轻动态选择偏见和多因素偏见的影响,我们提出了相应的偏见倾向估计方法。通过将偏见倾向估计方法的结果纳入其中,可以扩展广泛使用的反向倾向评分去偏方法,以纠正相应的偏见。

论文的第二部分包括两个章节,涉及偏见对基于强化学习的推荐方法的影响。其第一章重点解决了在模拟器上减轻偏见对强化学习 -基推荐方法的影响,从而实现了对这些方法的学习和评估。其第二章进一步探讨了在使用提出的去偏模拟器进行学习和评估时,用于强化学习 -基推荐方法的不同状态编码器。 https://dare.uva.nl/search?field1=keyword;value1=Reinforcement%20learning;f1-typeClassification=PhD%20thesis;docsPerPage=1;startDoc=9

推荐系统(RSs)旨在帮助用户从一组物品中迅速缩小选择范围,找到他们需要的内容[13, 107, 108, 157]。在过去的十年里,RSs在各种场景中变得越来越重要,例如电子商务产品推荐[79, 121]、媒体推荐[32, 127]、新闻推荐[84, 167]、基于位置的推荐[151, 160]以及健康和健身建议[116, 135]。RSs涉及预测用户对物品的喜好并向用户推荐物品,主要基于从用户档案、物品特征或用户-物品互动中学到的方法[13, 157]。RS方法可以基于各种技术,包括协同过滤[126]、基于内容的方法[103]和混合方法[134]。主要的RS方法依赖于监督学习模型来预测用户评分或用户与物品互动的概率。这些方法还可以与深度学习模型相结合,使它们能够捕捉复杂的推荐模式[64, 128, 157],例如用于顺序推荐的循环神经网络[48]。 除了这些传统的基于监督学习的RS方法外,强化学习用于推荐(RL4Rec)在学术界和工业界都越来越受关注[4, 78]。强化学习(RL)的关键思想是优化一个策略,将状态与动作匹配,以便执行这些动作的代理可以实现最大的累积奖励[131]。与监督学习不同,RL不仅考虑动作的即时奖励,还考虑它对后续动作的影响,因此可以学习长期目标。利用RL的原理,RL4Rec方法可以学习优化长期用户参与度,例如累积点击次数[170]。通常,RL4Rec方法通过向用户推荐物品并观察其后续互动来学习。RL4Rec方法需要探索物品空间,以避免陷入次优解[167]。这在在线应用RL4Rec时存在风险: (1)在学习过程中,可能会采取探索性或不正确的动作,对用户体验有害[72, 75]; (2)由于许多研究人员,无论是在学术界还是工业界,都无法获得实际用户的有限访问权限,因此这是耗时、昂贵且不可行的。 因此,尽管RL4Rec具有潜力,但由于这些风险,它在实践中并不经常被应用。

无论是基于监督学习还是基于强化学习,主要的RS方法都是基于用户与物品的记录互动进行学习和评估的。理想但不现实的用户互动数据包括系统中所有物品的用户反馈(例如评分或点击)。实际上,记录的用户互动数据通常非常稀疏,并受到由于数据收集引起的选择偏见的影响,这是由于系统数据收集引起的系统误差[18, 21, 89, 98, 104, 123]。由于选择偏见,决定用户是否与物品互动的过程不是随机选择的,某些互动比其他互动更有可能被观察到。用户互动中存在的两种众所周知的选择偏见是流行度偏见[18, 104, 123](用户更多地与流行物品互动)和积极性偏见[104](用户更倾向于评价他们更喜欢的物品)。除此之外,还存在各种形式的偏见,包括激励偏见[101]、一致性偏见[70]以及我们在本论文中将要讨论的两种复杂偏见:动态选择偏见和多因素偏见。 这些偏见可能对RSs的学习和评估产生负面影响[18, 21, 117]。例如,如果用户互动中存在流行度偏见,那么从这种偏见的记录数据中学到的RS方法可能会过度推荐由于流行度偏见在记录互动中过多地代表的热门物品。因此,这些方法可能忽视了个体用户的偏好,并忽略了不太流行的长尾物品。总之,在RSs中忽略偏见可能导致各种问题,例如过度特化[3]、过滤气泡[95, 102]、不公平[2],甚至用户参与度下降[21]。因此,在从有偏见的用户互动中学习RS方法时,纠正选择偏见是非常重要的。 为了减轻有偏见的用户互动数据中偏见的影响,已经提出了去偏RSs的任务。广泛使用的去偏方法[62, 117]利用倒数倾向评分(IPS)[59]根据它们的偏向性,即由于偏见而发生的概率,来逆向加权记录数据中的用户互动。它分配更高的权重给那些由于偏见而不太可能发生的用户互动,反之亦然。因此,这种基于IPS的去偏方法可以纠正由于选择偏见导致的过度或不足代表。IPS-based方法基于互动的偏向性来赋予权重,但这些偏向性不能直接观察到,因此需要偏向性估计[92, 117]。偏向性估计可以基于朴素贝叶斯和最大似然[18, 117, 158]或优化机器学习模型[114, 117]。通过相应的估计偏向性,IPS-based的去偏方法可以减轻不同形式偏见的影响。因此,当通过去偏方法优化RS方法时,RS方法可以去偏。 去偏RSs的出现伴随着人们对RSs中与偏见相关问题的认识日益增长,对社会产生积极影响和更公平的RSs做出了贡献。然而,仍然存在重要问题。

一方面,现有的去偏推荐方法主要假设选择偏见保持不变或仅受一个因素影响,例如,流行度偏见随时间不变,仅由物品因素决定。这与现实世界不同,物品的流行度随时间可能发生巨大变化;用户互动可能受到多种偏见或由多个因素确定的复杂偏见的影响[34, 56, 104]。忽略这些复杂形式的偏见可能导致对用户偏好和推荐的误导性预测,并在面对实际用户时导致性能下降。

另一方面,偏见在RL4Rec领域的影响仍然鲜有研究。先前的研究已经证明,在记录的用户互动中存在的偏见对于从这些互动中学到的RS方法具有重要影响[18, 117]。因此,我们可以预期偏见也会影响RL4Rec方法,因为它们也是从这些有偏见的互动中学到的。例如,现有关于RL4Rec方法中状态编码器组件的最佳选择的发现[83]是在不考虑偏见的情况下得出的,当考虑偏见效应时可能会发生变化。

在本论文中,我们考虑了用户互动中不同形式的偏见,并调查了偏见对RL4Rec的影响。具体而言,我们考虑并纠正了两种形式的偏见:随时间变化的动态选择偏见和由物品和评分值因素确定的多因素偏见。我们还将分析偏见在记录数据中的影响如何影响RL4Rec模拟器以及由此产生的RL4Rec方法。为了减轻偏见的影响,我们将提供第一个去偏模拟器,以实现RL4Rec方法的学习和评估。此外,我们还将调查在使用这个去偏模拟器进行学习和评估与忽略偏见的模拟器相比,RL4Rec方法的最佳状态编码器选择是否不同。