近年来,支持人类工作的 "自动化 "系统正在向基本上能够自我管理的 "自主 "系统转变。由于人机之间的协作和相互依存性质,围绕人机信任的问题变得比以往任何时候都更加重要。这项工作旨在探索与信任校准有关的问题,这些问题会影响操作员与系统互动的方式。本报告总结了与题为 "评估影响信任校准的因素:信任策略和风险的影响 "相关的主要研究活动、研究成果和研究成就。这也是最终报告。研究团队就信任校准、特定情况下的信任和人机协作协调了几个不同的研究方向。通过研究,我们发现:1)通过采用防止过度信任的缓解技术,我们可以改变信任分配的方式;2)在实验室环境中,通过使用动态方法改变风险,可以获得不同的信任效果;3)改善人类与自主性之间的社会关系,可以带来卓越的人机绩效成果。本文将详细讨论这三个研究方向中的每一个方向,以及补助金的主要成果。

引言

二十世纪中叶,技术的进步促使人机交互实现自动化,而今天,随着 "自主 "系统的爆炸式发展,也出现了类似的趋势。自动化旨在支持决策并卸载原本由操作员执行的任务,而自主则是在程序约束下 "自我管理 "的一系列能力(国防科学委员会,2012 年)。众所周知,在处理自动化问题时会产生意想不到的后果(参见 Parasuraman & Riley,1997 年的一篇综述),但最近有一个因素越来越受到重视,那就是操作员信任的概念。

一段时间以来,人们一直认为信任是一个值得对高频进行实证研究的概念(参见 Parasuraman 和 Riley,1997 年的早期综述),但需要注意的是,并非所有研究人员都同意这一观点(例如 Dekker 和 Woods,2002 年)。虽然信任在很大程度上是一个社会心理学概念,但在人为因素中,信任也被用于描述人机合作关系的部分特征。从形式上定义,信任是一种态度,即在不确定或脆弱的情况下,代理或系统会帮助操作者实现目标(Lee & See, 2004)。(人与人之间的信任与人与机器之间的信任在本质上是相似还是不同,这个问题仍在探索之中(如 Madhavan,2007 年),但迄今为止的实证工作表明,信任非常重要,因为它决定了与自动化和自主系统互动的特定策略。在这方面,信任是系统能力与性能之间的一个干预变量。

信任是人类性能的重要组成部分。信任通常是指对自动化或自主系统的依赖程度(例如 Lee & Moray, 1994; Parasuraman & Riley, 1997),适当的、良好的依赖程度有助于将性能保持在接近最佳水平。如果对并非百分之百可靠的自主系统的信任度过高,就会产生自满情绪(Moray 和 Inagaki,2000 年)。低信任度可能会导致废弃,这意味着自动化或自主代理本可以成功执行的功能被忽视了(Parasuraman 等人,1997 年)。

因此,信任校准,也就是将适当的操作员信任水平与适当的自主系统可靠性水平相匹配,近年来已成为一个重要的研究领域。人们认为,信任的校准将带来更适当的依赖和更少的错误。操作员将在需要最少监督的界面上减少认知负荷。这样,他们就可以腾出注意力来执行其他任务。有了经过校准的信任,操作员就能在瞬息万变的环境中更快地感知和应对突发事件。这样,就有可能通过减少操作员数量来有效管理更多的自主系统。

在过去 3 年中,我们开展了三项主要工作,包括

-

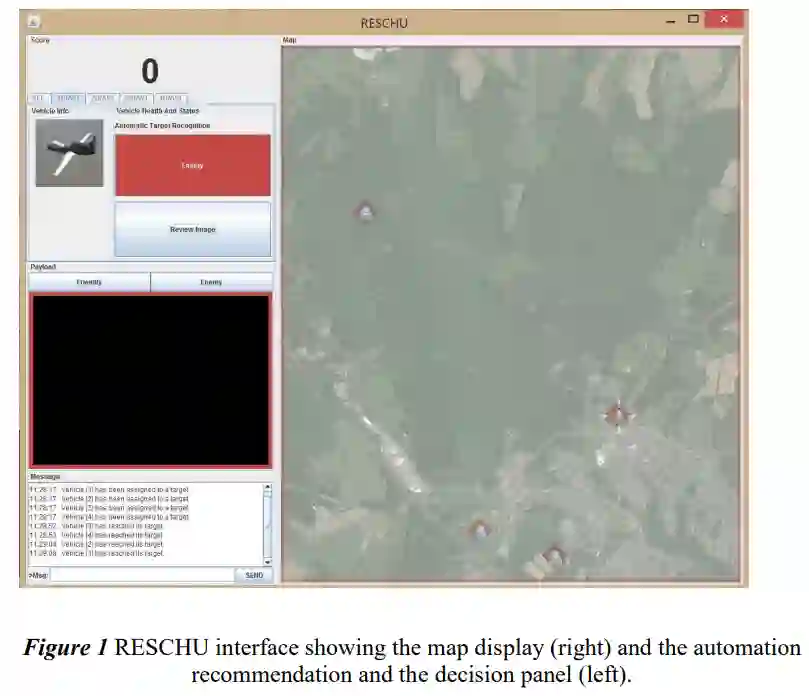

研究信任分配方式如何影响操作员与系统的交互方式。

-

探索信任的一个通常未被充分研究的方面,即操作员风险及其对信任策略的后续影响。

-

探讨人机协作的潜在互动结构

报告的以下部分将详细介绍每项研究。