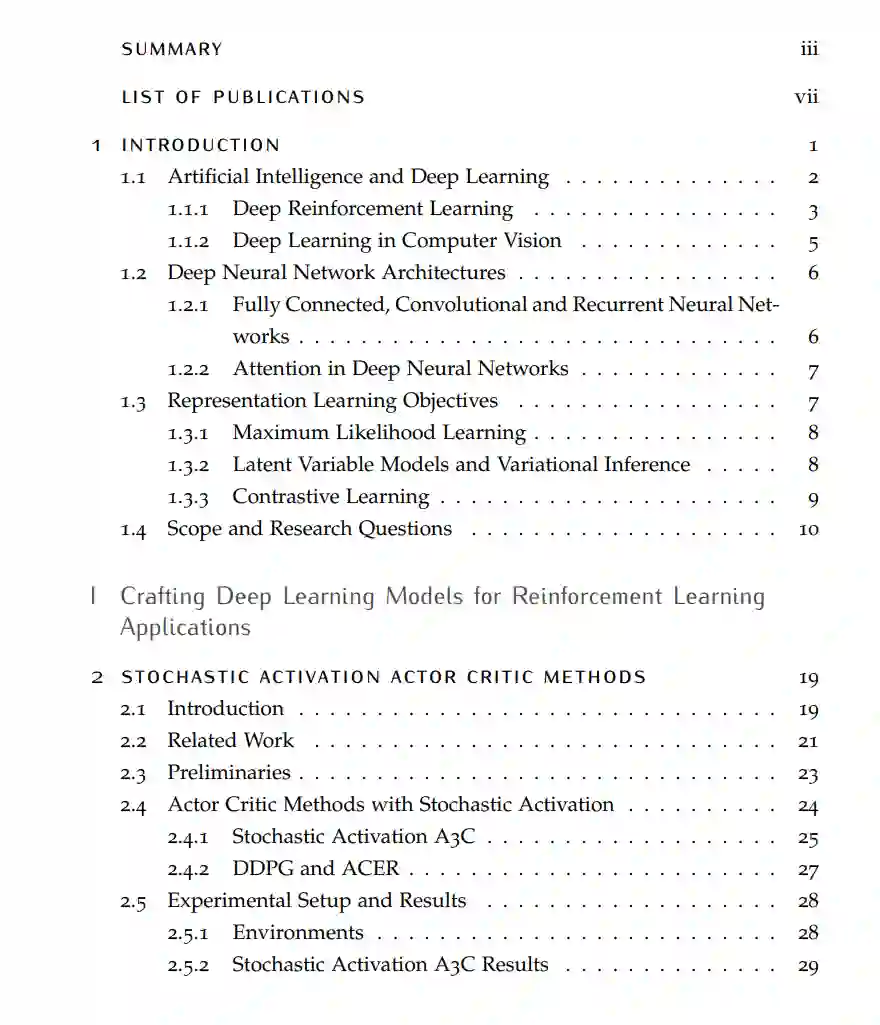

本文为强化学习和计算机视觉应用构建深度学习模型,重点是设计新颖有效的表示学习框架。所提出的方法有两个主要方面:神经网络模型架构设计和目标工程。为演示如何操纵每个方面,深入研究了人工智能中两个重要研究领域的代表性应用,即强化和计算机视觉。在这两个领域,都强调了如何操纵抽象表示,以从目标任务和可用数据类型中建立强大的归纳偏差。我们希望我们的例子可以为今后处理相关领域和其他领域的问题提供启发。 论文的第一部分研究了强化学习中的代表性任务。我们的贡献如下:

作为起点,旨在改善通用和探索性行为,并反映一类流行的无模型、基于策略的强化学习算法、actor - critic方法的环境不确定性。本文提出随机actor-critic方法(Shang et al., 2019b; Chapter 2;第2章)它采用了一种有效而灵活的方式将随机性注入到actor-critic模型中。随机性被注入到高级抽象表示中。测试了几个用随机激活增强的actor-critic模型,并在广泛的Atari 2600游戏、连续控制问题和赛车任务中证明了它们的有效性。

接下来,我们将注意力转向如何在一个更具体但更常见的RL问题设置中进行结构化探索:一个承载着不同任务套件的持久环境或世界。本文提出对环境进行世界图分解,以加速强化学习(Shang et al., 2019a; Chapter 3;第3章)世界图的节点是重要的航路点状态,边表示它们之间的可行遍历。在识别世界图之后,该框架将其应用于分层强化学习算法,以将探索偏向于与任务相关的航路点和区域。在一套具有挑战性的迷宫任务上彻底评估了所提出方法,并表明使用环境的世界图抽象可以显著加速强化学习,实现更高的回报和更快的学习。

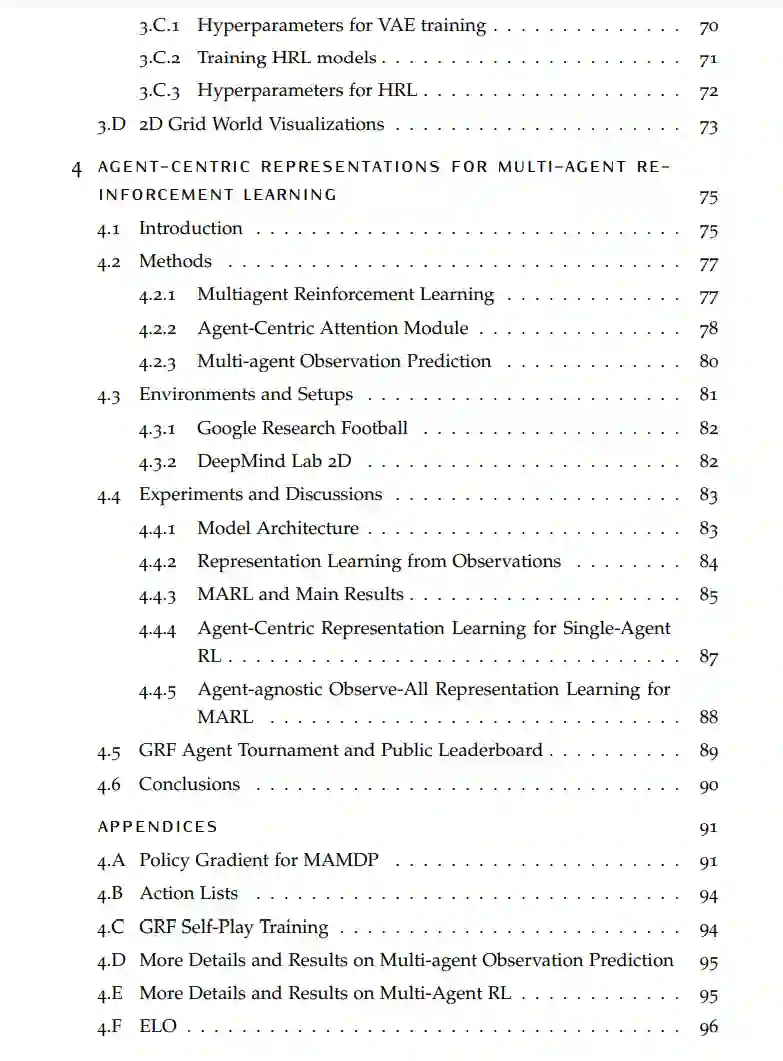

最后,考虑多智能体必须合作以实现共同目标的场景,这是多智能体强化学习的一个子集。建议将以智能体为中心的表示纳入多智能体强化学习(Shang等人,2020a;第四章)以两种方式。引入了一个以智能体为中心的注意力模块,具有跨智能体的显式连接。注意力模块建立在智能体的抽象表示之上。利用了一个以智能体为中心的无监督预测目标,作为辅助损失或预训练步骤的基础。在谷歌Research Football环境和DeepMind Lab 2D上评估了这些方法,表明它们导致了智能体之间更复杂的合作策略的出现,并提高了样本效率和泛化能力。

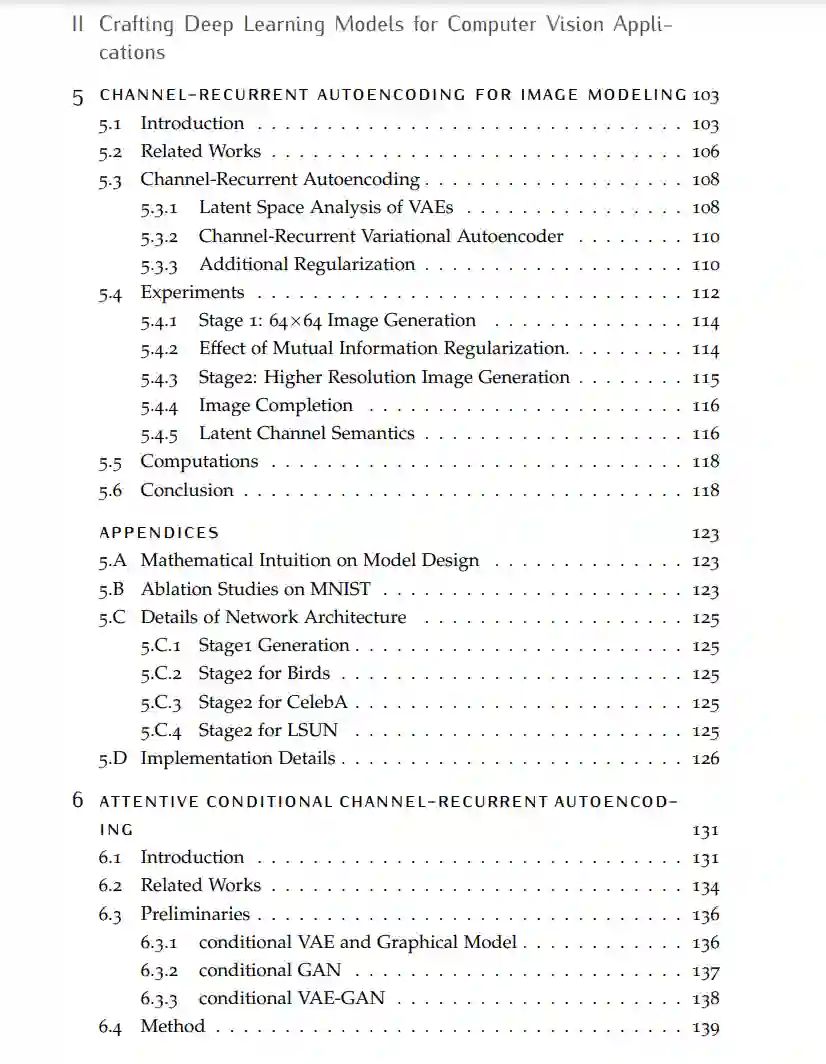

论文的第二部分将重点转移到各种计算机视觉任务和领域的无监督学习。我们的贡献如下:

为了更好地利用无标签数据并增强无监督图像建模,本文提出通道递归变分自编码器(crVAE) (Shang等人,2018;第5章)。它将抽象卷积特征的跨通道循环连接集成到推理和生成步骤,允许以全局到局部、粗到细的方式捕获由此产生的高级特征。结合对抗性损失,产生的通道循环VAE-GAN (crVAE-GAN)在生成不同光谱的高分辨率图像方面优于基线VAE-GAN,同时保持相同的计算效率水平。

下一步,进一步扩展通道循环框架,并提出了注意力的条件通道循环自编码;)属性条件人脸合成。评估通过定性的视觉检查和定量的指标进行,即inception分数、人类偏好和属性分类精度。

考虑对无标记视频序列进行无监督学习,并建议学习视频级静态和动态表示(Shang等人,2020b;第7章从时间一致性和动力学角度对视频进行分解。本文展示了在几个应用中学习到的表示的重要性,包括一个新的动力学检索任务,在人脸、人类活动和机器人抓取数据集上。