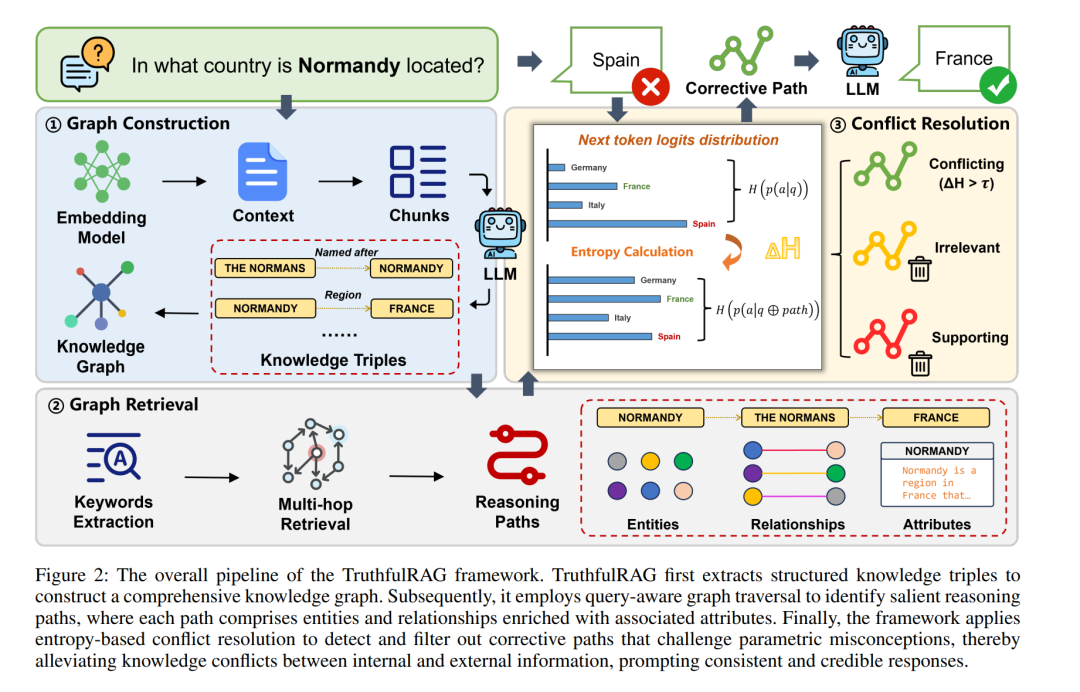

在检索增强生成(Retrieval-Augmented Generation, RAG)框架中,通过将基于检索的方法与生成式模型相结合,可以显著提升大语言模型(LLM)的能力。随着外部知识库的不断扩展以及模型内部的参数化知识逐渐陈旧,RAG 系统面临的一个关键挑战是如何解决检索到的外部信息与 LLM 内部知识之间的冲突。这类冲突会严重影响生成内容的准确性与可靠性。然而,现有的冲突解决方法通常停留在 token 或语义层面,难以对知识密集型任务中 LLM 内部知识与上下文之间的事实性差异形成完整且深入的理解,往往导致处理结果碎片化或不充分。 为克服这一局限,我们提出 TruthfulRAG,这是首个利用 知识图谱(Knowledge Graph, KG) 来解决 RAG 系统中事实层知识冲突的框架。具体而言,TruthfulRAG 通过系统性地从检索内容中抽取三元组来构建知识图谱,使用基于查询的图检索来识别相关知识,并采用基于熵的过滤机制精确定位冲突元素并缓解事实不一致性,从而使 LLM 能生成更加真实且准确的回答。 大量实验表明,TruthfulRAG 在缓解知识冲突、提升 RAG 系统的鲁棒性与可信度方面显著优于现有方法。!

成为VIP会员查看完整内容

相关内容

Arxiv

224+阅读 · 2023年4月7日