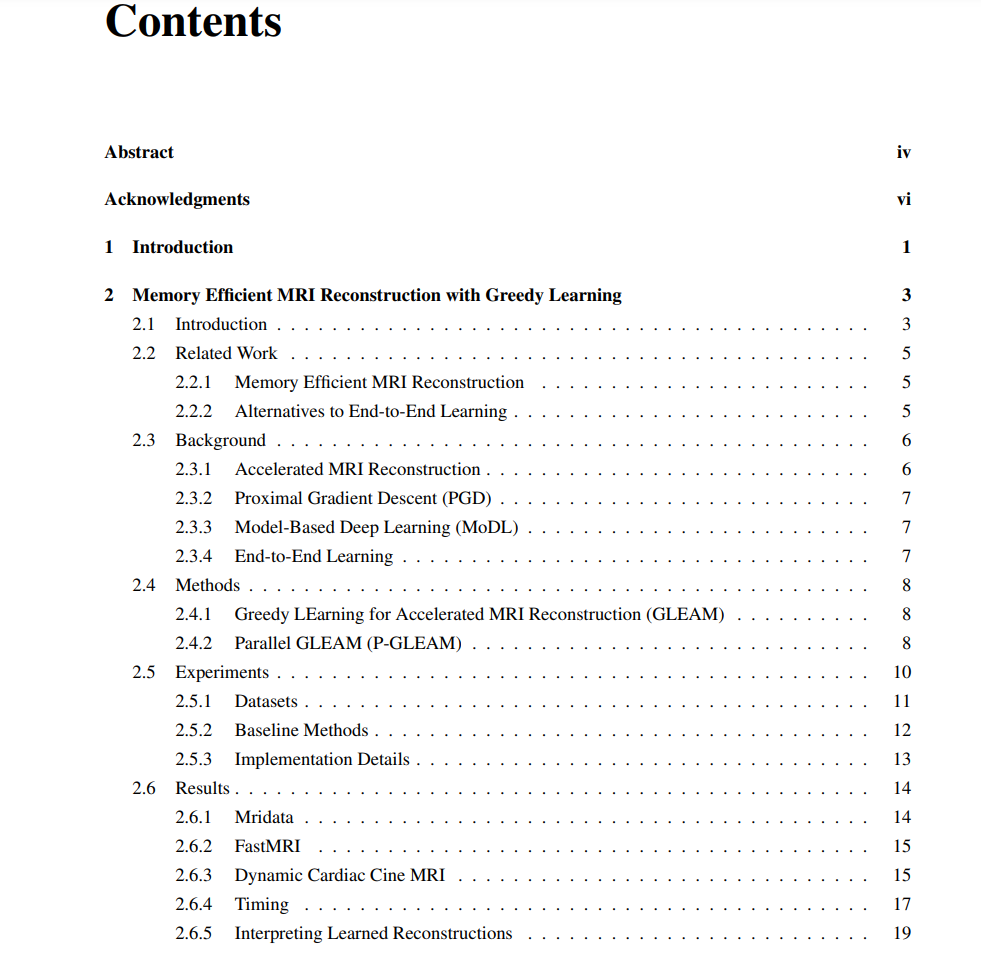

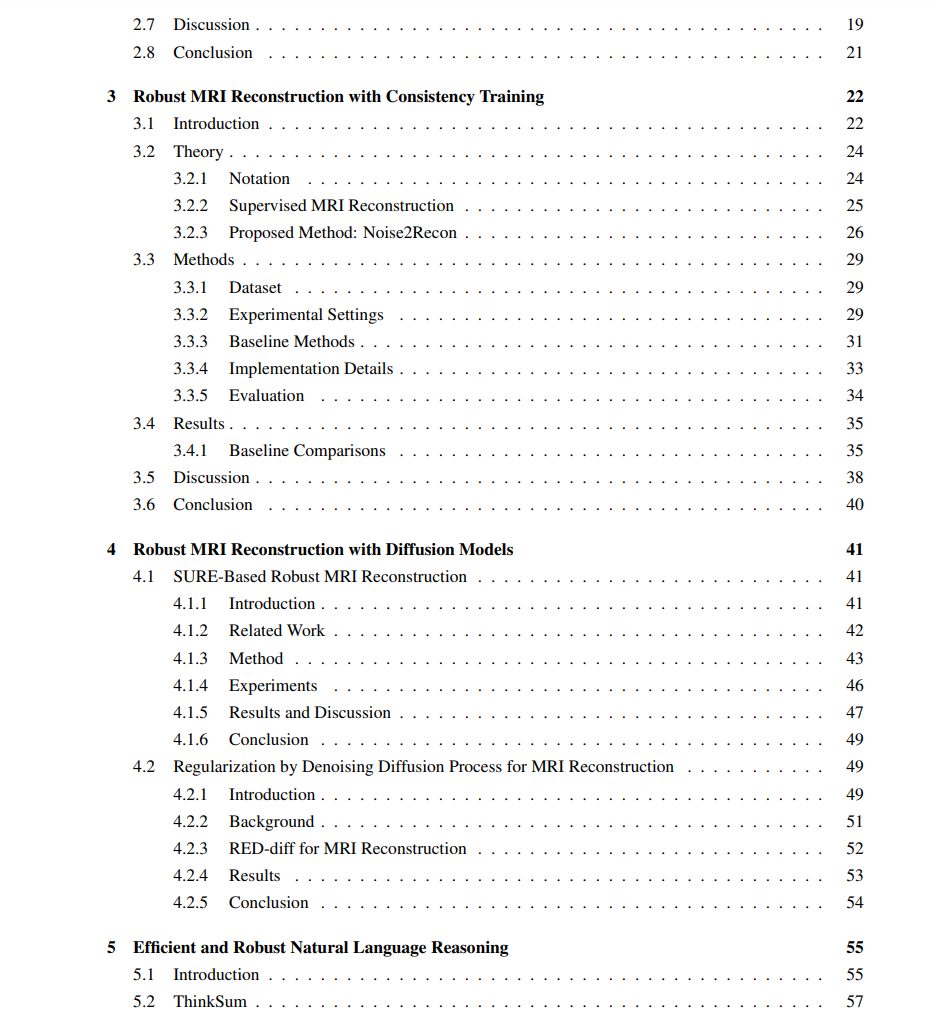

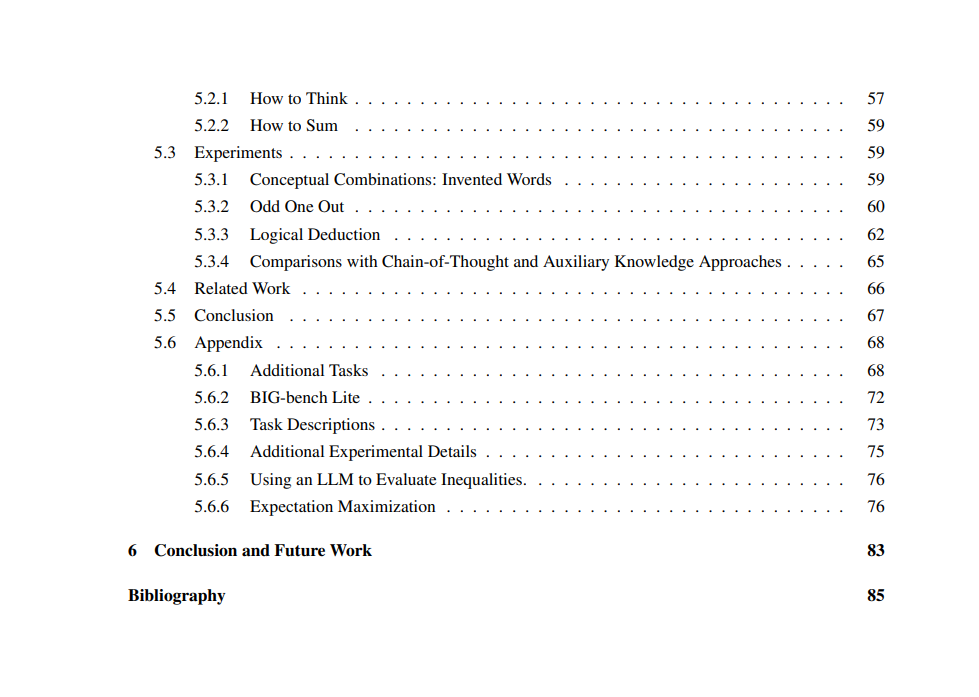

![]() 深度学习(DL)在医学影像和自然语言处理(NLP)等领域取得了显著进展。然而,在实际应用中,仍然存在一些挑战。首先,解决复杂任务需要具有高表现力的大型神经网络,这在如加速磁共振成像(MRI)重建等高维设置中,对时间和内存效率提出了重大挑战。其次,DL算法通常对训练和测试之间的分布变化敏感。例如,基于DL的MR重建方法在临床相关的分布变化(如噪声、扫描器引起的漂移和解剖结构变化)下会急剧失败。同样,在NLP中,大型语言模型(LLMs)对文本输入(提示)的格式变化(如提示中单词的顺序)也敏感。因此,开发时间和内存效率高、对分布变化具有改进鲁棒性的算法至关重要。在本论文中,我们通过一系列项目解决了现有DL技术的效率和鲁棒性问题。首先,我们描述了一种用于MRI重建的内存高效训练策略GLEAM,它将端到端神经网络分解为解耦的网络模块。GLEAM在高维设置中显著提高了时间和内存效率,同时改善了重建性能。然后,我们描述了一种一致性训练方法,该方法同时使用全采样和欠采样扫描进行抗噪声MRI重建,称为Noise2Recon。我们展示了Noise2Recon在低信噪比设置下,使用更少的标记数据,以及在推广到分布外加速因子时,比现有DL技术更具鲁棒性。接下来,我们讨论了使用扩散模型提高MRI重建鲁棒性的方法。第一种方法,称为SMRD,在测试时进行自动超参数选择以增强临床相关分布变化下的鲁棒性。SMRD在分布外测量噪声水平、加速因子和解剖结构下提高了鲁棒性,测量噪声下的PSNR提高了高达6 dB。第二种方法,称为RED-diff,基于测量一致性损失和得分匹配正则化的变分推理方法。RED-diff在使用相同内存的情况下实现了3倍的推理速度提升。最后,我们提出了一种用于自然语言推理的高效且鲁棒的概率推理方法,称为ThinkSum。ThinkSum是一种两阶段概率推理算法,它以结构化的方式推理对象或事实集合。在第一阶段,LLM在从提示或辅助模型调用中提取的一组短语上并行查询。在第二阶段,这些查询的结果被聚合以做出最终预测。我们展示了ThinkSum在困难的NLP任务上提高了性能,并且与标准提示技术相比,对提示设计更为鲁棒。此外,我们展示了ThinkSum可以同时处理对LLMs的并行查询,以提高效率。

深度学习(DL)在医学影像和自然语言处理(NLP)等领域取得了显著进展。然而,在实际应用中,仍然存在一些挑战。首先,解决复杂任务需要具有高表现力的大型神经网络,这在如加速磁共振成像(MRI)重建等高维设置中,对时间和内存效率提出了重大挑战。其次,DL算法通常对训练和测试之间的分布变化敏感。例如,基于DL的MR重建方法在临床相关的分布变化(如噪声、扫描器引起的漂移和解剖结构变化)下会急剧失败。同样,在NLP中,大型语言模型(LLMs)对文本输入(提示)的格式变化(如提示中单词的顺序)也敏感。因此,开发时间和内存效率高、对分布变化具有改进鲁棒性的算法至关重要。在本论文中,我们通过一系列项目解决了现有DL技术的效率和鲁棒性问题。首先,我们描述了一种用于MRI重建的内存高效训练策略GLEAM,它将端到端神经网络分解为解耦的网络模块。GLEAM在高维设置中显著提高了时间和内存效率,同时改善了重建性能。然后,我们描述了一种一致性训练方法,该方法同时使用全采样和欠采样扫描进行抗噪声MRI重建,称为Noise2Recon。我们展示了Noise2Recon在低信噪比设置下,使用更少的标记数据,以及在推广到分布外加速因子时,比现有DL技术更具鲁棒性。接下来,我们讨论了使用扩散模型提高MRI重建鲁棒性的方法。第一种方法,称为SMRD,在测试时进行自动超参数选择以增强临床相关分布变化下的鲁棒性。SMRD在分布外测量噪声水平、加速因子和解剖结构下提高了鲁棒性,测量噪声下的PSNR提高了高达6 dB。第二种方法,称为RED-diff,基于测量一致性损失和得分匹配正则化的变分推理方法。RED-diff在使用相同内存的情况下实现了3倍的推理速度提升。最后,我们提出了一种用于自然语言推理的高效且鲁棒的概率推理方法,称为ThinkSum。ThinkSum是一种两阶段概率推理算法,它以结构化的方式推理对象或事实集合。在第一阶段,LLM在从提示或辅助模型调用中提取的一组短语上并行查询。在第二阶段,这些查询的结果被聚合以做出最终预测。我们展示了ThinkSum在困难的NLP任务上提高了性能,并且与标准提示技术相比,对提示设计更为鲁棒。此外,我们展示了ThinkSum可以同时处理对LLMs的并行查询,以提高效率。

![]()

![]()

![]()