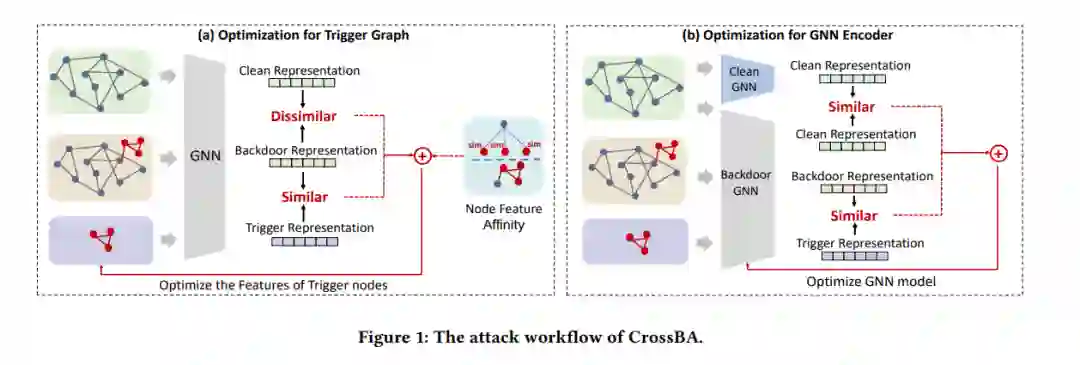

图提示学习(Graph Prompt Learning,GPL)在预训练与下游应用之间架起了重要桥梁,以缓解现实世界中图学习的知识传递瓶颈。虽然GPL在图知识传递和计算效率方面具有卓越的效果,但预训练模型中嵌入的后门中毒效应所带来的安全风险尚未得到充分探索。我们的研究对GPL易受后门攻击的脆弱性进行了全面分析。我们介绍了CrossBA,这是首个针对GPL的跨上下文后门攻击,仅在预训练阶段进行操作,无需了解下游应用。我们的研究在理论和实证上揭示了,通过调整触发图结合提示转换,可以无缝地将后门威胁从预训练编码器转移到下游应用。通过对涉及5个不同跨上下文场景和5个基准数据集的节点和图分类任务的3种代表性GPL方法进行广泛实验,我们证明了CrossBA在保持下游应用对干净输入功能的同时,一直能够实现高攻击成功率。我们还探索了针对CrossBA的潜在对策,并得出结论,当前的防御措施不足以缓解CrossBA。我们的研究强调了GPL系统中持续存在的后门威胁,提升了对GPL技术实践中信任问题的关注。

成为VIP会员查看完整内容

相关内容

Arxiv

225+阅读 · 2023年4月7日