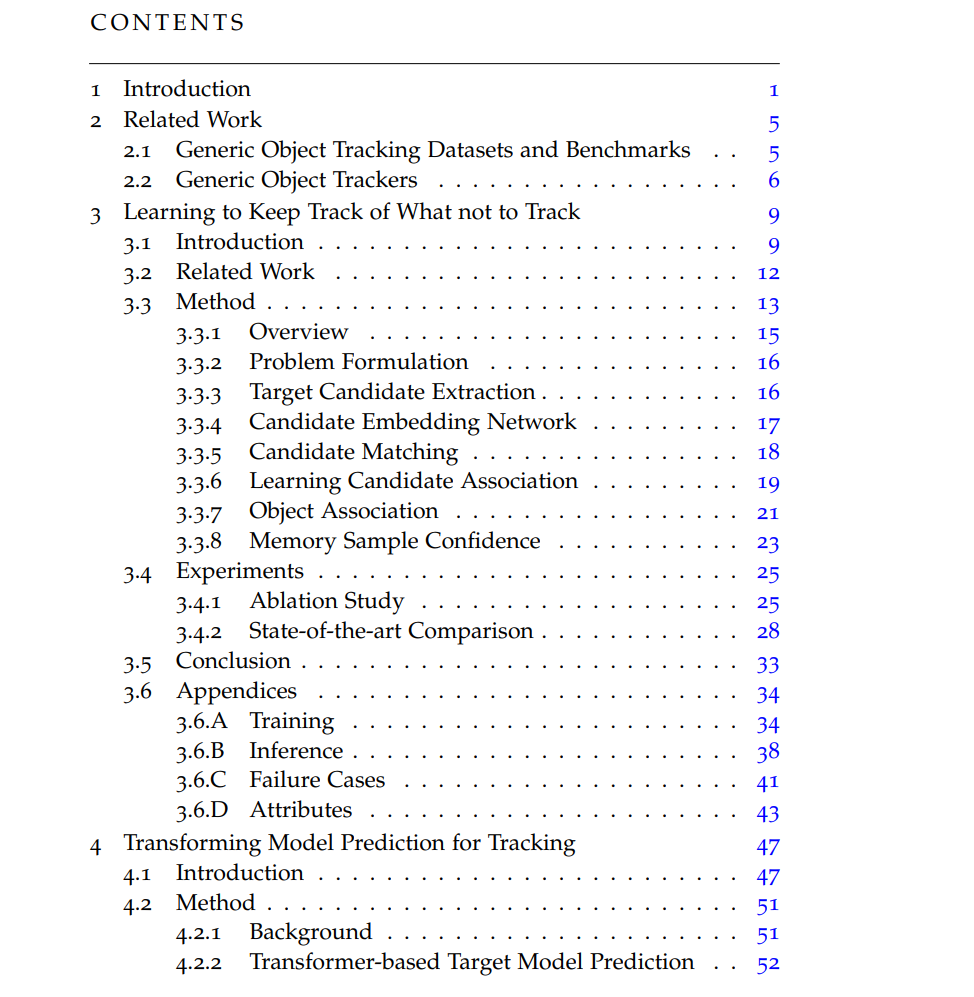

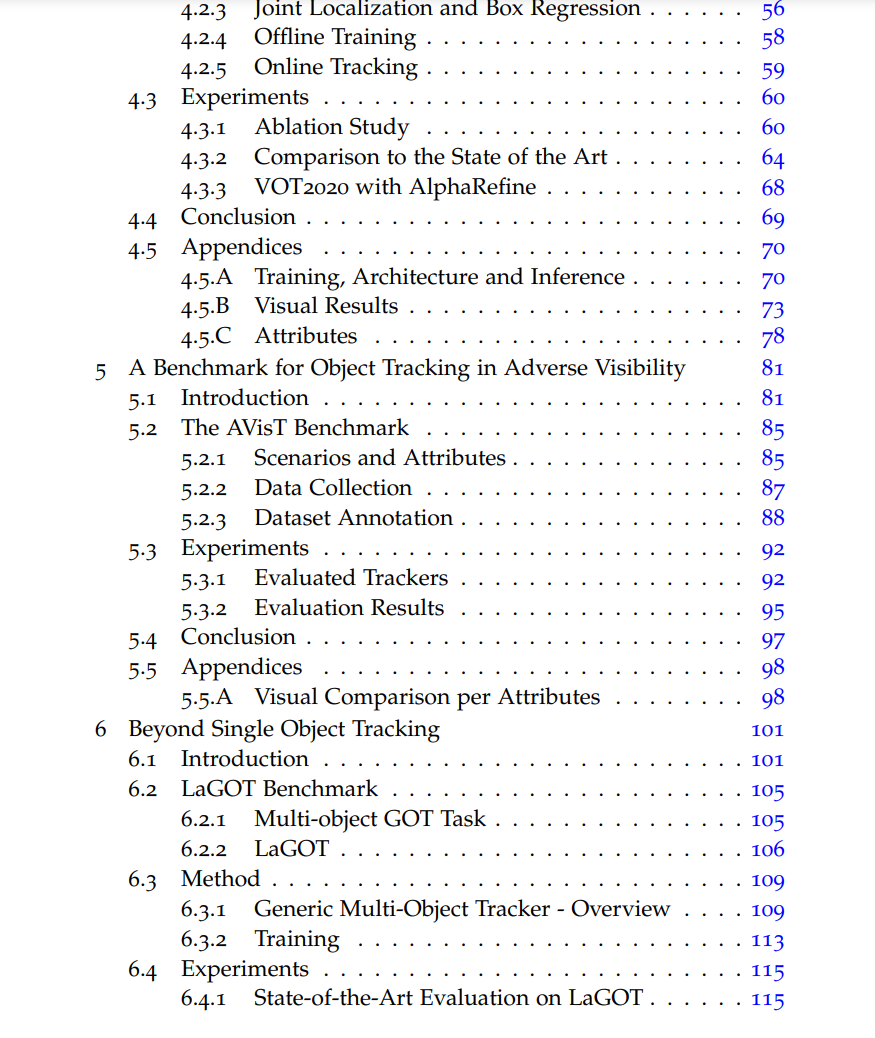

视觉物体跟踪是计算机视觉中的基本问题,并在多种任务中找到应用,如自动驾驶、机器人技术、监视、视频理解和体育分析。通用对象跟踪(GOT)是一种专门的跟踪任务,旨在通过使用用户在初始视频帧中定义目标对象的边界框来跟踪视频中的任何对象。从这样稀疏的信息中学习一个目标模型,以便在每个帧中跟踪目标,证明是极具挑战性的。尤其是在困难的跟踪情境中,目标对象经常被遮挡,走出视线,或者存在与目标视觉相似的干扰物。因此,我们在这篇论文中解决了在困难情境中的视频中鲁棒性地跟踪通用对象的问题。首先,我们提出了一个新的跟踪架构,可以跟踪干扰物以继续追踪目标。我们通过学习一个关联网络来实现这一点,该网络允许从帧到帧传播所有目标候选者的身份。为了解决视觉跟踪中干扰物之间缺乏地面真实对应的问题,我们提出了一种结合部分注释和自监督的训练策略。其次,我们引入了一个基于Transformer的目标模型预测器,用于生成目标模型。所使用的Transformer具有很小的归纳偏见,从而允许其学习对困难序列进行强大的目标模型预测。我们进一步扩展模型预测器,以估计第二组权重,这些权重用于准确的边界框回归。第三,我们提出了一个新的视觉跟踪基准,AVisT,专门用于具有不利可见性的跟踪情境。AVisT包含18种不同的情境,大致分为五个属性,包含42个对象类别。AVisT的关键贡献是多样性和具有挑战性的情境,涵盖了严重的天气条件、遮挡和不利的成像效果,以及伪装。最后,我们提出了多对象GOT的任务,这比在每个视频中仅跟踪一个通用对象具有更广泛的适用性,使其在实际应用中更具吸引力。为此,我们引入了一个新的大规模GOT基准,LaGOT,每个序列都包含多个注释的目标对象。我们的基准允许研究人员解决GOT中的剩余挑战,旨在通过同时跟踪多个对象来增加鲁棒性并减少计算。此外,我们提出了一个基于Transformer的GOT跟踪器,能够通过共享计算同时处理多个对象。