传感器与导弹技术的进步彻底改变了现代空战模式,将交战形式转变为以远程数据驱动为特征的超视距空战场景。在此类环境中,实时决策系统必须能处理序列化的高维非平稳数据,并随时间推移保持关键信息。本研究探讨了最新推出的神经网络架构——Mamba、minGRU和minLSTM——处理此类数据的有效性。虽然这些架构在监督学习(SL)与离线强化学习(RL)中展现出优异性能,但其在在线强化学习、部分可观测环境及多智能体设置中的表现此前尚未得到验证。早期研究表明,静态监督学习基准可能难以准确反映强化学习性能。为深入探究此问题,本研究评估了非平稳数据上的监督学习表现是否能更好地预测强化学习性能。我们设计了三种非平稳监督学习测试来模拟强化学习中存在的非平稳特性,随后在四个部分可观测的强化学习环境中开展实验,其中包含一个高维多智能体空战场景。结果显示,在对比静态与非静态条件时,各模型的监督学习性能差异微乎其微;而在强化学习中性能差异显著扩大,其中minGRU展现出最优的学习进展。值得注意的是,minLSTM虽在监督学习中表现稳定,却在强化学习中遭遇严重困难。这些发现表明,静态与非静态监督学习性能对强化学习性能的预测价值均十分有限。

对人类而言,在复杂环境中解读海量动态数据需要依靠多年经验与训练。然而对于强化学习智能体,要高效处理这些信息以支持自主或辅助人类决策,则需借助先进的机器学习表征技术。本硕士论文致力于研究旨在为超视距空战场景中的决策智能体捕获并保存关键信息的深度学习架构。该论文于林雪平的萨博公司完成。

1.1 研究动机

现代空战因传感器与导弹技术的进步而发生深刻变革。这些发展使空战特征从依赖快速机动与肉眼识别的近程战斗,转变为由传感器网络与先进武器系统驱动的远程对抗。随着新作战概念的出现,飞行员的态势感知越来越依赖于解读传感器数据[1]。这种转变凸显出能够实时处理大量动态数据的决策支持系统日益重要,它们可帮助飞行员与自主系统在高风险场景中作出有利决策。战斗机决策支持系统与全自主战斗机领域是当前研究热点,已有大量论文探索将强化学习应用于超视距空战[2][3][4][5][6]。多项研究证明使用强化学习训练的智能体能够展现智能决策能力[6]并重现既定战术行为[4]。传统深度学习架构处理序列数据时常面临梯度消失与爆炸等挑战。用于更新网络权重的梯度往往趋于接近零或失控增长,导致网络难以学习对许多强化学习任务至关重要的长期依赖关系[7]。另一挑战是处理序列数据的计算成本通常随序列长度线性增长。为应对这些局限,现代研究聚焦于设计能更有效处理长序列依赖的架构。近年来,传统循环神经网络(RNN)架构长短期记忆(LSTM)与门控循环单元(GRU)的两种变体——minLSTM与minGRU——被提出。这些模型在保持学习长期依赖能力的同时降低了计算成本[8]。此外,基于状态空间模型(SSM)的线性时间序列建模架构Mamba也展现出类似能力[9]。然而这些架构的全部潜力尚待充分理解与验证。虽然许多架构在不同任务的监督学习(SL)中超越传统循环神经网络,但其在强化学习中的表现因不稳定与泛化能力差而参差不齐[10]。监督学习与强化学习性能差异的潜在解释是:监督学习通常使用静态数据集,而强化学习环境(尤其在多智能体设置中)具有高度非平稳性。该假设表明,通过非平稳监督学习任务评估模型或可成为预测其强化学习性能的有效指标,本项目将对此展开研究。

1.2 研究目标

通过评估新型神经网络架构,本研究旨在揭示其在多智能体强化学习(特别是超视距空战场景)中的适用性。同时探究非平稳数据上的监督学习性能与强化学习环境表现之间的潜在关联。这些发现也可为其他需要高效率与可扩展性的实时系统提供架构选择方面的实践参考。

1.3 研究问题

- 与静态数据训练相比,基于LSTM、minGRU、minLSTM和Mamba的模型在非平稳数据训练中如何表现(涉及训练稳定性与性能)?

- 在监督学习与强化学习中,LSTM、minGRU、minLSTM和Mamba神经网络架构的训练吞吐量与单步训练学习进展有何差异?

- 监督学习中非平稳数据上的训练性能如何作为强化学习性能的预测指标?

- 基于LSTM、minGRU、minLSTM和Mamba的模型在低维观测与动作空间的单智能体环境与高维多智能体环境中的强化学习性能对比如何?

1.4 研究贡献

本论文为深度学习领域作出以下贡献:

• 设计与实现了非平稳监督学习实验。在既有研究基础上,将现有理念适配于新数据集,并从头设计了一项新颖测试;

• 首次对minGRU与minLSTM模型在在线强化学习(包括单智能体与多智能体设置)中进行实证评估;

• 拓展了监督学习与强化学习性能关系的跨领域研究,进一步纳入非平稳监督学习性能分析。

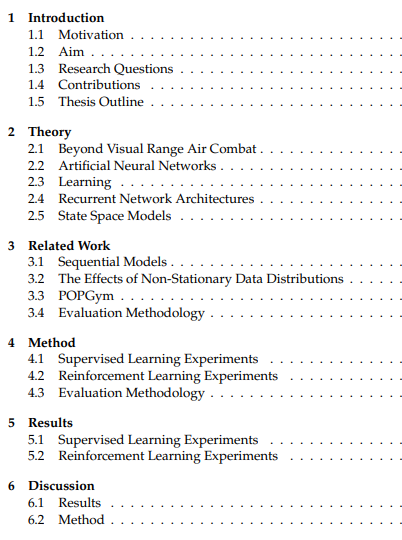

1.5 论文结构

本节说明论文的组织架构。第二章"理论基础"介绍理解本工作所需的理论背景。第三章"相关研究"综述与本文相关的既往研究。第四章"方法"描述实验设置。第五章"结果"呈现监督学习与强化学习的实验结果。第六章"讨论"解读结果并对所用方法进行批判性分析。第七章"结论"回答研究问题并提出未来工作的潜在方向。