【导读】伦敦帝国理工学院教授Michael Bronstein等人撰写了一本关于几何深度学习系统性总结的书,提出从对称性和不变性的原则推导出不同的归纳偏差和网络架构。非常值得关注!

几何深度学习是一种从对称性和不变性的角度对大量ML问题进行几何统一的尝试。这些原理不仅奠定了卷积神经网络的突破性性能和最近成功的图神经网络的基础,而且也提供了一种原则性的方法来构建新型的问题特定的归纳偏差。

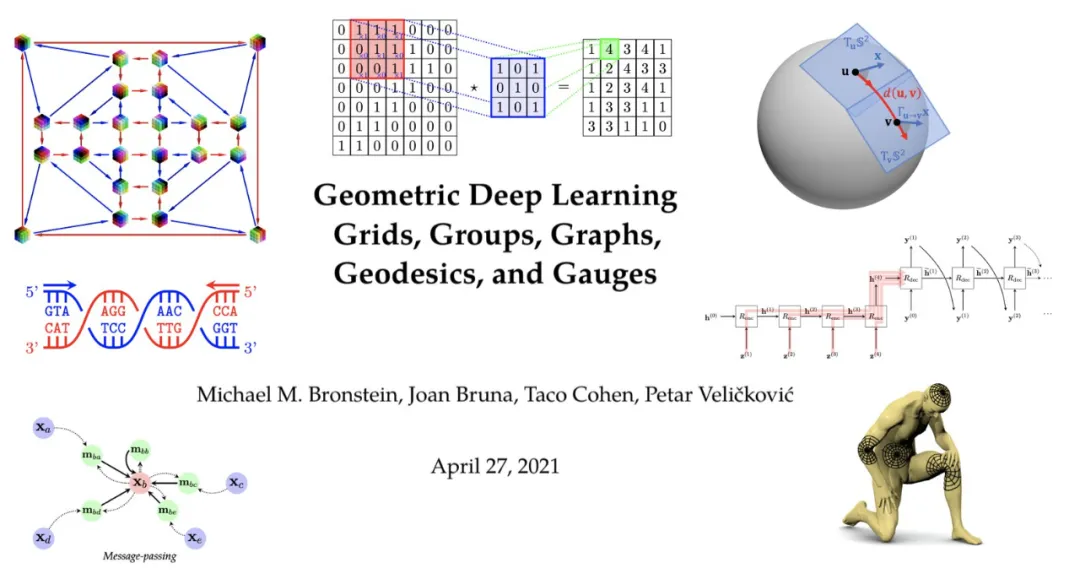

在本文中,我们做了一个适度的尝试,将Erlangen项目的思维模式应用到深度学习领域,最终目标是获得该领域的系统化和“连接点”。我们将这种几何化尝试称为“几何深度学习”,并忠实于Felix Klein的精神,提出从对称性和不变性的原则推导出不同的归纳偏差和网络架构。特别地,我们将重点放在一类用于分析非结构集、网格、图和流形的神经网络上,并表明它们可以被统一地理解为尊重这些域的结构和对称性的方法。

我们相信这篇文章将吸引深度学习研究人员、实践者和爱好者的广泛受众。新手可以用它来概述和介绍几何深度学习。经验丰富的深度学习专家可能会发现从基本原理推导熟悉架构的新方法,也许还会发现一些令人惊讶的联系。实践者可以获得如何解决各自领域问题的新见解。

一些重要论述:

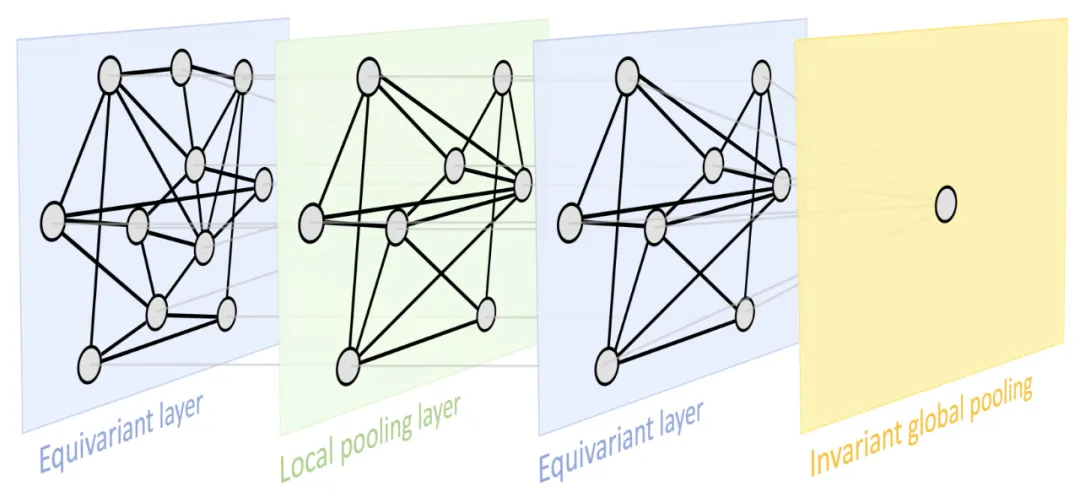

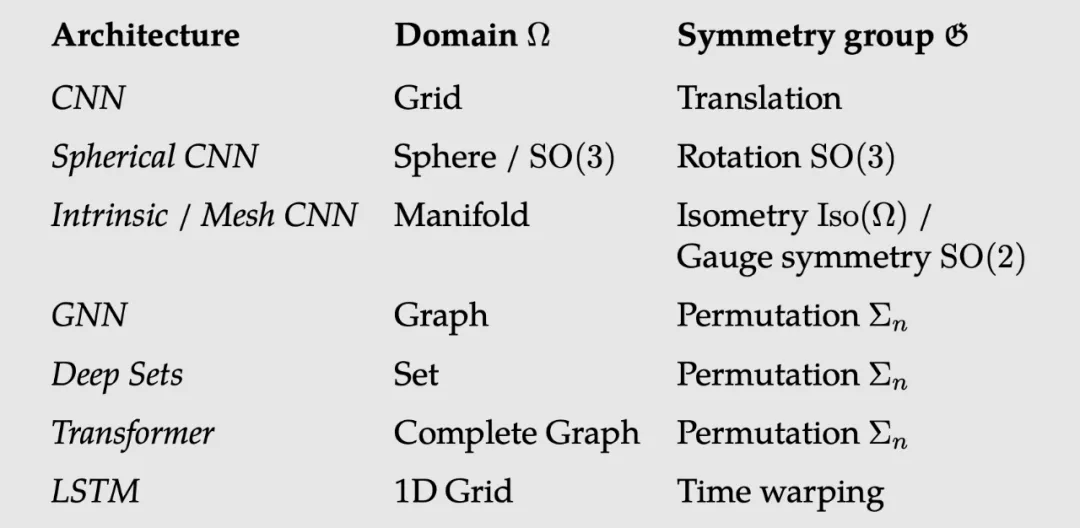

- 我们研究了流行的深度学习架构(CNNs, GNNs, transformer, LSTMs)的本质,并意识到,只要有一组合适的对称,我们就可以等价它们,它们都可以用一个通用的几何框架来表达。

- 更进一步,我们在一些不太标准的领域(如同质群和流形)上使用了我们的框架,这表明框架可以很好地表达这些领域的最新进展,如球形CNN, SO(3)-变换器,和规范-等变网格CNNs。

- 几何深度学习的“5G”:网格、组(具有全局对称性的齐次空间)、图(以及作为特定情况的集)和流形,其中几何先验通过全局等距不变(可以用测地线表示)和局部规范对称来表现。

成为VIP会员查看完整内容

相关内容

Arxiv

0+阅读 · 2021年6月16日

Arxiv

10+阅读 · 2018年3月27日