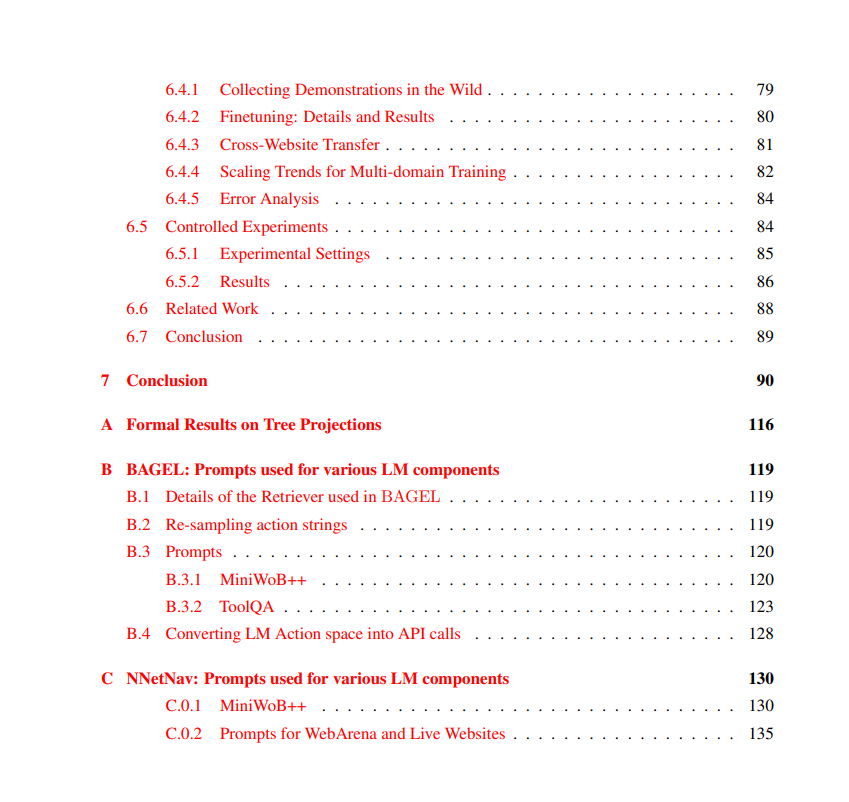

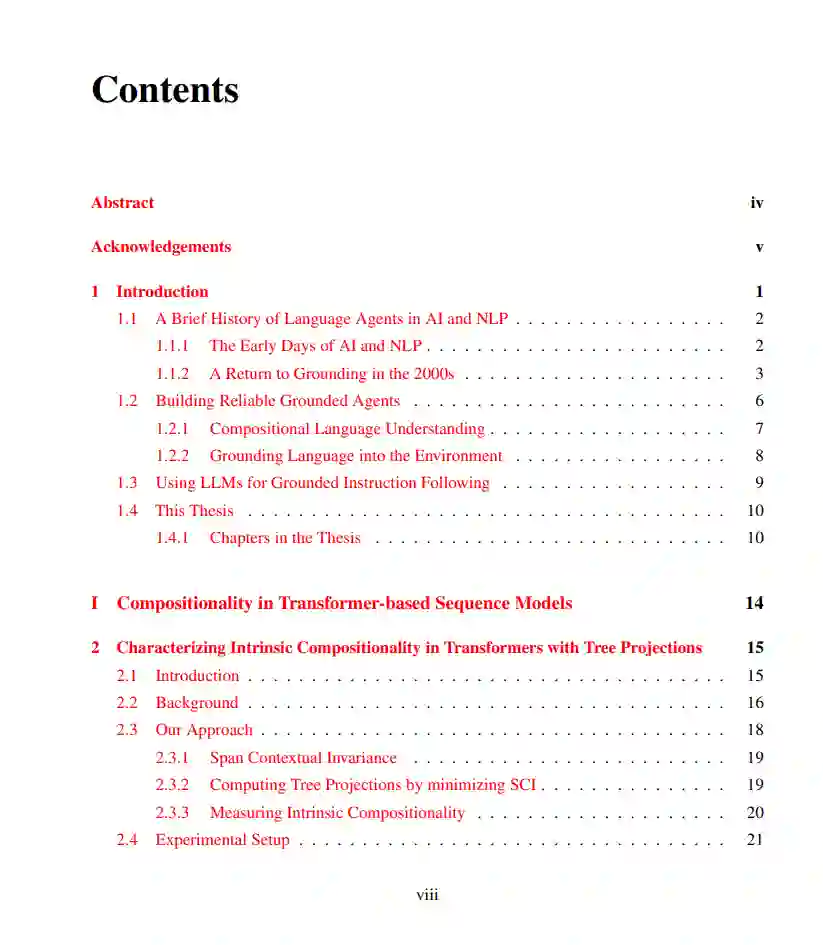

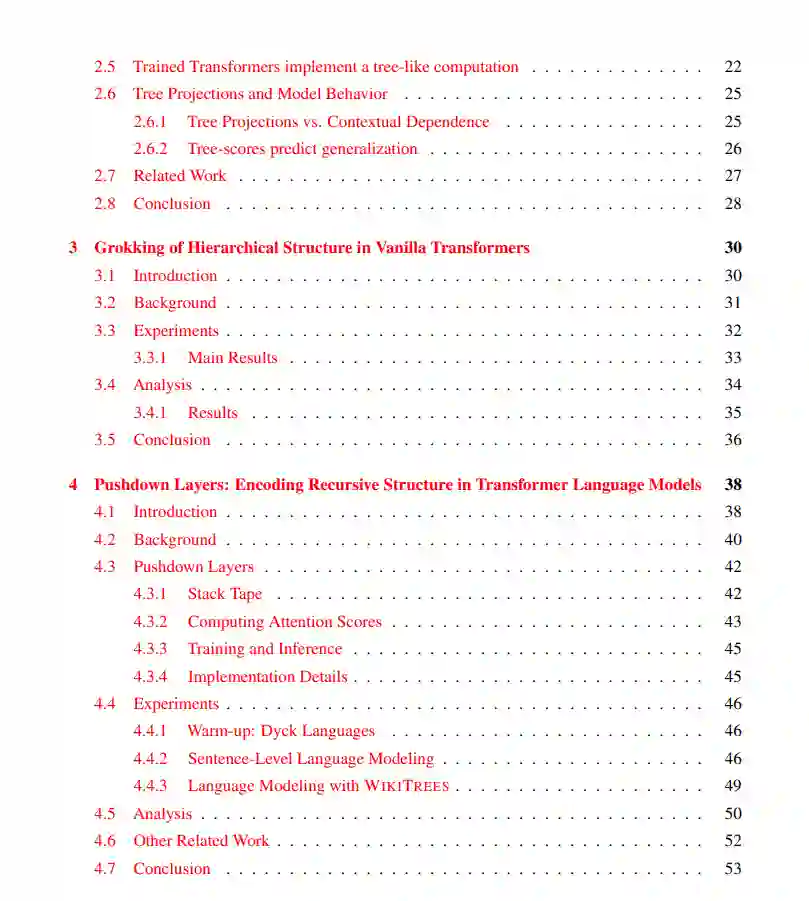

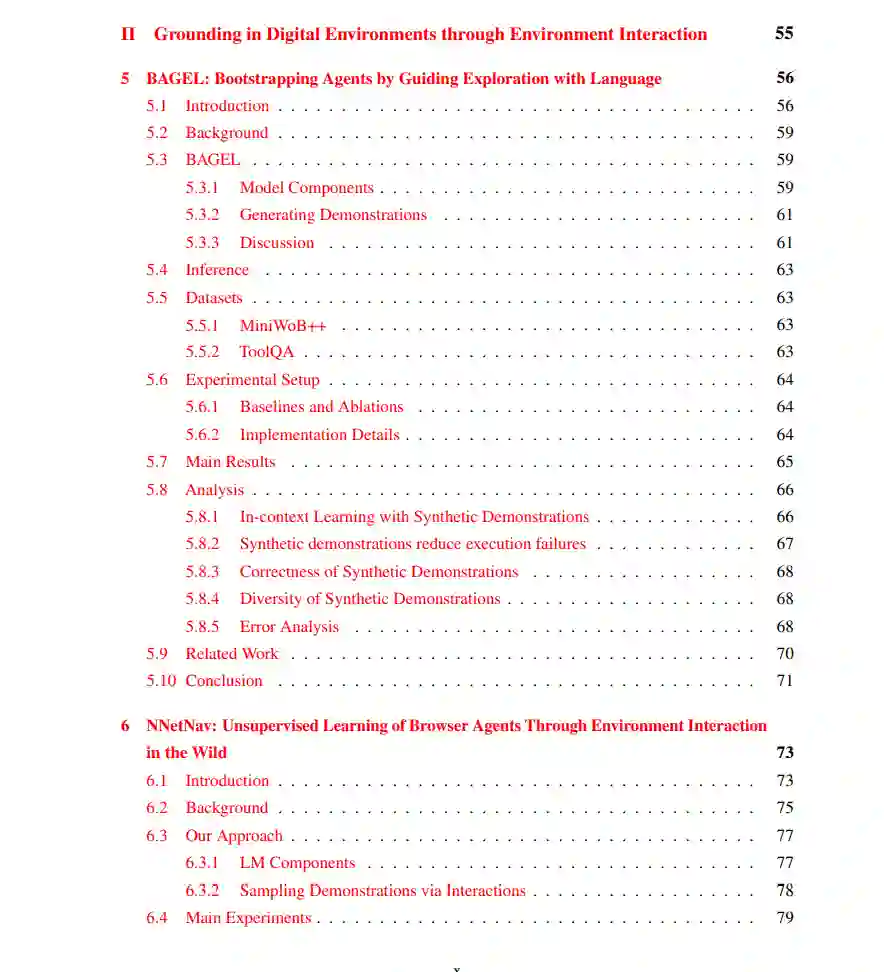

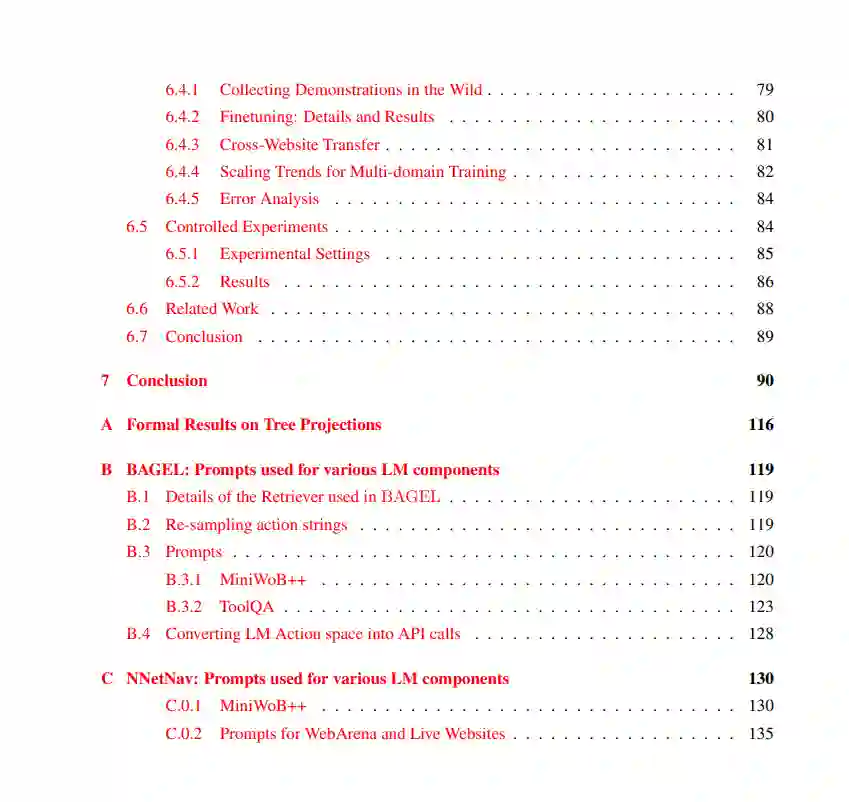

大语言模型(LLMs)已展现出卓越的能力,越来越多的研究致力于将其作为智能体(agents)使用——即能够将自然语言表达的复杂人类目标转化为在数字环境(如网页浏览器)中的一系列操作行为。要实现这一目标,需具备两个核心能力:第一,理解任意组合性的语言输入;第二,在陌生环境中自主学习,以便将语言目标有效地落实为多步决策行为。本论文正是围绕这两个挑战展开研究。 在第一部分中,我提出了 Tree Projections 框架,用于理解 Transformer 如何构建组合性结构。随后,我基于 Tree Projections 提出一系列研究成果,揭示了 Transformer 中组合泛化(compositional generalization)、“顿悟”现象(grokking)以及样本高效学习的机制。尽管 Tree Projections 有助于解释模型的泛化能力,已有研究表明标准 Transformer 在处理深层递归时表现不佳,其根本原因是缺乏支持无限层级结构的机制。为此,我提出了 Pushdown Layers,一种引入基于栈的记忆机制的结构增强方法。Pushdown Layers 能够提升模型在嵌套或递归推理任务中的样本效率与泛化能力。 在第二部分中,我介绍了 NNetNav 与 BAGEL,两种用于网页环境中无监督、开放式探索的方法,使得模型能够在无需人工监督的情况下,自动为新网页采集训练数据。最佳效果来自于结合 NNetNav 所采集的示范数据对 LLM 进行微调。NNetNav 利用语言的层级结构来引导探索策略。借助 NNetNav,我们从 20 个真实网站中采集了 10,000 条交互示范,并据此微调了一个 80 亿参数的模型,在多个网页浏览基准测试中实现了无监督方法的新 SOTA,超越了零样本设置下的 GPT-4 表现。 总体而言,这些工作将我们更进一步推向具备语言理解与自主交互学习能力的数字语言智能体的发展目标。