在开放世界中分类是验证模型安全性的重要方式,也是一个真正能够商用落地的模型不可避免要面对的问题。传统的分类模型都是在一个封闭的世界中进行训练,即假设测试数据和训练数据都来自同样的分布(称作分布内,in-distribution)。例如我们利用一组猫、狗照片训练一个猫、狗分类器。然而,部署的模型在实际使用中总是会遇到一些不属于封闭世界类别的图片,例如老虎。或者也会遇到一些和训练图片视觉上大相径庭的照片,例如卡通猫。模型应当如何去处理这些不属于训练分布的图片(即分布外样本,out-of-distribution),是开放世界领域所关注的问题。

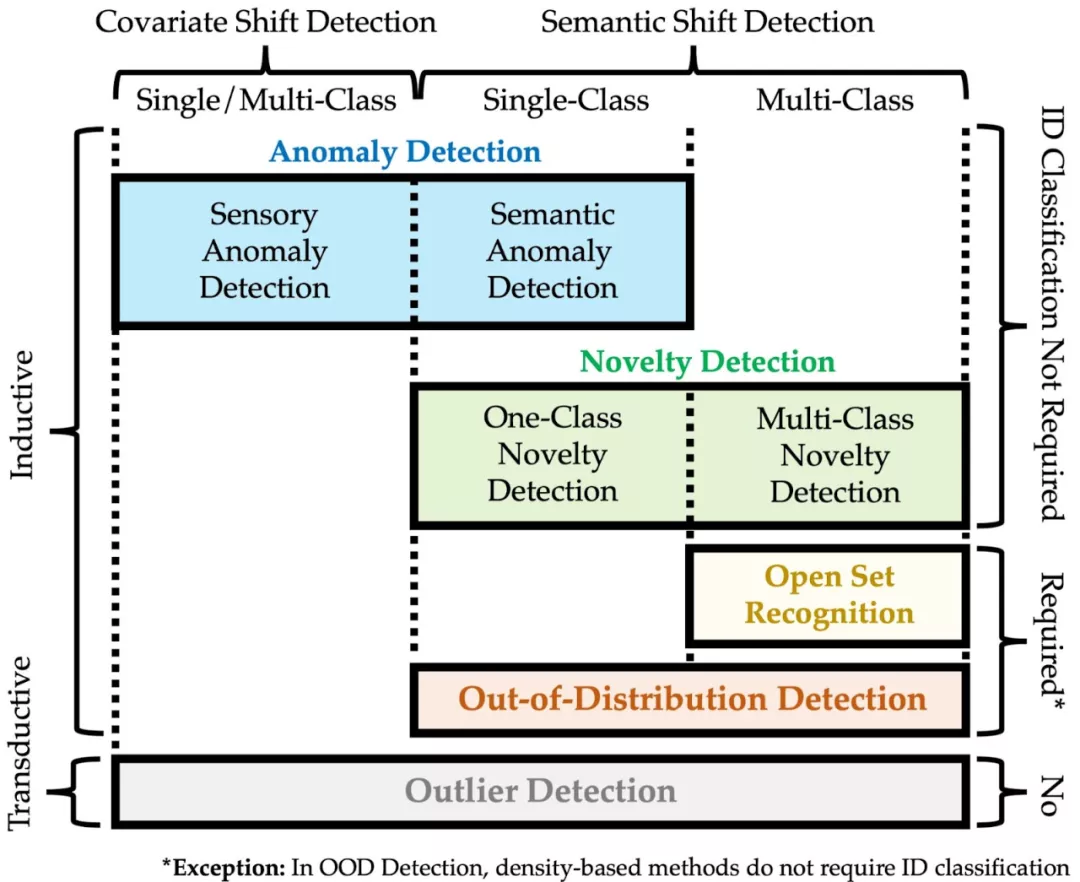

开放世界领域中时常能够见到如下几个任务:

- OD: Outlier Detection, 离群检测

- AD: Anomaly Detection, 异常检测

- ND: Novelty Detection, 新类检测

- OSR: Open Set Recognition, 开集识别

- OOD Detection: Out-of-Distribution Detection, 分布外检测

它们之间虽然各有千秋,却又有千丝万缕的联系。虽然现有工作也有尝试着将自己的任务和别的任务进行区分,但是各任务之间也不统一,使得整个领域都缺乏对各个任务准确的定义。让外界甚至参与者都对各个任务的具体目标困惑。

为了解决这个问题,一篇名为《Generalized Out-of-Distribution Detection: A Survey》的综述解决了这些困惑,将以上五个任务归纳进一个「广义 · 分布外检测」(Generalized OOD Detection)的大框架内。至此,这些任务都能进行准确的定位,而它们之间的关系也顿时清晰可辨。

论文地址: https://www.zhuanzhi.ai/paper/c934e74c6afb7fea3ed931c98877448f 项目主页:https://github.com/Jingkang50/OODSurvey

摘要:分布外检测(Out-of-distribution,OOD)是确保机器学习系统可靠性和安全性的关键。例如,在自动驾驶中,我们希望驾驶系统在检测到以前从未见过的不寻常场景或物体,无法做出安全决定时,发出警报,并将控制权交给人类。该问题最早出现于2017年,从那时起就越来越受到研究领域的关注,由此产生了大量的研究方法,从基于分类到基于密度再到基于距离的方法。同时,在动机和方法论方面,还有几个问题与OOD检测密切相关。这些方法包括异常检测(AD)、新奇检测(ND)、开放集识别(OSR)和异常点检测(OD)。尽管有不同的定义和问题设置,这些问题经常混淆读者和从业人员,因此,一些现有的研究误用术语。在本次综述中,我们首先提出了一个称为广义OOD检测的通用框架,它包含了前面提到的五个问题,即AD、ND、OSR、OOD检测和OD。在我们的框架下,这五个问题可以看作是特殊情况或子任务,更容易区分。然后,我们通过总结它们最近的技术发展,对这五个领域进行全面的调研。我们总结了这个调研查的开放挑战和潜在的研究方向。