摘要

大型语言模型(LLMs)的出现为自然科学与社会科学研究带来了变革性机遇,其通过提供理解复杂系统的新范式,正重塑相关领域的研究进程。尤其是生成式智能体模拟(GABMs)——通过整合LLMs模拟人类行为,因其能在多样化人工环境中建模复杂交互而日益受到关注。本文综述了LLMs在网络科学、演化博弈论、社会动力学及流行病建模等领域的颠覆性作用,评估了其在社会行为预测、博弈合作增强、疾病传播模拟等方面的最新进展。研究发现,LLMs不仅能复现人类典型行为(如公平偏好、合作倾向、社会规范遵循),还具有成本效益、可扩展性和伦理简化等独特优势;但同时也存在因提示词敏感性、幻觉问题甚至模型特性导致的行为不一致性,这为控制此类AI驱动的智能体带来了挑战。尽管潜力巨大,若要将LLMs有效整合至政府、社会或个人决策流程中,仍需解决数据偏见、提示词设计难题及人机交互动力学理解等关键问题。未来研究需优化模型架构、标准化方法论,并探索LLMs与人类及彼此交互中可能涌现的新型合作行为,这些进展或将彻底改变各类系统的决策模式。

关键词:大语言模型(LLMs),生成式智能体模拟(GABMs),复杂系统,网络科学,合作博弈,社会动力学,流行病建模********************************

彭晨丨作者

论文题目:LLMs and generative agent-based models for complex systems research 发表时间:2024年10月28日 论文地址:https://doi.org/10.1016/j.plrev.2024.10.013 会议名称:Physics of Life Reviews **

**

近年来,大语言模型(LLMs)的突破性进展正在重塑自然科学与社会科学的研究范式。近期,发表在 Physics of Life Reviews 的综述文章系统梳理了LLMs与生成式智能体模拟(Generative Agent-Based Models, GABMs)在复杂系统研究中的前沿应用。这类模型通过将LLMs嵌入智能体决策核心,能够实现人类在复杂环境中的互动行为的模拟,为网络演化、群体合作、社会动态传播等经典问题提供了全新研究路径。LLMs不仅能复现人类的公平性、合作倾向等社会规范,还展现出成本效益、可扩展性和伦理简化等独特优势。然而,其行为的不一致性、提示敏感性以及“幻觉”问题也揭示了AI智能体控制的技术挑战。

****

**

复杂网络:LLM驱动的自组织网络演化

在复杂网络领域,传统模型依赖固定规则生成节点连接,而GABMs首次实现了基于语义理解的网络自组织。一项研究通过GPT-3.5模拟在线社交网络生长:每个新加入的智能体(节点)在接收到包含现有成员好友数的提示后,自主决定连接对象。有趣的是,初始实验发现网络呈现独特的**“中心-辐条”结构**,与传统偏好连接模型(preferential attachment)的幂律分布明显不同。深入分析揭示,这种偏差源于LLM对节点名称的隐性偏好——当研究者将节点名称随机化后,网络结构立即趋近经典模型。这种**“名称偏见”**现象凸显了LLMs在模拟人类行为时可能引入的隐性认知偏差。

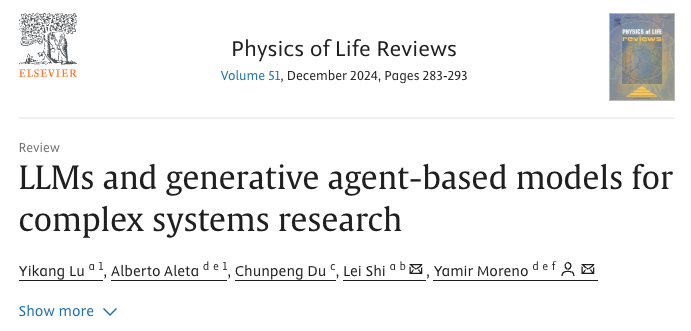

图 1. 生成式智能体模型(GABMs)。智能体并不根据一组固定的规则来决定它们之间的相互作用。相反,会向LLM发送包含所需详细信息的提示,并返回智能体应该做出的决策。

****

**

博弈论:AI智能体的合作悖论

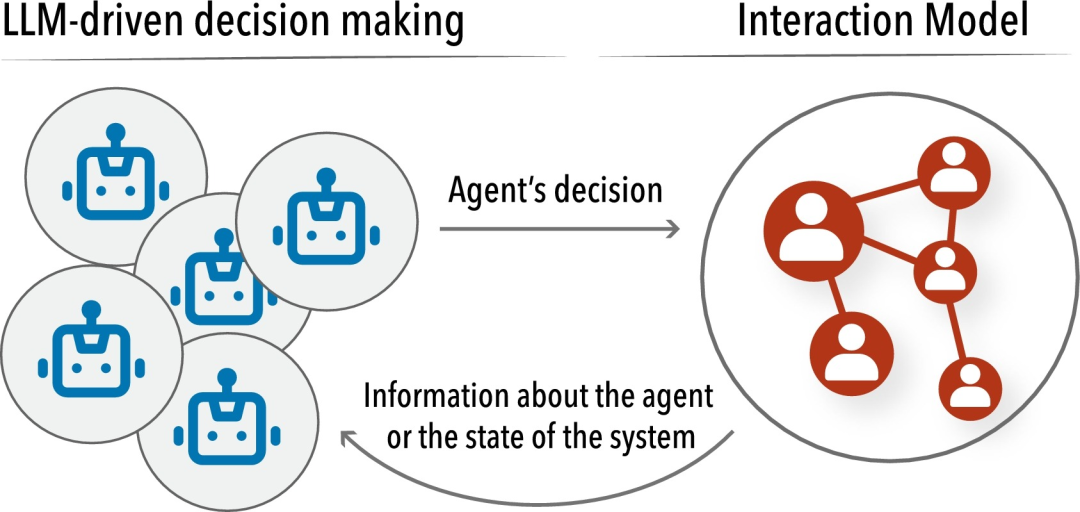

博弈论实验成为检验LLMs社会认知能力的试金石。一项独裁者博弈(Dictator Game)中发现,GPT-3.5智能体的平均分配公平性显著高于人类,且从未选择“独占全部资源”的理性策略。

在一项囚徒困境(Prisoner's Dilemma)的单次博弈中,LLMs的合作率高达65.4%,远超人类37%的历史数据。这种超理性行为在另一团队的迭代实验中发生反转:**当GPT-4智能体相互博弈时,表现出“一次背叛终身不合作”**的极端惩罚策略,揭示了模型版本更新带来的行为变化。

这些矛盾结果暗示,LLMs的合作倾向高度依赖提示框架和模型微调策略,其“价值观”本质上是开发者预设与社会训练数据共同作用的产物。

图3. 提示一个LLM参与独裁者博弈。将Brookins等人提供的指令复制到使用GPT-3.5的LLM智能体中。虽然指令没有明确提到公平,但LLM表现出公平分配的倾向,超过人类参与者。

****

**

社会动力学:人机混合决策的曙光

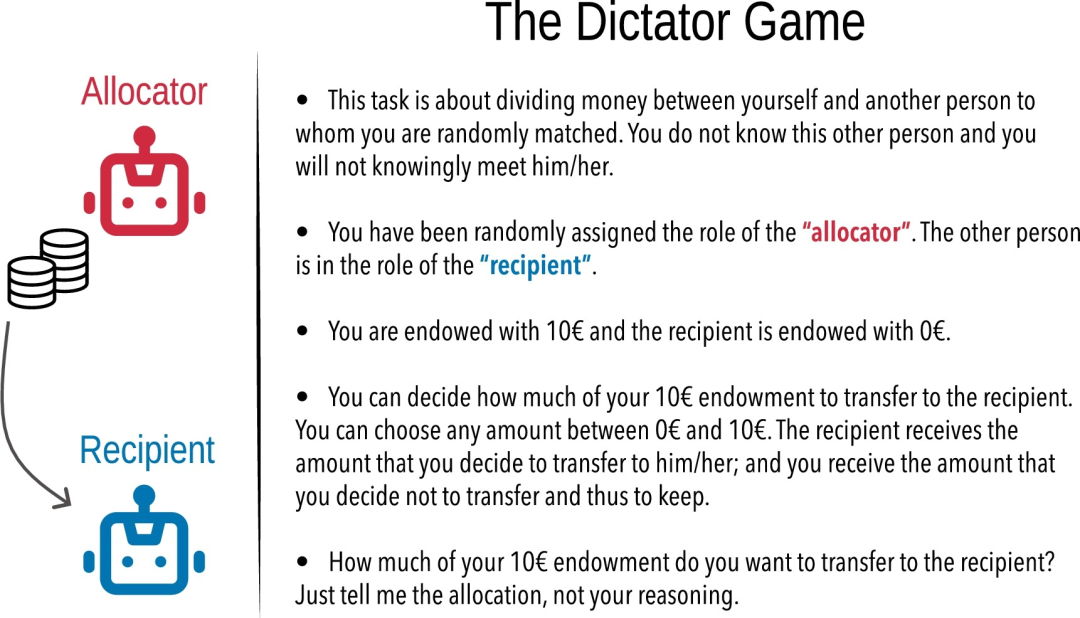

社会动态模拟方面,LLMs正在突破传统智能体模型的局限。一项研究在流行病建模中构建了三层提示框架:基础场景智能体仅考虑工作收入;健康反馈层加入个体症状感知;完整反馈层进一步引入社区感染数据。结果显示,获取群体信息的智能体自发产生居家隔离行为,使疫情传播规模下降80%。这种无需预设规则的适应性决策,为公共卫生干预模拟提供了动态响应基础。

图5. LLM驱动智能体的疫情传播模型。Williams等人提出一种模型,其中个体每天通过LLM决策是否外出互动或居家隔离。在基准场景中,LLM仅被告知个体需要工作赚钱;在健康状态反馈场景中,提示词额外包含个体的健康状况;最终,完整反馈场景还会提供社区病毒传播信息(研究者将其命名为"Catasat病毒")及前一阶段同区域(名为"Dewberry Hollow")的感染人数数据。

而在群体决策领域,另一项研究证实GPT-3能精准模拟特定亚文化群体(如美国福音派基督徒)的政治倾向,其预测结果与真实民调误差小于2%。这种细粒度的人群建模能力,使政策仿真可以触及传统问卷调查难以覆盖的微观社会结构。

****

**

挑战与未来:人机共生的决策新生态

尽管前景广阔,LLMs在复杂系统中的应用仍面临三重挑战。首先是提示工程的脆弱性:在最后通牒博弈(Ultimatum Game)中,同一LLM作为提议者与响应者时行为一致性仅50%,而双智能体架构则提升至88%,显示决策角色的语义隔离至关重要。

其次是价值观的隐形编码,在一项政治倾向量表检测中发现,早期模型(如BERT)呈现保守倾向,而GPT-4则更趋自由主义,这种偏差可能扭曲社会模拟的客观性。

**最后是群体涌现的不确定性,**在多智能体公共品博弈中发现,恶意节点的存在会使相邻个体贡献率下降40%,但另一团队观察到补偿性合作增强,这种矛盾可能源于不同LLM版本的风险评估机制差异。

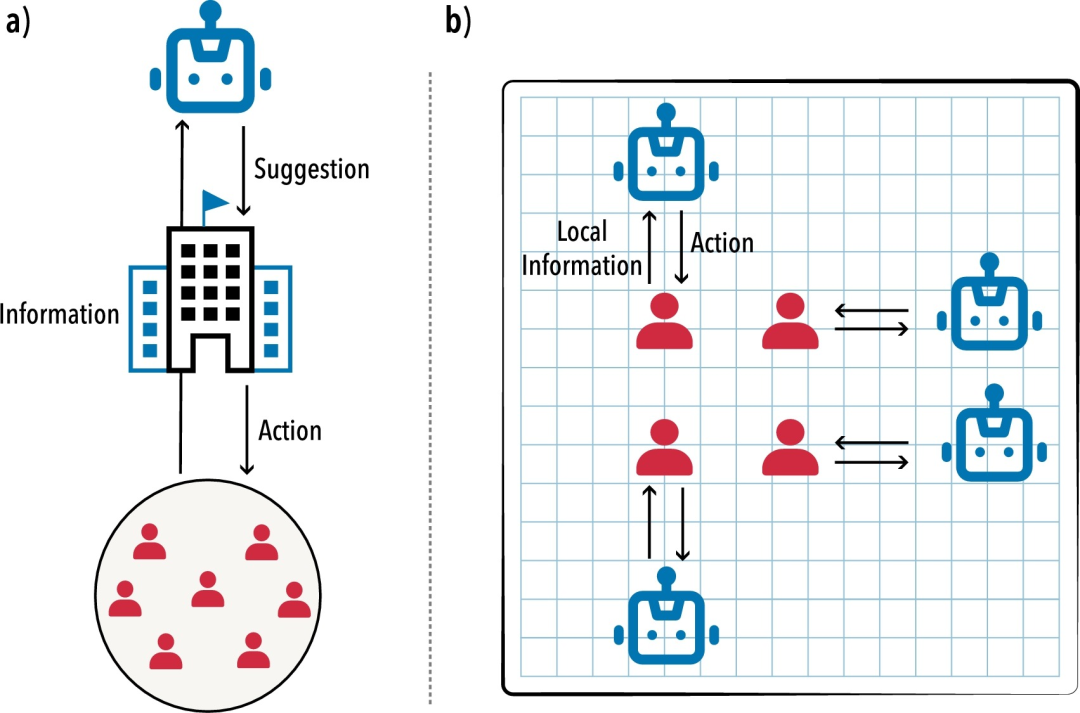

图6. LLM在社会决策中的整合应用。左图:智能体为政府或第三方组织提供决策支持,右图:智能体辅助个人决策的过程。此类智能元素的整合机制,在概念上类似于领域专家委员会模式,但其规模可扩展至前所未有的水平。

因此,未来的研究需建立标准化的提示词协议、开发偏差检测工具,并深入探索人机混合群体中新型合作机制的涌现规律。当数十亿LLM智能体在数字空间持续交互,可能催生超越人类经验的社会动力学新模式。这场始于语言理解的革命,未来可能将重塑我们理解复杂性的方式。

参考文献 [1] De Marzo, G., Pietronero, L., & Garcia, D. (2023). Emergence of scale-free networks in social interactions among large language models. arXiv preprint arXiv:2312.06619. [2] Guo, F. (2023). GPT in game theory experiments. arXiv preprint arXiv:2305.05516. [3] Williams, R., Hosseinichimeh, N., Majumdar, A., & Ghaffarzadegan, N. (2023). Epidemic modeling with generative agents. arXiv preprint arXiv:2307.04986. [4] Argyle, L. P., Busby, E. C., Fulda, N., Gubler, J. R., Rytting, C., & Wingate, D. (2023). Out of one, many: Using language models to simulate human samples. Political Analysis, 31(3), 337-351.**

**