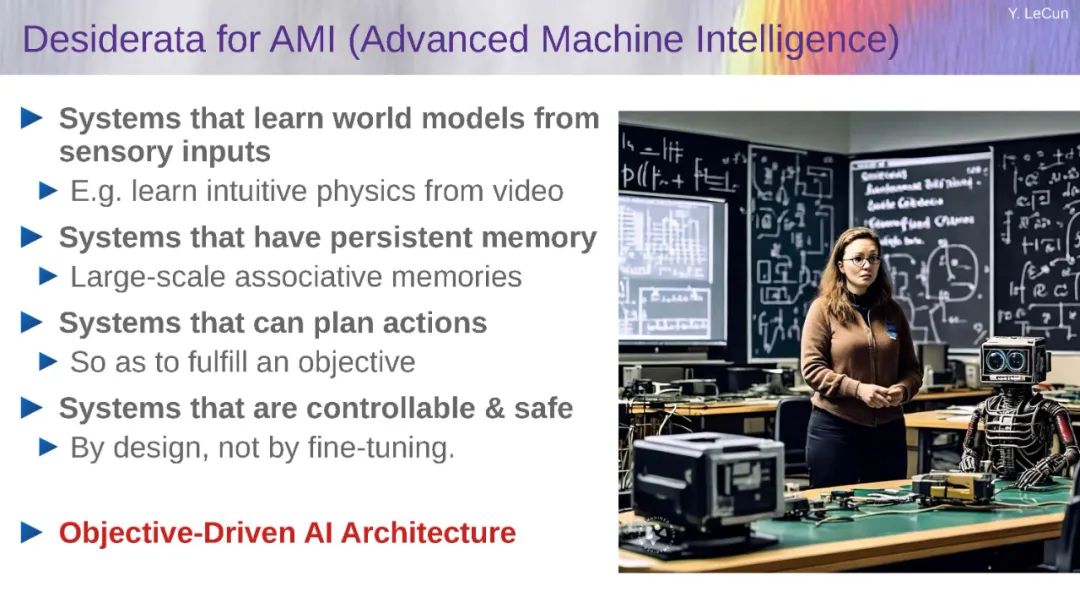

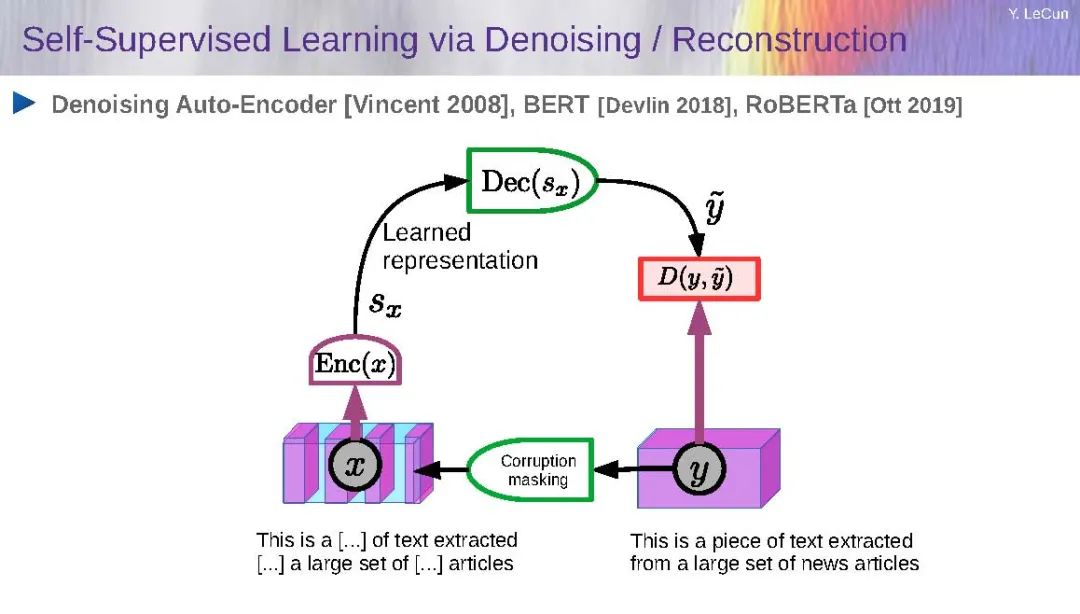

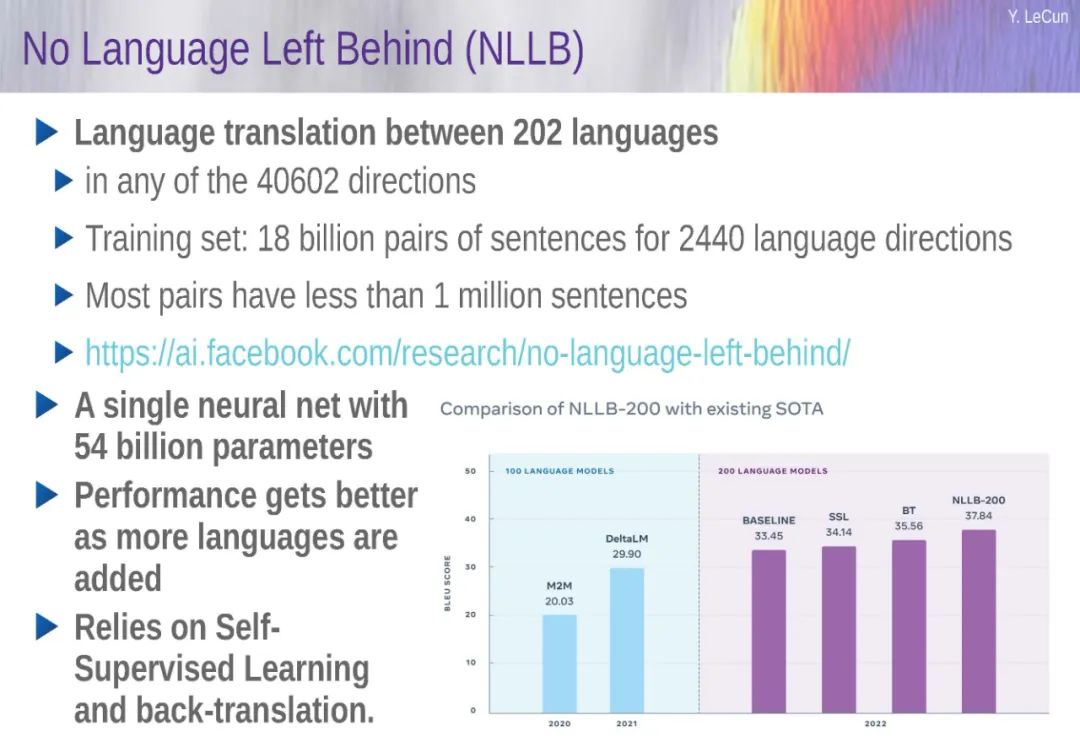

Yann LeCun是Meta的副总裁兼首席人工智能科学家,同时也是纽约大学的银级教授,隶属于Courant数学研究所、数据科学中心、神经科学中心以及电子与计算机工程系。他是Facebook人工智能研究的创始主任,也是纽约大学数据科学中心的创始主任。 他在1983年从巴黎ESIEE获得电气工程师文凭,并于1987年从巴黎索邦大学获得计算机科学博士学位。在多伦多大学进行博士后研究后,他于1988年加入了新泽西州霍姆德尔的AT&T贝尔实验室,后于1996年成为AT&T实验室研究部门的图像处理研究部门主任。2003年,他在短暂的NEC研究所(普林斯顿)工作后加入纽约大学担任教授。2012年,他成为纽约大学数据科学中心的创始主任。2013年底,他被任命为Facebook人工智能研究主任,同时兼任纽约大学的兼职教授。2015-2016年,他在法国高等师范学院担任客座教授。 他目前的研究兴趣包括人工智能、机器学习、计算机感知、机器人技术和计算神经科学。他以对深度学习和神经网络的贡献而闻名,特别是在计算机视觉和语音识别应用中广泛使用的卷积网络模型。他在这些主题上发表了200多篇论文,内容涉及手写识别、图像压缩和专用人工智能硬件。 勒库恩是国际学习表示会议(ICLR)的创始人和总共同主席,并在多个编辑委员会和会议组委会任职。他是加拿大先进研究学院“机器与大脑学习”项目的联合主席。自2008年以来,他一直是IPAM的科学顾问委员会成员,并是ICERM的董事会成员。他为许多公司提供咨询,并共同创立了初创公司Elements Inc.和Museami。他是新泽西发明家名人堂的成员。他是美国国家科学院、国家工程院和法国科学院的成员。他是法国荣誉军团勋章骑士,AAAI和AAAS的研究员,2018年宾夕法尼亚大学Pender奖获得者,以及IPN墨西哥、洛桑联邦理工学院和法国蔚蓝海岸大学的荣誉博士。 他与杰弗里·辛顿和约书亚·本吉奥一起获得了2018年ACM图灵奖,以表彰他们在“概念和工程上的突破,使深度神经网络成为计算的关键组成部分”。 https://www.ece.uw.edu/news-events/lytle-lecture-series/ 目标驱动的人工智能:走向能够学习、推理和计划的机器 摘要 机器如何能像人类和动物一样高效地学习?机器如何学习世界的运作方式并获得常识?机器如何学会推理和规划?当前的人工智能架构,比如自回归大型语言模型(Auto-Regressive Large Language Models),还远远不够。我将提出一种模块化的认知架构,它可能构成回答这些问题的路径。该架构的核心是一个预测性世界模型,该模型允许系统预测其行动的后果,并规划一系列行动来优化一组目标。这些目标包括保障系统可控性和安全性的护栏。世界模型采用了层次化联合嵌入预测架构(Hierarchical Joint Embedding Predictive Architecture,简称H-JEPA),通过自监督学习进行训练。JEPA学习感知的抽象表征,这些表征同时最大限度地提供信息并最大限度地可预测。相关的工作论文可以在此处获得。