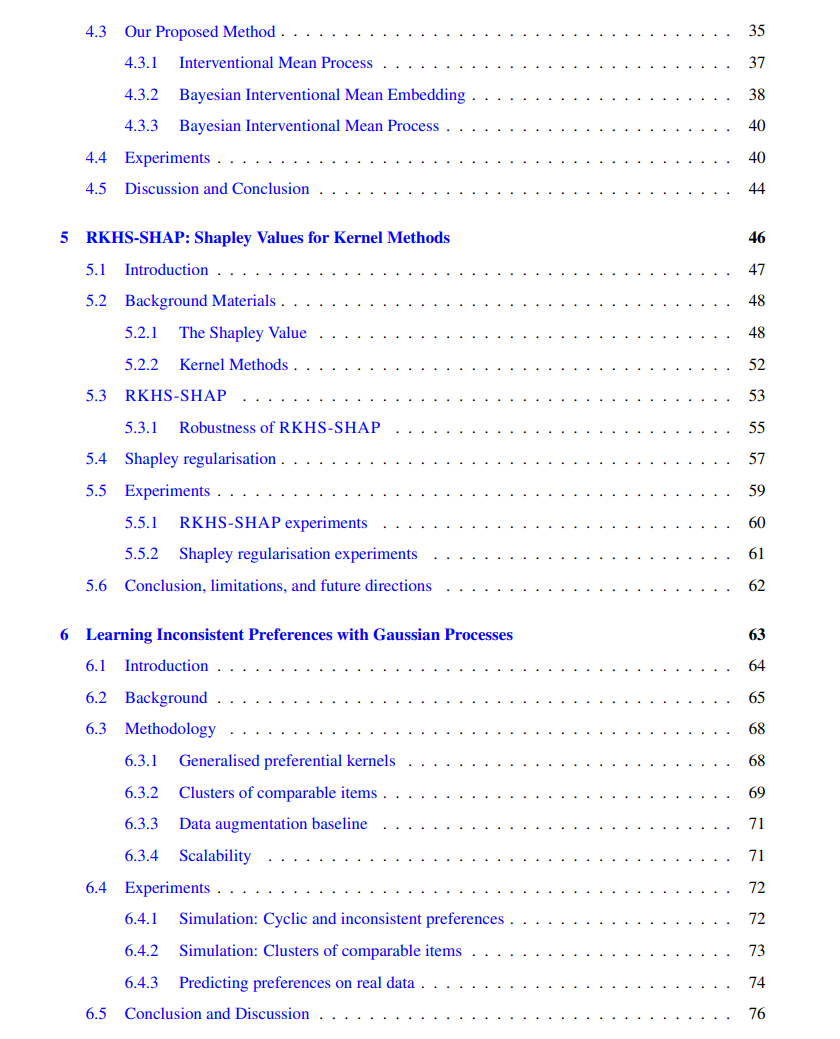

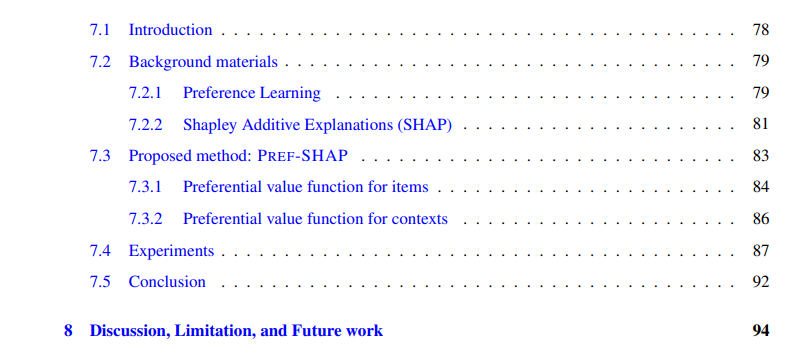

机器学习已成为健康、法律和汽车等多个安全关键行业的不可或缺的组成部分。因此,确保我们的机器学习模型适当运作并赢得用户信任至关重要。这篇论文聚焦于通过推广更有原则的不确定性量化和更有效的可解释性工具来提升机器学习的安全性和透明度。特别是,这项工作广泛运用了核均值嵌入(KME)和高斯过程(GP),因为它们能够在最小的分布假设下表示概率分布,同时分别能很好地捕捉不确定性。我在第二章详细介绍了这两种方法。第三章展示了这些方法联合使用来解决一个统计降尺度问题的有效性,其中提出了一个解耦高斯过程。第四章考虑了一个因果数据融合问题,其中多个因果图被结合用于推理。我引入了BayesIMP,这是一个使用KME和GP构建的算法,能在考虑数据和模型的不确定性的同时得出因果结论。在第五章,我提出了RKHS-SHAP,这是一个利用Shapley值为核方法建模可解释性的模型。具体而言,我建议使用KMEs来估计合作游戏中的价值函数,从而避免了对任何参数密度的估计。我还提出了一个Shapley正则项,用于调节某些特征对模型的贡献量。第六章呈现了一个通用的偏好高斯过程,用于模拟具有非排名结构的偏好,这为第七章奠定了基础,在这一章中,我基于我的研究提出了Pref-SHAP,用于解释偏好模型。 机器学习(ML)已经成为我们日常生活中不可或缺的一部分,因为它能够提高不同领域传统实践的效率、精度和质量。ML模型具有广泛的应用,从诊断疾病[Alaa等人,2017]和制定个性化治疗策略[Bica和van der Schaar,2022],检测欺诈交易[Shirgave等人,2019]和预测股市趋势[Gogas和Papadimitriou,2021],分析法律文件[Robaldo等人,2019]和评估政策结果[Kreif和DiazOrdaz,2019],到筛选简历[Sinha等人,2021]和自动化交通模式[Yurtsever等人,2020]。鉴于这些模型改变生活的潜力,确保它们按预期运行并向用户灌输信任至关重要。这是可信ML领域的主要目标。

正如Schmitz等人[2022]所指出的,确保机器学习(ML)模型的可信度不仅限于准确性,还包括考虑隐私、公平、安全和透明度。保护个人隐私对于防止敏感个人信息的滥用至关重要,已经开发了差分私有ML[Abadi等人,2016]和分散式学习[Li等人,2020]等方法来实现这一目标。相比之下,数据和ML模型中的潜在偏见可能会导致对特定用户群体的歧视[Mehrabi等人,2021],突显了算法设计中公平性的重要性。提高ML的安全性是另一个关键主题,涉及不确定性量化[Hüllermeier和Waegeman,2021]、对抗性攻击[Kurakin等人,2016]、数据中毒[Goldblum等人,2022]、领域适应和概括[Zhang等人,2019]的研究。提高ML的透明度[Roscher等人,2020]类似于打开算法“黑盒子”,以了解模型是如何运行的。这不仅使终端用户能够更好地理解结果是如何生成的,而且还支持从算法训练中学习。

在本文中,我提出了我的贡献,通过倡导更原则性的不确定性量化和更有效的可解释性工具,来提高机器学习的安全性和透明度。在整个论文中,我严重依赖于使用核均值嵌入[Muandet等人,2017]和高斯过程[Rasmussen和Williams,2005b]作为非参数方法来捕获和建模概率分布。这两种方法都依赖于正定核。前者利用它们作为再现核来构建函数空间,并将分布作为其中的元素,而后者利用它们作为协方差函数。第二章正式介绍了这两类方法的细节。此外,在第三章中,我提出了一个项目,展示了这两种方法的相互结合使用,以解决具有挑战性的图像重建问题。

相关内容

牛津大学是一所英国研究型大学,也是罗素大学集团、英国“G5超级精英大学”,欧洲顶尖大学科英布拉集团、欧洲研究型大学联盟的核心成员。牛津大学培养了众多社会名人,包括了27位英国首相、60位诺贝尔奖得主以及数十位世界各国的皇室成员和政治领袖。2016年9月,泰晤士高等教育发布了2016-2017年度世界大学排名,其中牛津大学排名第一。