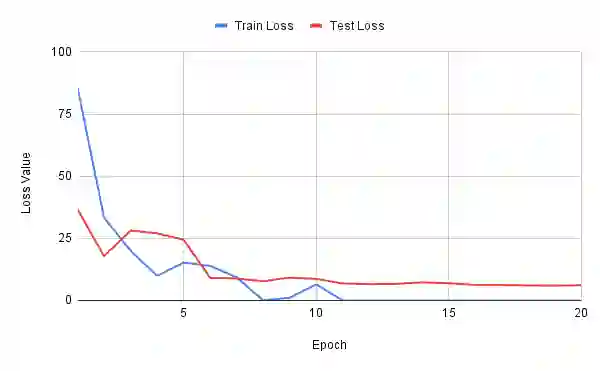

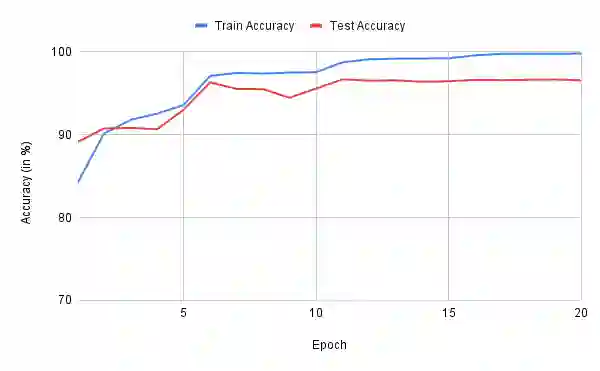

We propose the APTx Neuron, a novel, unified neural computation unit that integrates non-linear activation and linear transformation into a single trainable expression. The APTx Neuron is derived from the APTx activation function, thereby eliminating the need for separate activation layers and making the architecture both optimization-efficient and elegant. The proposed neuron follows the functional form $y = \sum_{i=1}^{n} ((α_i + \tanh(β_i x_i)) \cdot γ_i x_i) + δ$, where all parameters $α_i$, $β_i$, $γ_i$, and $δ$ are trainable. We validate our APTx Neuron-based architecture on the MNIST dataset, achieving up to $96.69\%$ test accuracy within 11 epochs using approximately 332K trainable parameters. The results highlight the superior expressiveness and training efficiency of the APTx Neuron compared to traditional neurons, pointing toward a new paradigm in unified neuron design and the architectures built upon it. Source code is available at https://github.com/mr-ravin/aptx_neuron.

翻译:本文提出APTx神经元,这是一种新颖的统一神经计算单元,将非线性激活与线性变换集成于单一可训练表达式中。APTx神经元源自APTx激活函数,从而消除了对独立激活层的需求,使架构兼具优化高效性与结构优雅性。该神经元遵循函数形式 $y = \sum_{i=1}^{n} ((α_i + \tanh(β_i x_i)) \cdot γ_i x_i) + δ$,其中所有参数 $α_i$、$β_i$、$γ_i$ 和 $δ$ 均为可训练参数。我们在MNIST数据集上验证了基于APTx神经元的架构,使用约332K可训练参数在11个训练周期内实现了高达$96.69\%$的测试准确率。实验结果表明,与传统神经元相比,APTx神经元具有更卓越的表达能力与训练效率,为统一神经元设计及其架构开辟了新范式。源代码发布于 https://github.com/mr-ravin/aptx_neuron。