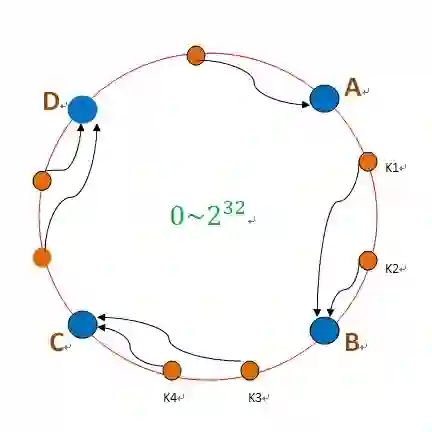

Consistent hashing is fundamental to distributed systems, but ring-based schemes can exhibit high peak-to-average load ratios unless they use many virtual nodes, while multi-probe methods improve balance at the cost of scattered memory accesses. This paper introduces Local Rendezvous Hashing (LRH), which preserves a token ring but restricts Highest Random Weight (HRW) selection to a cache-local window of C distinct neighboring physical nodes. LRH locates a key by one binary search, enumerates exactly C distinct candidates using precomputed next-distinct offsets, and chooses the HRW winner (optionally weighted). Lookup cost is O(log|R| + C). Under fixed-topology liveness changes, fixed-candidate filtering remaps only keys whose original winner is down, yielding zero excess churn. In a benchmark with N=5000, V=256 (|R|=1.28M), K=50M and C=8, LRH reduces Max/Avg load from 1.2785 to 1.0947 and achieves 60.05 Mkeys/s, about 6.8x faster than multi-probe consistent hashing with 8 probes (8.80 Mkeys/s) while approaching its balance (Max/Avg 1.0697). A microbenchmark indicates multi-probe assignment is dominated by repeated ring searches and memory traffic rather than probe-generation arithmetic.

翻译:一致性哈希是分布式系统的基础,但基于环的方案可能表现出较高的峰值与平均负载比,除非使用大量虚拟节点;而多探测方法虽能改善负载均衡,却以分散的内存访问为代价。本文提出局部会合哈希(LRH),该方法保留令牌环结构,但将最高随机权重(HRW)选择限制在C个不同相邻物理节点组成的缓存局部窗口内。LRH通过一次二分查找定位键,使用预计算的“下一个不同节点”偏移量精确枚举C个不同候选节点,并选择HRW胜出者(可选择加权)。查找成本为O(log|R| + C)。在固定拓扑的活性变化下,固定候选过滤机制仅重映射那些原始胜出者已失效的键,从而实现零额外扰动。在N=5000、V=256(|R|=1.28M)、K=50M、C=8的基准测试中,LRH将最大/平均负载从1.2785降至1.0947,并达到60.05 Mkeys/s的吞吐率,比8次探测的多探测一致性哈希(8.80 Mkeys/s)快约6.8倍,同时接近其负载均衡水平(最大/平均负载1.0697)。一项微基准测试表明,多探测分配的主要开销源于重复的环搜索和内存流量,而非探测生成计算。