【大咖来了】有道周枫:苹果Core ML对移动端深度学习的意义

新智元推荐

作者:周枫

【新智元导读】在WWDC2017(全球开发者大会)上,苹果发布了支持移动端深度学习的 CoreML 框架。网易有道 CEO 周枫指出,这个新框架能够解决以往云端数据处理的一系列问题,而且相对安卓的 TensorflowLite 更加成熟,值得人工智能的开发者关注。

【大咖小传】

周枫博士现任网易高级副总裁,网易有道CEO。周枫在清华大学取得计算机科学学士和硕士学位,在加州伯克利大学取得计算机科学博士学位,曾在多个顶级国际学术会议和期刊上发表超过10篇论文。周枫加入网易后,主持有道词典开发、有道搜索平台架构、有道云笔记和密码认证系统“将军令”开发等,将有道词典打造成了份额第一的词典与翻译产品,用户量超过6亿。目前,周枫带领有道的NMT团队攻坚基于人工智能的神经网络翻译(NMT)技术,并开始进军在线教育领域。

——————————————————————————

在上周WWDC苹果发布的一系列软硬件产品中,CoreML看起来是很不起眼的一个。简单来说,它是秋季正式上市的iOS11新增的人工智能编程框架,让开发者可以更方便地为App增加基于人工智能算法的功能。

关注人工智能或深度学习的产品和技术人员应该重视CoreML,CoreML是第一个较完善的手机端人工智能框架,利用它可以做出创新的功能。

目前国内探讨比较多的数据处理办法,仍然是利用人工智能在云端处理大数据。相对云端的处理,手机端的人工智能至少有这样几点好处:

响应更快,避免网络通信延迟;

节省流量,不需要上传数据;

可以实时处理视频,解决了上传和处理视频速度慢的问题;

对开发者更便宜,省去了租用服务器的成本。

近两年以来,移动SoC(系统级芯片)的处理能力,终于可以有效运行实用化的深度学习算法了(iPhone7的GPU计算能力大约是200Gflops),所以这时候推出CoreML,苹果做到了领先一步。相比较来说,Android上同样用于移动机器学习的TensorflowLite成熟度看起来差不少。

和Tensorflow、Caffe等深度学习框架不同,CoreML是完全聚集于在设备端本地进行深度学习推理的框架,而其它框架除了支持本地设备端同时也支持云端,能够推理也支持训练。

集中力量的一个结果是CoreML性能更优。苹果宣传Inception v3速度是Tensorflow的6倍,这是通过MetalAPI对于GPU能力充分利用的结果。

另一个结果是,CoreML看起来更方便使用。苹果很聪明的定义了一个标准的模型格式(.mlmodel),提供了流行的框架模型到该格式的转换工具,比如你可以将你的Caffe模型转换成CoreML的模型格式。这样就可以利用各个模型的训练阶段,而不像TensorflowLite只能使用Tensorflow模型。模型训练好了之后,只要拖放到XCode中就可以使用,苹果甚至把接口的Swift代码都给你生成好了,非常方便。

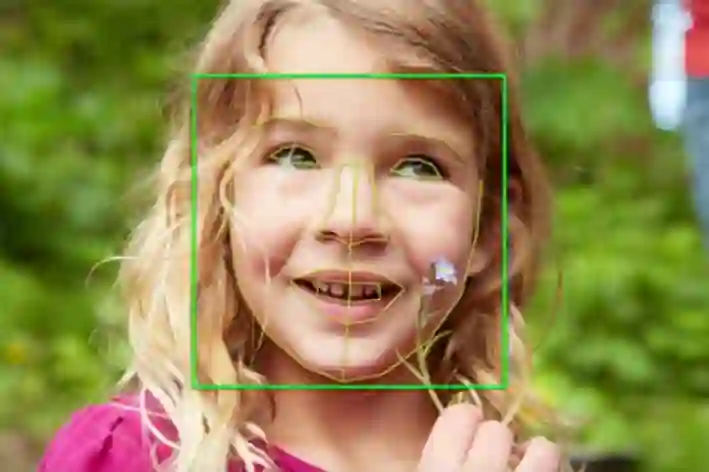

Core ML的目的就是让开发者把机器学习更容易的用到App里。开发者能够用CoreML实现实时物体识别、人脸特征点识别、跟踪运动中的物体、文本分析等,这些处理过程都可以在现有的iPhone和iPad上运行。下面是CoreML能够实现的一部分技术Demo:

实时物体识别(Resnet >10fps)

带五官位置的人脸检测(直接调用Vision Framework)

物体跟踪(Vision Framework)

Core ML填补了iOS移动端机器学习的空白,开发者们可以从这个新框架出发,思考自己的App能够封装哪些人工智能的新技术。而面对苹果的步步紧逼,“为移动而生”的TensorflowLite也该好好优化一下模型适配和处理速度的问题了,毕竟人工智能的未来不可能只在云端。