机器之心&ArXiv Weekly Radiostation

参与:杜伟,楚航,罗若天

本周的重要论文包括 MIT 韩松团队提出的 GAN 通用压缩方法,以及西湖大学登上《Science》封面的新冠病毒研究。

GAN Compression: Efficient Architectures for Interactive Conditional GANs

1st Place Solutions for OpenImage2019 - Object Detection and Instance Segmentation

Stanza: A Python Natural Language Processing Toolkit for Many Human Languages

Natural Language Processing and Text Mining with Graph-Structured Representations

Circle Loss: A Unified Perspective of Pair Similarity Optimization

Structural basis for the recognition of SARS-CoV-2 by full-length human ACE2

Julia Language in Machine Learning: Algorithms, Applications, and Open Issues

ArXiv Weekly Radiostation:NLP、CV、ML更多精选论文(附音频)

论文 1:

GAN Compression: Efficient Architectures for Interactive Conditional GANs

摘要:

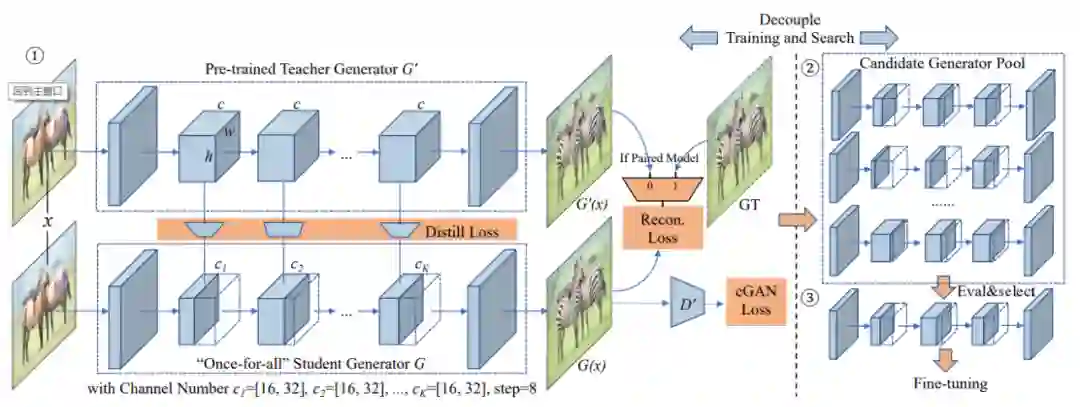

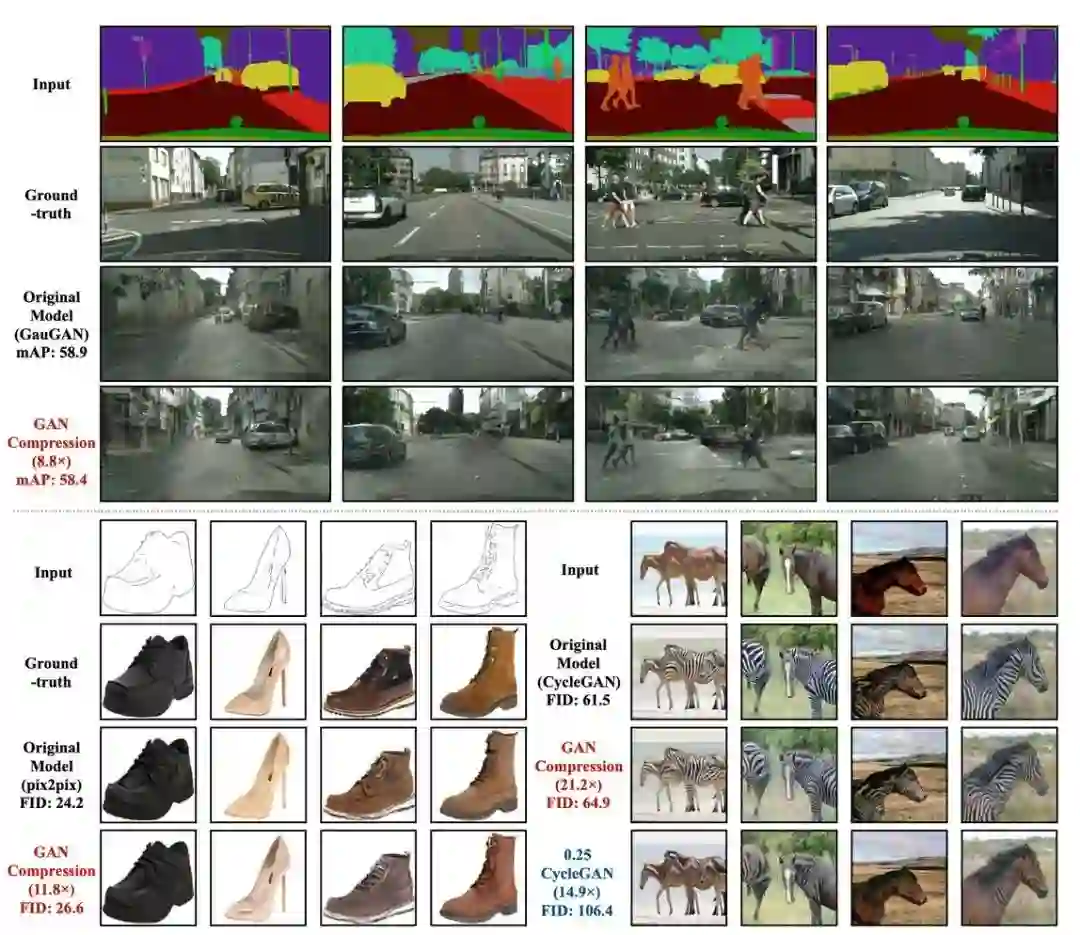

生成模型 GAN 是机器学习领域里最为重要的发展方向之一。但这类算法需要消耗巨量算力,大多数研究者已经很难得出新成果。近年来,这一方向颇有被大型机构垄断的趋势。但近日,

来自麻省理工学院(MIT)、Adobe、上海交通大学的研究者提出了一种用于压缩条件 GAN 的通用方法

。这一新技术在保持视觉保真度的同时,将 pix2pix,CycleGAN 和 GauGAN 等广泛使用的条件 GAN 模型的计算量减少到 1/9~1/21。该方法适用于多种生成器架构、学习目标,配对或非配对设置。

GAN 压缩后的具体性能如何?在研究者们展示的 Demo 中,

使用 CycleGAN 为视频中的马添加斑马条纹所需的算力不到 1/16,帧数提高了三倍,而且效果还有所提升

。值得一提的是,该研究所使用的硬件平台是英伟达的边缘 AI 计算芯片 Jetson Xavier GPU。根据官方公布的数据,Jetson Xavier 的 INT8 算力为 22+10TOPS,骁龙 865 则是 15TOPS。压缩后的 GAN 现在看来已经可以跑在机器人、无人机等小型设备上了,未来塞进手机指日可待。

![]()

![]()

Cityscapes、Edges→Shoes 以及 Horse→Zebra 数据集上效果比较。

![]()

在 NVIDIA Jetson AGX Xavier、NVIDIA Jetson Nano、1080Ti GPU 和 Xeon CPU 上测到的内存和延迟下降。

推荐:

GAN 也可以大幅压缩,MIT 韩松团队的最新研究让众多研究者们为之一振。

论文 2:

1st Place Solutions for OpenImage2019 - Object Detection and Instance Segmentation

摘要:

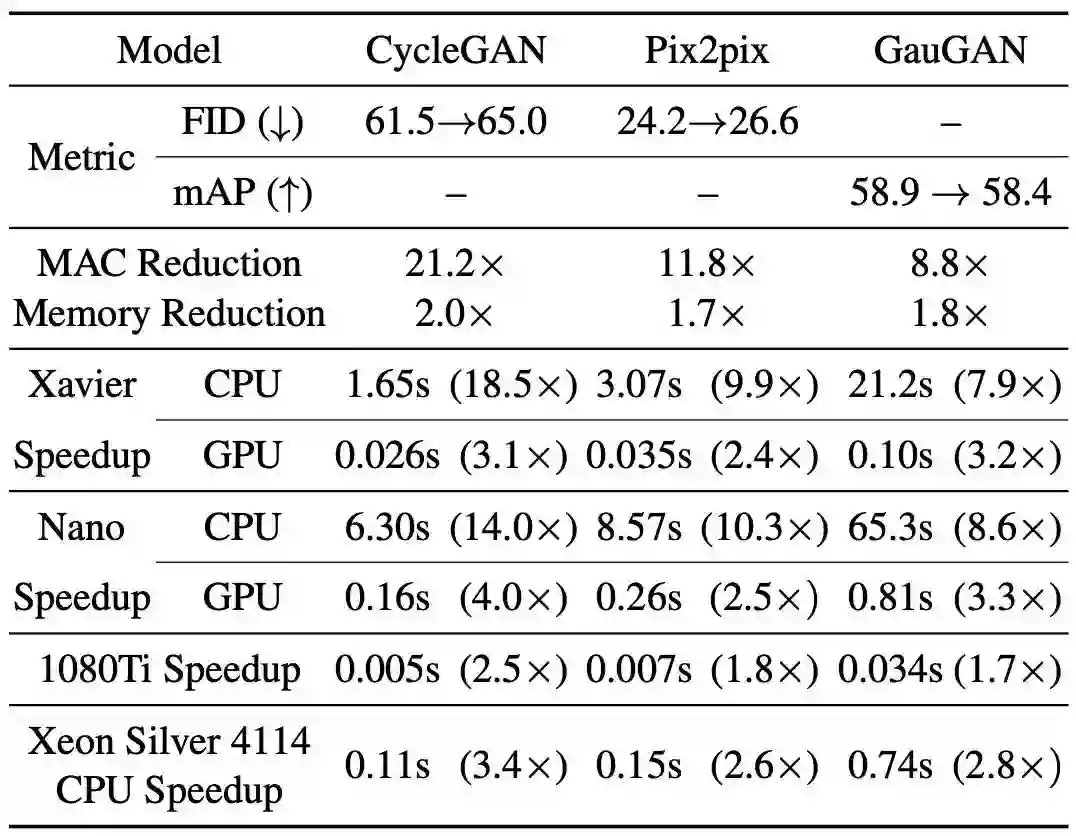

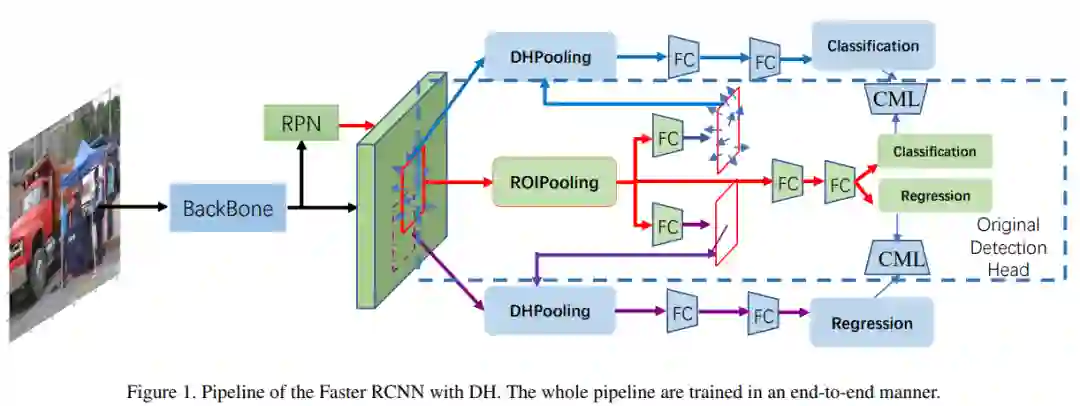

在本文中,

来自港中文、南洋理工以及港大等的研究者提出 Decoupling Head(DH),它通过自学习的最佳特征提取来解耦目标分类和回归,从而带来巨大的性能提升

。此外,他们将 soft-NMS 算法调整为 adj-NMS,以获得稳定的性能提升。最后,通过 voting 确定边界框的位置和置信度,进而提出了一种设计合理的集成策略。

此外,研究者还将介绍几种训练/推理策略以及一些稍作改进的技巧。鉴于这些细节,他们训练和集成了 28 个具有不同 backbone、head 和 3 + 2 专家模型的全局模型,并在 OpenImage 2019 目标检测挑战赛上的公开和私有排行榜上排名第一。

![]()

利用 DH 实现更快速 RCNN 的 pipeline。

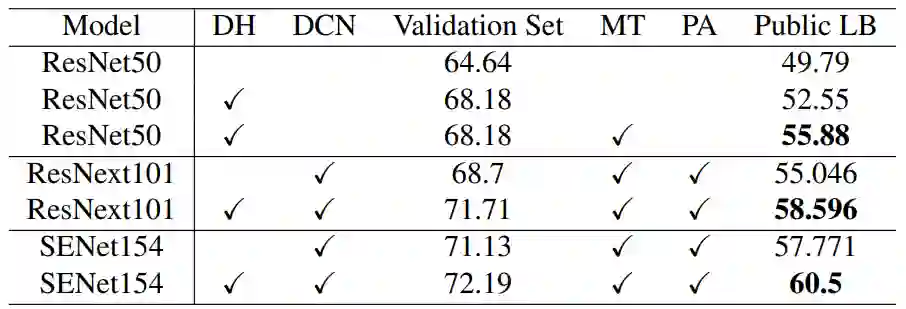

![]()

具有不同 backbone 的 DH 上的控制变量研究。DCN 和 MT 分别表示可变形 convnet 和多尺度测试;PA 表示求取 epoch 参数的均值。

推荐:

给定这类表现良好的实例边界框,研究者进一步设计了一个简单的实例级语义分割 pipeline,并在分割挑战中取得了第一名。

论文 3:

Stanza: A Python Natural Language Processing Toolkit for Many Human Languages

摘要:

在本文中,

来自斯坦福大学的研究者将介绍 Stanza,这是一个支持 66 种人类语言的开源 Python 自然语言处理工具包

。与现有的广泛使用的工具包相比,Stanza 具有用于语言分析的语言不可知的全神经管道,包括标记化、多词标记扩展、词形化、词性和词性和形态特征标记,依赖项解析以及命名实体识别。

他们已经对 Stanza 进行了总共 112 个数据集的训练,其中包括 Universal Dependencies 树库和其他多语种语料库,

结果显示相同的神经体系结构可以很好地泛化并在所有测试的语言上实现优越性能

。此外,Stanza 包括一个与广泛使用 Java Stanford CoreNLP 软件相连接的本地 Python 接口,该接口进一步扩展了其功能,以涵盖共引用解析和关系提取等其他任务。

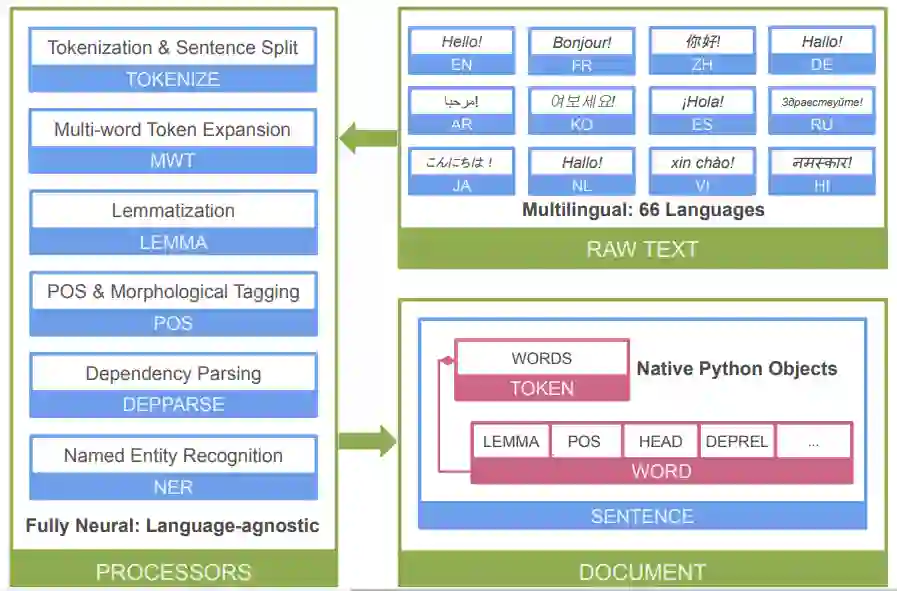

![]()

本文 Stanza 神经 NLP pipeline 整体架构图。

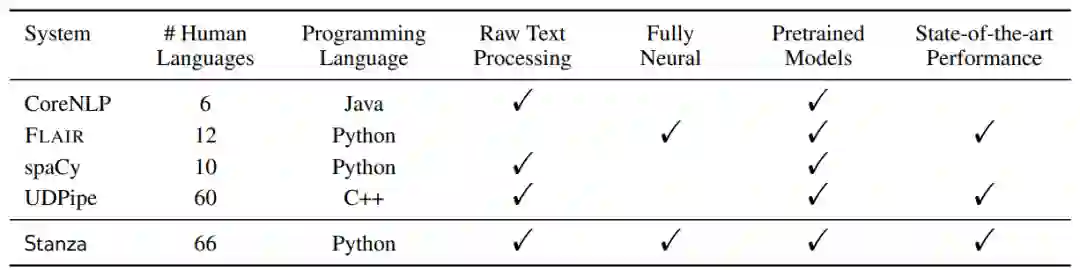

![]()

本文 Stanza 与其他流行 NLP 工具包的特性对比。

推荐:

一经开源,便引起了社区的热议。李飞飞就在推特上点赞了这个项目。

论文 4:

Natural Language Processing and Text Mining with Graph-Structured Representations

摘要:

自然语言的形式及其语意具有层次性(hierarchical),组合性(compositional)和灵活性(flexible)。已有的研究并未充分利用各类文本中存在的语义结构。图(graph)是一种通用且强大的表示形式,可以表达各种不同对象以及它们之间的联系,无论是在自然语言处理,还是在社交网络,现实世界等各种场景都无处不在。本论文在深度学习强大的表示学习能力的基础上,设计并结合了不同的文本的图结构化表示,并利用图结构计算模型,例如图神经网络(Graph Neural Networks), 去解决不同的自然语言处理和文本挖掘问题。

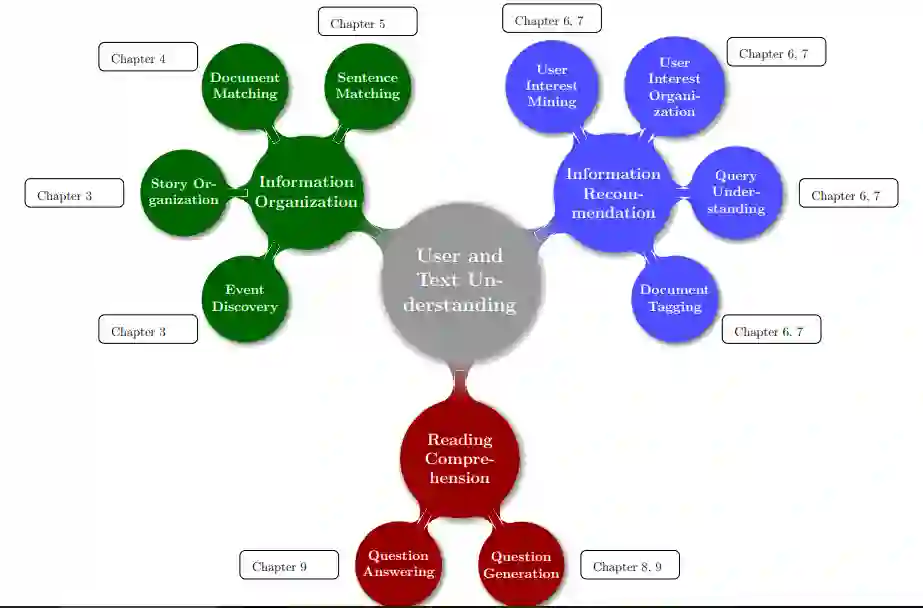

论文包含三大部分:

第一部分介绍了文本的聚类和匹配,提出各类匹配问题的结构化算法,并进一步提出 Story Forest 系统用于新闻事件的聚类组织和结构化表示。该系统落地到腾讯 QQ 浏览器热点事件挖掘。第二部分关注文本挖掘,提出了 Attention Ontology 兴趣图谱,挖掘和描述用户不同粒度的兴趣点,建立不同兴趣点之间的联系,并可用于刻画文章主题。这部分工作显著提高了 QQ 浏览器,手机 QQ,微信等应用中的信息流推荐系统的效果。第三部分关注文本生成,提出了 ACS-QG 系统,自动从无标注文本中生成高质量的问答对,可用于问答系统的训练,有助于大大减少数据集创建成本,以及提高机器阅读理解的能力。

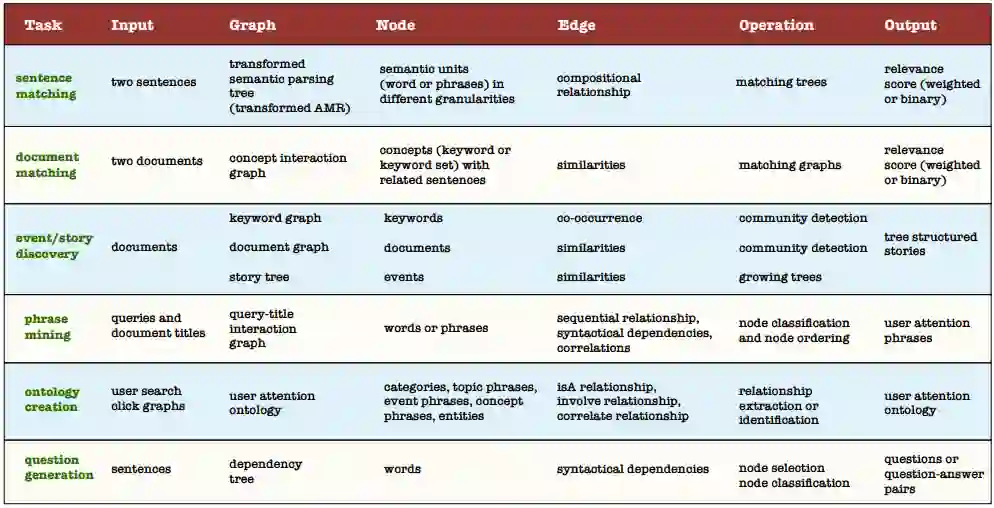

![]()

![]()

推荐:

本文是阿尔伯塔大学 Bang Liu 的博士毕业论文,此君公开自己的 thesis 可谓自信,堪称大佬!

论文 5:

Circle Loss: A Unified Perspective of Pair Similarity Optimization

摘要:

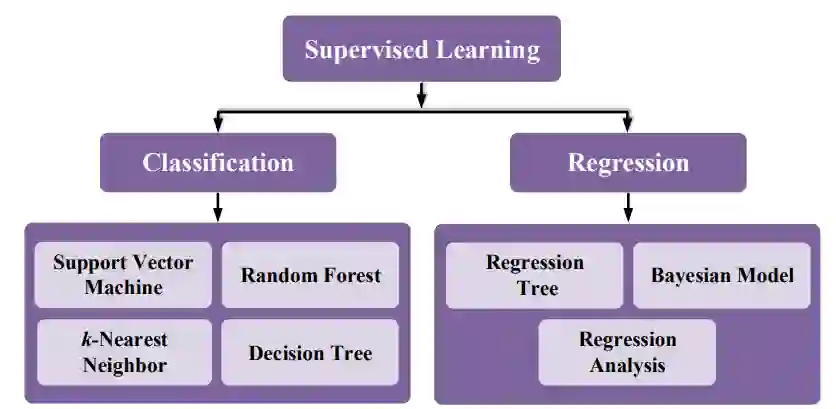

深度特征学习有两种基本范式,分别是使用类标签和使用正负样本对标签进行学习。使用类标签时,一般需要用分类损失函数(比如 softmax + cross entropy)优化样本和权重向量之间的相似度;使用样本对标签时,通常用度量损失函数(比如 triplet 损失)来优化样本之间的相似度。这两种学习方法之间并无本质区别,其目标都是最大化类内相似度(s_p)和最小化类间相似度(s_n)。

在这篇论文中,

来自旷视研究院、北航、澳大利亚国立大学和清华大学的研究者提出用于深度特征学习的 Circle Loss,从相似性对优化角度正式统一了两种基本学习范式(分类学习和样本对学习)下的损失函

数。通过进一步泛化,Circle Loss 获得了更灵活的优化途径及更明确的收敛目标,从而提高所学特征的鉴别能力;它使用同一个公式,在两种基本学习范式,三项特征学习任务(人脸识别,行人再识别,细粒度图像检索),十个数据集上取得了极具竞争力的表现。

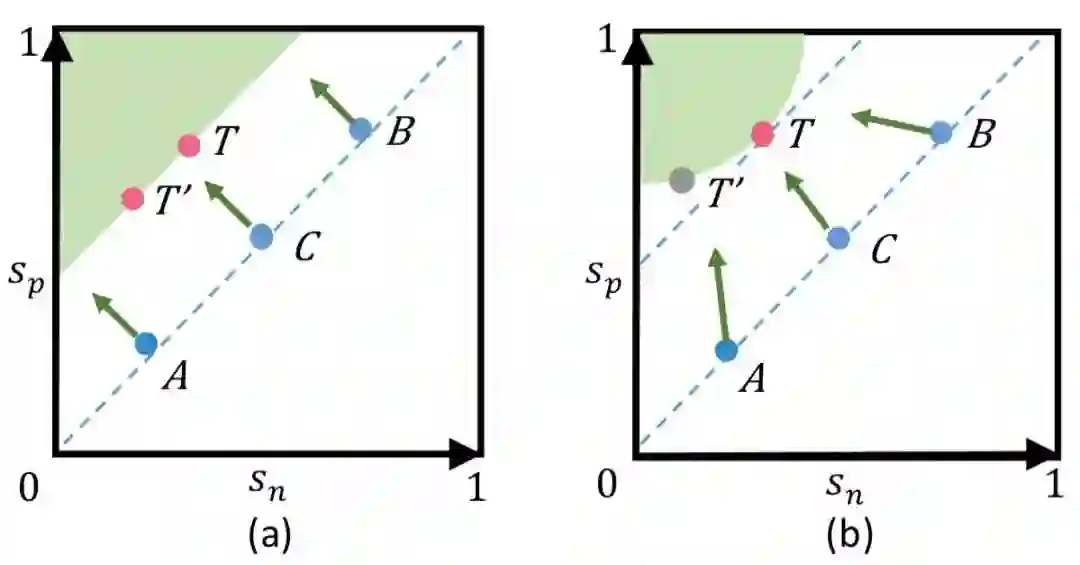

![]()

降低 (s_n - s_p) 的常用优化方法与新提出的降低 (α_ns_n − α_ps_p) 的优化方法之间的对比。

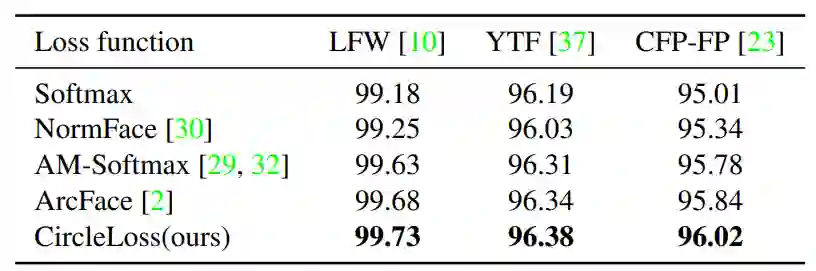

![]()

使用 ResNet34 主干网络在 LFW、YTF 和 CFP-FP 上的人脸识别准确度。

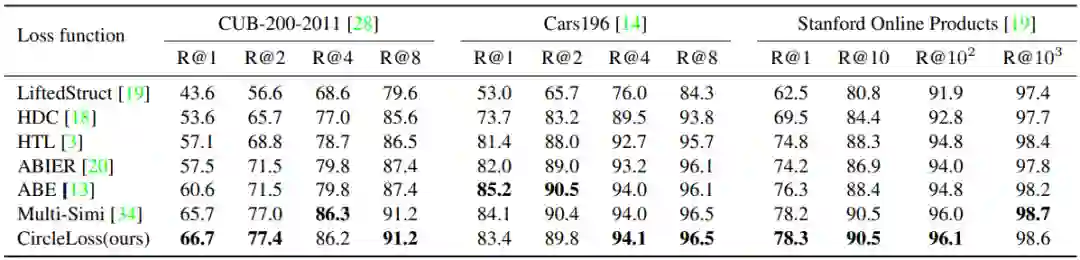

![]()

在 CUB-200-2011、Cars196 和 Stanford Online Products 上与当前最佳结果的比较,这里报告的是 R@K(%)。

推荐:

实验表明,在人脸识别、行人再识别、细粒度的图像检索等多种深度特征学习任务上,Circle Loss 都取得了极具竞争力的性能。

该论文入选 CVPR 2020 Oral Presentation

。

论文 6:

Structural basis for the recognition of SARS-CoV-2 by full-length human ACE2

摘要:

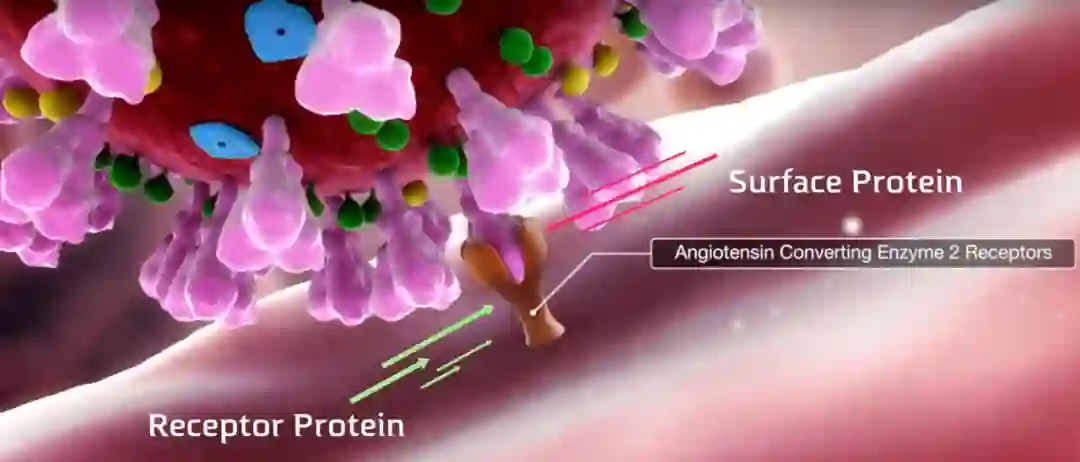

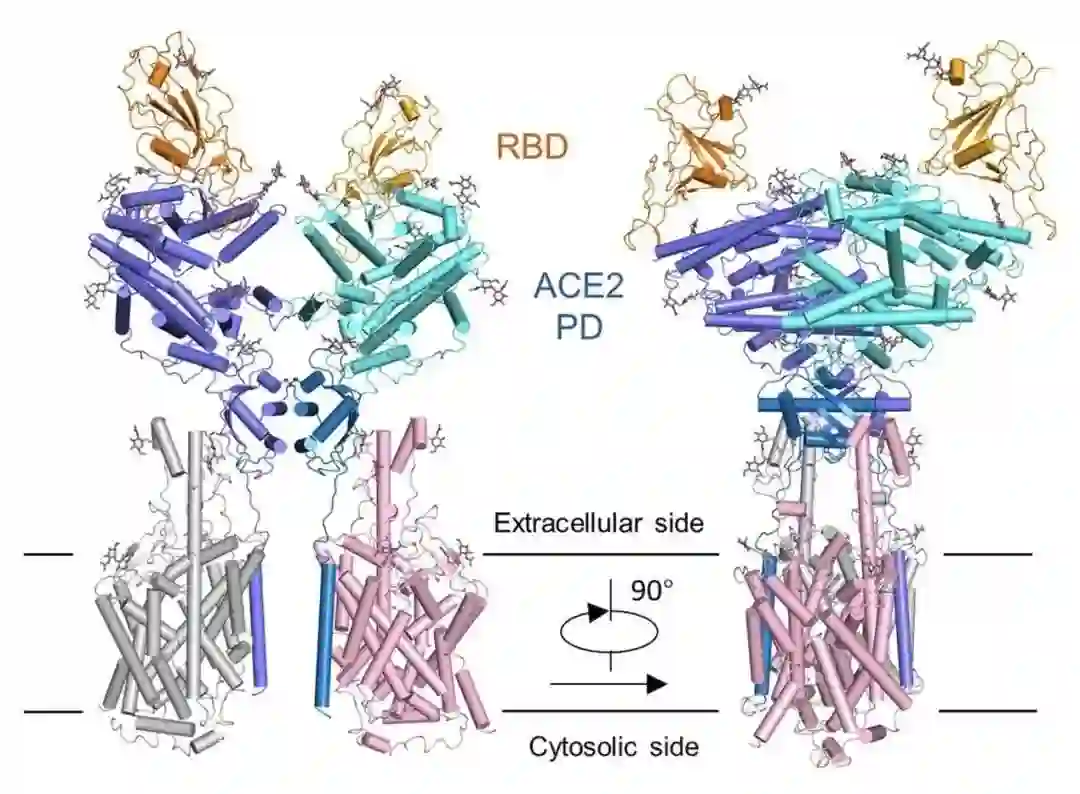

西湖大学周强实验室在论文《Structural basis for the recognition of the SARS-CoV-2 by full-length human ACE2》中,首次公开了新型冠状病毒表面 S 蛋白受体结合结构域与细胞表面受体 ACE2 全长蛋白复合物的三维结构,展示了新冠病毒侵染人体细胞的详细过程。

这项成果登上了最新一期《Science》杂志的封面

。

从结构上来说,病毒由一个核酸长链(DNA 或 RNA)和蛋白质外壳构成。在感染宿主细胞的过程中,病毒表面的蛋白会与人体表面的受体结合,就像一只手抓住了门把手。而在新冠病毒中,「这只手」就是病毒表面的 S 蛋白,它的目标就是抓住「门把手」ACE2 受体。

![]()

![]()

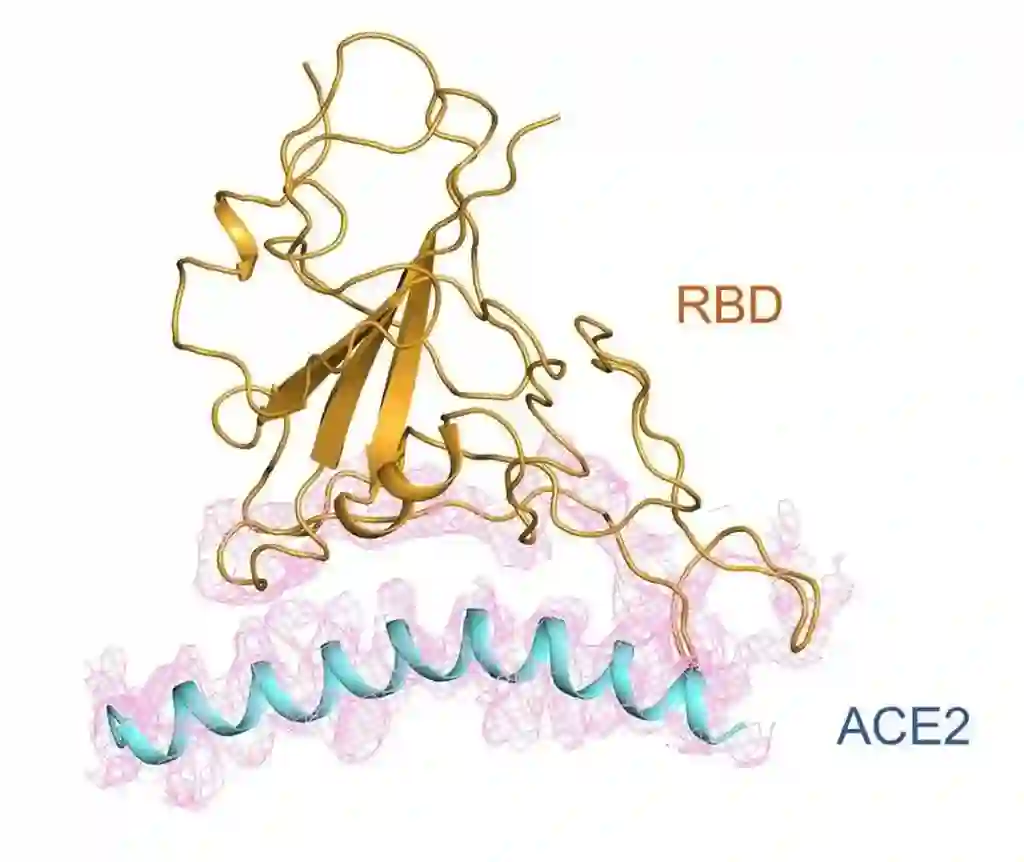

在周强团队的不懈努力下,我们得以洞悉新冠病毒 S 蛋白与 ACE2 的高分辨率三维空间结构。上图为其受体结合区域的复合物结构图。

![]()

RBD(receptor binding domain)和 ACE2 的相互作用示意图。

推荐:

随着新冠病毒感染人数在各个国家和地区的激增,西湖大学的这项研究或许可以为全球对抗疫情做出贡献。

论文 7:

Julia Language in Machine Learning: Algorithms, Applications, and Open Issues

摘要:

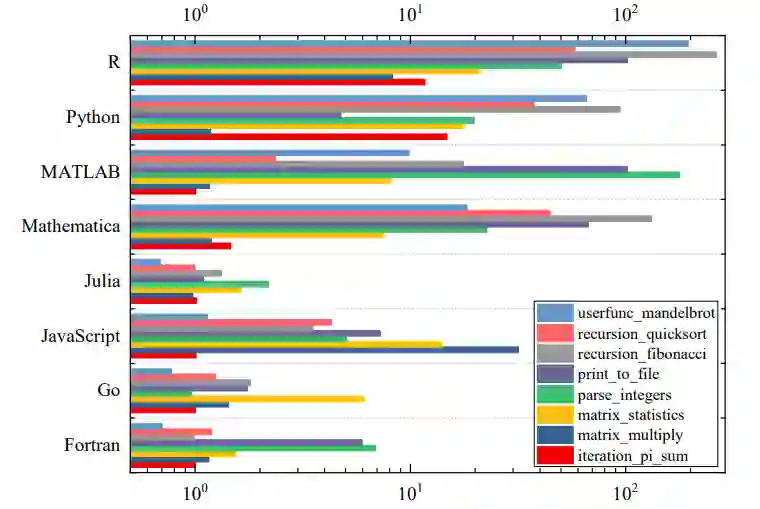

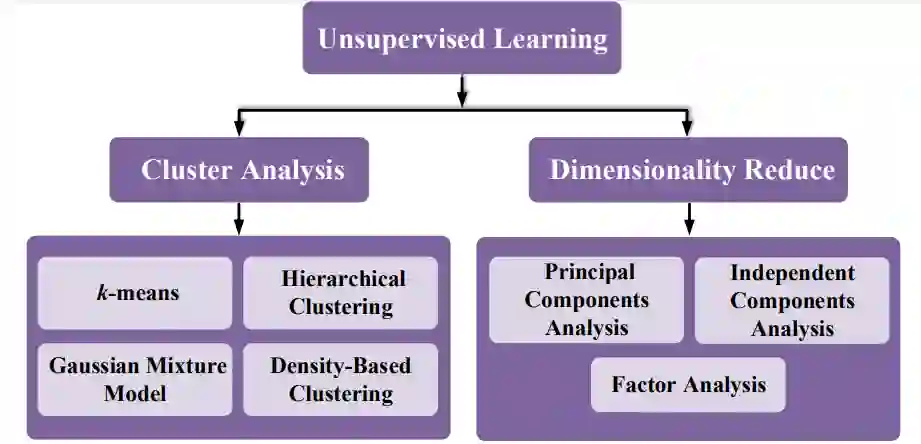

机器学习正在推动科学和工程学许多领域的发展。一种简单而有效的编程语言可以加速机器学习在各个领域的应用。当前,最常用于开发机器学习算法的编程语言包括 Python、MATLAB 和 C / C ++。但是,这些语言都无法很好地兼顾效率和简单性。

Julia 语言是一种快速且易于使用的开源编程语言,最初是为高性能计算而设计的,可以很好地平衡高效性和简单性

。本文总结了 Julia 语言在机器学习中的应用方面的相关研究工作和发展。首先调查了以 Julia 语言开发的流行机器学习算法;然后研究了使用 Julia 语言实现的机器学习算法的应用;最后讨论了在机器学习中使用 Julia 语言所产生的开放性问题和潜在的未来方向。

![]()

Julia 与其他编程语言的 benchmark 对比。

![]()

![]()

推荐:

这篇 51 页的综述论文详细介绍了机器学习中 Julia 语言的算法、应用和存在的问题,为想要了解 Julia 语言的读者提供一份实用指南。

ArXiv Weekly Radiostation

机器之心联合由楚航、罗若天发起的ArXiv Weekly Radiostation,在 7 Papers 的基础上,精选本周更多重要论文,包括NLP、CV、ML领域各10篇精选,并提供音频形式的论文摘要简介,详情如下:

1. ELECTRA: Pre-training Text Encoders as Discriminators Rather Than Generators. (from Kevin Clark, Minh-Thang Luong, Quoc V. Le, Christopher D. Manning)

2. PathVQA: 30000+ Questions for Medical Visual Question Answering. (from Xuehai He, Yichen Zhang, Luntian Mou, Eric Xing, Pengtao Xie)

3. A Framework for Generating Explanations from Temporal Personal Health Data. (from Jonathan J. Harris, Ching-Hua Chen, Mohammed J. Zaki)

4. TLDR: Token Loss Dynamic Reweighting for Reducing Repetitive Utterance Generation. (from Shaojie Jiang, Thomas Wolf, Christof Monz, Maarten de Rijke)

5. E2EET: From Pipeline to End-to-end Entity Typing via Transformer-Based Embeddings. (from Michael Stewart, Wei Liu)

6. BaitWatcher: A lightweight web interface for the detection of incongruent news headlines. (from Kunwoo Park, Taegyun Kim, Seunghyun Yoon, Meeyoung Cha, Kyomin Jung)

7. Rat big, cat eaten! Ideas for a useful deep-agent protolanguage. (from Marco Baroni)

8. Matching Text with Deep Mutual Information Estimation. (from Xixi Zhou, Chengxi Li, Jiajun Bu, Chengwei Yao, Keyue Shi, Zhi Yu, Zhou Yu, (2) University of Californi, Davis)

9. Generating Major Types of Chinese Classical Poetry in a Uniformed Framework. (from Jinyi Hu, Maosong Sun)

10. Word2Vec: Optimal Hyper-Parameters and Their Impact on NLP Downstream Tasks. (from Tosin P. Adewumi, Foteini Liwicki, Marcus Liwicki)

1. Compact Deep Aggregation for Set Retrieval. (from Yujie Zhong, Relja Arandjelović, Andrew Zisserman)

2. Detection in Crowded Scenes: One Proposal, Multiple Predictions. (from Xuangeng Chu, Anlin Zheng, Xiangyu Zhang, Jian Sun)

3. Learning Dynamic Routing for Semantic Segmentation. (from Yanwei Li, Lin Song, Yukang Chen, Zeming Li, Xiangyu Zhang, Xingang Wang, Jian Sun)

4. Selecting Relevant Features from a Universal Representation for Few-shot Classification. (from Nikita Dvornik, Cordelia Schmid, Julien Mairal)

5. Are Labels Necessary for Neural Architecture Search?. (from Chenxi Liu, Piotr Dollár, Kaiming He, Ross Girshick, Alan Yuille, Saining Xie)

6. Learning 3D Part Assembly from a Single Image. (from Yichen Li, Kaichun Mo, Lin Shao, Minhyuk Sung, Leonidas Guibas)

7. DeepStrip: High Resolution Boundary Refinement. (from Peng Zhou, Brian Price, Scott Cohen, Gregg Wilensky, Larry S. Davis)

8. Rethinking Class-Balanced Methods for Long-Tailed Visual Recognition from a Domain Adaptation Perspective. (from Muhammad Abdullah Jamal, Matthew Brown, Ming-Hsuan Yang, Liqiang Wang, Boqing Gong)

9. Distillating Knowledge from Graph Convolutional Networks. (from Yiding Yang, Jiayan Qiu, Mingli Song, Dacheng Tao, Xinchao Wang)

10. Cylindrical Convolutional Networks for Joint Object Detection and Viewpoint Estimation. (from Sunghun Joung, Seungryong Kim, Hanjae Kim, Minsu Kim, Ig-Jae Kim, Junghyun Cho, Kwanghoon Sohn)

1. Inverse Problems, Deep Learning, and Symmetry Breaking. (from Kshitij Tayal, Chieh-Hsin Lai, Vipin Kumar, Ju Sun)

2. Adversarial Continual Learning. (from Sayna Ebrahimi, Franziska Meier, Roberto Calandra, Trevor Darrell, Marcus Rohrbach)

3. Automatic Identification of Types of Alterations in Historical Manuscripts. (from David Lassner, Anne Baillot, Sergej Dogadov, Klaus-Robert Müller, Shinichi Nakajima)

4. ARDA: Automatic Relational Data Augmentation for Machine Learning. (from Nadiia Chepurko, Ryan Marcus, Emanuel Zgraggen, Raul Castro Fernandez, Tim Kraska, David Karger)

5. iTAML: An Incremental Task-Agnostic Meta-learning Approach. (from Jathushan Rajasegaran, Salman Khan, Munawar Hayat, Fahad Shahbaz Khan, Mubarak Shah)

6. FastDTW is approximate and Generally Slower than the Algorithm it Approximates. (from Renjie Wu, Eamonn J. Keogh)

7. Meta Pseudo Labels. (from Hieu Pham, Qizhe Xie, Zihang Dai, Quoc V. Le)

8. Data Parallelism in Training Sparse Neural Networks. (from Namhoon Lee, Philip H. S. Torr, Martin Jaggi)

9. Understanding the robustness of deep neural network classifiers for breast cancer screening. (from Witold Oleszkiewicz, Taro Makino, Stanisław Jastrzębski, Tomasz Trzciński, Linda Moy, Kyunghyun Cho, Laura Heacock, Krzysztof J. Geras)

10. Preferential Batch Bayesian Optimization. (from Eero Siivola, Akash Kumar Dhaka, Michael Riis Andersen, Javier Gonzalez, Pablo Garcia Moreno, Aki Vehtari)

![]()