Yann LeCun在IJCAI-2018开幕式上的演讲:我们需要一个世界模型

作者:哈工大SCIR 李忠阳 丁效 刘挺

摘要:国际人工智能领域顶级会议IJCAI 2018主会于2018年7月16日在瑞典首都斯德哥尔摩召开。Facebook首席人工智能科学家、纽约大学教授 Yann LeCun在开幕式上发表了题目为“Learning World Models: the Next Step towards AI”的演讲。LeCun表示人工智能革命的未来不会是有监督学习,也不会是单纯的强化学习,而是需要学习一个具备常识推理与预测能力的世界模型。LeCun认为自监督学习是实现这一目标的一个潜在研究方向。

关键词:人工智能 机器学习

国际人工智能领域顶级会议IJCAI-2018主会于2018年7月16日上午在瑞典首都斯德哥尔摩召开。Facebook首席人工智能科学家、纽约大学教授 Yann LeCun在开幕式上发表了题目为“Learning World Models: the Next Step towards AI”的演讲。LeCun表示人工智能革命的未来不会是有监督学习,也不会是单纯的强化学习,而是需要学习一个具备常识推理与预测能力的世界模型。LeCun认为自监督学习是实现这一目标的一个潜在研究方向。

现阶段,深度学习的浪潮汹涌澎湃,强化学习的势头不可阻挡,人工智能的发展迎来了前所未有的高潮。在高潮中,我们尤其需要正视存在的问题。

LeCun在报告中介绍说,当前几乎所有实用的机器学习系统都是基于有监督学习建立的。有监督学习通过向机器展示大量有标签的样本,告诉机器正确的答案,并通过反向传播学习模型参数,模型就能够完成图像分类之类的任务。过去几年,有监督学习获得了极大的成功。尤其伴随着深度学习的兴起,卷积神经网络等深度模型被广泛应用于各项任务中,例如医疗诊断、自动驾驶、机器翻译和信息检索等。然而,LeCun认为目前的深度学习缺乏推理能力,未来的一个重要发展趋势就是深度学习和推理的结合。

LeCun谈到目前有监督学习和强化学习面临的问题。有监督学习需要过多的有标签训练样本,而这些标签通常都是人类提供的,需要大量的人工参与。这与婴儿的学习方式大相径庭:婴儿通过大量的观察和少量的与环境交互就能够学习。而强化学习需要大量的尝试以获得足够的反馈。尽管强化学习在游戏中表现良好,却难以被应用到现实世界中,因为现实世界的环境远不像游戏那样可大量快速地重复。比如自动驾驶中,一次失败的尝试可能会导致驾驶员死亡,而且现实世界的环境也无法像游戏那样人为加速。

LeCun总结了这两类学习系统的缺点:缺少独立于任务的背景知识;缺少常识;缺少预测行为后果的能力;缺少长期规划和推理的能力。简言之就是,这两类学习系统没有世界模型,没有关于世界如何运作的通用背景知识。这也是当前深度学习可解释性差、缺乏推理能力的原因。

LeCun认可现有的有监督学习和强化学习技术可以使人类在自动驾驶、医疗诊断、机器翻译、客服机器人、信息检索等领域中取得不错的进展,但他认为仅仅依靠现有技术,无法实现常识推理、智能个人助理、智能聊天机器人、家庭机器人以及通用人工智能。在这样的背景下,LeCun提出:人工智能革命的未来不会是有监督学习,也不会是单纯的强化学习,而是需要学习一个具备常识推理与预测能力的世界模型。从直观上理解,世界模型就是一个具备关于世界如何运作的通用背景知识、具备预测行为后果的能力、具有长期规划与推理能力的模型。

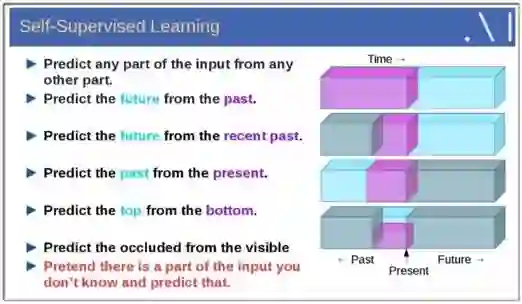

图1. 自监督学习方法

那么,如何学习世界模型呢?LeCun认为自监督学习是有望突破有监督学习与强化学习现状、学习世界模型的一个潜在研究方向。如图1所示,自监督学习将输入和输出当成一个完整的整体,它通过挖掘输入数据本身提供的弱标注信息,基于输入数据的某些部分预测其它部分。在达到预测目标的过程中,模型可以学习到数据本身的语义特征表示,这些特征表示可以进一步被用于其他任务当中。当前自监督学习的发展主要体现在视频、图像处理领域。例如,在空间层面上包括图像补全、图像语义分割、灰度图像着色等,在时间层面上包括视频帧预测、自动驾驶等。

在学术界,自监督学习近期成为了一个新的研究热点,但它并不是一个全新的概念。Geoffrey Hinton说他的团队早在上世纪70年代就已经开始研究自监督学习。早在2013年,笔者所在的自然语言处理领域就出现了经典的Word2vec词向量表示学习方法。它假设处于相似上下文的词拥有相似的语义,利用自然语言本身的序列信息,通过当前位置的词预测周围的词来学习每个词的特征向量表示。Word2vec词向量学习方法就是一种自监督学习方法。

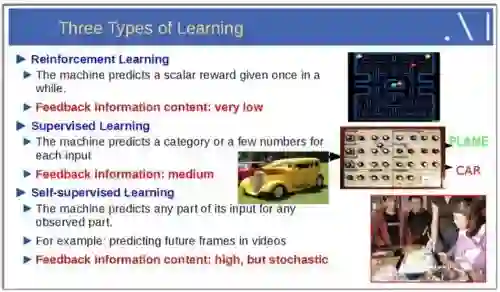

图2. 三种学习范式对比

从强化学习到有监督学习,再到自监督学习,模型接收的反馈信息逐渐增多,模型表征复杂度、适用任务类型逐渐增加,同时任务中涉及的人类手工劳动比重也显著减少,自动化程度大大增加(见图2)。因此,自监督学习可以克服有监督学习中需要大量人工标注数据的问题,也可以解决强化学习中反馈信号稀疏、需要太多次尝试的问题。

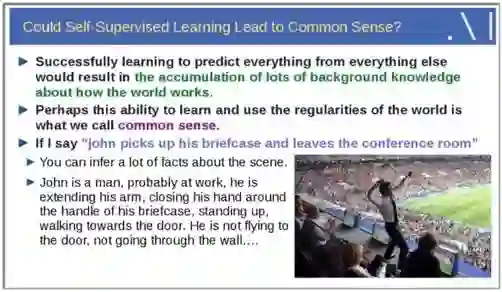

图3

那么,自监督学习能够使机器获得常识吗?如图3所示,LeCun认为机器在基于某些部分预测任何其他部分的过程中,将会积累大量关于世界如何运作的背景知识。这种学习并运用世界上普遍规律的能力就是常识推理。这里LeCun 举了一个例子:如果接收到一个自然语言句子“约翰拿起他的公文包,离开了会议室”,具备世界模型的机器应该能够预测出当前场景下的各种背景知识:约翰是一个男人,他可能在工作,他伸展着胳膊、手握着公文包的提手,站立走向会议室的门,他不是飞向门的,他也没有从墙上穿过去。

LeCun进一步认为预测能力就是智能的本质。智能机器人只有具备了预测行为后果的能力,它才能提前作出合理的规划;机器具备了规划的能力,那么它就能模拟世界。建立世界模型就是为了使机器具备常识推理与预测能力,而自监督学习是现阶段机器学习技术中有望实现这一目标的研究方向。

在报告的最后,LeCun总结了科学和技术之间相互驱动、相互促进的历史渊源,比如望远镜和光学、蒸汽机和热力学、计算器和计算机科学以及通讯技术和信息论等。LeCun提出了一系列的开放问题结束了他的演讲:

什么是智能科学的“热力学”?

人工智能和自然智能背后是否存在本质的规律?

学习的背后是否存在简单的法则?

大脑是否为进化产生的大量Hack的集合?

作者介绍

李忠阳

哈尔滨工业大学社会计算与信息检索研究中心在读博士生,师从刘挺教授

主要研究方向为事理图谱的构建与应用、时序与因果关系抽取、事件预测、网络表示学习等

zyli@ir.hit.edu.cn

丁效

CCF专业会员

哈尔滨工业大学助理研究员

主要研究方向为自然语言处理、社会计算以及智能金融

xding@ir.hit.edu.cn

刘挺

哈尔滨工业大学教授、哈工大人工智能研究院副院长、社会计算与信息检索研究中心主任。曾任顶级国际会议ACL、EMNLP领域主席

CCF理事、CCCF前译文栏目主编

主要研究方向为自然语言处理和社会计算

tliu72@foxmail.com

本期责任编辑:张伟男

本期编辑:刘元兴

“哈工大SCIR”公众号

主编:车万翔

副主编: 张伟男,丁效

责任编辑: 张伟男,丁效,赵森栋,刘一佳

编辑: 李家琦,赵得志,赵怀鹏,吴洋,刘元兴,蔡碧波,孙卓,赖勇魁

长按下图并点击 “识别图中二维码”,即可关注哈尔滨工业大学社会计算与信息检索研究中心微信公共号:”哈工大SCIR” 。