AAAI2022最新「预训练语言表示」报告,300页PPT阐述预训练文本挖掘进展

【导读】国际人工智能会议AAAI 2022论文将在全程线上举办,时间在 2 月 22 日-3 月 1 日,本届大会也将是第 36 届 AAAI 大会。大会涵盖了众多最近研究Tutorial报告,来自Yu Meng,韩家炜等等学者共同做了关于预训练语言表示的进展报告,非常值得关注!

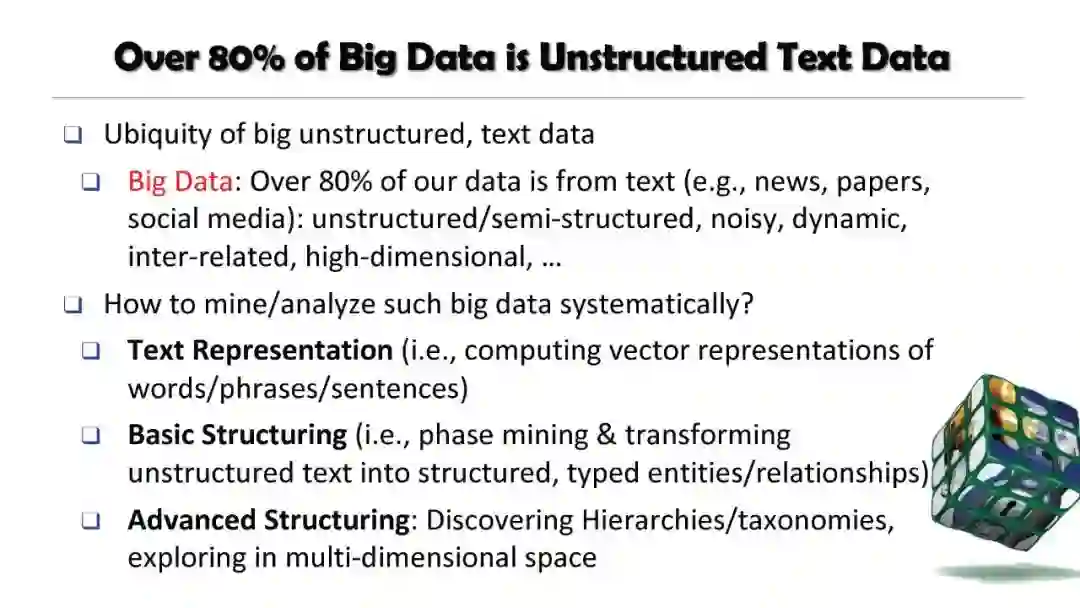

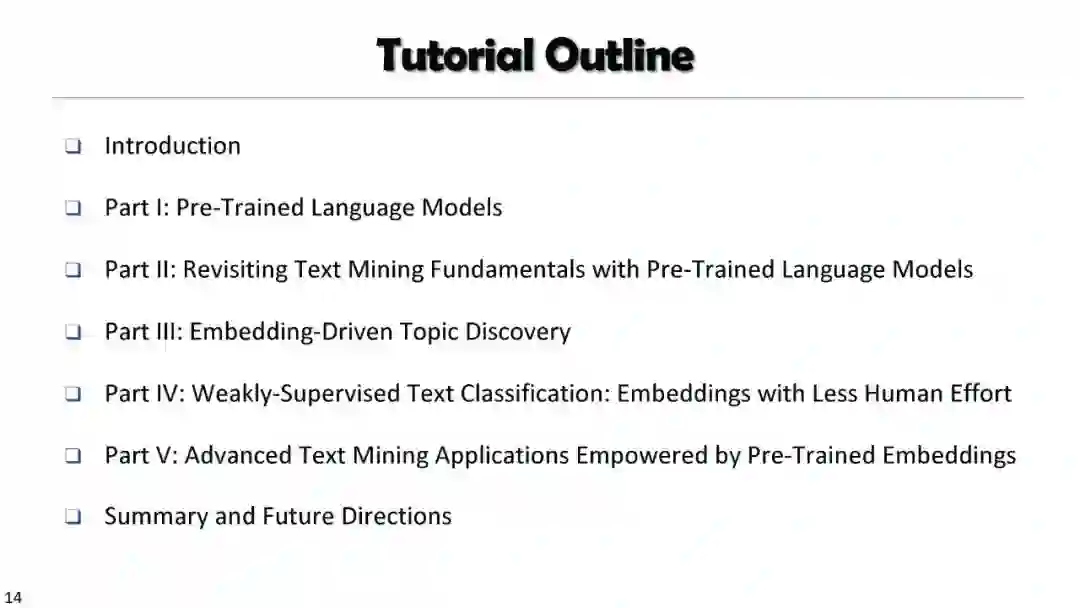

引言 Introduction

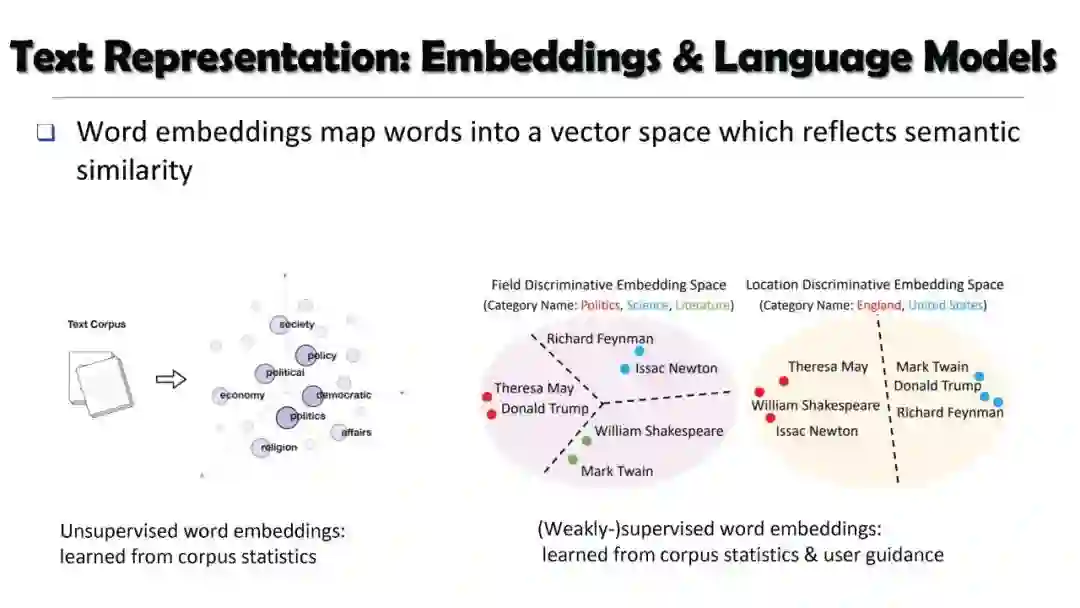

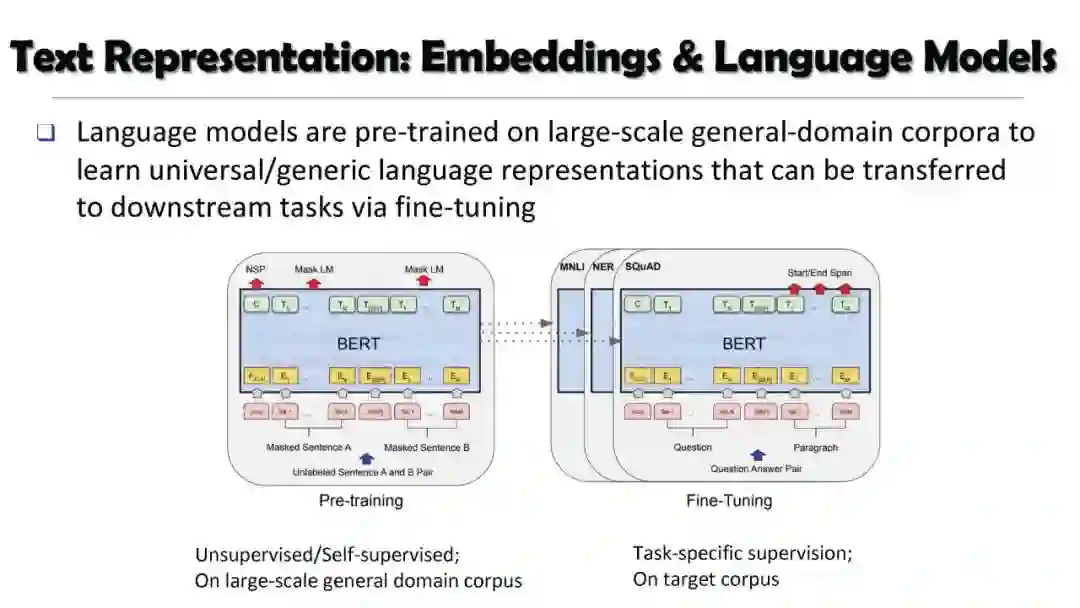

第一部分:预训练语言模型 Part I: Pre-Trained Language Models [Slides]

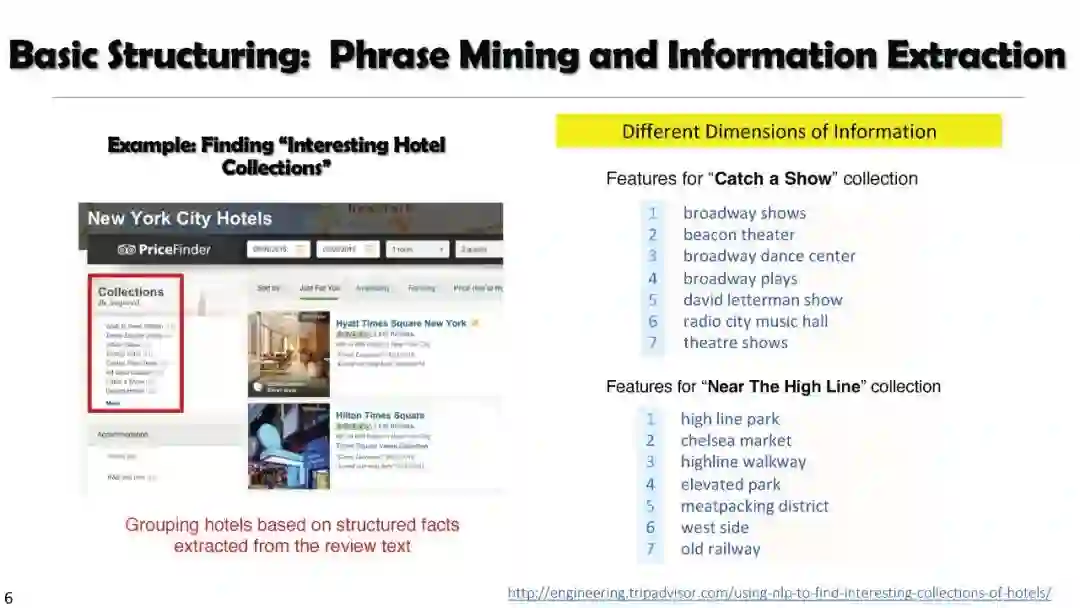

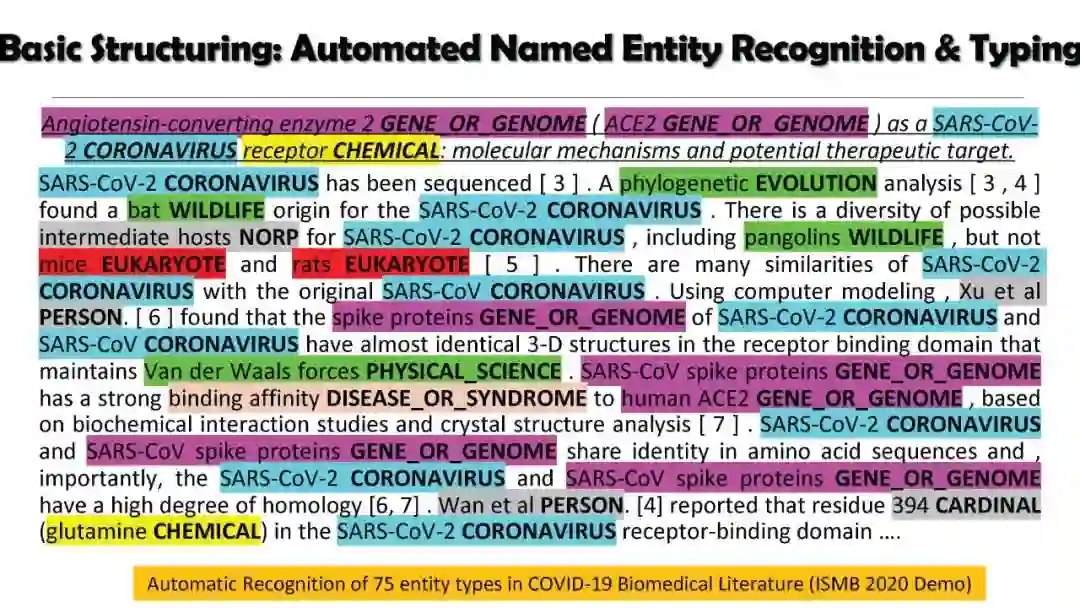

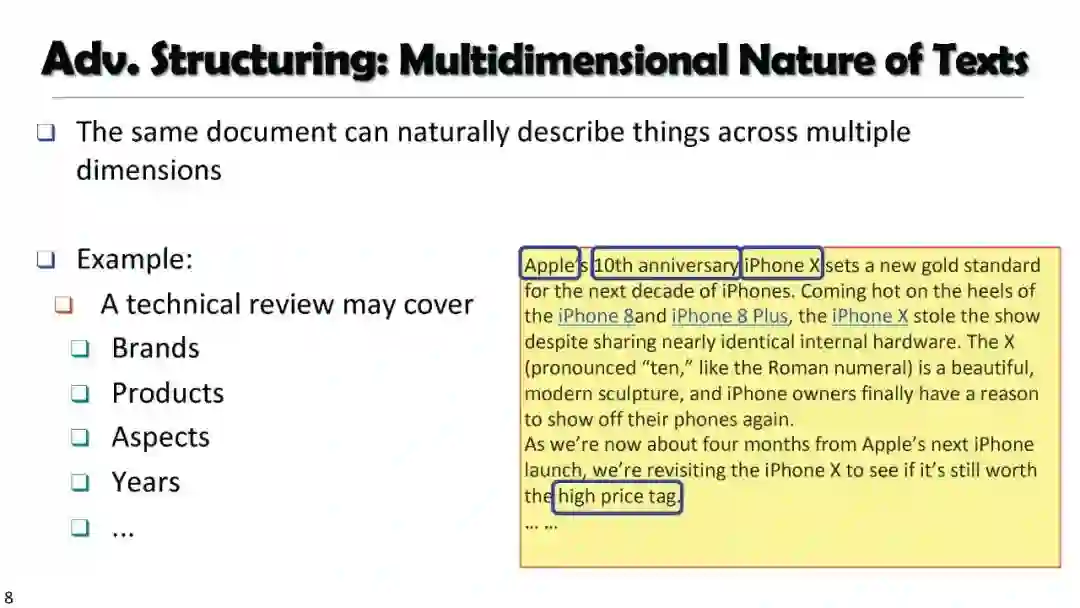

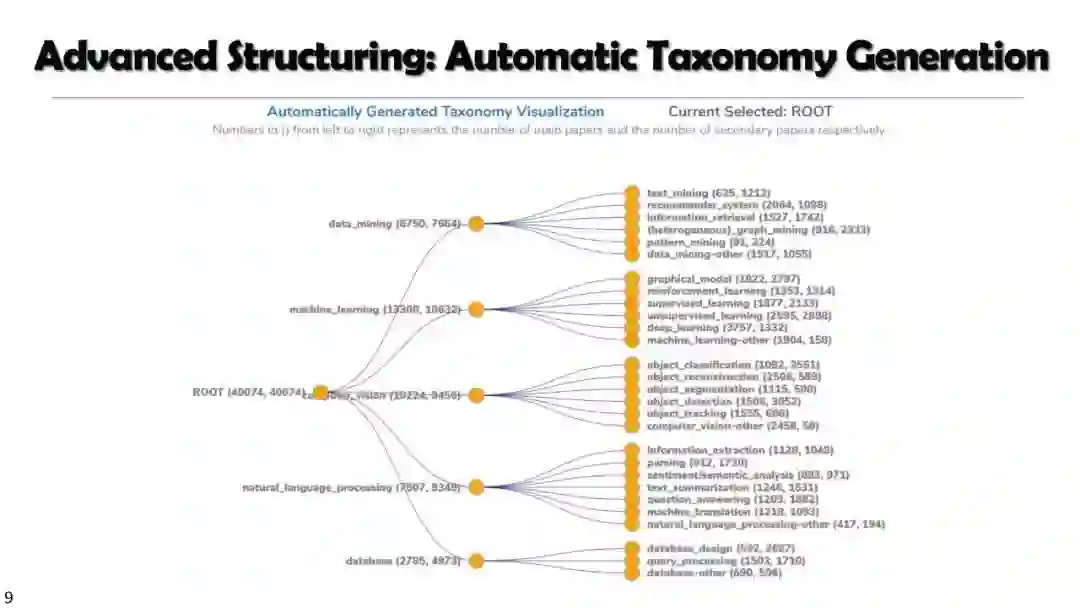

第二部分 重温文本挖掘基础 Part II: Revisiting Text Mining Fundamentals with Pre-Trained Language Models

第三部分 嵌入驱动主题挖掘 Part III: Embedding-Driven Topic Discovery

第三部分 弱监督文本挖掘 Part IV: Weakly-Supervised Text Classification: Embeddings with Less Human Effort

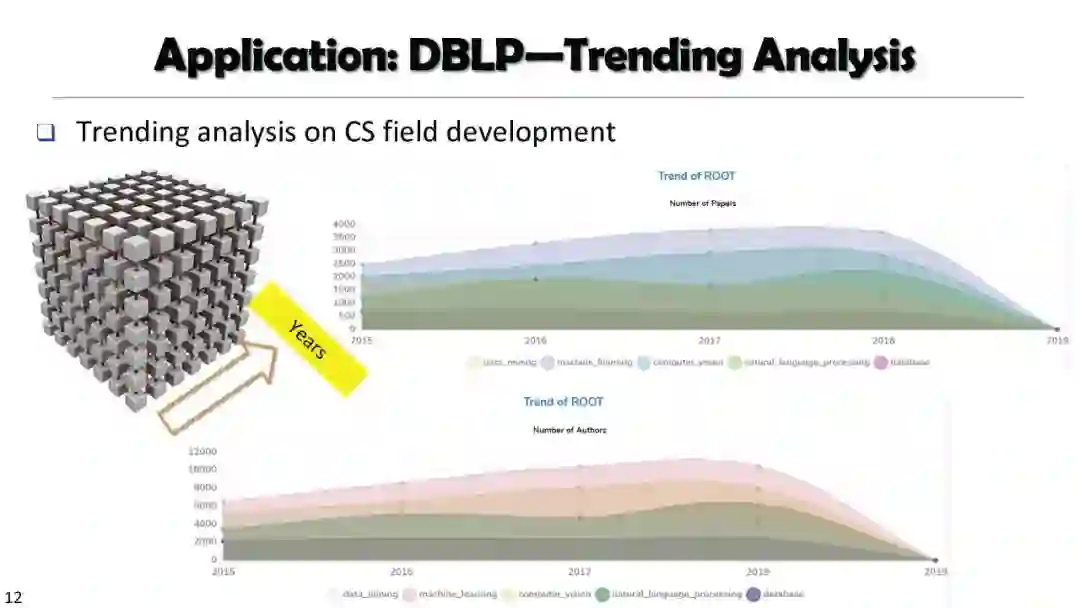

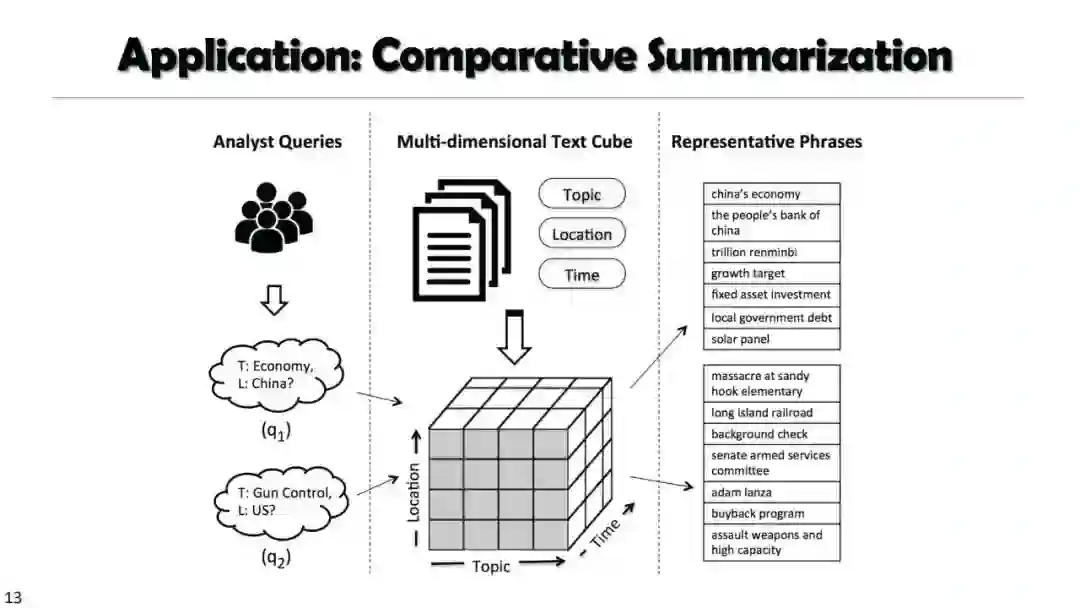

第四部分 高级文本挖掘应用 Part V: Advanced Text Mining Applications Empowered by Pre-Trained Language Models [Slides]

地址:

https://yumeng5.github.io/aaai22-tutorial/

专知便捷查看

便捷下载,请关注专知公众号(点击上方蓝色专知关注)

后台回复“PTM300” 可以获取《AAAI2022最新「预训练语言表示」报告,300页PPT阐述预训练文本挖掘进展》专知下载链接索引

登录查看更多

相关内容

Arxiv

0+阅读 · 2022年4月18日