一秒识别渣女,拒绝戴绿帽!这个造福男性的App,却被活活骂死了

文 | 祥燎

来源 | 金错刀(ID:ijincuodao)

江湖上一直有这样的传说——

一些性工作者或渣女、渣男,在风流多年,玩腻了之后,便会伪装成普通人,最后找个老实人嫁(娶)了。

这里的老实人,也被称作“接盘侠”。

据说程序员就是他们最心仪的“接盘侠”。在人们印象中,穿着格子衬衫的程序员,成天只知敲代码,两耳不闻窗外事,心思单纯,不容易发觉别人的伪装。

关键,程序员挣得还多。

程序员们自然不会坐以待毙。有道是,老实人被逼急了,什么事都干得出来。

有一个程序员,便开发了一套AI系统,只要在APP中上传一张女生的照片,程序就可以自动将这个女生的样貌与成人网站中女生的照片进行比对,辨别出她是否曾是性工作者。

尽管APP还未推出,网友已经迫不及待地取好了名字:原谅宝(爱她就要原谅她的过去),也叫“老实人保护计划”。

原谅宝得到了不少人的声援,男性居多,毕竟“苏享茂事件”还历历在目。

但该项目,夭折了,被人活活骂死的。在刀哥看来,挺活该。

老实人的反击:AI辨渣女

准备做原谅宝的人,是一个身在德国的程序员。

早在去年8月,他就透露出他的计划,理由正如大家所想的那样:

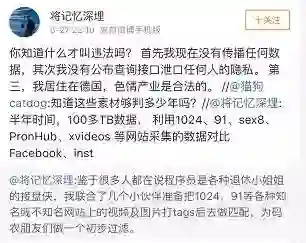

“鉴于很多人都在说程序员是各种退休小姐姐的接盘侠,自己作为一位资深程序员,实在看不下去这种言论,所以要做点事情,为各位同行的码农朋友找对象做一个初步过滤。”

今年5月27号,他的一则微博,成功引起了广泛关注。

“经过半年不懈的努力,100多TB数据,利用1024、91、sex8、PornHub、xvideos 等网站采集的数据对比Facebook、instagram、TikTok 、抖音、微博等社交媒体。我们在全球范围内成功识别了10多万从事不可描述行业的小姐姐。”

据称,他将色情网站上的公开视频和图片打标签后做匹配,以实现所谓“以图搜片”,查询者可以通过上传女性照片、视频和数据库做匹配,判断该女性是否疑似从事过色情行业。

他还宣称,该APP对视频的识别率,达到 99%;而对于声音语气模仿采用声纹检测对抗,识别率达到 100%。

消息一出,网上吵得不可开交。

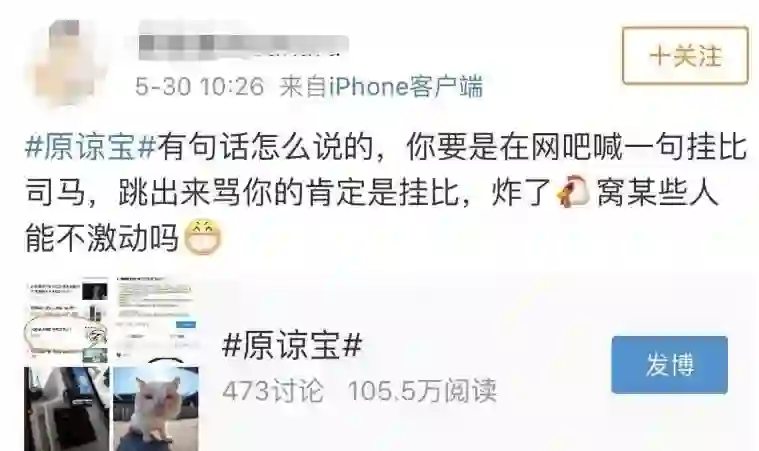

支持者大都是男性,他们认为这是老实人的福音,渣女应得的惩罚,甚至认为反对原谅宝的女性,肯定是“心虚”。

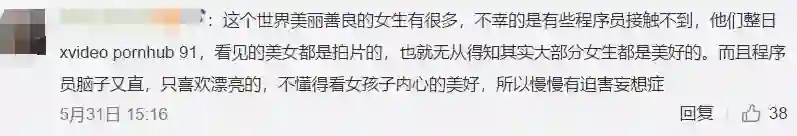

但更多人是愤怒,并反讽道:“冰清玉洁程序员”,“评判异性的唯一标准就是生殖器。大约连草履虫都活得比他们有滋味吧。”

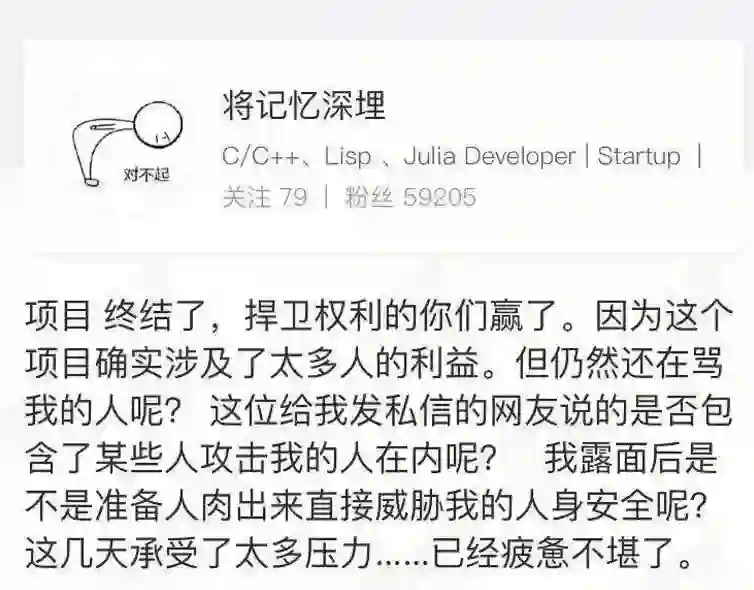

眼见事情闹大,那位不知名的程序员,删除了整个项目和数据库。

但网上的批评没有随之停止。大概是被骂得太惨,他后来换了个说法。他表示不经过本人,根本无法查询。因为该系统需要通过eID(公民网络电子身份标识)实名认证后注册登录,不经过本人同意是无法查询的;增加人脸识别作为二次确认后,只能查询自己是否有视频或图片被上传到色情网站。

这么一解释,原谅宝跟“老实人保护计划”可也没什么关系了,更像是为了担心被偷拍的女性而做的App。

但也有人指出,eID在中国并不普及,使用率很低。为了这极少数的人群,他却肯费如此大精力,是何等的胸襟。

还有人质问,为什么不做个男版的?他表示,他没有针对采集男性社交媒体数据来进行大规模训练,而且现在工作很忙。

网友便对他的话做了解读:他对采集女性的数据则做过大规模训练,而且做女版的时候就不忙。不过不做男版也情有可原,毕竟露脸的不多...

总之,解释越多,被骂得越狠。

原谅宝无疾而终了,但这件事引发的讨论,才刚刚开始。

被骂死的两点原因

触犯众怒的原谅宝死了,死得一点不冤。

那名程序员的出发点也许是好的,但涉及到人们极隐私的生活,事情就不可能像他想得那样简单。

各种质疑,会理所当然地向他扑来。

首先就是合法性的问题。

在对原谅宝的谴责中,“侵犯隐私权”是最常见的一种。他的回复是:整合公开资源并不犯法。

但此前,他也表示这是一个商业化的软件。那么在商业化的情况下,就极可能存在侵犯隐私权的风险。

另外,原谅宝在社交网络上获取用户数据,根据我国的《网络安全法》,未经本人同意在社交网络收集个人信息,本身就是一种非法行为。如果有中国用户使用这个系统,开发者就会面临违反《网络安全法》的风险。

简而言之,原谅宝并不合法。

其次是合理性的问题。

相比合不合法,很多人的关注点更多在于原谅宝的合理性上。比起谈法律,谈道德、谈实际情况更符合大众的调性。

原谅宝的设计初衷是辨别渣女和性工作者。但它怎么才能辨别是性交易还是伴侣之间的视频呢?

该程序员的回答是,无法甄别...

所以如果原谅宝真推广开来,最常见的情况只会是这样:所有能被搜索出来的女性,都会被人认为是性工作者或渣女。

但谁都知道,现实生活没有非黑即白。不是你拍了视频就是渣,而从没拍过的人就冰清玉洁。

人工智能再智能,也没法仅靠一段视频,就还原当时的来龙去脉。哪怕是完整的视频,但拍摄的原因,上传的原因,外人可能永远也无从得知。

或许有的人的确玩得很嗨,但嗨到很拍视频并上传的,只能是少数。至于性工作者,更不会轻易接受拍视频。

而一般人出现在成人视频网站上,无外乎几种情况。

第一,以为只是情侣间的情趣活动,但没想到伴侣却上传到了网站。

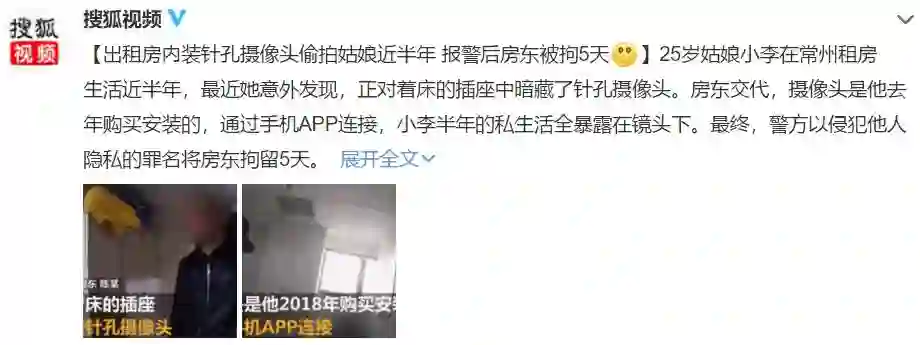

第二,被偷拍。别说在酒店,就算行走在大街上,甚至是厕所里(一直搞不懂有啥可看的...),针孔摄像头都无处不在,防不胜防。

在偷拍产业链发达的韩国,女性人人自危,以至于韩国的手机,哪怕你调成静音,也没法关闭拍照的快门声。中国的偷拍,也渐渐有向韩国看齐的趋势。

第三,被威胁。此前的“裸贷”“裸条”,就可以归为此类。

第四,被犯罪。最近国外网友在Twitter上发起了#Chinawakeup#的话题,事情的起因是她在网上看到很多女性被下药,被不法分子侵害的视频。这种被下迷奸药,女性在毫不知情的情况下被偷拍、强奸的视频,在成人视频网站上并不少见,甚至还可能成为卖点。

因此,很多女性是以受害者的身份出现在这些视频里的。视频的再次传播对她们而言,无疑是二次伤害。

原谅宝明明什么情况都搞不明白,却要掌握生杀大权,毁人一生。

但反过来,很少有男性是被迫的。真要说起来,女性成为“接盘侠”的可能性要大得多。

AI辨渣女,可信吗?

抛开法律的束缚,道德的谴责,原谅宝在技术上是否可行呢?

很值得怀疑。

那名程序员声称原谅宝对视频和声纹的识别率,分别高达99%和100%。这个数据怎么来的?他没说。他如何测试,测试了多少样本,全是未知数。

仅有一个结论,很难让人信服。

这只是一种自然而然的判断,而真从技术上来说,原谅宝应该也不具备能识别渣女的能力。

原谅宝在查询系统中使用的能从视频中识别人物的技术叫智能视觉,是现在在人工智能领域比较常见的一种技术。

智能视觉技术,就是用算法在后台不断训练系统,早期要靠人工不断地给系统识别的图片打上各类标签。最终,等技术足够成熟,不需要人工干预,系统就可以自动地得出标签。我们熟知的天眼系统,就使用了部分智能视觉技术。

这就涉及到了一个问题——它需要一个准确的数据库。原始样本如果不准确不够多,也就无从利用答案训练系统。

也就是说,该程序员自己得知道正确答案,他才可能训练系统。这就要求他必须能把视频网站的人,和社交网站的人对上号。

但是,像Facebook、微博这样大型社交网站,反爬虫技术相当成熟,一般人要获取用户数据,难度极大。

事实也的确如此。据他所说,原谅宝在全球筛选出了不到11万女性,其中拥有微博或抖音账号的,只有不到1000人。这正说明其采集国内社交媒体数据能力相当之差,因此识别的准确率也必然高不到哪去。

相比社交网站的用户数据,获取成人视频网站的数据就没那么难了,但还是那个问题:数据准确吗?

据业内人士称,“视觉智能需要很多的前提,比如拍摄的清晰度,以及作为模板的人像有特定要求。”

除了正儿八经拍片谋生的人,一般的成人视频里,要么脸部有遮挡,要么画面晃动,画面不清晰,光线昏暗等等,根本无从识别。

哪怕画面清晰,脸部没遮挡,镜头稳定,你获得的数据就是对的吗?

面对亚洲四大邪术,就算是人眼,也有看走眼的时候。

还有近几年兴起的AI换脸,让多少人误以为女明星下海了?

将盖尔·加朵的脸换到艳星上

还有的人得不到女神,就收集女神照片,利用该技术做一部女神黄片。

甚至有的人利用AI换脸,对某些女性进行色情报复。她的家人、朋友,往往信以为真,毕竟“有视频有真相”。

总之,在这一切的数据都不可信的前提下,原谅宝的AI辨渣女,仿佛天方夜谭。

话说回来,如果他在缺乏准确数据库的情况下,还能做到高达99%的准确率,如此牛X的程序员,我们可以当国宝对待了。

至此,连他的出发点,也很值得怀疑了。

其实这样的事,也见怪不怪了。总有这样的人,会让我们在生活中一次次感受一个浅显又深刻的道理——

科技是把双刃剑。

多么痛的领悟。

参考资料:

半佛仙人:《原谅宝的数据真相与隐私埋葬》

大家:《那些怕“接盘”的程序员,是因为他们看谁都是性工作者》

航通社:《“原谅宝”:“科技向善”的反面》

往期精选

- 加入社群吧 -