强化学习博士毕业吃香吗?Reddit网友寻求职业规划建议

新智元报道

新智元报道

编辑:桃子 拉燕

【新智元导读】强化学习的博士生该如何做职业规划?

尽管我更喜欢与RL相关的博士课程,你认为哪个课程更符合我的期望?

DL和RL

DL和RL

网友献策

参考资料:

https://www.reddit.com/r/MachineLearning/comments/sxpo89/d_advice_on_career_paths_after_a_phd_in_rl/

登录查看更多

相关内容

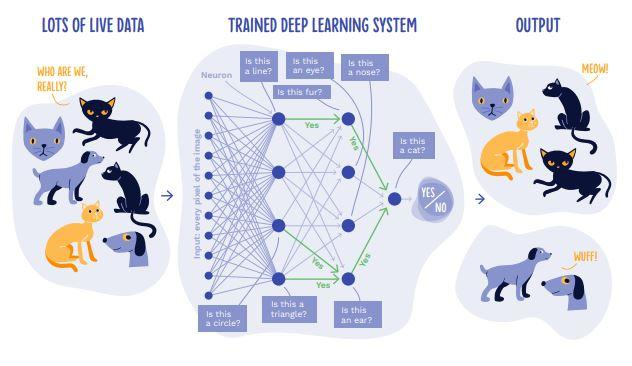

强化学习(RL)是机器学习的一个领域,与软件代理应如何在环境中采取行动以最大化累积奖励的概念有关。除了监督学习和非监督学习外,强化学习是三种基本的机器学习范式之一。

强化学习与监督学习的不同之处在于,不需要呈现带标签的输入/输出对,也不需要显式纠正次优动作。相反,重点是在探索(未知领域)和利用(当前知识)之间找到平衡。

该环境通常以马尔可夫决策过程(MDP)的形式陈述,因为针对这种情况的许多强化学习算法都使用动态编程技术。经典动态规划方法和强化学习算法之间的主要区别在于,后者不假设MDP的确切数学模型,并且针对无法采用精确方法的大型MDP。

专知会员服务

140+阅读 · 2020年7月10日

Arxiv

0+阅读 · 2022年4月20日

Arxiv

0+阅读 · 2022年4月20日

Arxiv

24+阅读 · 2021年8月12日