BAT机器学习面试题及解析(286-290题)

本系列作为国内首个AI题库,囊括绝大部分机器学习和深度学习的笔试面试题、知识点,可以作为机器学习自测题,也可以当做查漏补缺的资料库。七月在线AI题库(网页版及APP版)见“阅读原文”

286.优化算法及其优缺点?

温馨提示:在回答面试官的问题的时候,往往将问题往大的方面去回答,这样不会陷于小的技术上死磕,最后很容易把自己嗑死了。

1)随机梯度下降

优点:可以一定程度上解决局部最优解的问题

缺点:收敛速度较慢

2)批量梯度下降

优点:容易陷入局部最优解

缺点:收敛速度较快

3)mini_batch梯度下降

综合随机梯度下降和批量梯度下降的优缺点,提取的一个中和的方法。

4)牛顿法

牛顿法在迭代的时候,需要计算Hessian矩阵,当维度较高的时候,计算 Hessian矩阵比较困难。

5)拟牛顿法

拟牛顿法是为了改进牛顿法在迭代过程中,计算Hessian矩阵而提取的算法,它采用的方式是通过逼近Hessian的方式来进行求解。

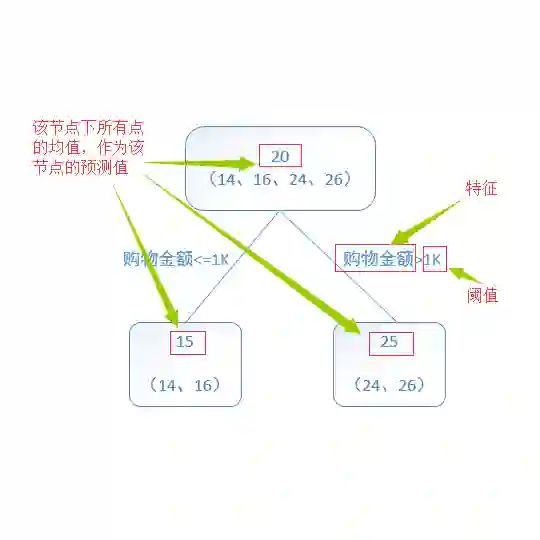

287.RF与GBDT之间的区别与联系?

1)相同点:都是由多棵树组成,最终的结果都是由多棵树一起决定。

2)不同点:

a 组成随机森林的树可以分类树也可以是回归树,而GBDT只由回归树组成

b 组成随机森林的树可以并行生成,而GBDT是串行生成

c 随机森林的结果是多数表决表决的,而GBDT则是多棵树累加之和

d 随机森林对异常值不敏感,而GBDT对异常值比较敏感

e 随机森林是减少模型的方差,而GBDT是减少模型的偏差

f 随机森林不需要进行特征归一化。而GBDT则需要进行特征归一化

288.两个变量的 Pearson 相关性系数为零,但这两个变量的值同样可以相关。

A 正确

B 错误

答案为(A):Pearson相关系数只能衡量线性相关性,但无法衡量非线性关系。如y=x^2,x和y有很强的非线性关系。

289.下面哪个/些超参数的增加可能会造成随机森林数据过拟合?

A 树的数量

B 树的深度

C 学习速率

答案为(B):通常情况下,我们增加树的深度有可能会造成模型过拟合。学习速率并不是随机森林的超参数。增加树的数量可能会造成欠拟合。

290.目标变量在训练集上的 8 个实际值 [0,0,0,1,1,1,1,1],目标变量的熵是多少?

A. -(5/8 log(5/8) + 3/8 log(3/8))

B. 5/8 log(5/8) + 3/8 log(3/8)

C. 3/8 log(5/8) + 5/8 log(3/8)

D. 5/8 log(3/8) – 3/8 log(5/8)

答案为(A)

《BAT机器学习面试1000题系列》往期题目: