论文清单:一文梳理因果推理在自然语言处理中的应用

©作者 | 肖之仪

单位 | 北京邮电大学

研究方向 | 因果推理、对话系统

2. Causality for NLP Reading List

3. Causal Reading Group

因果工具

1. DoWhy: An end-to-end library for causal inference

4. CausalNex: A Python library that helps data scientists to infer causation rather than observing correlation.

5. CausalImpact: An R package for causal inference in time series

6. CausalDiscoveryToolbox: Package for causal inference in graphs and in the pairwise settings. Tools for graph structure recovery and dependencies are included.

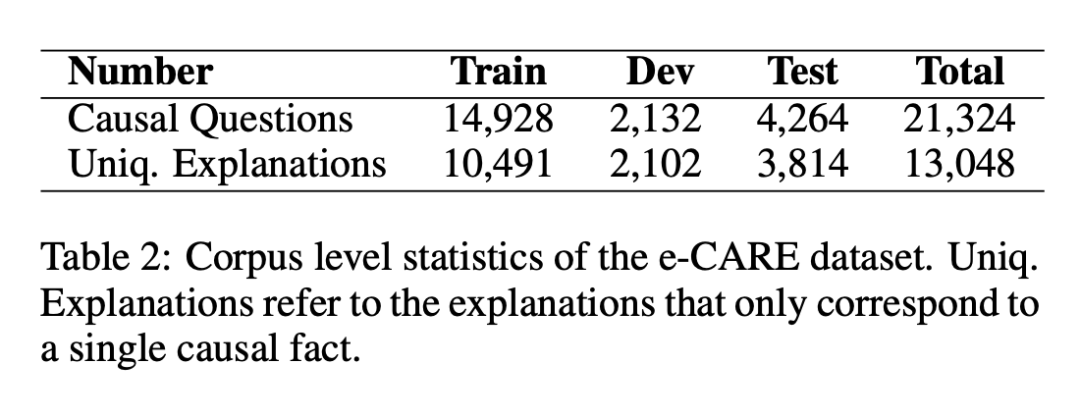

e-CARE: a New Dataset for Exploring Explainable Causal Reasoning

数据集示例:

综述类文章

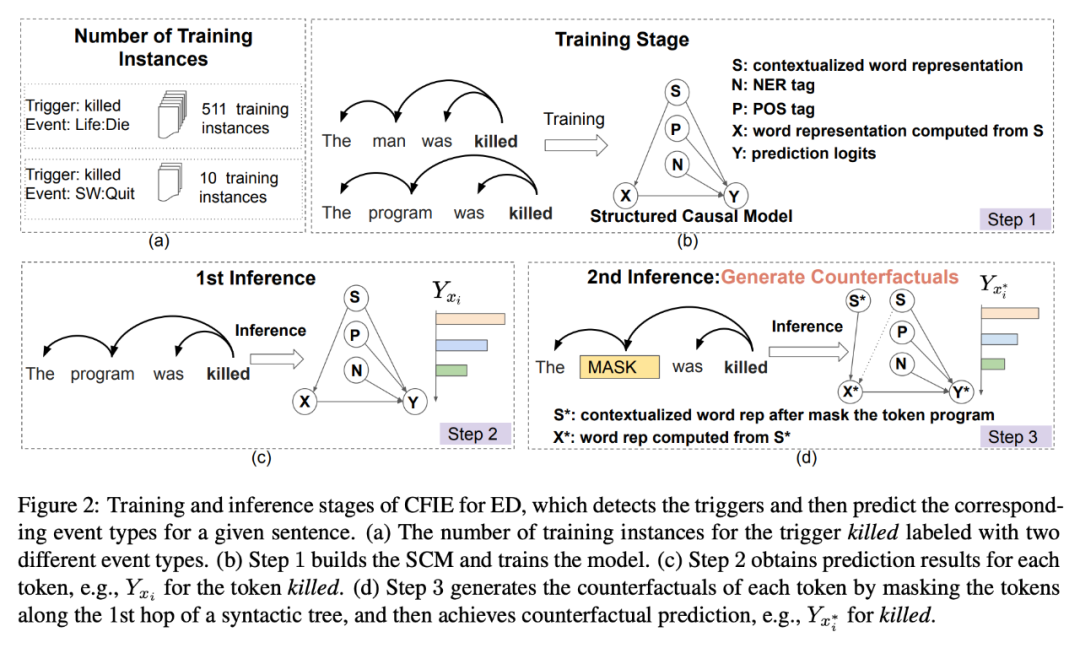

A Review of Dataset and Labeling Methods for Causality Extraction

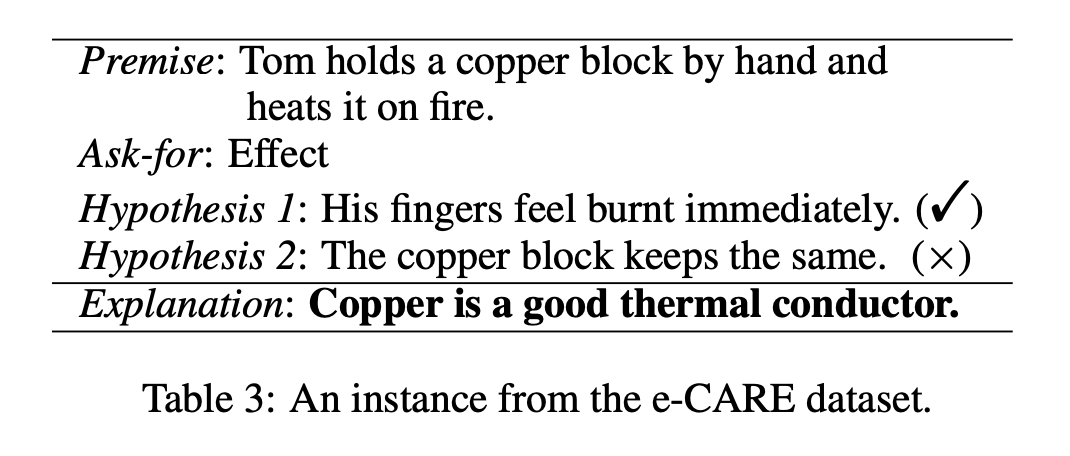

同时作者也总结了在英文语境相下具有因果关系的连接词,如下表所示:

▲ Summary of common causal connectives in English

Causal Inference in Natural Language Processing: Estimation, Prediction, Interpretation and Beyond

文献概述如下:

在NLP任务建模种融合因果关系

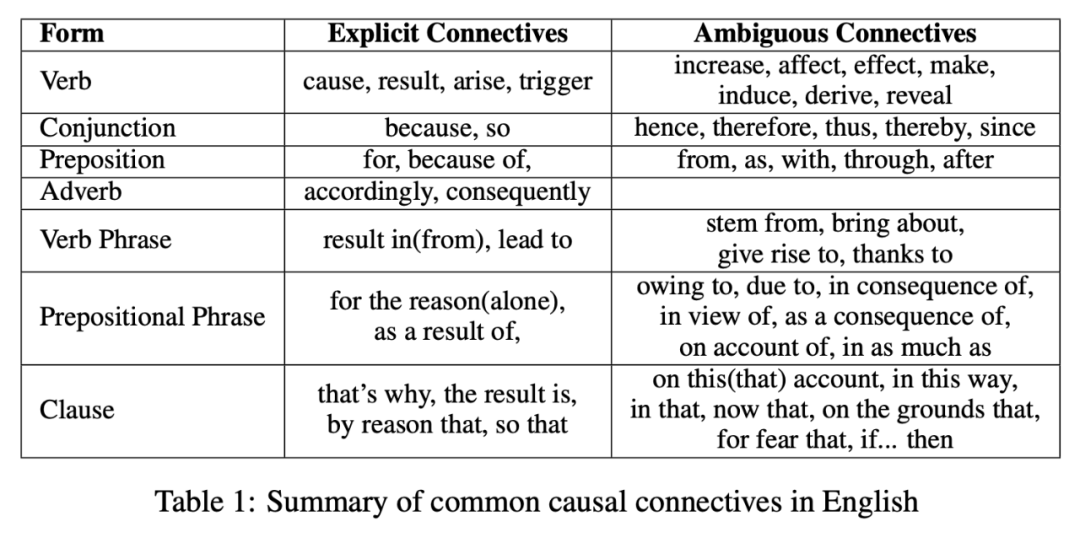

Uncovering Main Causalities for Long-tailed Information Extraction (EMNLP 2021)

信息抽取旨在从非结构化的文本中提取出结构化的信息。在实际场景下,数据集由选择偏移带来的长尾分布可能会使得模型习得一些可疑的关联关系。

本文献提出的 CFIE 拟解决上述问题,具体贡献如下:

1. 对多种信息抽取任务(RE,NER 和 ED )构建统一的结构因果模型(structural causal model)并描述不同变量之间的因果关系;

2. 基于上述的结构因果模型,使用相应的语言结构生成反事实样本,以此在推理阶段更好的计算直接因果效应(direct causal effect);

3. 文献进一步提出一种消除偏倚的方法以提供更具鲁棒性的预测。

▲ Training and inference stages of CFIE for ED

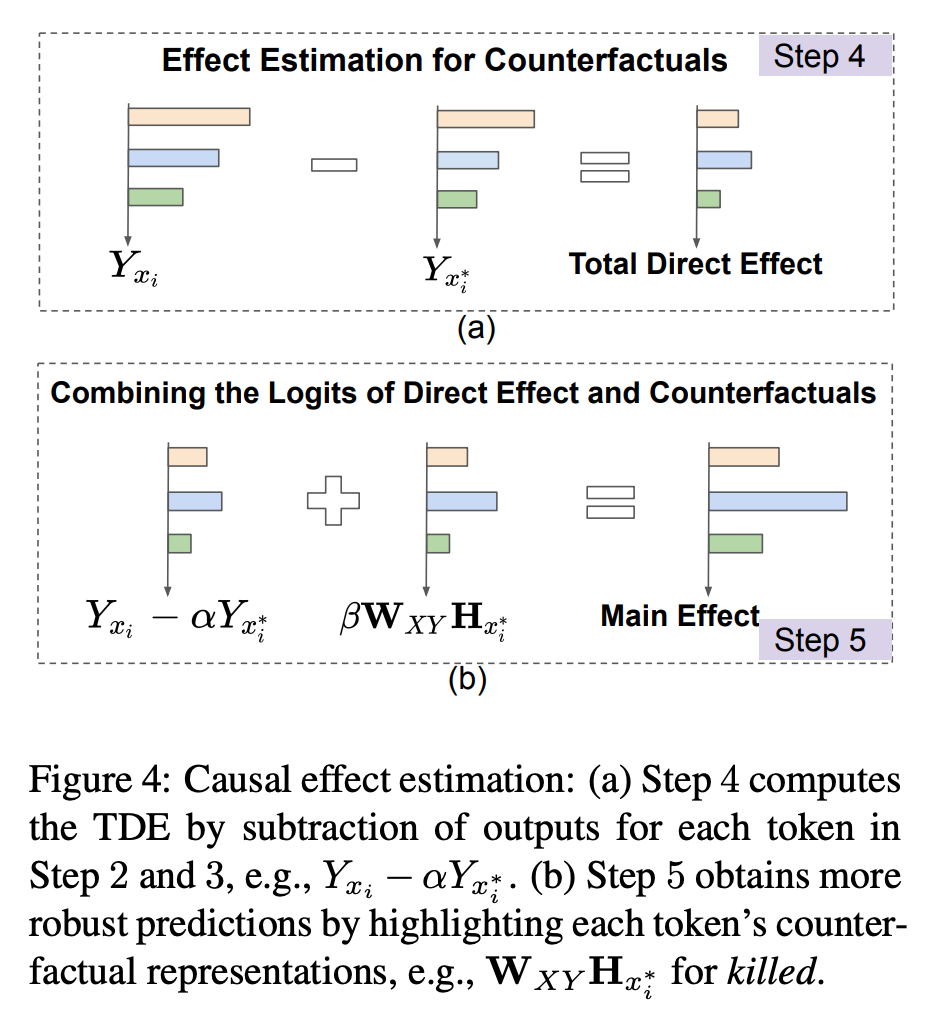

▲ Causal effect estimation

CFIE 的模型设计如上图所示,分成如下五个步骤:

Counterfactual Generator: A Weakly-Supervised Method for Named Entity Recognition (EMNLP 2020)

1. 基于因果关系的视角描述了 NER 模型推断机制的理论基础,研究了模型输入特征与输出标签之间存在的可疑的关联关系;

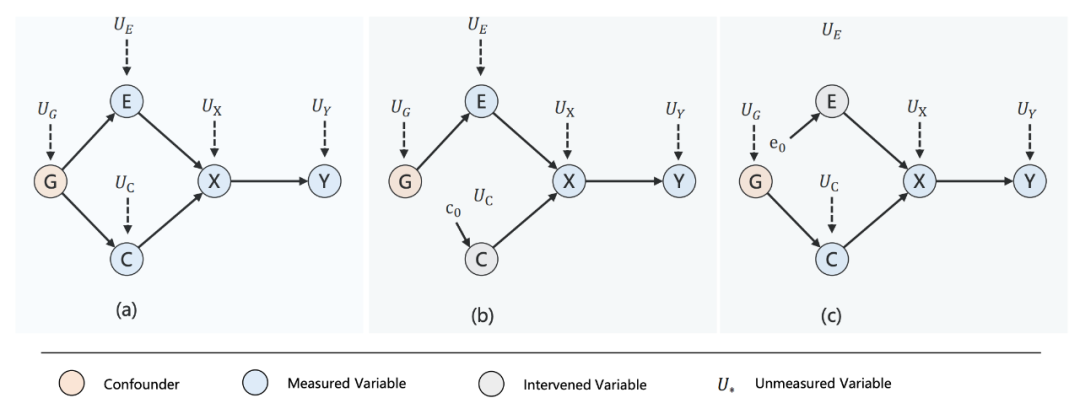

▲ Structural Causal Models (SCMs) that describes the mechanism of the NER model inference.

作者为 NER 模型的推理机制构建了相应的 SCM 并以 DAG 的形式可视化,其中结点 G 表示混杂因子——既影响了实体结点 E的同时也影响了上下文结点 C,结点 X 则代表了由结点 E 和 C 所生成的输入实例,结点 Y 是 NER 模型的评估指标,如 F1 值。

作者通过平均因果效应 ACE(Average Causal Effect)来评估干预后的 treatment effect,值得注意的是上图中的 (b) 与 (c) 分别表示对上下文和实体进行干预,作者设计了一个新的评估指标—— RI(Relative Importance)来评估上下文和实体的表示对于 NER 模型推理阶段的重要性,在后续的实验分析模块,作者得出的结论是实体的表示对 NER 模型的推理更重要。

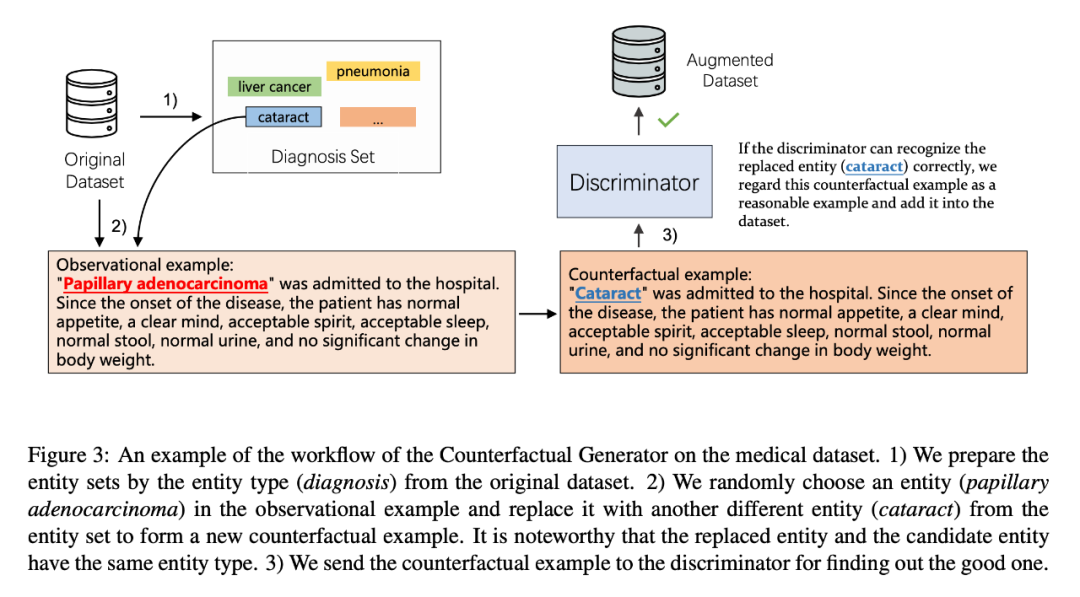

1. 从已有的本地数据中抽出实体集合;

2. 从实体集合中选取与待干预样本实体相同类别的实体进行替换从而生成反事实样本;

3. 通过使用原始数据训练的辨别器(discriminator)分辨新生成的反事实样本是否合理,若合理则将该样本加入到已有数据集内。

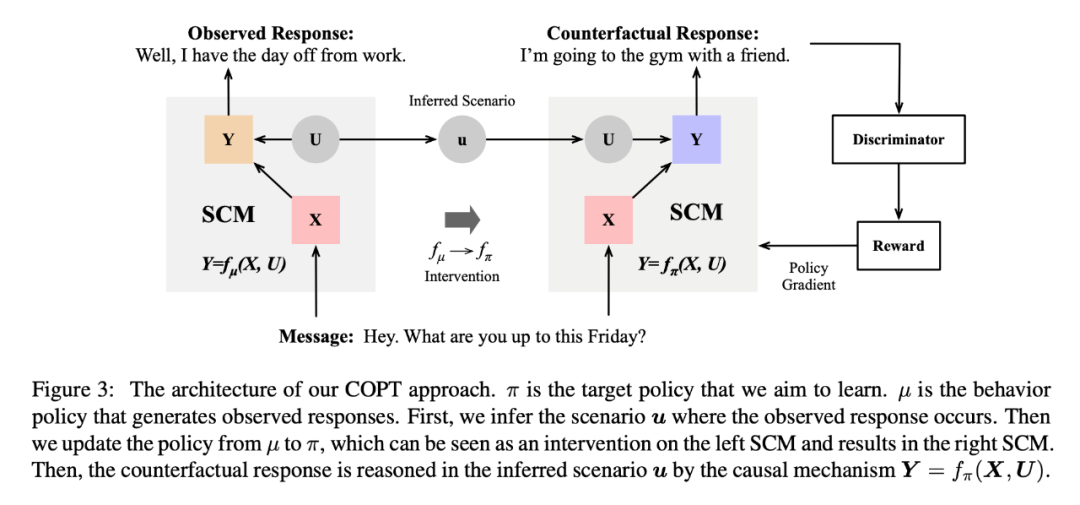

Counterfactual Off-Policy Training for Neural Dialogue Generation (EMNLP 2020)

1. 以「结构因果模型」对「对话生成模型」建模,从而在「对话生成模型」中融合「反事实推理」;

2. 论文中提出的模型所生成的反事实回应相较于其他标准的基于对抗学习从头开始生成的回应的质量要高得多;

3. 论文提出的方法与模型无关(model-agnostic),因此可以适配与任何基于对抗学习的对话生成模型。

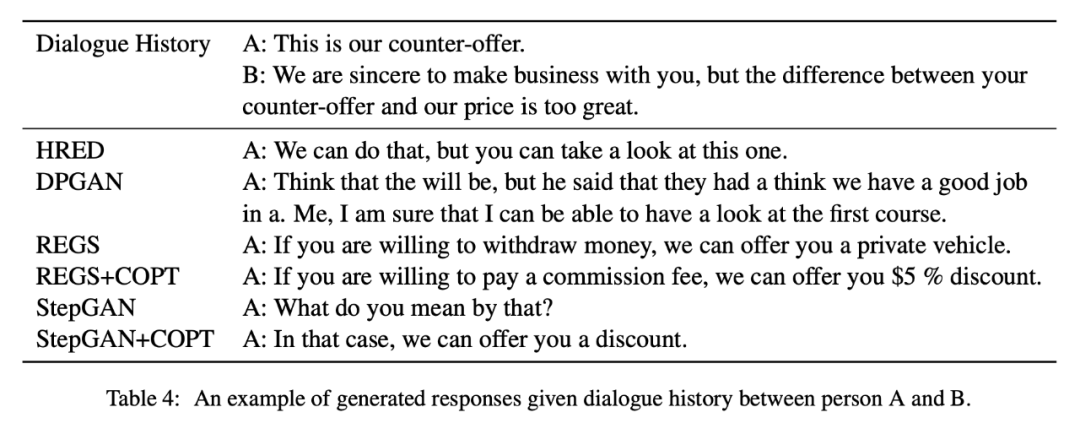

▲ An example of generated responses given dialogue history between person A and B.

文中提出的「counterfactual off-policy training (COPT) approach」步骤如下:

1. 构造生成式对话模型的 SCM,将其描述为两个组成部分即——场景(scenarios)和因果机制(causal mechanisms);

2. 给出观测回复数据中推断的场景,COPT 将场景(scenario)以及对话历史(dialogue history)根据 SCM 生成相应的反事实回复;

3. 判别器评估生成的语句,并将相应的 reward 返还给第二步的生成器。

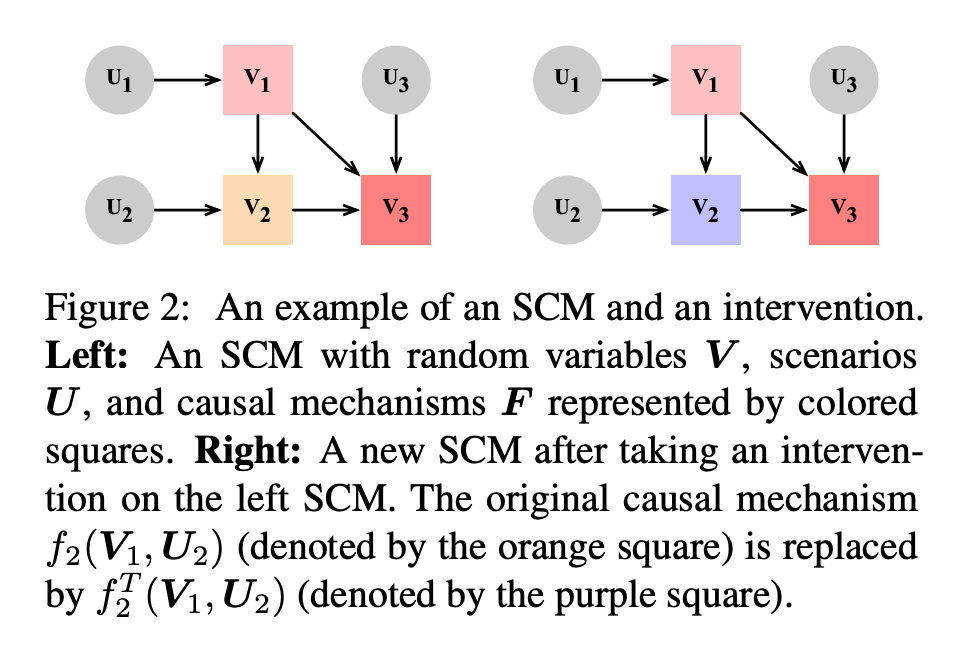

▲ An example of an SCM and an intervention.

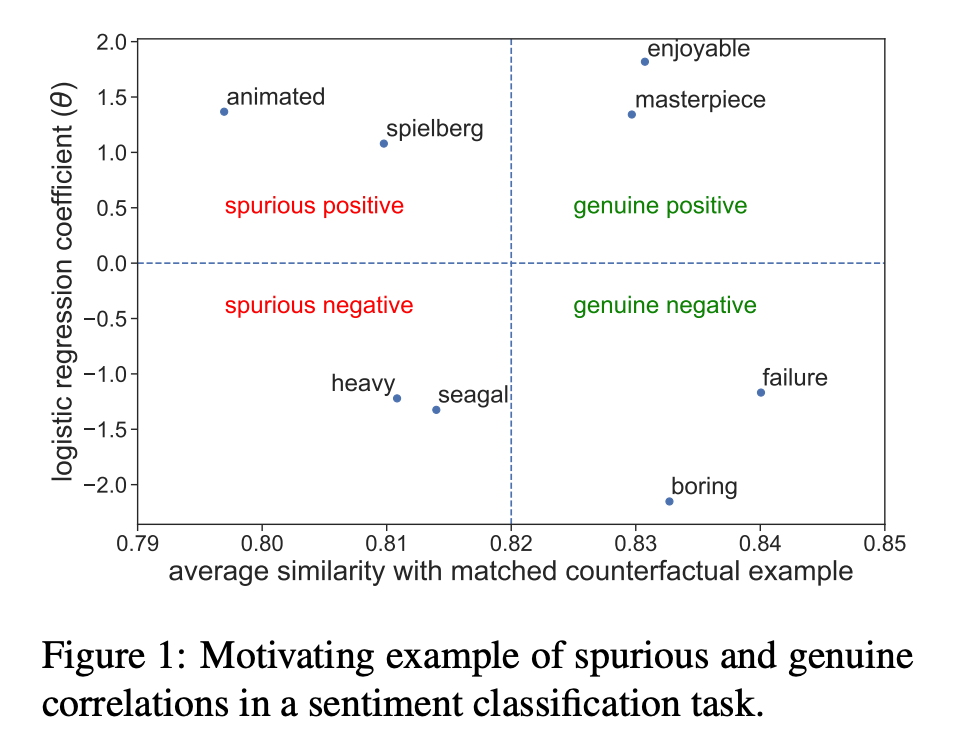

Identifying Spurious Correlations for Robust Text Classification (EMNLP Findings 2020)

▲ Motivating example of spurious and genuine correlations in a sentiment classification task.

在上图中,作者展示了八个与模型高度匹配的词汇,其中类别 1 代表正向情感,类别 2 则表示负向情感。

不难发现,在正向情感方面,「spielberg」与「animated」看上去较为可疑,作者认为「spielberg」是一名非常成功的电影导演,在数据集中提及到他的电影评论往往是正向的,因此模型认为「spielberg」与正向情感强相关,但作者认为「spielberg」这个单词本身不应当是电影评论被判定为正向情感的原因,举个很简单的例子,倘若有一天导演拍摄了一部新片但口碑却不尽如人意,含有这类可疑的关联关系的模型则会误判评论。

因此,本文提出了一个监督文本分类方法旨在认出文本分类中的伪相关性和真相关性,文章提出的方法如下:

1. 用原始数据集训练分类器 f;

2. 从分类器 f 中提取出与每个类别强相关的若干个词汇;

3. 对前序步骤提取出来的每个词汇计算其真实或可疑的可能值;

4. 对第二步产生词汇的子集进行人工标注,并训练成词汇分类器 h;

5. 应用 h 标注剩余的单词去评估他们是否可疑。

对语言模型进行因果分析

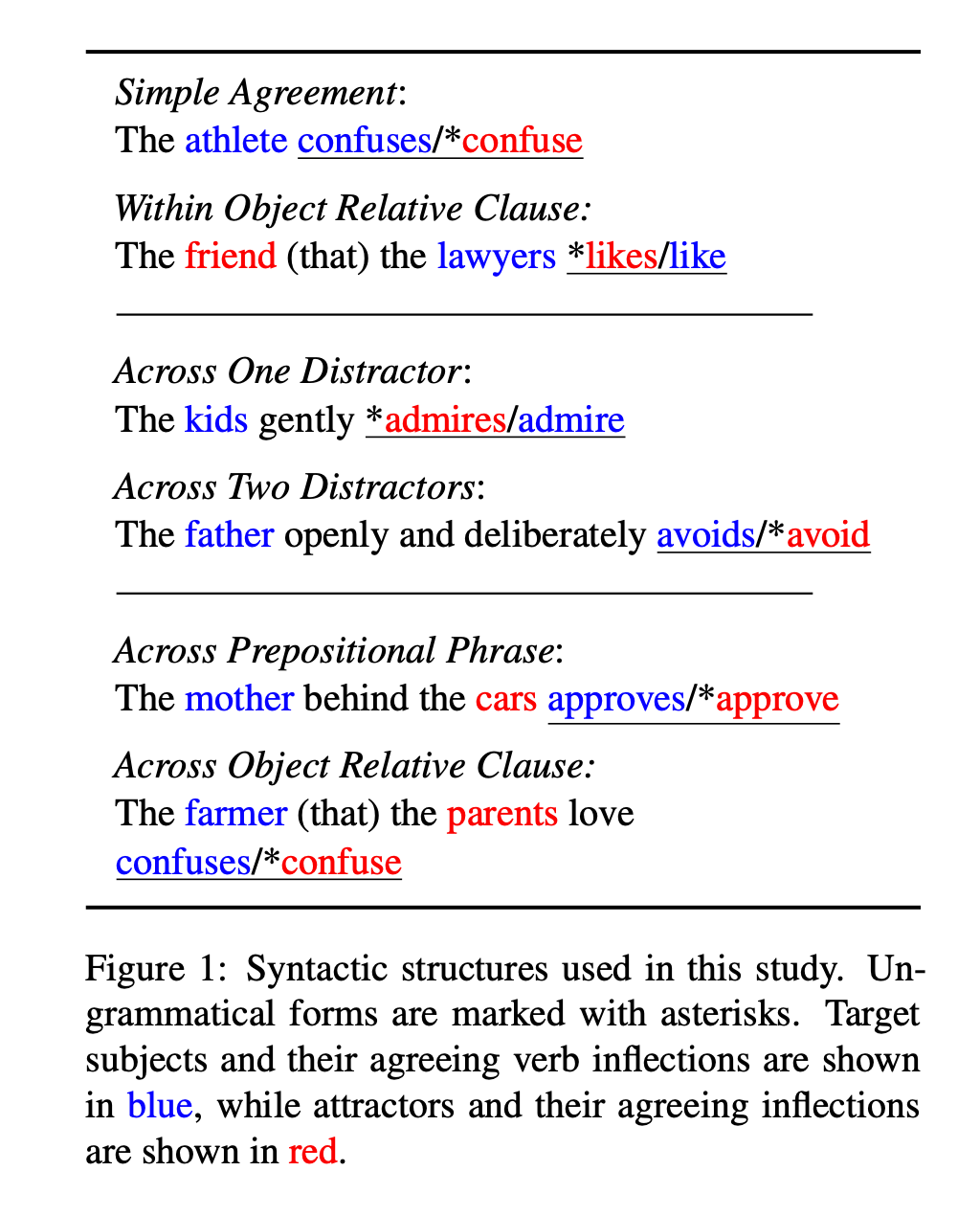

Causal Analysis of Syntactic Agreement Mechanisms in Neural Language Models (ACL 2021)

作者想应用因果中介分析(causal mediation analysis)来观察预训练语言模型在「主谓一致」上的表现,探讨对不同的语法结构来说,语言模型中的的哪个神经元负责判断判断「主谓一致」。

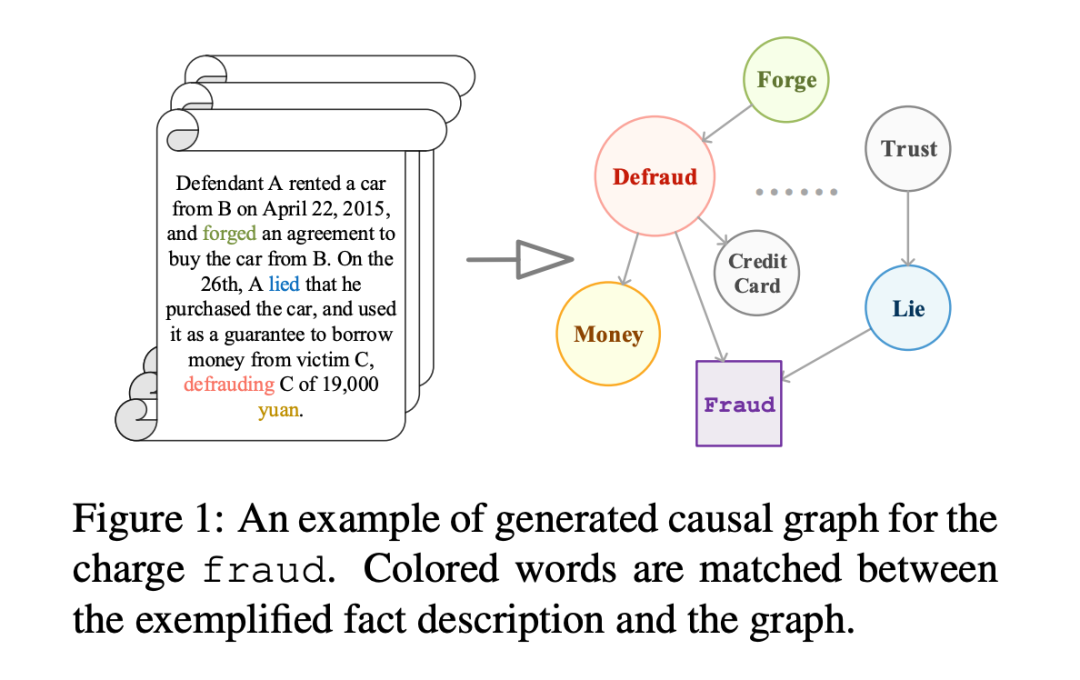

Everything Has a Cause: Leveraging Causal Inference in Legal Text Analysis (NAACL 2021)

▲ An example of generated causal graph for the charge fraud.

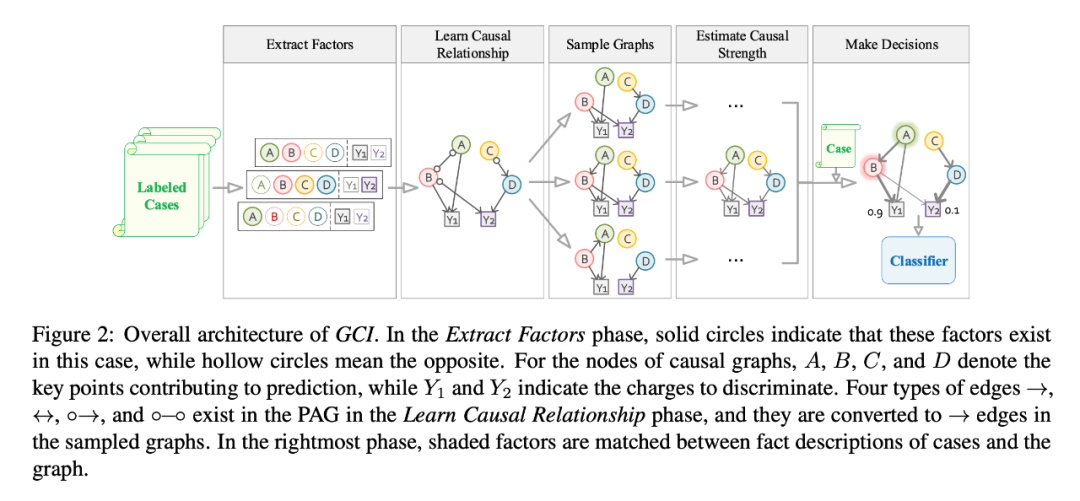

因果推理可以捕捉不同变量之间的因果关系,大多数现有工作专注于解决结构化数据,而从非结构化数据中挖掘因果关系则鲜少有学者涉足,本文献提出了一个全新的基于图的因果推断框架 CGI(Graph-based Causal Inference)——不用人为介入即可通过事实描述构造因果图,以此辅助法律从业者作出更好的判断。

文献通过「近似指控消歧」(similar charge disambiguation)任务来评估框架的性能,实验结果验证 GCI 不仅能够在多个近似指控的事实描述中捕捉细微差别,而且能提供解释性判决,在小样本的实验环境下 CGI 的表现优异。除此之外, CGI 中所包含的因果知识能够有效地与神经网络相结合,以此提供更好的性能和可解释性。

1. 文献提出了一个新的基于图的因果推断框架,可以自动地对非结构化数据进行因果推断;

2. 文献将 GCI 框架所得出的因果知识与神经网络相结合;

3. 文献通过「近似指控消岐」任务验证了 CGI 能从法律文本中捕捉到细微差别,且它能够进一步提升神经网络的可解释性。

▲ Overall architecture of GCI.

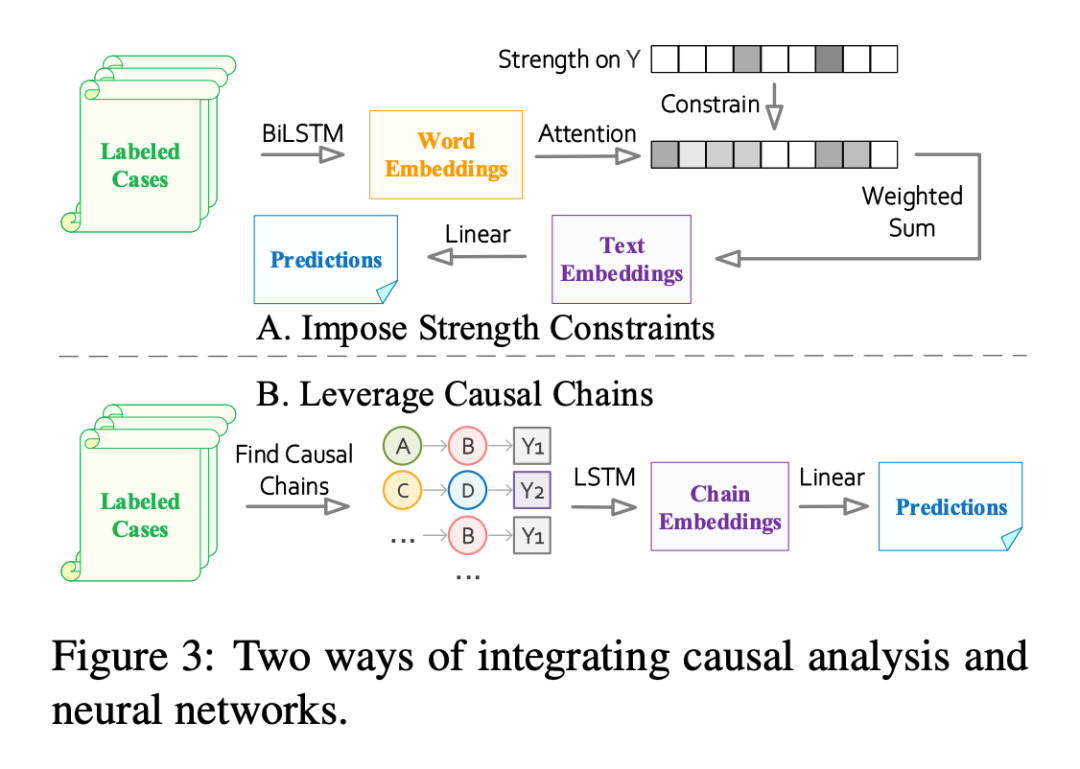

▲ Two ways of integrating causal analysis and neural networks.

文献通过两种方式将因果发现的结果应用至神经网络,第一种是将因果强度限制 Attention 的权重,第二种将有向无环图拆解成若干因果链并作为 LSTM 的输入。

因果常识推理及其生成

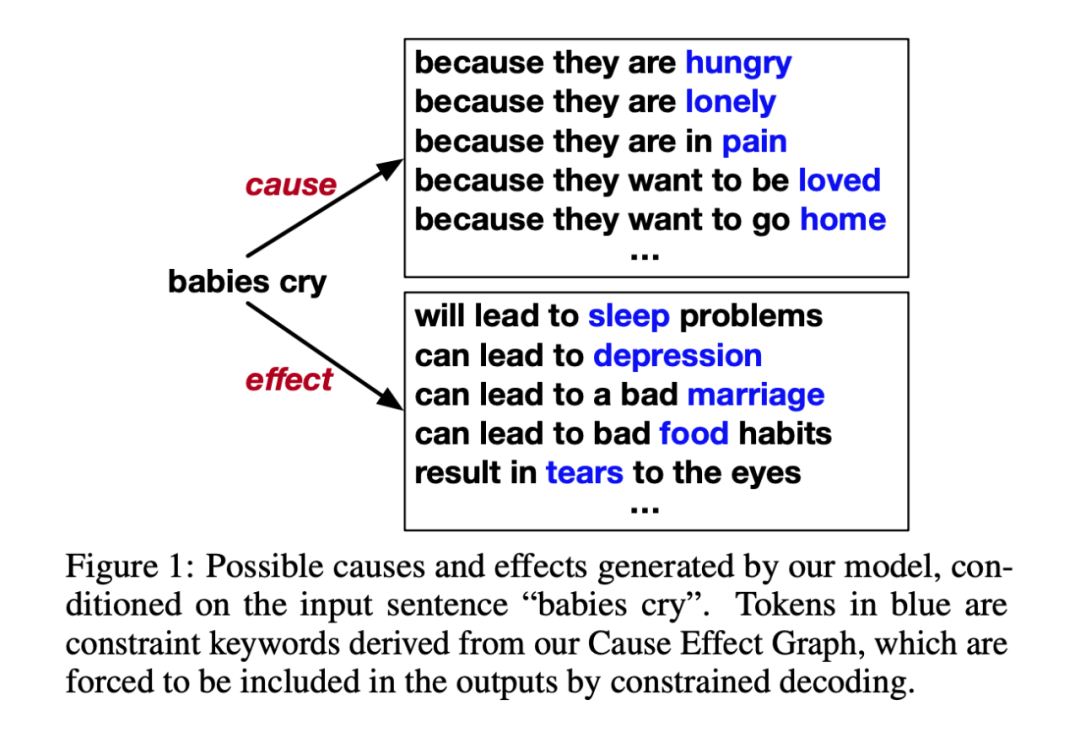

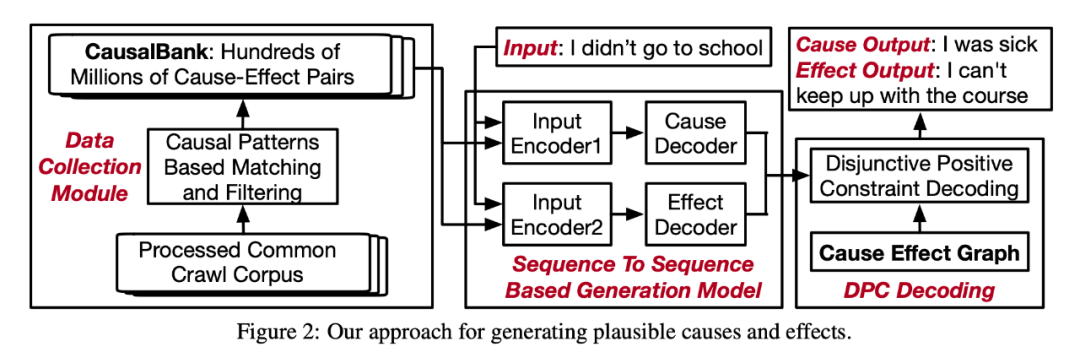

Guided Generation of Cause and Effect (IJCAI 2020)

论文作出如下贡献:

1. 提出了开放式因果生成的任务:对任意格式的文本生产出其可能的原因与结果;

2. 构造了因果数据集 CausalBank,其包含有 3.14 亿个因果对(cause-effect pairs);

3. 拓展了词法限制的解码(lexically-constrained decoding),使其支持析取正向约束(disjunctive positive constraints)。

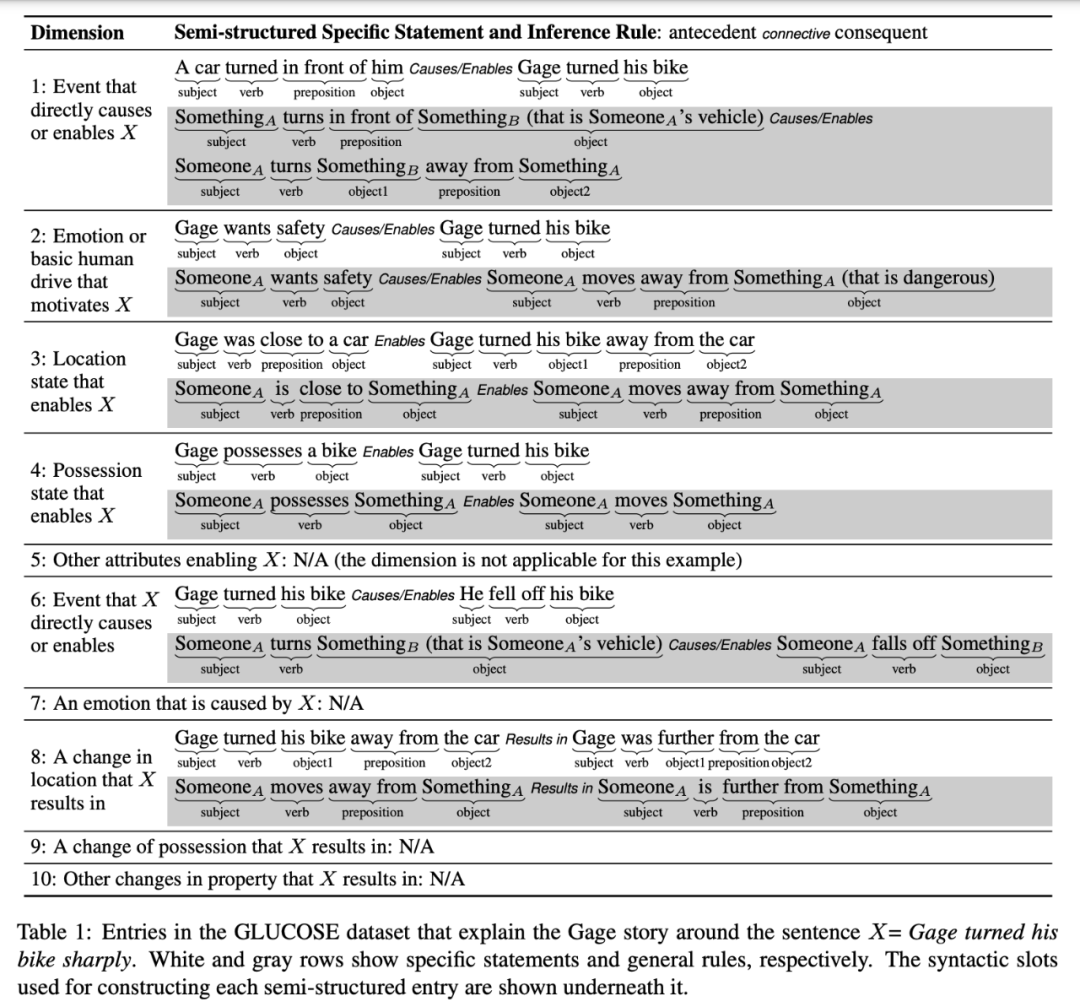

GLUCOSE: GeneraLized and COntextualized Story Explanations (EMNLP 2020)

文献介绍了 GLUCOSE 数据集,当给出一则短故事和故事中的一个句子 X,GLUCOSE 从十个维度会捕捉与 X 相关的因果解释。

这十个维度启发于人类认知心理学,覆盖了 X 通常隐含的原因和结果,如:事件、地点、所有物等等。

▲ Entries in the GLUCOSE dataset that explain the Gage story around the sentence X= Gage turned his bike sharply.

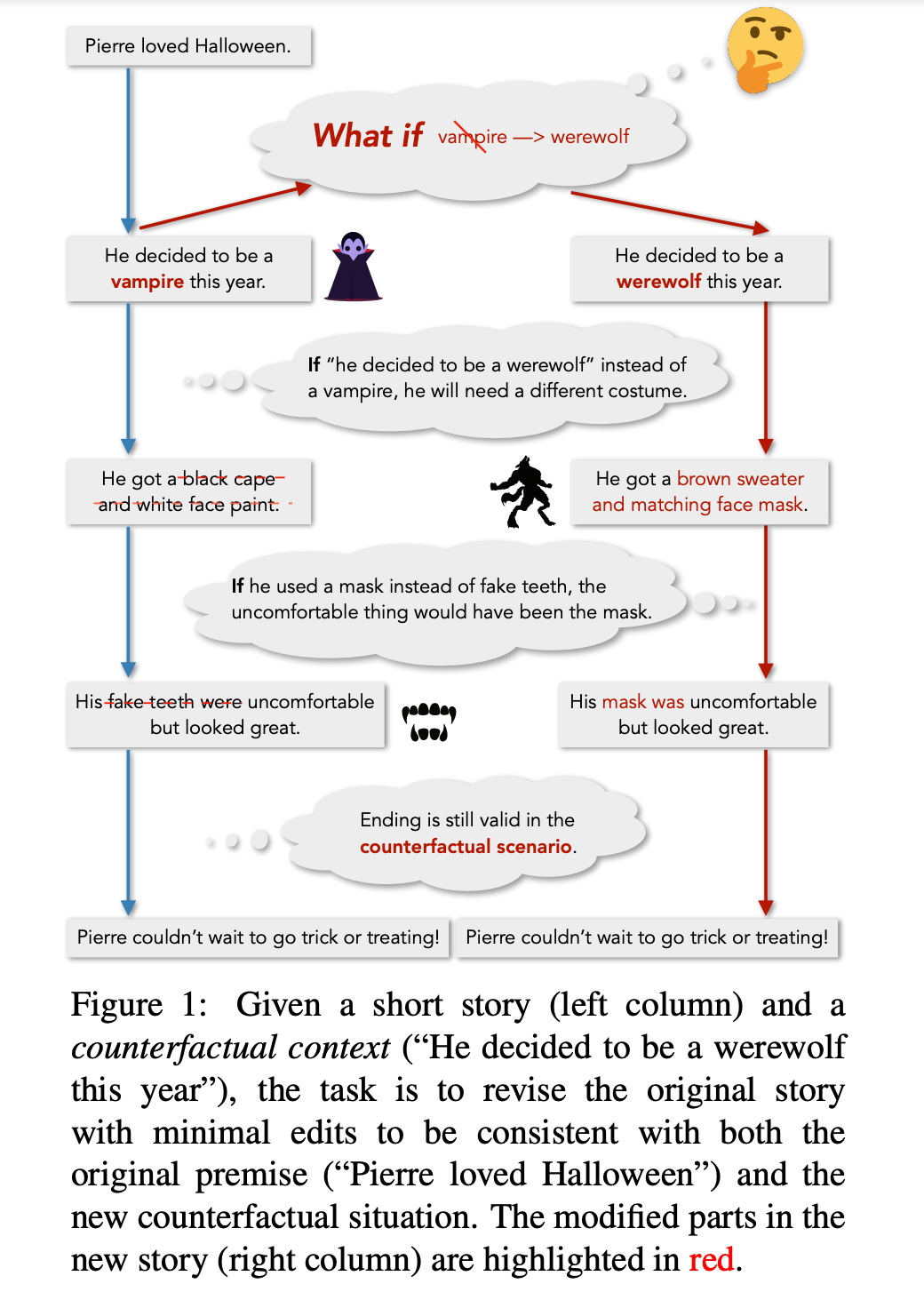

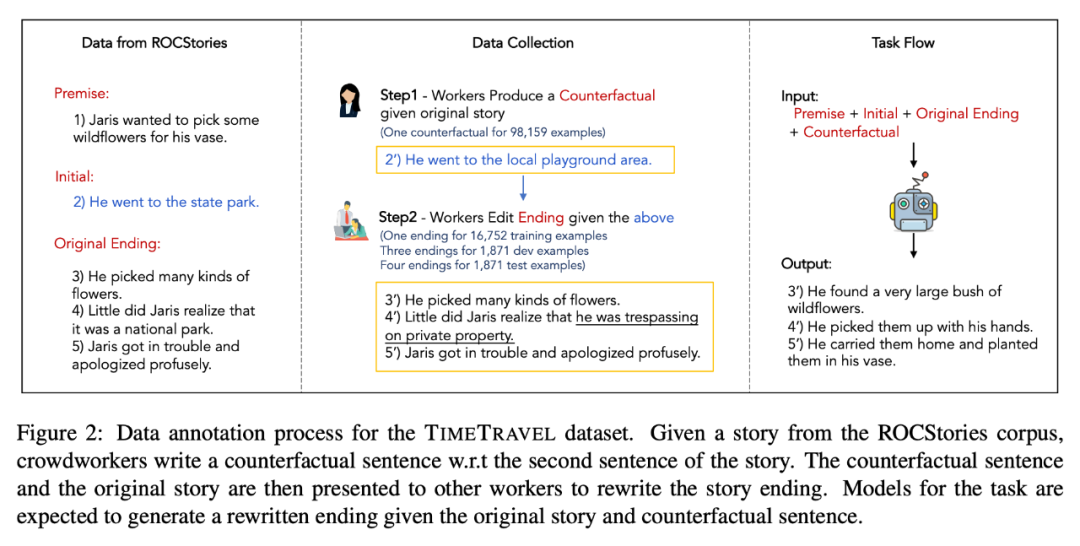

Counterfactual Story Reasoning and Generation (EMNLP 2019)

在文献中,作者提出了一个新的任务,即基于故事理解和生成的反事实故事重写(Counterfactual Story Rewriting)。

举个例子,如下图所示,左侧提供了原始故事版本,Pierre 喜欢万圣节,想要在万圣节扮演吸血鬼,因此他准备了相应的打扮,但假设 Pierre 想要扮演的是狼人,通过反事实推理,我们知道接下里的故事内容要于狼人相符。

▲ Data annotation process for the TIMETRAVEL dataset.

参考文献

[1] A Review of dataset and labeling methods for causality extraction https://aclanthology.org/2020.coling-main.133/

[2] Causal Inference in Natural Language Processing: Estimation, Prediction, Interpretation and Beyond https://arxiv.org/abs/2109.00725

[3] Uncovering Main Causalities for Long-tailed Information Extraction https://arxiv.org/abs/2109.05213

[4] Counterfactual Generator: A Weakly-Supervised Method for Named Entity Recognition https://aclanthology.org/2020.emnlp-main.590/#

[5] Counterfactual Off-Policy Training for Neural Dialogue Generation https://aclanthology.org/2020.emnlp-main.276/

[6] Identifying Spurious Correlations for Robust Text Classification https://arxiv.org/pdf/2010.02458.pdf

[7] Seeing Stars: Exploiting Class Relationships for Sentiment Categorization with Respect to Rating Scales https://aclanthology.org/P05-1015/

[8] Causal Analysis of Syntactic Agreement Mechanisms in Neural Language Models https://arxiv.org/abs/2106.06087

[9] Everything Has a Cause: Leveraging Causal Inference in Legal Text Analysis https://arxiv.org/abs/2104.09420

[10] Yake https://github.com/LIAAD/yake

[11] Guided Generation of Cause and Effect https://www.ijcai.org/Proceedings/2020/0502.pdf

[12] GLUCOSE: GeneraLized and COntextualized Story Explanations https://arxiv.org/pdf/2009.07758.pdf

[13] Counterfactual Story Reasoning and Generation https://arxiv.org/pdf/1909.04076.pdf

更多阅读

#投 稿 通 道#

让你的文字被更多人看到

如何才能让更多的优质内容以更短路径到达读者群体,缩短读者寻找优质内容的成本呢?答案就是:你不认识的人。

总有一些你不认识的人,知道你想知道的东西。PaperWeekly 或许可以成为一座桥梁,促使不同背景、不同方向的学者和学术灵感相互碰撞,迸发出更多的可能性。

PaperWeekly 鼓励高校实验室或个人,在我们的平台上分享各类优质内容,可以是最新论文解读,也可以是学术热点剖析、科研心得或竞赛经验讲解等。我们的目的只有一个,让知识真正流动起来。

📝 稿件基本要求:

• 文章确系个人原创作品,未曾在公开渠道发表,如为其他平台已发表或待发表的文章,请明确标注

• 稿件建议以 markdown 格式撰写,文中配图以附件形式发送,要求图片清晰,无版权问题

• PaperWeekly 尊重原作者署名权,并将为每篇被采纳的原创首发稿件,提供业内具有竞争力稿酬,具体依据文章阅读量和文章质量阶梯制结算

📬 投稿通道:

• 投稿邮箱:hr@paperweekly.site

• 来稿请备注即时联系方式(微信),以便我们在稿件选用的第一时间联系作者

• 您也可以直接添加小编微信(pwbot02)快速投稿,备注:姓名-投稿

△长按添加PaperWeekly小编

🔍

现在,在「知乎」也能找到我们了

进入知乎首页搜索「PaperWeekly」

点击「关注」订阅我们的专栏吧