黄家驹演唱会31年后重映,再次带火AI修复,1小时播放破亿

明敏 鱼羊 发自 凹非寺

量子位 | 公众号 QbitAI

一场没怎么预热的演唱会,在抖音直播间里火了。

开场10分钟,观看人次就突破1600万,1小时后飙升到1亿以上。

而这场演唱会,其实是从31年前穿越而来。

1991年,Beyond乐队首次登上红磡体育馆的舞台,初次登台就铸成经典。

如今,时光流转,这场演出在2022年的夏天在直播间里,通过手机屏幕和上亿人见面。

不过令人意外的是,尽管演唱会的母带已经称得上是“老古董”了,但是直播间播放的画面却没有糊成渣。

无论是黄家驹脸上细微的表情,还是黄贯中斗琴时上下翻飞的手指,歌迷们都能从手机这样的小屏幕上看得一清二楚。

△动图效果略有压缩

如此清晰的效果和细节呈现,让不少人恍惚间仿佛重回了90年代,引得歌迷直呼“Beyond精神永存!”

更值得关注的是,这种精神和情怀背后,提供核心支撑的是正在走向规模化商用的AI修复技术。

众所周知,Beyond这盘演唱会影碟录制于90年代,当时的技术设备都还十分有限。

就拿画面来说,能达到的水平只有540p、25FPS。

音质方面,也会受到现场噪声大等因素影响,最终录下的歌声也会大打折扣。

而Beyond的修复,画面和音质都达到了一种新水准。更重要的是,这场看上去工程浩大的修复,其实只花1个星期就搞定了,其中绝大部分还都是由AI“直出”的。

这种技术和效率,也让更多人潜在的情怀寄托和需求,得到释放。

是的,AI修复正在从黑科技成为日常,也是时候更清晰地了解背后的技术原理了。

“细节到眼线都看清了”

其实这几年,大众对AI修复已经不再陌生。

去年,央视动漫和上海美术电影制片厂的多部经典动画通过AI修复技术,画面清晰度可以达到4K水平。

不过和过去的一些修复工作相比,这次修复演唱会录像,AI还着重注意了这3个方面:

多帧去交错

人像修复

亮度、色彩、氛围调节

首先来看多帧去交错。

这里先要普及一个概念:什么是去交错?

早期由于设备处理速度或者带宽限制的问题,不少视频录像都是使用交错式信号。

也就是将整个画面平均分成一定数量的横行,两个场分别显示画面的奇数行和偶数行。

这样一来,设备的缓存和处理速度要求都能减半。

而利用“视觉暂留效应”,两个画面可以在快速播放过程中呈现出完整的画面。

不过,随着显示设备不断进化升级,如液晶显示器等都只支持逐行扫描。

这就导致老旧影片在新设备上播放时,会出现非常明显的闪烁。

所以,需要使用去交错的办法,来将隔行扫描的信号转换为逐行扫描信号。

传统常见的去交错方法,一般是把连续的两个场直接拼为一帧,不做任何修改。

但是每个场之间的拍摄时间还是会存在细微变化,如果这一刻拍摄物体正在移动,就会导致去交错后的图像会出现“拉丝”问题。

针对这个问题,AI这次使用的是基于运动补偿的多帧去交错算法。

和传统方法相比,这种方法的大致原理是根据邻近场使用动态估计,去预测画面中的物体移动并得到动态向量,根据前一个场及动态向量就能重建出一个新的场,然后将此两个场并完成反交错。

它的特点是泛化性更强,细节处理能力更好。

从结果来看,修复后吉他手的手部伪影完全被去除了,轮廓也清晰了起来。

第二个不同之处,便是对人像的着重修复。

演唱会录像中势必会存在大量的人像镜头,很多还是怼脸大特写,歌迷格外关注的镜头往往也是这些部分。

但受限于当年的拍摄设备水平,最终呈现的效果很容易是人和背景糊成一片,五官轮廓也不清晰。

针对这一问题,这次修复中使用了火山引擎自研的自适应人像增强算法。

这种方法基于深度学习模型,会在消除人脸整体的模糊和压缩损伤的同时,进一步对五官进行重建。

比如之前不少网友说,修复后影像里,黄家驹的眼睛都有了光、眼线都能看得一清二楚。

这就是因为算法对眼睛部分进行了重建,并补足了更多细节。

除了五官以外,这一算法还能兼顾皮肤纹理、头发丝等方面的细节处理,可以让修复后的人脸更加真实。

此外,考虑到演唱会中拍摄到表演者的脸部不只有正面,算法还考虑到侧脸、俯视、仰视、被话筒遮挡等多种情况,可以解决很多极端情况下的修复问题。

第三方面,体现在色彩亮度增强上。

据技术提供方火山引擎介绍,原片中其实存在大量过曝、死黑场景,色彩还原度也不够高。

而这些问题不是简单调节亮度或色彩就能解决的。

就拿死黑场景举例,因为影片本身还存在很严重的底噪,如果直接把偏暗场景调亮,底噪也会被同时放大。

至于色彩方面,还需要平衡好修补褪色和保留复古感两方面因素。

在这方面,火山引擎是根据具体片源的效果,依据美学评分对不同方面进行调整。

并能根据不同帧的色彩统计信息进行分区域自适应亮度增强,从而找到最佳的明暗平衡效果。

据技术人员介绍,以上几方面工作几乎都是由AI完成的,人工参与的只有一些调参部分。

甚至连对画质的评估,AI都参与了一波。

这次使用了一个针对画质的VQScore算法,对影片效果进行评估。

该算法在ICME 2021的“压缩UGC视频质量评估”比赛中,获得了“无参考视频质量评价(NR-VQA)MOS赛道”第一名。

拯救古早收音bug

视频修复方面细节拉满,不过既然是演唱会,光修复画面可不够,音质体验更是拨动观众心弦的关键。

受限于当时的技术水平和录音设备,在原版影碟中,其实存在各种各样的音质问题。

比如:

噪声干扰:设备、环境的噪声影响音质

带宽不足:设备、压缩算法等导致音频截止频率低

响度问题:响度问题导致听感不适

针对这些问题,此次火山引擎音频技术团队在Beyond演唱会的音质修复方面,主要用到了三种算法。

音频降噪算法

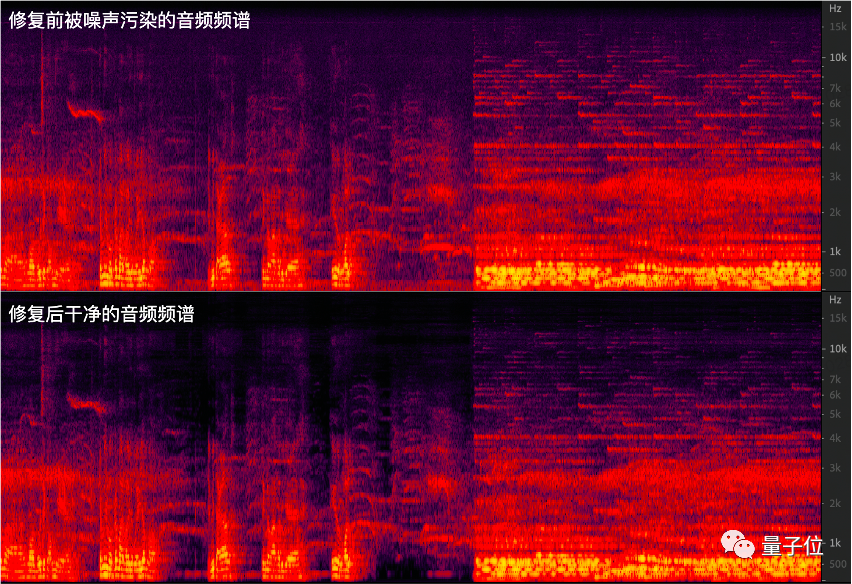

首先,来看看音频降噪算法带来的效果。

这是降噪前演唱会现场的收音:

降噪之后,效果则是这样的:

可以听出来,由于90年代演唱会收音条件有限,现场的环境又比较嘈杂,原版音频中噪声是比较明显的。

而修复之后,黄家驹的声音和音乐声变得更加清晰、干净。

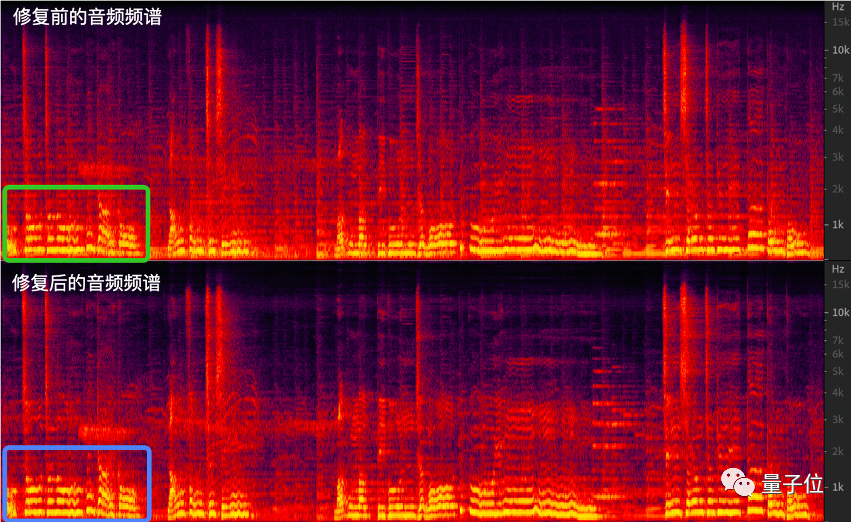

这一点在频谱图上也表现得很明显:降噪前,音频频谱较为浑浊;降噪后,频谱图清晰了不少。

值得注意的是,传统的降噪方案通常针对人声,在演唱会这样的场景里,容易“误伤”音乐本身。

因此,在为演唱会设计降噪算法之初,技术团队就将降噪导致的音乐失真问题考虑在内,通过在训练时加入音乐数据等方式,实现了对音乐场景和人声场景的兼容。

也就是说,可以在保留人的说话声、唱歌声以及音乐本身的同时,抑制其他噪声。

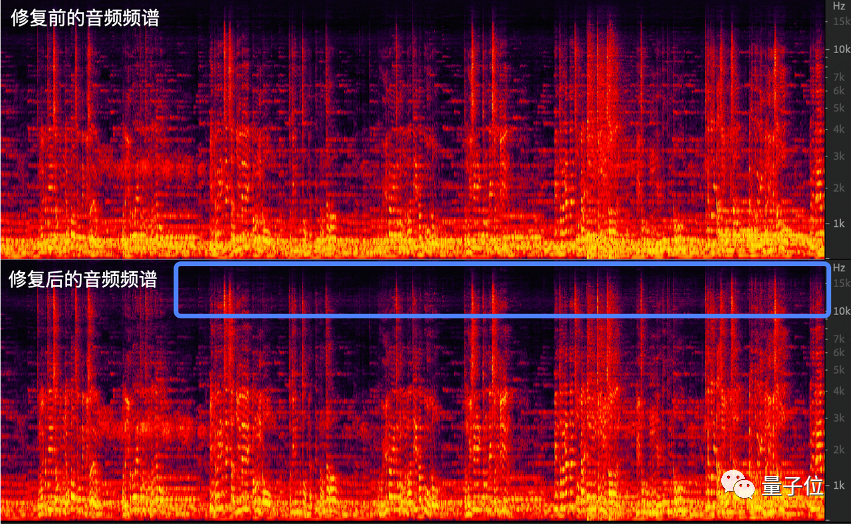

音频超分算法

噪声之外,由于演唱会拾音设备、录制硬件以及存储压缩等技术原因,声音带宽受损(即带宽变窄)同样会影响听觉体验。

因此,修复团队还引入了音频超分算法。

该算法主要对演唱会中人声的部分进行了频带拓展,以使人声更加清晰。

从蓝框部分可以看到,经过超分,原始音频的高频部分得到了拓展和增强。

响度算法

最后,是通过音源分离算法提取演唱会中歌声的部分,然后用响度算法对响度进行调整。

这是因为演唱会现场拾音的过程中,可能会出现人唱歌的声音被乐器、环境声盖住的情况。

单独提取唱歌部分的人声,进行响度调整,然后再与原音频混合,能够使整体的声音大小听上去更加舒适。

一个幕后小故事是,无论是画质修复还是音频修复,都需要人工来进行最终质量评估。

而修复团队的程序员们恰好都是听着《海阔天空》、《光辉岁月》长大的一群人。

因此处理Beyond演唱会的旧影像时,修复人员们都是以粉丝的心态,一遍又一遍不断地去听、去看修复效果,力图用算法把当年红馆的热烈氛围在今日重现。

他们的标准说起来也很简单:

我得先觉得身临其境了。

另外,值得一提的是,修复人员谈到,本次修复基本都是AI搞定的。目前,这样的技术能力已经被集成到火山引擎对外开放的智能处理、音频技术两个产品中。

AI修复技术的B/C面

当一场场线上怀旧演唱会在网上掀起热潮,AI修复技术也再一次成为技术热点。

并且在一次次的“出圈”之中,这类“网红”技术的发展路径和商业化前景,逐渐清晰明朗起来。

第一阶段,是新兴技术的探索期。

在这个阶段,老片修复的相关技术手段从实验室走向民间。以B站up主大谷的视频为代表的个人修复作品,屡屡吸足眼球,引发热议。

△大谷修复作品

伴随着云与AI的进一步结合,各大科技厂商开始把“网红”引入家门,这也就开启了AI修复技术的第二阶段:技术工业化进程中的试验期。

这时候,开始有更多工业级的修复项目出现在大众眼前,但仍旧有“单个项目、单点突破”的特点。

比如此前西瓜视频和火山引擎推出的“经典视频4K修复计划”,就是通过工业化的AI技术手段,成批量地修复《哪吒传奇》、《黑猫警长》等百部经典动画。

而现在,你或许不知道的是,这样的技术不再仅仅停留在公益项目、To B产品的阶段,甚至打开抖音,你也能用上。

比如画质修复的相关算法,就已经被集成到抖音个人用户的作品发布功能当中。即使没有专业的拍摄设备,用户投稿的作品经过AI针对清晰度、色彩、瑕疵、失真等问题的自动修复,也能达到不错的效果。

由此可见,在长期的技术积累与实践之后,AI修复技术作为一种成熟技术产品的第三阶段——大规模商用落地,或许已经拉开帷幕。

尤其对于字节跳动这样的厂商而言,其旗下拥有抖音等每天都会产生海量音视频UGC内容投稿的平台。

从修复动画到Beyond演唱会,一系列技术问题的突破和解决,最终都会直接在产品层面上有所体现。

并且不仅在云这一侧面向B端,也已经在C端显现出潜能。

实际上,这也是AI技术不断普惠、下放过程中的一个典型案例。

咱们作为普通用户,受益其中,自然喜闻乐见。

说说你最希望AI修复的“老东西”吧?

— 完 —

「人工智能」、「智能汽车」微信社群邀你加入!

欢迎关注人工智能、智能汽车的小伙伴们加入我们,与AI从业者交流、切磋,不错过最新行业发展&技术进展。

ps.加好友请务必备注您的姓名-公司-职位哦~

点这里👇关注我,记得标星哦~

一键三连「分享」、「点赞」和「在看」

科技前沿进展日日相见~