欧盟发布最新《人工智能道德准则》,能保证我们信赖AI吗?

作者 |

张涛 学术plus高级评论员,专注研究人工智能产业技术与网络信息安全

欧盟委员会于本月8日发布了正式版的人工智能道德准则《ETHICS GUIDELINES FOR TRUSTWORTHY AI》(可信赖AI的伦理准则),提出了实现可信赖人工智能全生命周期的框架。

该准则由欧洲人工智能高级别专家组(High-Level Expert Group on Artificial Intelligence,AI HLEG)起草。AI HLEG由欧盟委员会2018年4月任命的专门负责撰写人工智能道德准则并为欧盟提供政策和投资建议的小组,包括52位代表学术界、工业界和民间社会的独立专家。

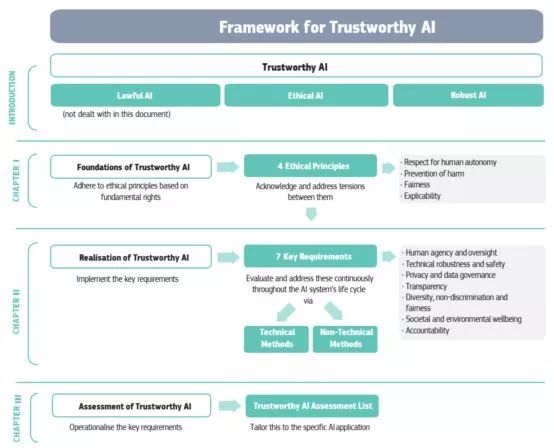

1. 报告将从三个方面分析“可信赖AI全生命周期框架”分别为:三个基本条件、可信赖AI的基础、以及可信赖AI的实现。

2. 提出四项伦理准则:尊重人自主性、预防伤害、公平性和可解释性。

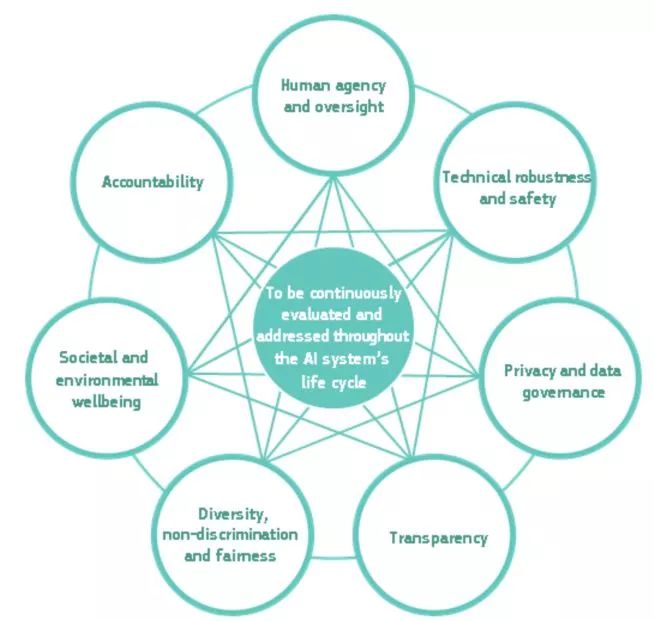

3. 实现可信赖AI的七个关键要素:人的能动性和监督;技术鲁棒性和安全性;隐私和数据管理;透明性;多样性、非歧视性和公平性;社会和环境福祉;问责。

全生命周期框架

-1-

三个基本条件

准则的目标是推进可信赖AI(Trustworthy AI)的发展。可信赖AI在系统的全生命周期中需要满足三个条件:

1.合法的(lawful)。系统应该遵守所有适用的法律法规;

2.合伦理的(ethical)。系统应该与伦理准则和价值观相一致;

3.鲁棒的(robust)。不管从技术还是社会的角度来看,AI系统都可能会造成伤害。所以系统中的每个组件都应该满足可信赖AI的要求。

-2-

可信赖AI的基础:四条伦理准则

根据国际人权法律、欧盟条约和欧盟宪章,专家组提出了AI系统应该涵盖的基本权利,其中有些权利在欧盟是法律强制执行的,因此保证这些权利也是法律的基本要求,包括:尊重人的尊严(Respect for human dignity),个人自由(Freedom of the individual),尊重民主、正义和法律规范(Respect for democracy, justice and the rule of law),平等、不歧视和团结(Equality, non-discrimination and solidarity)、公民权利(Citizens’ rights)。

包括:尊重人的自主性(respect for human autonomy)、预防伤害(prevention of harm)、公平性(fairness)和可解释性(explicability)。

伦理准则1:尊重人的自主性。AI系统不应该、胁迫、欺骗、操纵人类。相反,AI系统的设计应该以增强、补充人类的认知、社会和文化技能为目的。人类和AI系统之间的功能分配应遵循以人为中心的设计原则,而且AI系统的工作过程中要确保人的监督。AI系统也可能从根本上改变工作领域。它应该在工作环境中支持人类,并致力于创造有意义的工作。

伦理准则2:预防伤害。AI系统不应该引发、加重伤害,或对人类产生不好的影响。因此需要保护人类的尊严和身心健康。AI系统和运行的环境必须是安全的(safe and secure)。因此要求技术上必须是鲁棒的,而且要确保AI技术不会被恶意使用。尤其要注意可能会恶意使用该技术的人和可能会造成不良影响的应用场景。

伦理准则3:公平性。AI系统的开发、实现和应用必须是公平的。虽然对公平性可能会有不同的解读,但是应当确保个人和组织不会受到不公平的偏见、歧视等。如果AI系统可以避免不公平的偏见,就可以增加社会公平性。为此,AI系统做出的决策以及做决策的过程应该是可解释的。

伦理准则4:可解释性。可解释性对构建用户对AI系统的信任是非常关键的。也就是说整个决策的过程、输入和输出的关系都应该是可解释的。但目前的人工智能算法和模型都是以黑盒(black box)的形式运行的。

-3-

可信赖AI的实现:七个关键要素

专家组提出了AI系统应该满足的7个关键要素以达到可信赖的要求,分别是:人的能动性和监督(Human agency and oversight),技术鲁棒性和安全性(technical robustness and safety),隐私和数据管理(privacy and data governance),透明性(transparency),多样性、非歧视性和公平性(diversity, non-discrimination and fairness),社会和环境福祉(societal and environmental wellbeing),问责(accountability)。

要素1:人的能动性和监督。AI系统应通过支持人的能动性和基本权利以实现公平社会,而不是减少、限制或错误地指导人类自治。

1.1人类监督 人类的监督可以帮助确保AI系统不影响人类自主或产生不良的后果。监督可以通过不同的管理机制来实现,包括human-in-the-loop (HITL)、human-on-the-loop (HOTL)、human-in-command (HIC)等方法。根据AI系统应用领域和潜在的风险,可以实现不同程度的监督机制以支持不同的安全和控制措施。

要素2:技术鲁棒性和安全性。可信赖的AI系统的关键部分就是技术鲁棒性,这与防止伤害的原则是紧密相关的。技术鲁棒性要求算法足够安全、可靠和稳健,以处理AI系统所有生命周期阶段的错误或不一致。

2.1抵御攻击和安全性。AI系统应该防止被黑或出现可以被攻击的漏洞。攻击可能是针对模型的、也可能是针对数据的、也可能是针对底层基础设施的,包括软件和硬件。如果AI系统被攻击,其中的数据和系统行为可能会被修改,导致系统产生不同的决策(结果)。

2.2备用计划和通用安全(safety)。AI系统应该有出现紧急情况的备用方案。也就是说AI系统可能从基于统计的决策转为基于规则的决策,或者要求询问人类操作者才可以继续(如自动驾驶汽车)。必须保证系统所作的一切都不会对用户和环境造成伤害。

2.3准确度。准确度是指AI系统能够做出正确判断和决策的能力。良好的开发和评估过程可以支持、缓解和纠正出现不准确的预测的非故意风险。如果偶尔的不准确的预测不可避免,那么系统应该要能计算这种错误情况发生的概率。在可能会对人类生命安全带来影响的AI系统中,准确度的要求是非常重要的,比如自动驾驶和在刑事司法领域的应用。

2.4可靠性和可重现性。AI系统的结果必须要是可重现的和可靠的。对AI系统进行详细检查以防产生意外的伤害。可重现性是指科学家和政策制定者要能够准确地描述AI系统的行为。

要素3:隐私和数据管理。公民应该完全控制自己的数据,同时与之相关的数据不会被用来伤害或歧视他们。

3.1隐私和数据保护。AI系统必须确保系统的整个生命周期内都要确保隐私和数据保护。这既包括用户提供的信息,也包括用户在和系统交互过程中生成的信息。同时要确保收集的数据不会用于非法地或不公平地歧视用户的行为。

3.2数据质量和完整性。数据集的质量对AI系统的性能非常关键。收集的数据可能是含有偏见的、不准确的、有错误的。这些数据在用于训练之前要进行清洗,去除这些有偏见的、不准确的、有错误的数据。同时还要确保数据的完整性。如果给AI系统的数据是恶意的就可能会改变系统的行为。在规划、训练、测试和实现的整个过程中都要对数据集进行测试和处理。

3.3对数据的访问。在处理个人数据时,都会用到管理数据访问的数据协议。协议应该列出谁以及什么情况下可以访问数据。

要素4:透明性。应确保AI系统相关元素的可追溯性,包括数据、系统和商业模型。

4.1可追溯性。AI系统产生决策使用的数据集和过程都应该记录下来以备追溯,并且应该增加透明性,具体包括收集的数据和算法使用的数据标记。可追溯性包括可审计性和可解释性。

4.2可解释性。可解释性就是要解释AI系统的技术过程和相关的决策过程。技术可解释性要求AI做出的决策是可以被人们所理解和追溯。在AI系统会对人类的生命造成重大影响时,就需要AI系统的决策过程有一个合理的解释。

4.3通信。人类有权知道与其通信的是人类还是AI系统,这就要求AI系统是可被识别的。

要素5:多样性、非歧视性和公平性。AI系统应考虑人类能力、技能和要求的总体范围,并确保可接近性。该需求与公平性原则是紧密相关的。

5.1避免不公平的歧视。AI系统使用的数据集可能会不可避免的存在歧视、不完整和管理不当等问题。这类数据集的歧视可能会造成AI系统的针对特定人群或个人的歧视。AI系统开发的方式也可能会出现不公平的歧视问题,可以通过以一种明确和透明的方式来分析和解决系统的目的、局限性、需求和决策来解决。

5.2辅助功能和通用设计。尤其在B2C领域,系统可能是用户为中心的,以一种允许所有人都平等地使用AI产品和服务的方式,即无论年龄、性别、能力和其他特征。因此针对残障人士的辅助功能就显得格外重要,AI系统的设计不应该采用一种通用的设计。

5.3相关利益方参与。为了开发出可信赖的AI系统,建议对受系统直接或间接影响的利益相关方进行咨询。

要素6:社会和环境福祉。应采用AI系统来促进积极的社会变革,增强可持续性和生态责任。

6.1可持续和环境友好型AI。AI系统是为了解决一些最迫在眉睫的社会难题,同时要保证尽可能地以环境友好型的方式出现。系统的开发、实现和使用过程,以及整个供应链都应该进行这方面的评估。

6.2社交影响。AI系统在社会生活各领域的应用可能会改变我们对社会机构的理解,影响我们的社会关系。AI在增强我们的社交技能的同时,可能也会减弱我们的社交技能,这会对人们的身心健康带来影响。

6.3社会和民主。同时要考虑评估AI应用对民主、社会的影响,因为AI系统极有可能应用于政治决策和选举相关的民主进程中。

要素7:问责。应建立机制,确保对AI系统及其成果负责和问责。

7.1可审计性。可审计性包含了对算法、数据和设计过程的评估,这并不意味着与AI系统相关的商业模型和知识产权需要公开。通过内部和外部审计者的评估,加上评估报告可以验证该技术的可信赖性质。在影响基本权利的应用中,AI系统应该进行独立审计,比如与人身安全(safety)相关的应用。

7.2最小化负面影响。识别、评估、记录、最小化AI系统的负面效应对AI应用是非常重要的。涉及开发、应用和AI系统使用的影响评估可以帮助减少负面影响。

-4-

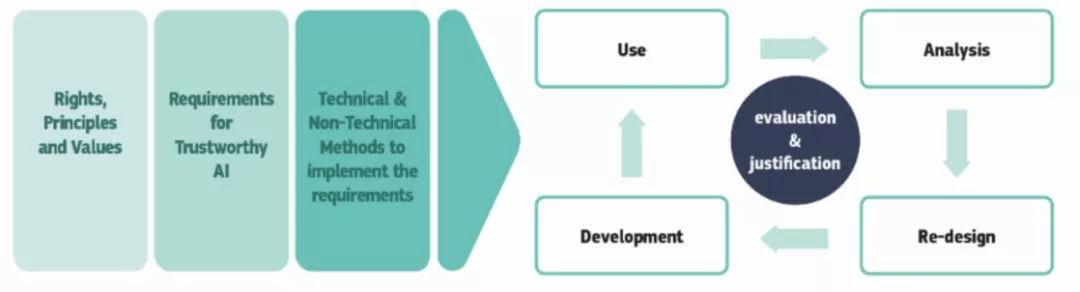

可信赖AI的实现:技术和非技术方法

可信赖AI的实现是一个持续的过程,覆盖AI系统的全生命周期,使用的方法包括技术方法和非技术方法,如下图所示:

技术方法包括:实现可信赖AI的技术方法覆盖AI系统的设计、开发和使用的全生命周期中,具体包括:构建可信赖AI架构;设计中融入伦理和法律要求;解释方法;测试和验证;服务质量指标。非技术方法包括:监管(管理);行为准则;标准;认证;通过管理框架进行审计;通过教育培养伦理观;利益相关方参与和社会对话;多方参与设计。

报告目录

原文发表于学术plus

--END--