导师分配强化学习方向,看了几个月论文,还是非常迷茫……

最近几年来,人工智能领域热门话题层出不穷,强化学习应该算是其中相当热门的领域了。

作为近些年创新的热点领域,不仅控制领域的大拿在关注强化学习,计算机大类的导师们也在积极利用强化学习来完成一些场景创新。

(百说不厌的创新点)

(为了论文现在入坑强化学习还来得及吗?)

不难看出,强化学习的研究现阶段在学术界还很热门,毕竟通俗一点说,深度学习总需要一个应用场景,而RL可以拓展DL的场景有很多。

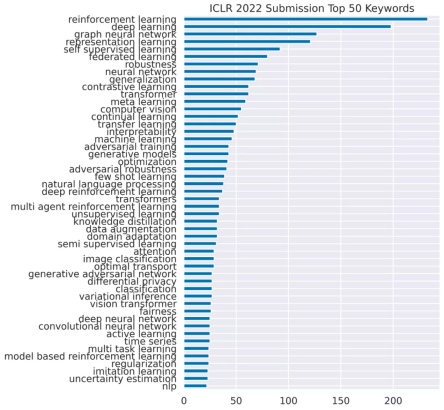

作为AI技术发展的风向标,计算机领域各大顶会一直备受关注,而近年来相关领域内,各大顶会中强化学习方向论文投递和收录均名列前茅。

以ICLR 2022为例,强化学习(Reinforcement Learning)论文投递数量位居第一,且远高于其他方向论文!

这说明两点:

一、强化学习方向正是研究热门;

二、这个方向容易产出论文;

有同学就把近年来顶会中强化学习方向的论文全都下载整理好,花了好一番力气,然而论文读不通,也无法总结出对自己的科研和论文有帮助的点。

某乎上就有同学陷入了这样的困境 ⬆️ ,在导师放养的情况下,如果没有一个领域内的专家帮忙梳理和指点,确实很难短时间走出困境。

因此,8月16、17日晚19:30,我们特邀请一位强化学习大神,直播为大家拆解顶会论文炼成全过程。

强化学习方向大神亲自拆解

顶会论文炼成全过程

添加老师微信获取听课地址+最新论文合集(含代码)

03.掌握深度学习解决多智能体协作任务,自动驾驶特征抽取器的原理与使用

在计算机领域,顶级会议论文对学生的重要性不言而喻。这个人人内卷的时代,是否具有科研背景和学术能力已经成为考研、保研、录取名校的关键考察项。而手握一篇甚至多篇高质量的论文,就是学术成果最好的展现。它意味着高额的奖学金、名校入学机会……

当然如果为了未来更优质的工作,含金量高的顶会论文更是不可或缺,毕竟如果以进大厂为目标,手握几篇高质量的论文是敲门砖之一。

对于大部分的科研党来说,大部分人的难题不是不想发,而是……

论文读不通、读不懂,

无法在科研和论文能力上获得积累,

导师不能及时给出指导,

不知道怎么写论文;

不知道怎么确定选题;

不知道怎么凝练创新点;

不知道idea在哪里?

……

你需要的不是喊你回头是岸的高僧,你需要的是一位科研路上的领路人。很多同学的问题不是自己没有科研的能力,而是缺少一双为自己拨开迷雾的手。

想要能够快速发论文有两点至关重要。

一、紧跟风口。

想发文章最容易的方法就是紧跟风口,顺着领域内的研究趋势确定自己的方向,毕竟在热门领域内,创新和idea远比其他非热门领域多。

比如,选择当下的热门强化学习。现在入坑还来得及!

二、有一位有经验有能力的前辈指导。

大家都在努力的设计新网络、新策略、新training算法,只要能够在某一问题上做到一个很好的porfermance,论文就水到渠成。而想要快速达到,旁人的指点不可或缺。

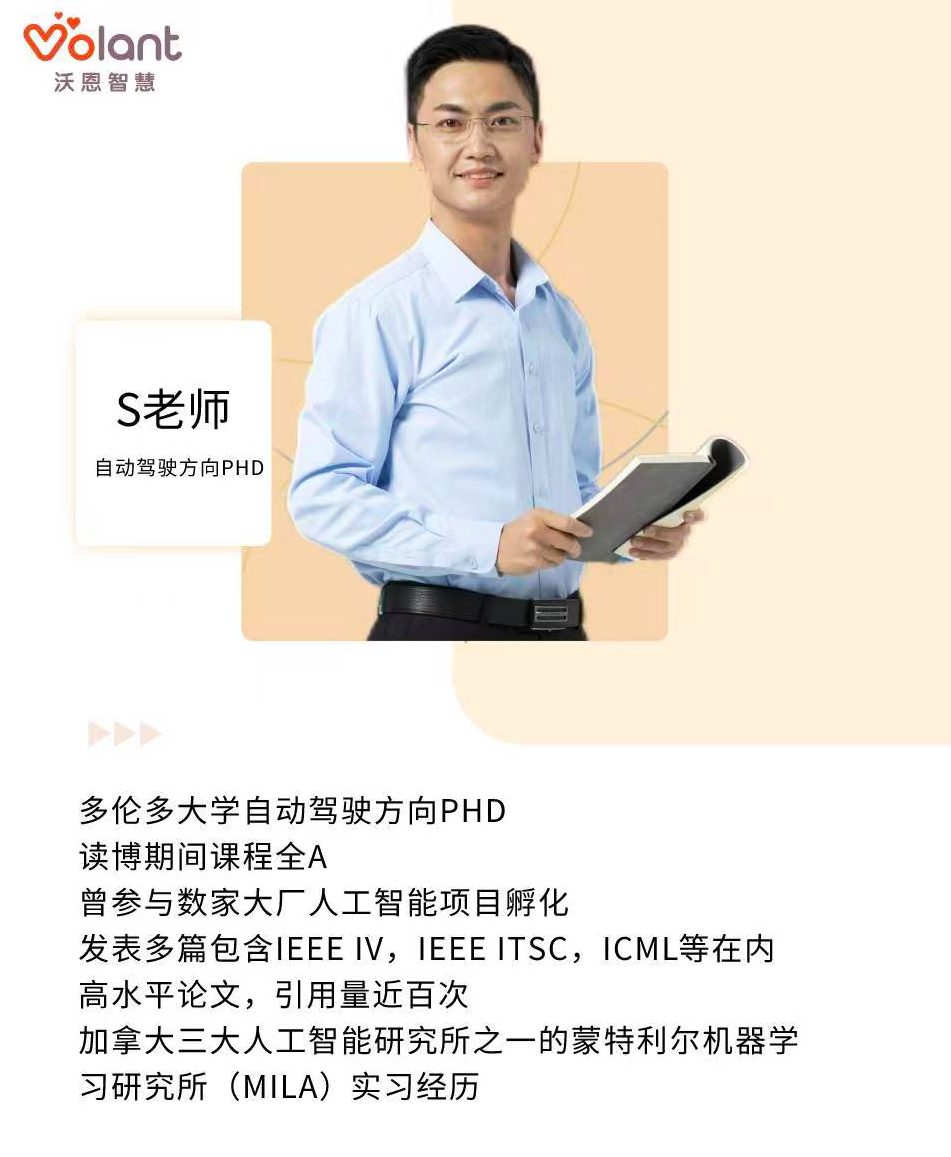

沃恩智慧特别邀请强化学习方向大神、顶会论文的第一作者、顶会审稿人,来和大家讲讲,强化学习方向顶会论文炼成全过程~

(悄悄透露,这位公开课老师,已经指导多名学员的论文写作,认真耐心,很多学员经老师指点已经发出高水平论文)

想要快速发论文,想要get idea的同学,快快扫码联系老师~

强化学习方向大神亲自拆解

顶会论文炼成全过程

添加老师微信获取听课地址+最新论文合集(含代码)

有了好的idea,论文就成功了一大半。

而顶会论文对于有创新性的idea,尤为看重。

要想从科研小白变身科研大神,这是一个必须要跨过去的门槛。

强化学习作为当前的研究热门,创新点和idea更加不可或缺。

8月16、17日,晚上19:30,

快快扫码预约,和学术大神聊聊你在科研上的困惑~~

讲师介绍 ⬇️

强化学习方向大神亲自拆解

顶会论文炼成全过程

添加老师微信获取听课地址+最新论文合集(含代码)