DeepFake捏脸真假难辨,汤姆·克鲁斯比本人还像本人!

![]()

新智元报道

新智元报道

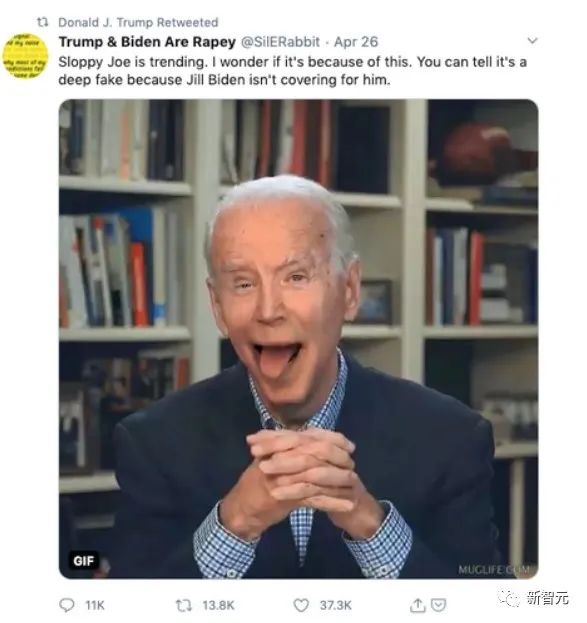

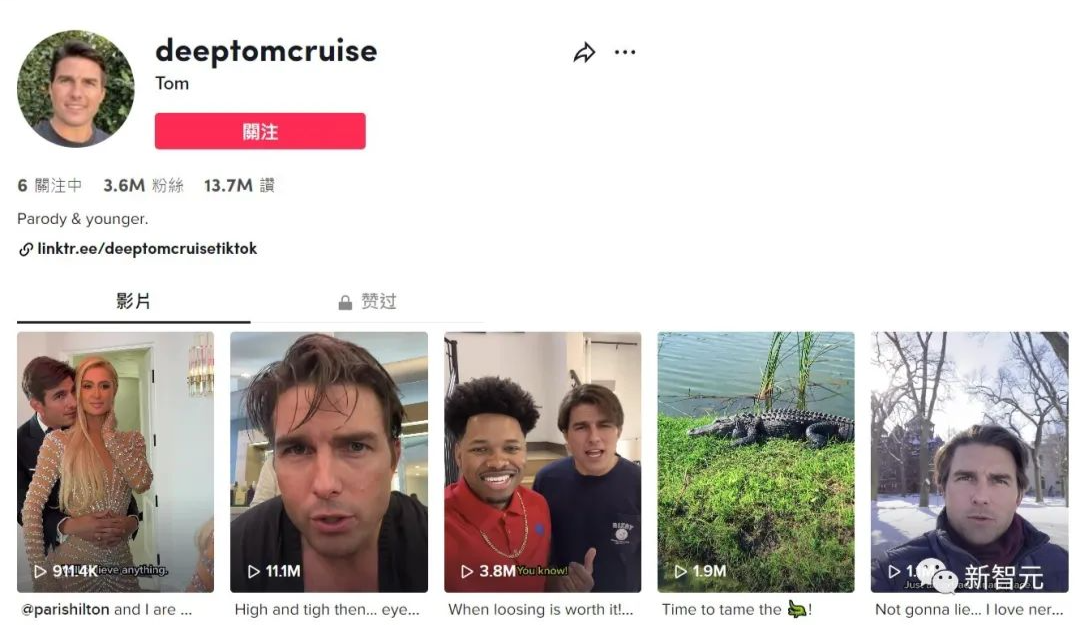

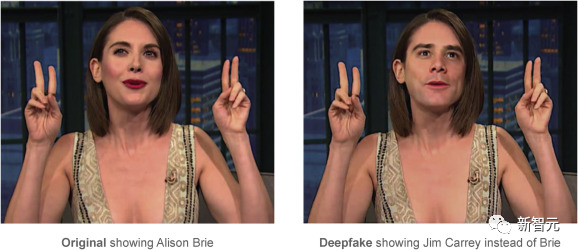

【新智元导读】在网上,不断冒出的Deepfake视频让人们难辨真假。Tiktok上的假汤姆·克鲁斯已经拥有了360万粉丝。Deepfake的门槛变低,也带来了源源不断的问题……

错的不是技术,而是人

Deepfake很容易,立法很难

我们能做什么?

登录查看更多

相关内容

Arxiv

0+阅读 · 2022年9月19日