铰接物体在我们的生活中无处不在。全面理解这些铰接物体的外观、结构、物理性质和语义,对于研究社区是大有助益的。

目前的铰接物体理解方法通常是基于不考虑物理特性的 CAD 模型的合成物体数据集,这不利于视觉和机器人任务中从仿真环境到实际应用的泛化。

为了弥补这一差距,我们提出了AKB-48:一个大规模的铰接物体知识库,它包含 48 个类别的 2,037 个真实世界中的三维铰接物体模型。

我们通过铰接知识图谱 ArtiKG 描述每个物体。为了构建 AKB-48,我们提出了一个快速铰接知识建模流程(FArM),可以在 10-15 分钟内构建铰接物体的 ArtiKG,在很大程度上降低了在现实世界中对物体建模的开销。在该数据的基础上,我们提出了一个新颖的集成网络框架 AKBNet,用于类别级的视觉铰接操作(C-VAM)任务。我们提出了三个对比基准子任务,即姿态估计,物体重建和控制。

https://arxiv.org/pdf/2202.08432v1.pdf

https://liuliu66.github.io/articulationobjects/

铰接物体是由多个关节连接的刚性部分组成的,可以在三维空间中进行旋转或平移运动。有关铰接物体的知识对于许多研究社区(如计算机视觉、机器人和具身人工智能)都是有所助益的。现有的铰接物体数据集包括 PartNet-Mobility、ReArt-48、RBO 等。

然而,这些数据集大多更加关注结构信息(例如,部位分割、运动结构),但是很少注意外形(例如,纹理、细致的几何信息),也很少注意物理特性(例如,每个部位的质量、惯量、材料和摩擦力),也很少涉及语义(例如,类别、功能可供性)。然而,有一些重要的任务非常依赖于这些信息,例如:目标检测依赖于「纹理」,三维重建依赖于「细致几何信息」,目标控制依赖于「物理特性」,缺乏这些物体知识不利于学习模型的泛化。

为了推动对铰接物体的研究,本文提出了 AKB-48:一个包含 48 个类别、2,037 个实例的大规模真实铰接知识库。对于每个实例,我们根据相应的真实物体扫描出物体的模型,并手动细化。物体知识会被组织到一个铰接知识图谱(ArtiKG)中,它包含各种物体属性和特征的详细标注。为了在大数据集上进行扫描和标注,我们提出了快速铰接知识建模(FArM)流程。

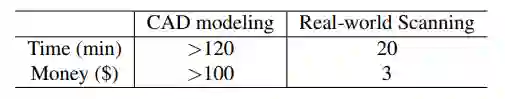

具体而言,我们利用三维传感器和转台、集成了结构和语义标注的 GUI、用于物理属性标注的标准真实世界实验开发了一个物体记录系统。该系统节省了大量用于建模现实世界铰接物体的时间和金钱和成本(每个物体的标注成本为 3 美元,耗时 10-15 分钟)。本文对比了 CAD 建模与反向扫描。总而言之,该流程的资金和时间预算分别仅为前者的 1/33 和 1/5。

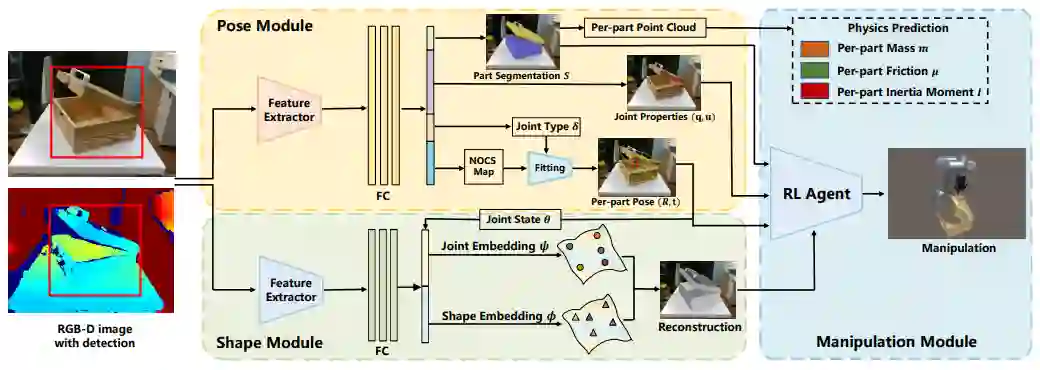

我们利用 AKB-48 数据集提出了AKBNet,这是一种用于类别级视觉铰接控制(C-VAM)任务的新型集成架构。为了解决 C-VAM 任务,视觉系统 AKBNet 需要能够估计物体的姿态,重建物体的几何形状,并在推理类别级的控制策略。因此,它由三个感知子模块组成:

(1)用于类别级铰接物体姿态估计的「姿态模块」:该模块旨在估计某类中未曾见过的铰接物体的每个部位的 6D 姿态。然而,以往的研究通常针对于运动类别,定义某个类别的物体具有相同的运动结构。我们的姿态模块将「类别」的概念扩展到「语义类别」,同一类物体可以具有不同的运动结构。

(2)用于铰接物体重建的「形状模块」:获得姿态后,我们再对输入图像进行形状编码,重建每个部位的形状。完整的几何信息对于决定在哪里进行交互控制至关重要。

(3)用于铰接物体控制的「控制模块」:通过感知获得铰接信息(例如,部位分割、各部位姿态、铰接属性、完整网格)后,就可以根据观察结果推断出交互策略。我们设置了「打开」和「拉动」的操作任务,分别对应于转动铰接和移动铰接。

针对每个模块评估时,我们假设模块的输入是上一个模块的 Ground Truth。针对整个系统评估时,输入是上一个模块的输出。显然,我们不能对 AKB-48 支持的所有任务进行基准测试。我们希望它能成为未来计算机视觉和机器人领域中的铰接研究的良好平台。

(1)提出了 AKB-48 数据集,它包含 48 个类别的 2,037 个铰接模型,我们采用了一个多模态知识图 ArtiKG 来组织丰富的标注信息。该数据集有助于缩小当前的视觉和具身人工智能研究之间的差距。据我们所知,这是第一个从现实世界收集到的具有丰富标准信息的大规模铰接数据集。

(2)提出了一种快速铰接知识物体建模流程 FArM,使得从现实世界中收集铰接物体信息更加容易。在构建真实世界的三维模型数据集时,该流程可以大大降低时间和金钱成本阿。

(3)提出了一种用于整体类别级视觉铰接操作(C-VAM)任务的新型架构 AKBNet。实验表明,该架构的各个部件和整体模型在现实世界中是有效的。

在构建知识库时,我们需要回答三个问题:(1)我们应该标注物体的什么类型的知识?(2)我们应该标注什么物体,物体来自真实世界还是模拟世界?(3)如何高效地标注物体知识?

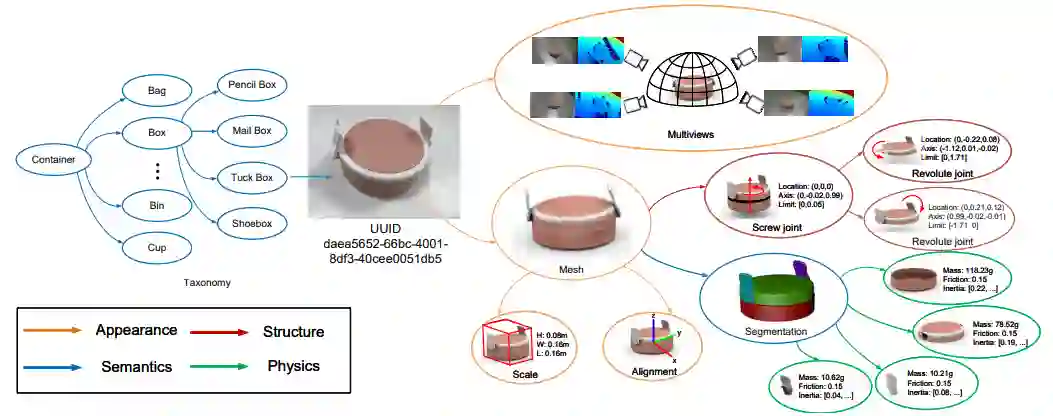

不同的任务需要不同种类的物体知识,为了统一标注的表征,我们将其组织成一个多模态知识图谱 ArtiKG。ArtiKG 由四个主要部分组成,即外观、结构、物理属性和语义。

图注:AKB-48 数据集中定义的铰接只是图谱(ArtiKG)。

我们将每个实例的形状与网格数据结构以及纹理存储在一起。从现实世界中扫描对象时,我们也会收集对象的多视图 RGB-D 快照。

铰接物体和刚体物体的关键区别在于运动结构。被铰接的物体有关节和部位这样的概念,这些概念对于刚体来说是没有意义的。对于每个关节,我们标注了关节的类型、参数和运动限制。对于每个部位,我们将每个运动部位分割出来。

在对基本的几何和结构信息进行标注之后,我们以从粗到细的过程为物体赋予语义信息。我们为每个实例赋予了一个 uuid。接着,我们根据 WordNet 为物体分配类别。此外,我们还标记了部位的语义。虽然我们已经标注了运动学上的部位,但它与语义部位并不完全相同。以带把手的马克杯为例,把手并不是通过关节附着在马克杯本体上,因此它不是一个运动学上的部位,而是一个语义上的部位,因为它表明了人类通常抓取马克杯的位置。

真实的物体存在于物理世界中,通常具有物理属性,这对于精确仿真、真实世界中的控制和铰接物体的交互是很重要的。因此,我们为模型存储物理属性的标注,包括每个部位的质量、惯量、材料和表面摩擦力。

本文从标注的准确性、时间和金钱成本两个方面对比真实世界扫描和 CAD 建模。

根据 ArtiKG 的内容,我们可以看到,相较于 CAD 建模,从真实世界中扫描的物体具有很多优势(例如,外观和物理性质)。但不可否认的是,CAD 模型可以模拟内部结构,而扫描技术更多地关注物体表面。幸运的是,大多数日常用品都可以拆卸,所以扫描技术可以很好地处理它们。

在研究新的类别或运动学结构时,ShapeNet 类型的模型收集范式局限于构建手工 CAD 模型所需的大量时间和金钱成本。另一方面,日常生活中,许多铰接物体价格偏移,可以被外行人扫描。就 CAD 而言,淘宝上的外包服务价格如下表所示(单位:美元)。

为了高效收集现实世界的铰接模型,我们设置了一个如下图所示的记录系统:

图注:(1)用于多尺度物体的旋转转台(2)是一个跟踪标记(3)吸光项(4)升降支架(5)Shining 3D 扫描仪(6-8)用于捕获多视图物体数据的英特尔 RealSenseL515相机。

我们为标注开发了一个铰接物体建模的三维 GUI。建模过程包含三个部分:物体对齐、部位分割、关节标注(详情请参阅原文)。

现实世界中的铰接物体存在于物理世界中,具有物理属性。为了使 AKB-48 可以被用于现实世界的机器人控制和交互任务,我们还为铰接物体的每个部分标注了以下物理属性:各部位质量、各部位惯性力矩、各部位材料和摩擦力。

在构建 AKB-48 数据集的过程中,我们考虑了以下要求:(1)通用性。AKB-48 能够涵盖日常生活中常见场景中的大部分铰接物类别。(2)多样性。每个类别中的物体有各种各样的形状,形变能力、纹理和运动结构。(3)用例。所选物体应该包含各种使用上的功能。此外,完成控制性能的能力是需要优先考虑的。

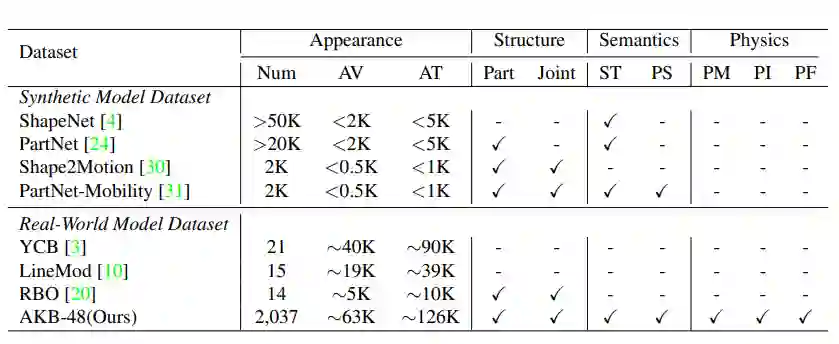

我们的 AKB-48 数据集在 ArtiKG 中提供了四种丰富的标注信息:外观、结构、语义和物理属性。AV:平均顶点数。AT:三角形的平均数目。ST:语义分类。PS:各部位语义标签。PM:各部位质量。PI:各部位惯性力矩。PF:各部位的摩擦力。

AKBNet 是一个用于 C-VAM 任务的集成架构。AKBNet 的输入是单张带有检测到的二维边界框的 RGB-D 图像。AKBNet 中构建了三个子模块,旨在估计各部位的 6D 姿态,重构铰接物体的完整几何形状,并根据感知信息推理交互策略。

给定带有二维边界框的图像,我们可以获取部分点云 P。我们首先通过 Pointnet++提取点云特征,然后建立了用于预测逐点分割 S 和部位级归一化物体坐标空间(NOCS)图的两个分支。为了解决为止运动结构和关节类型的问题,我们在特征提取器上引入了三个分支,根据相应的部位对关节类型分类,并预测关节的属性(位置,轴)。最后,我们通过带有运动约束的姿态优化算法恢复出每个刚性部位的 6D 姿态。

给定部分点云 P,形状模块旨在恢复出完整的几何外形和相应的关节状态。

我们利用 A-SDF 构建了一个特征提取器用来处理连接后的部分点云和高斯初始化的形状嵌入、关节嵌入。

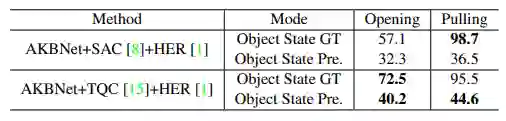

控制模块执行两项任务:分别对应于铰接结构中的转动关节和移动关节的打开和拉动。为了完成这些任务,我们训练了两个强化学习智能体。

我们给出了两种状态表征:(1)对象状态(2)智能体状态。动作包括智能体末端执行器的三维平移和夹持器的打开宽度。奖励函数是转动关节沿目标部件关节轴方向的旋转角度,移动关节沿目标部件关节轴方向的移动距离。我们使用两种常用的强化学习基线(带有 HER 的 TQC 和 SAC)训练。

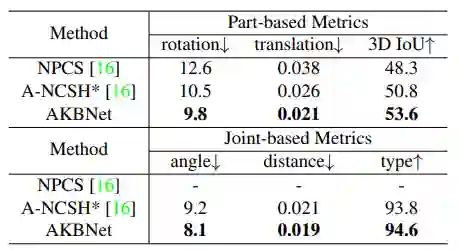

我们在真实世界测试集上评估了 NPCS、A-NCSH 和 AKBNet 在类别级关节姿态估计任务中的作用。

在姿态估计方面,AKBNet 在旋转、平移和 3D IoU 指标上的误差分别为 9.8、0.021 和 53.6,高于 NPCS 和 A-NCSH。在关节相关的评估方面,AKBNet 可以精确预测未见过的铰接物体的关节类型,准确率为 94.6%。此外,AKBNet 在关节轴和位置预测方面分别具有 8.1 和 0.019 的误差。

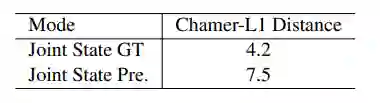

给定真实的关节状态,形状模块可以以 4.2 Chamfer-l1 距离重建出关节物体。另一方面,在给定预测关节状态的情况下,系统地评估形状模块,该状态是由姿态模块预测的相连的两部分的姿态推导出来的。Chamfe-l1 距离比真实的关节状态下高 3.3,说明所预测的姿态对重建性能影响较大。

我们比较了 TQC+HER 训练算法与 SAC+HER 训练算法在 AKBNet 控制模块上进行打开和拉动任务的性能。给定真实的物体状态时,AKBNet 完成打开和拉动任务的成功率分别为 72.5% 和 98.7%。然而,当使用预测的物体状态时,我们的方法只有 40.2% 和 44.6% 的成功率。