【ICML2020】机器学习无参数在线优化,294页ppt

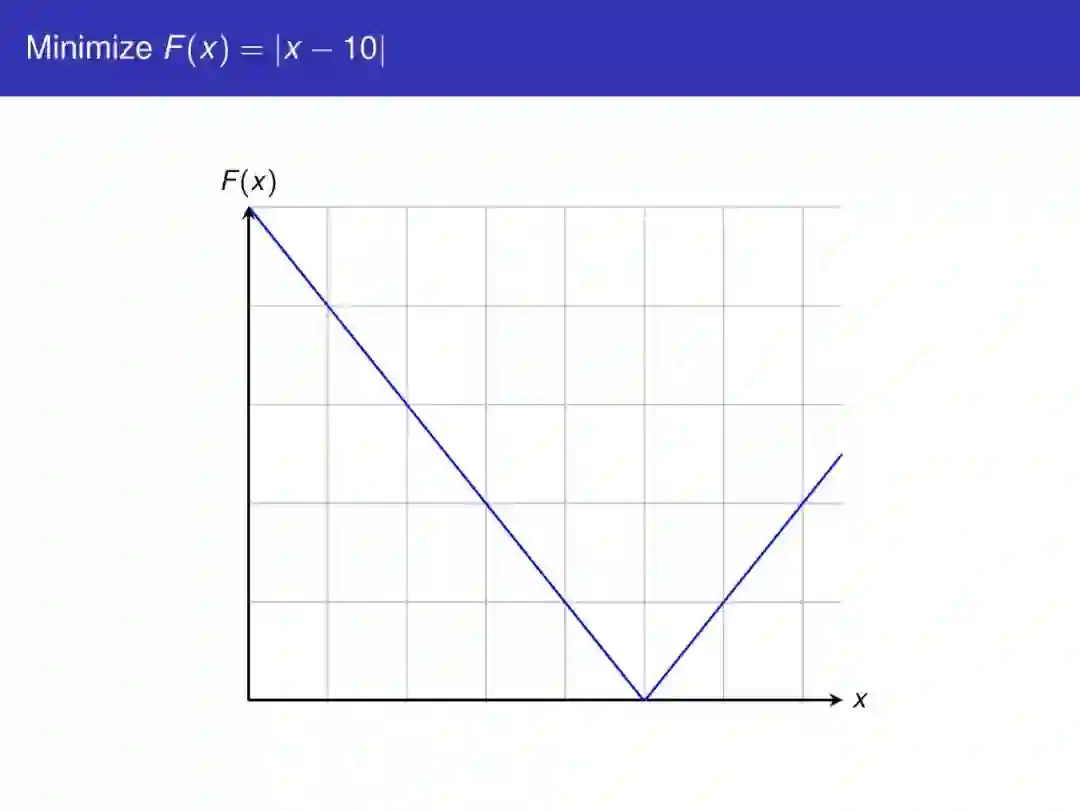

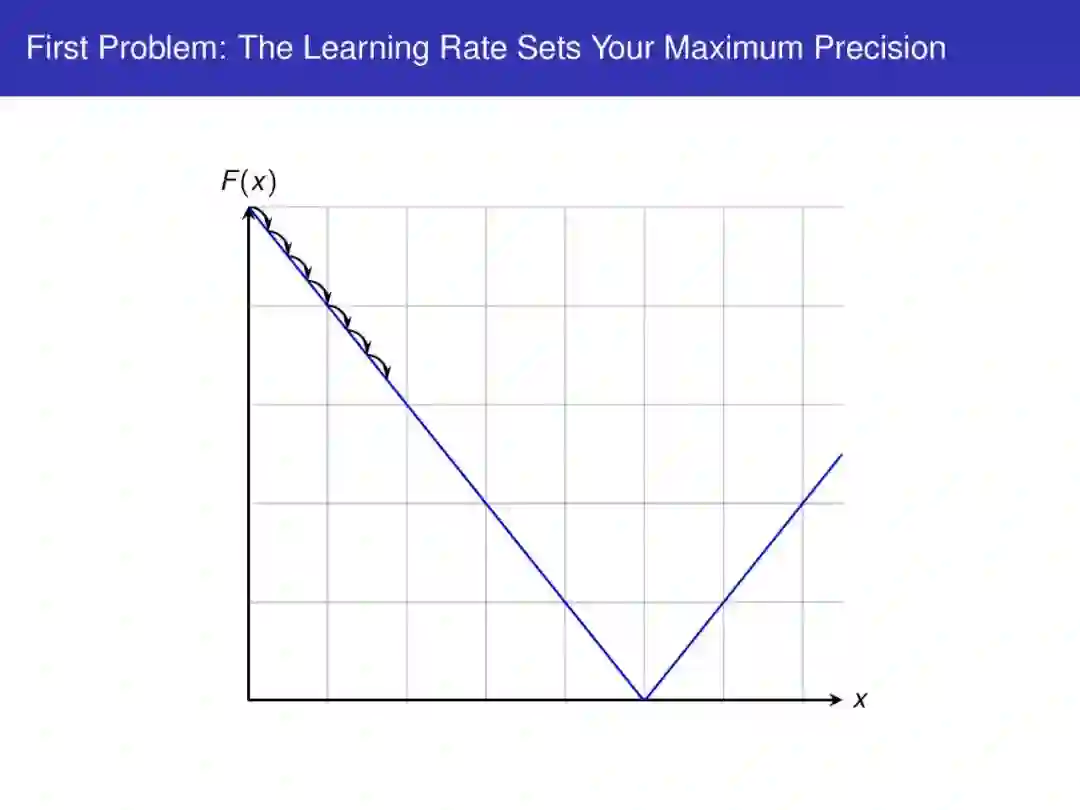

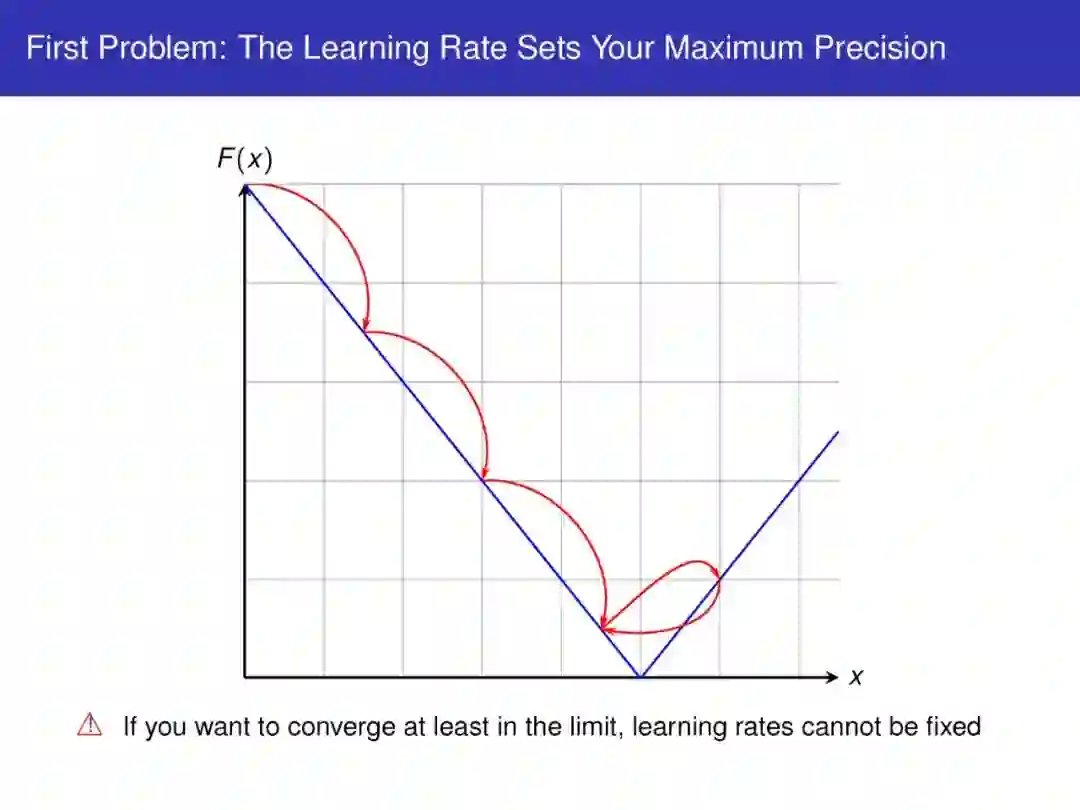

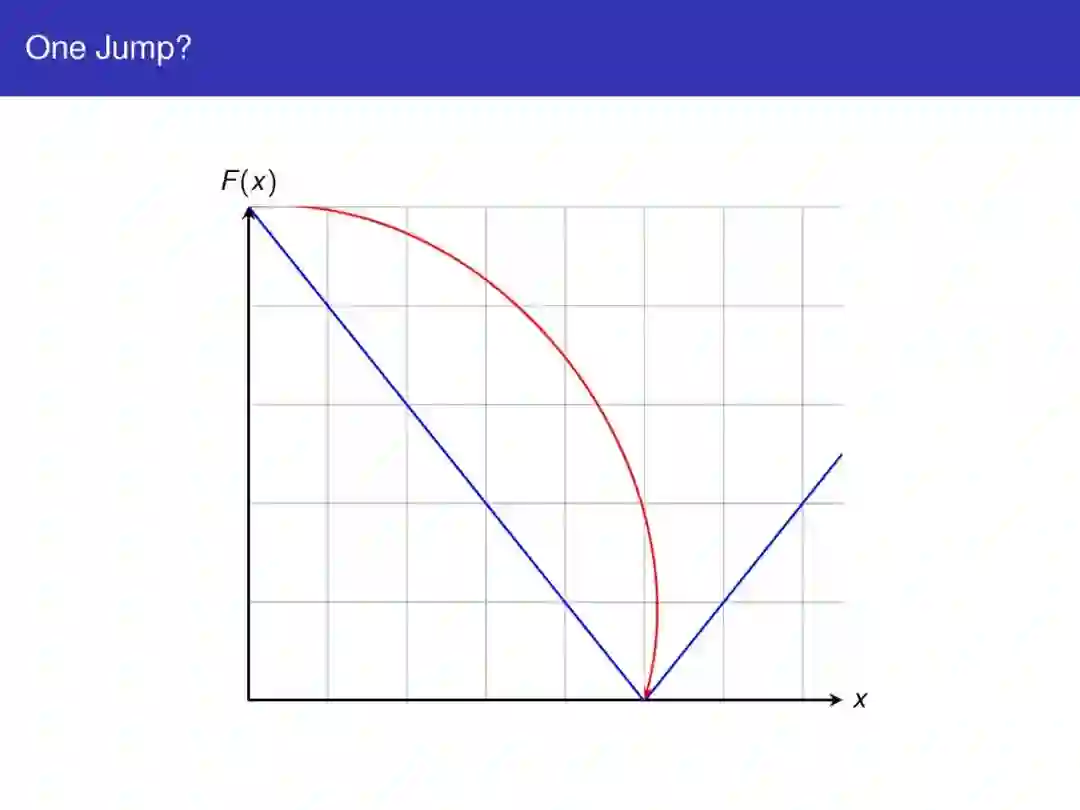

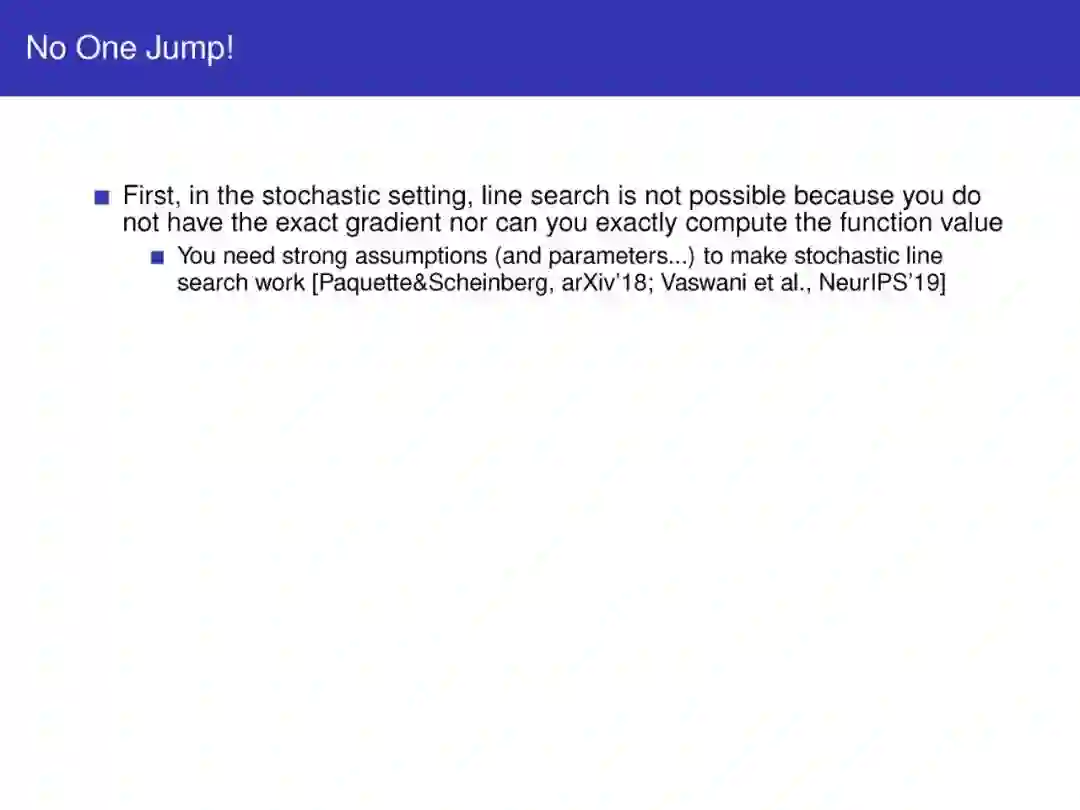

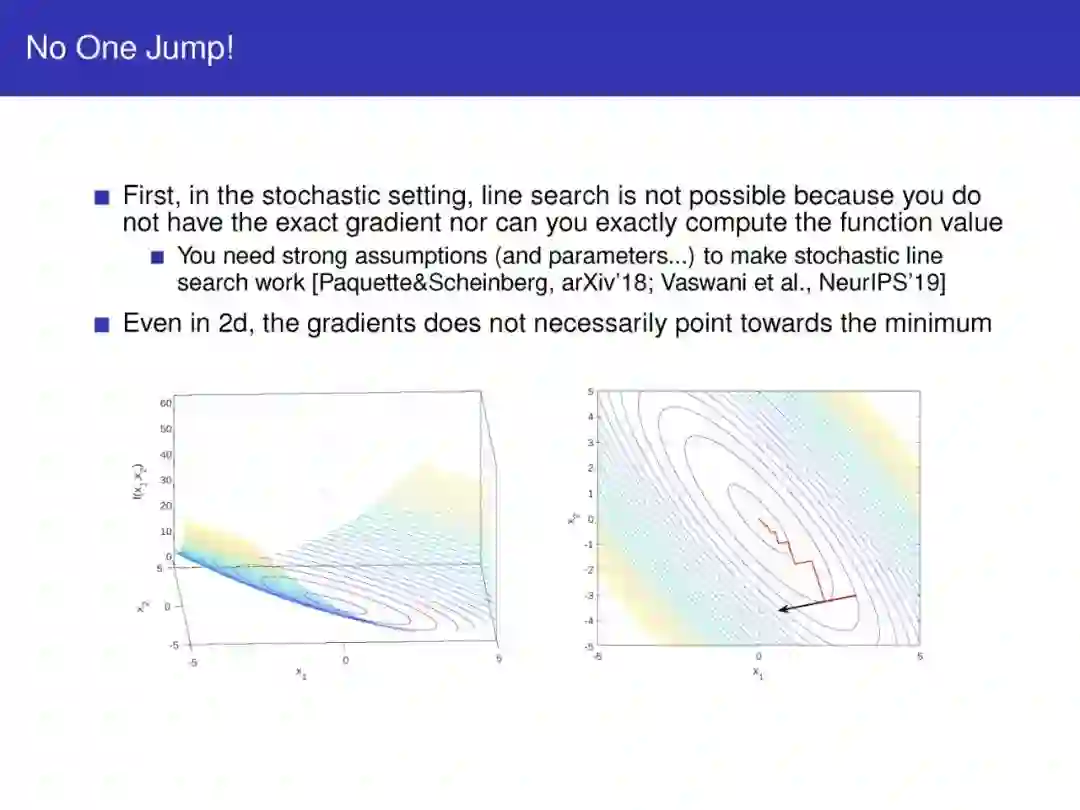

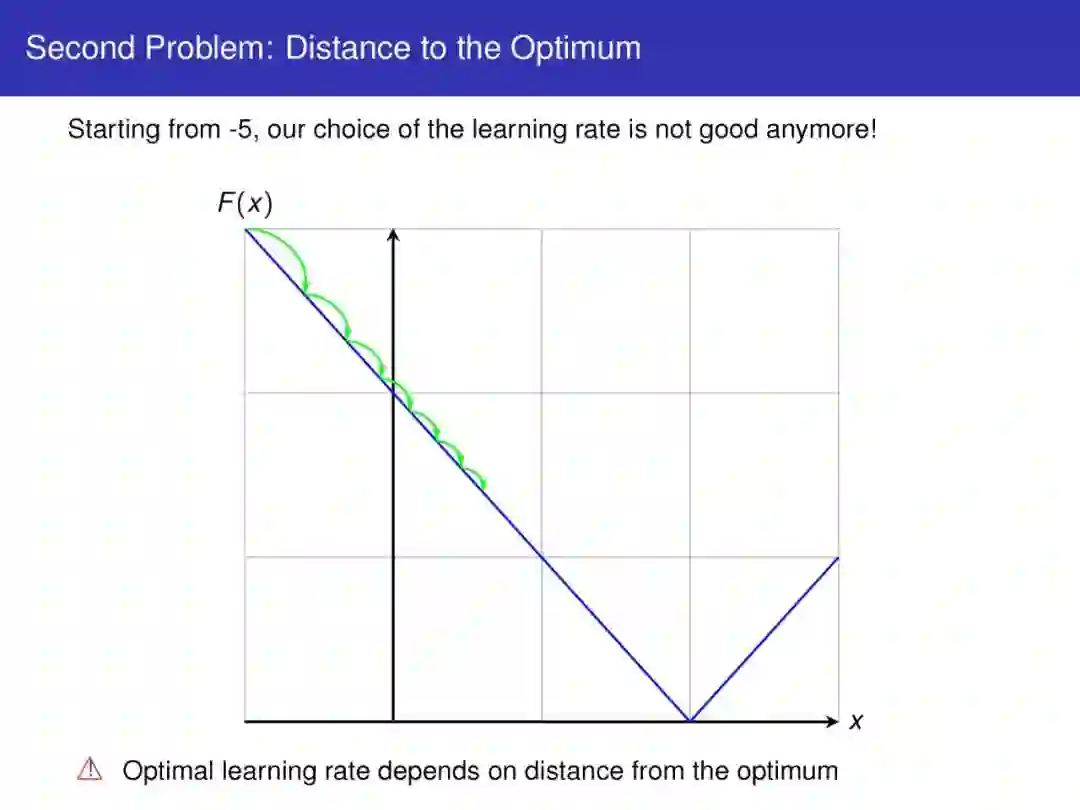

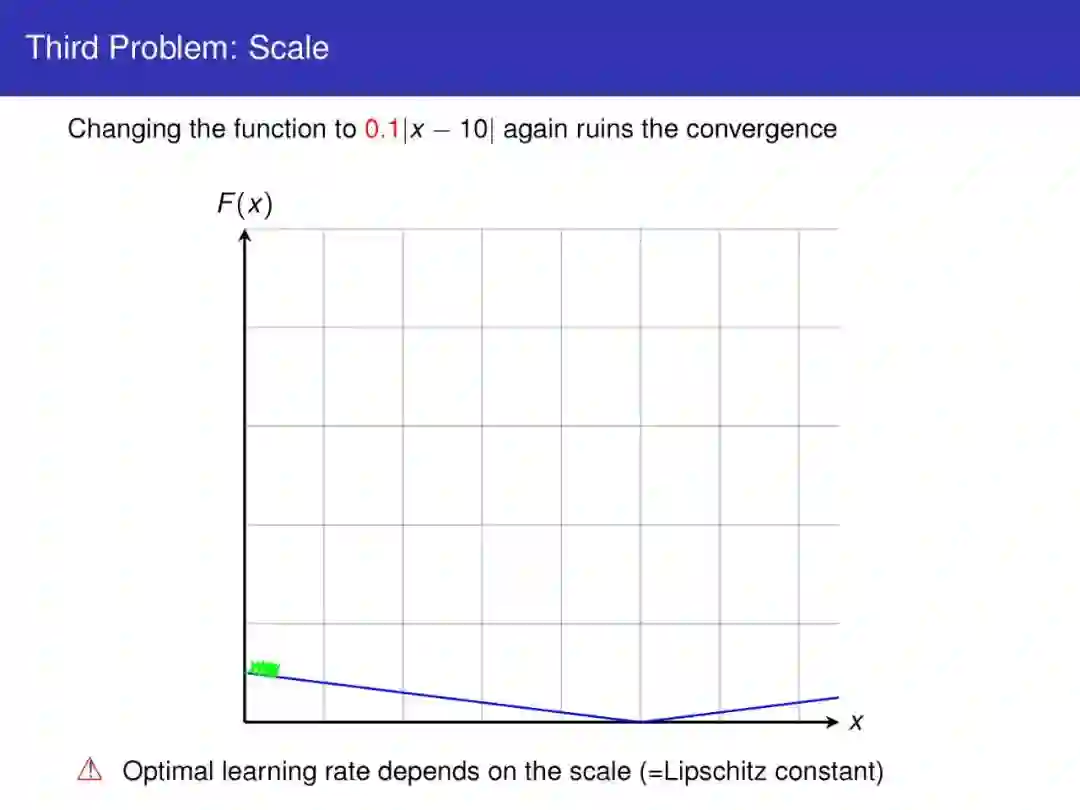

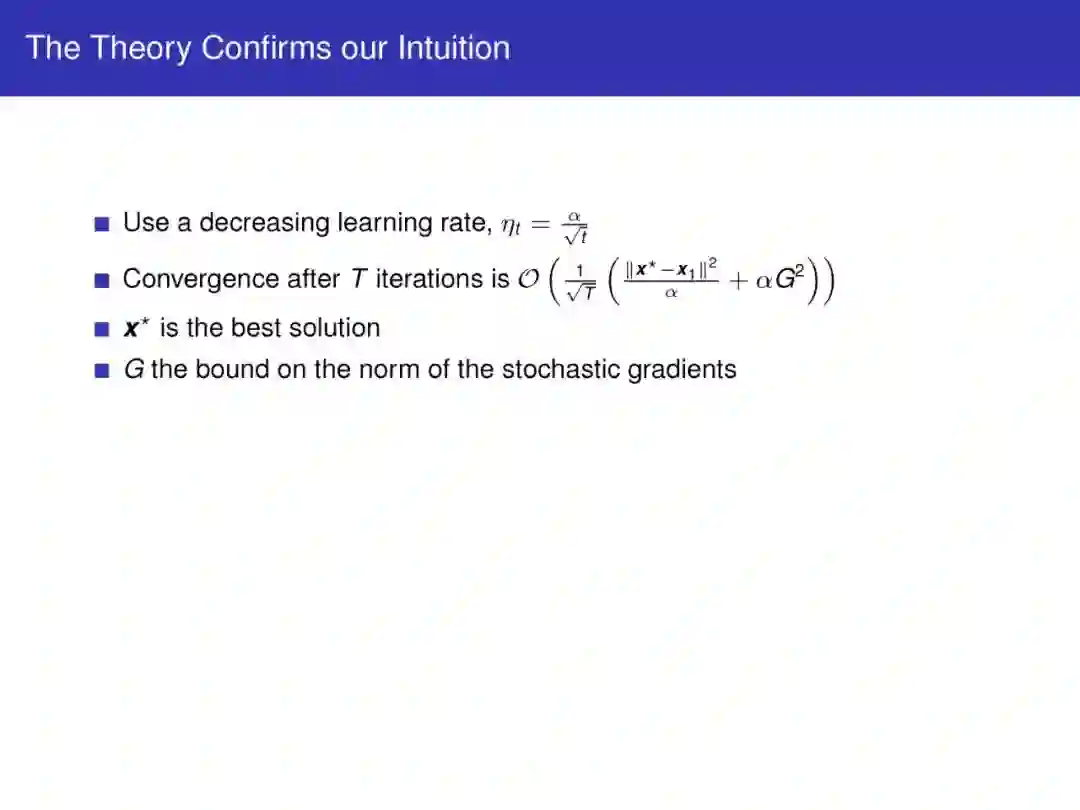

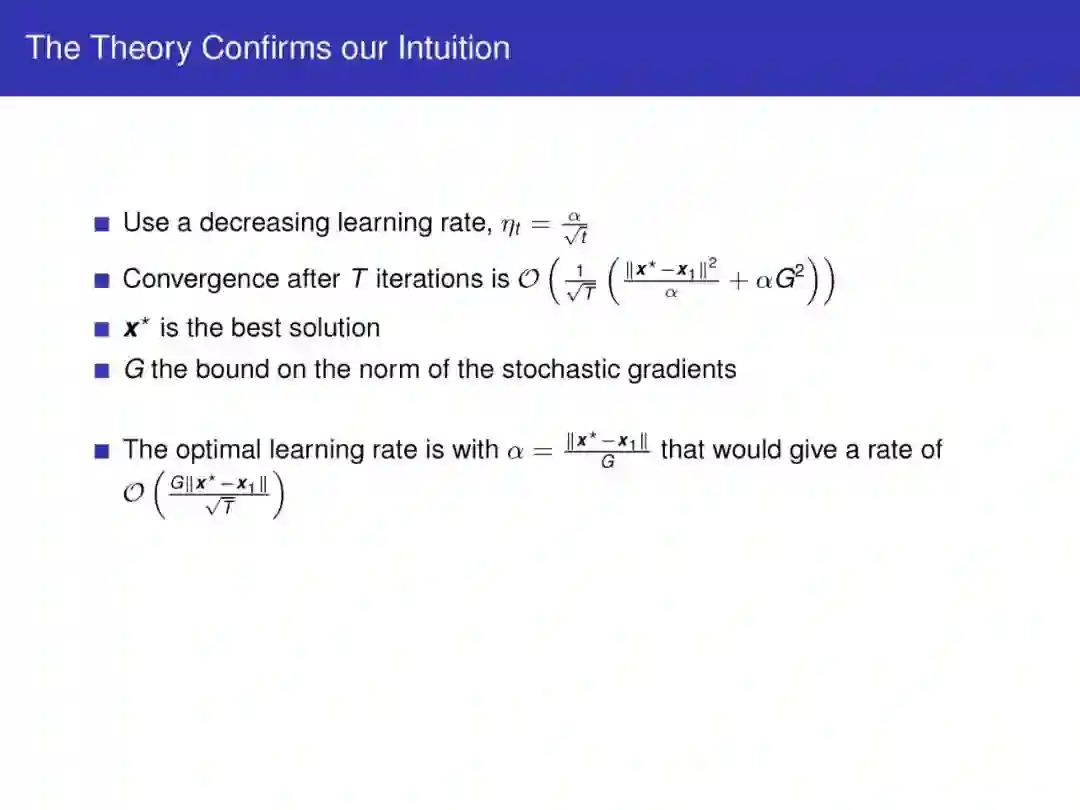

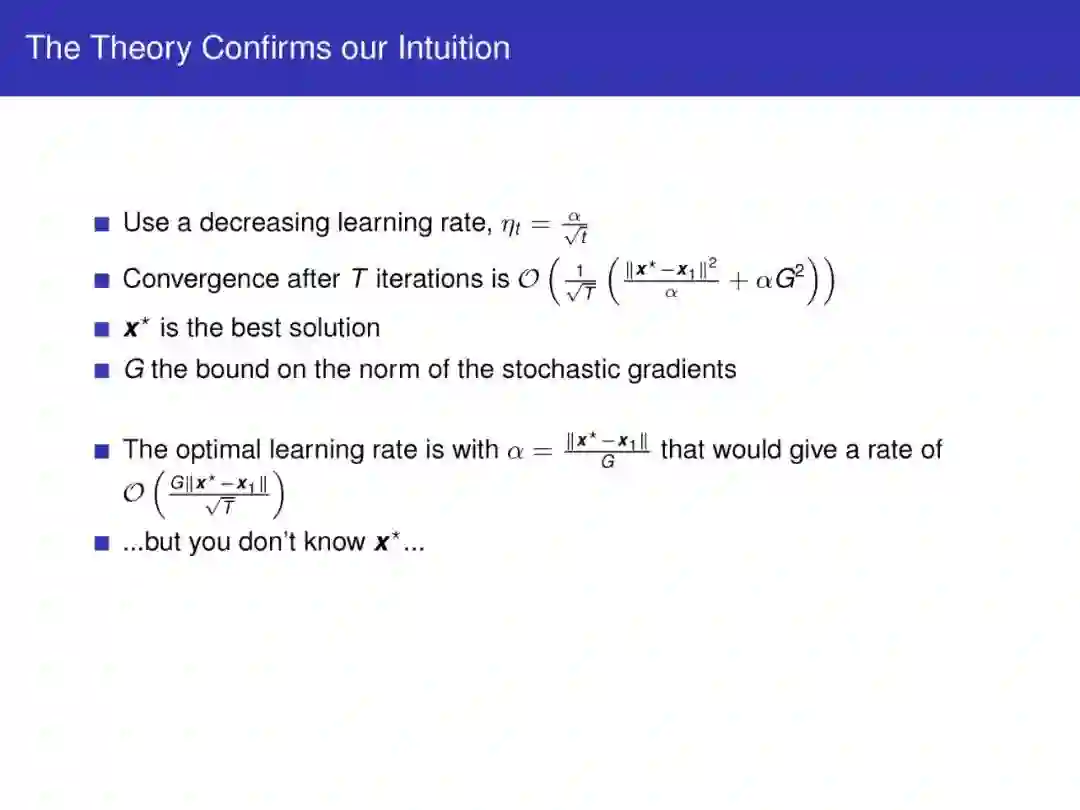

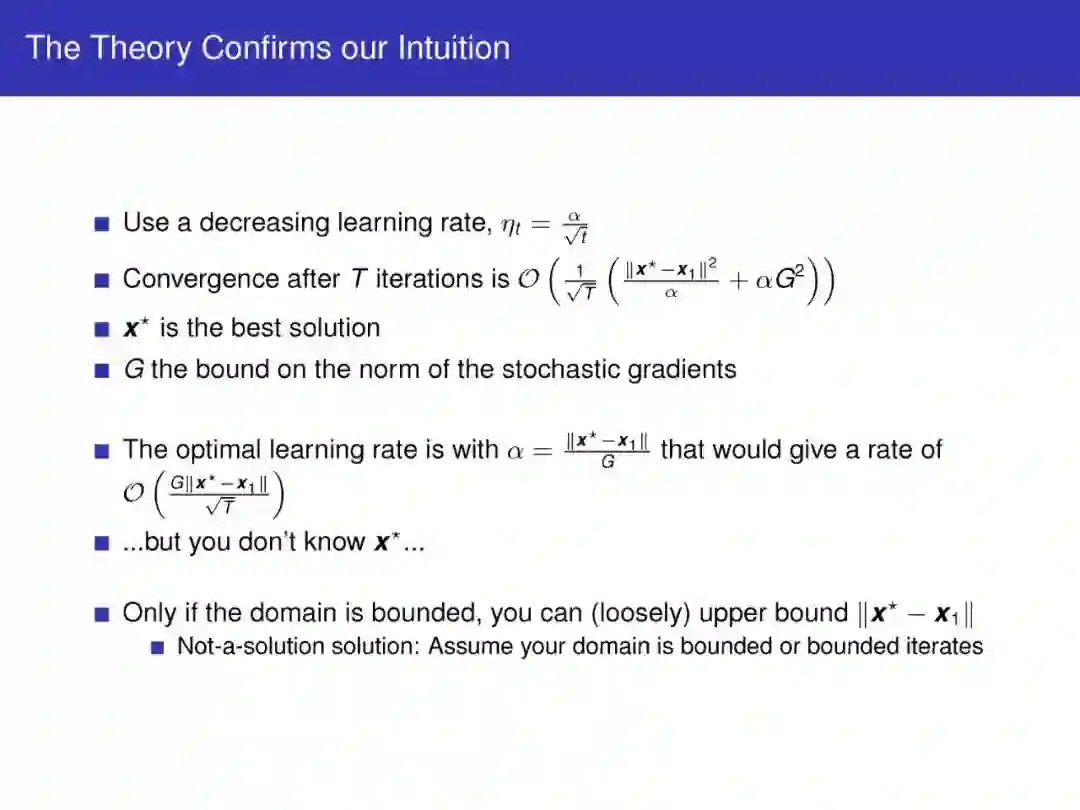

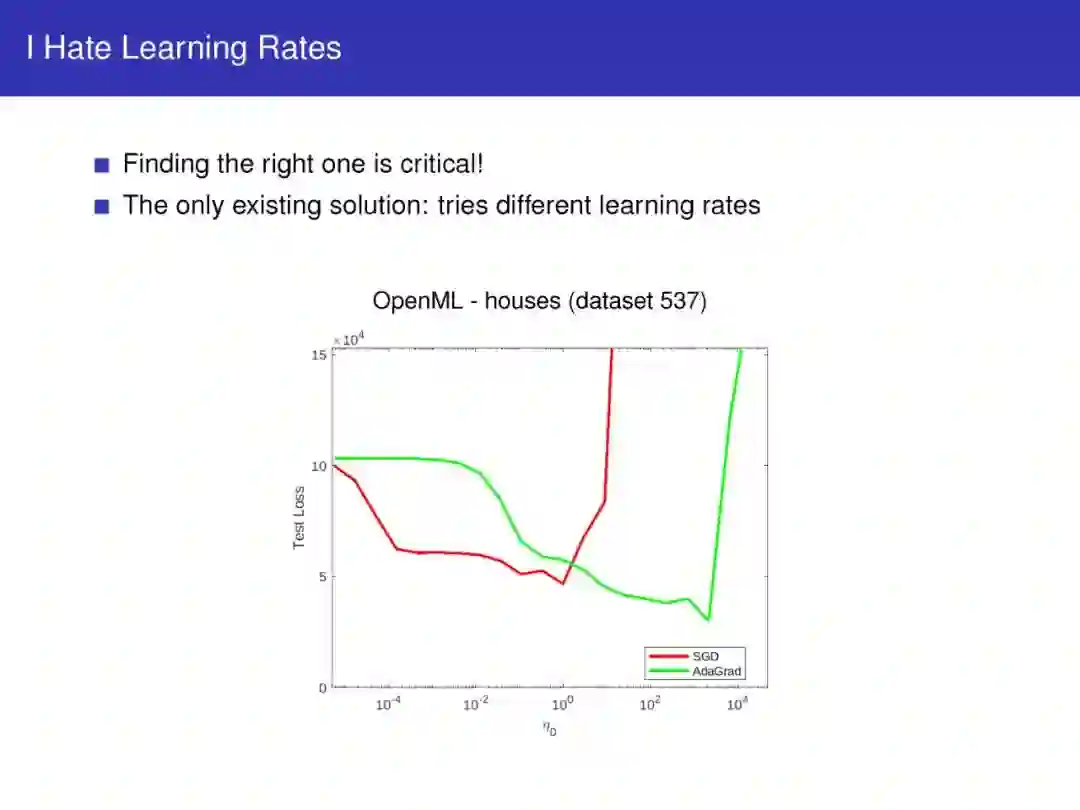

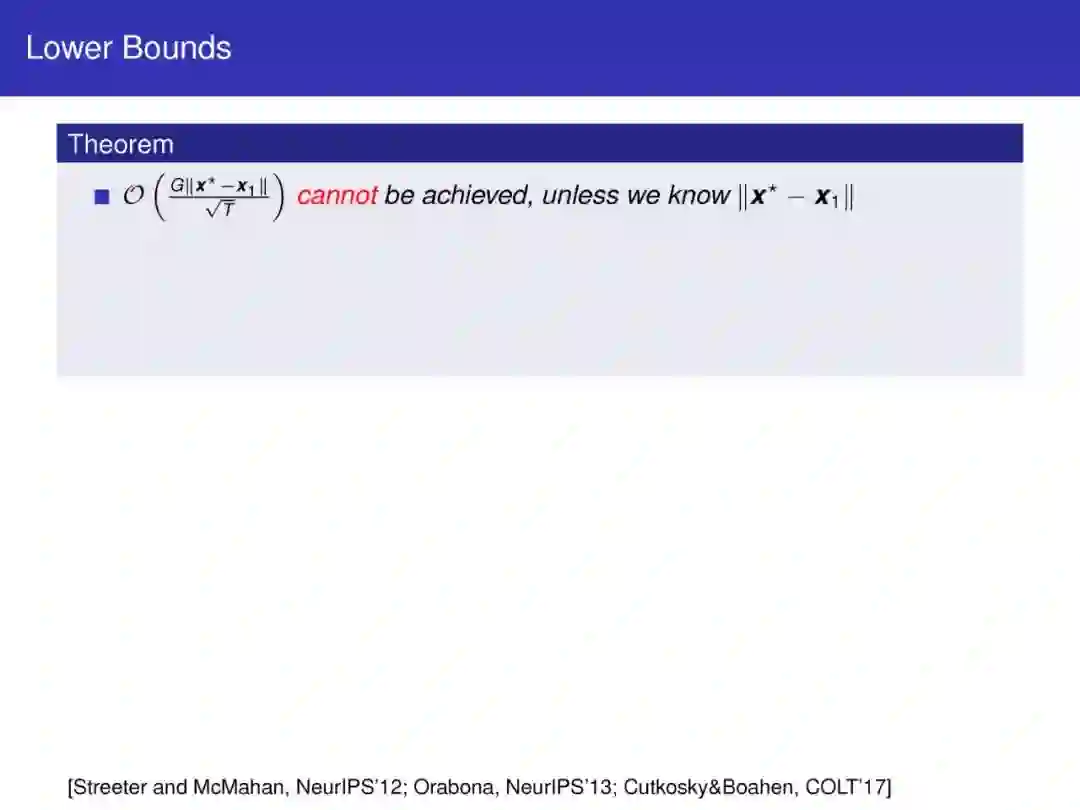

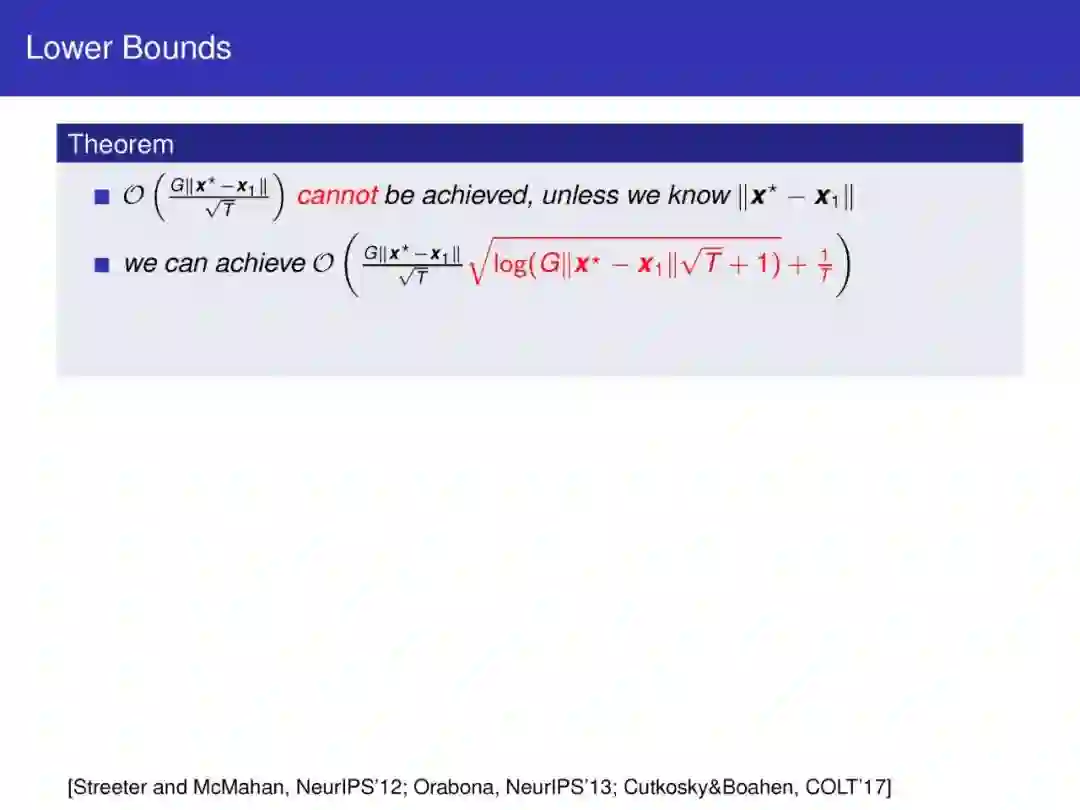

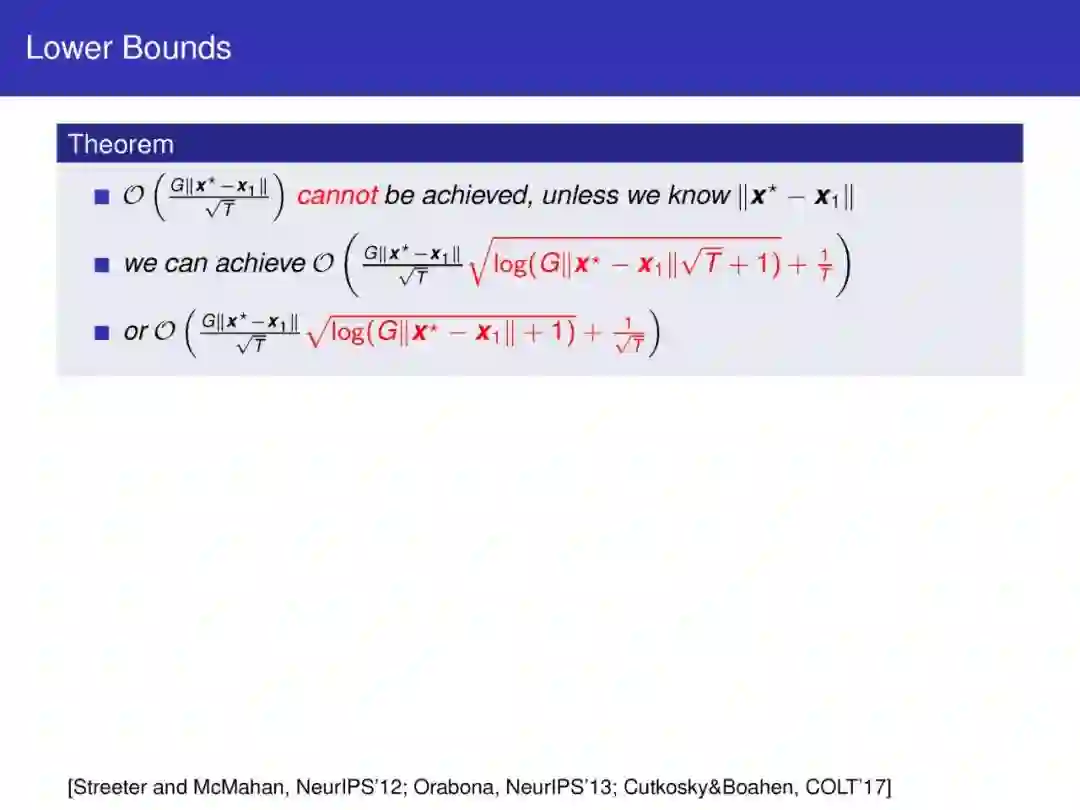

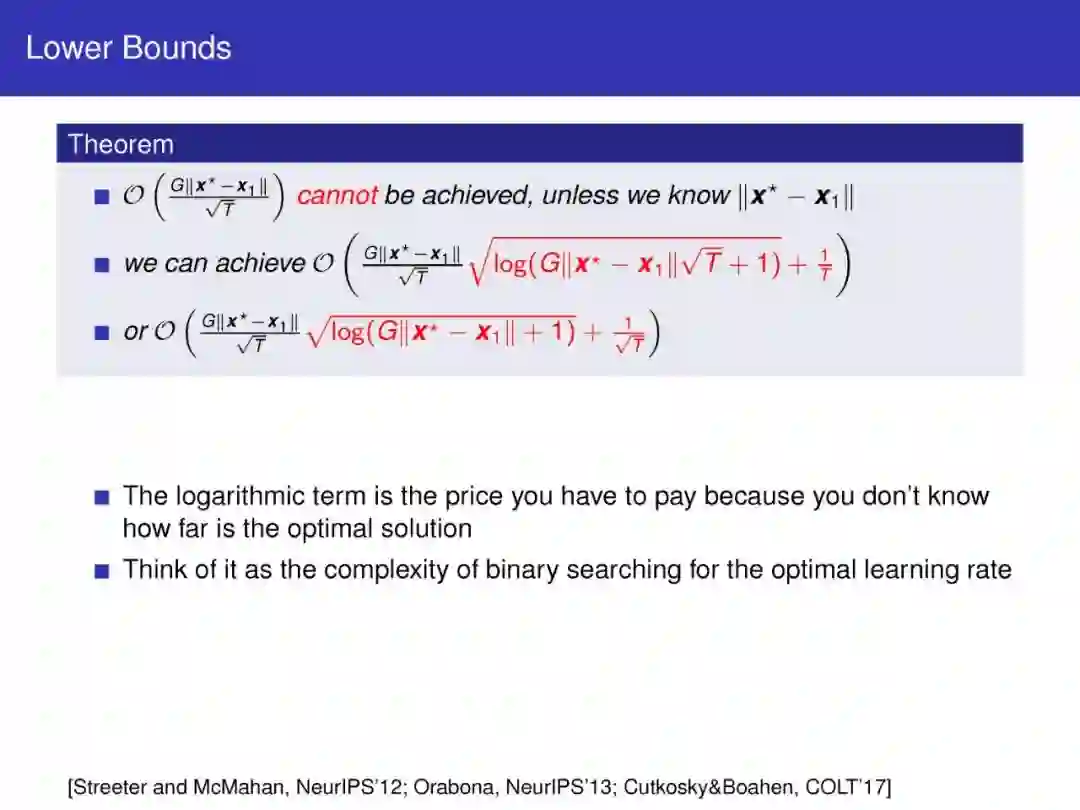

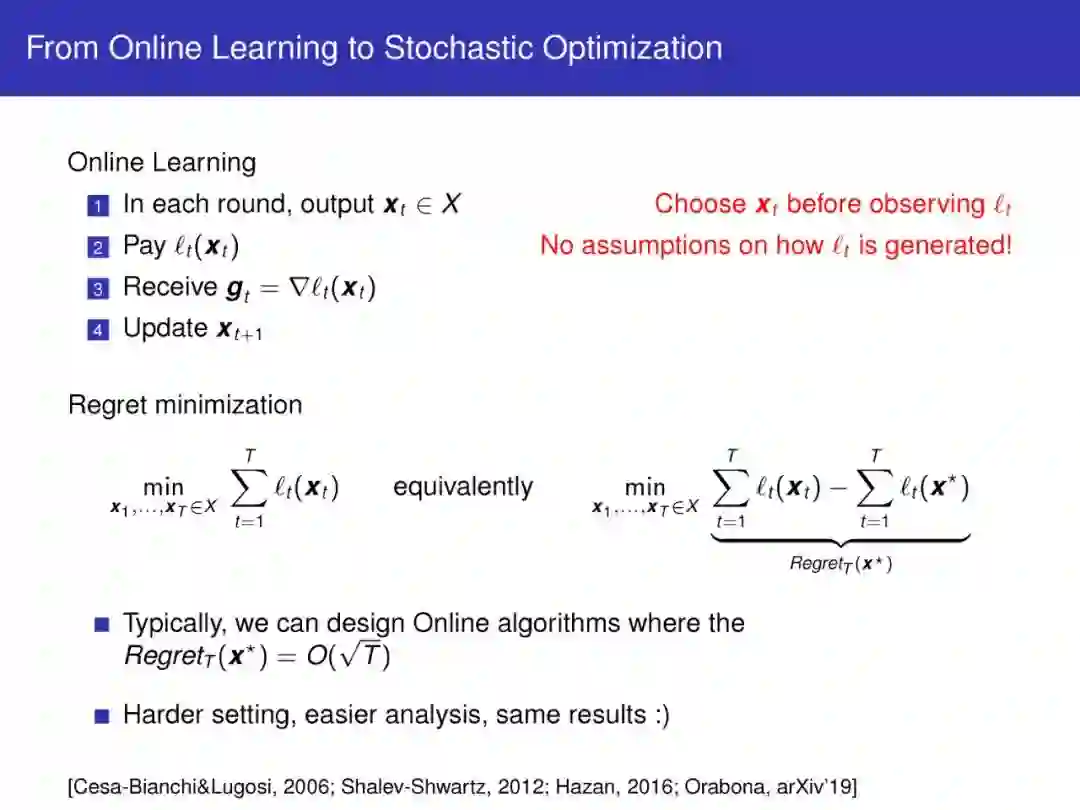

经典的随机优化结果通常假设数据的各种属性的已知值(例如Lipschitz常数、到最优点的距离、平滑性或强凸性常数)。不幸的是,在实践中,这些值是未知的,因此必须经过长时间的反复试验才能找到最佳参数。

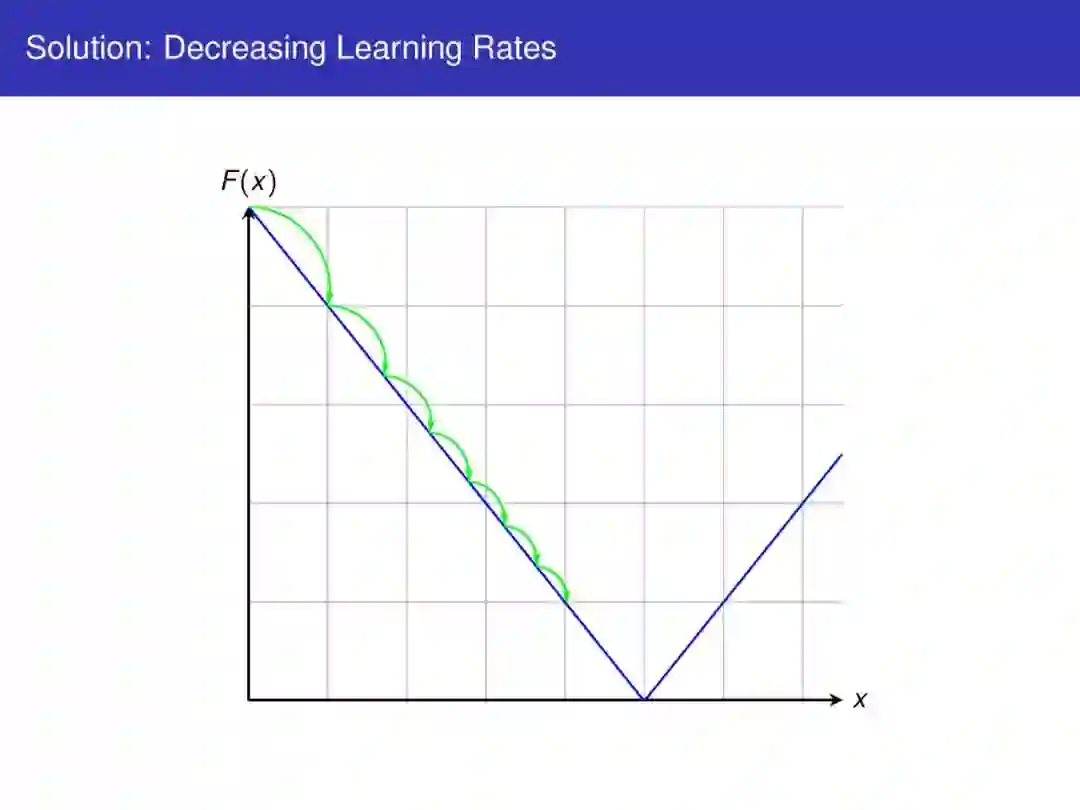

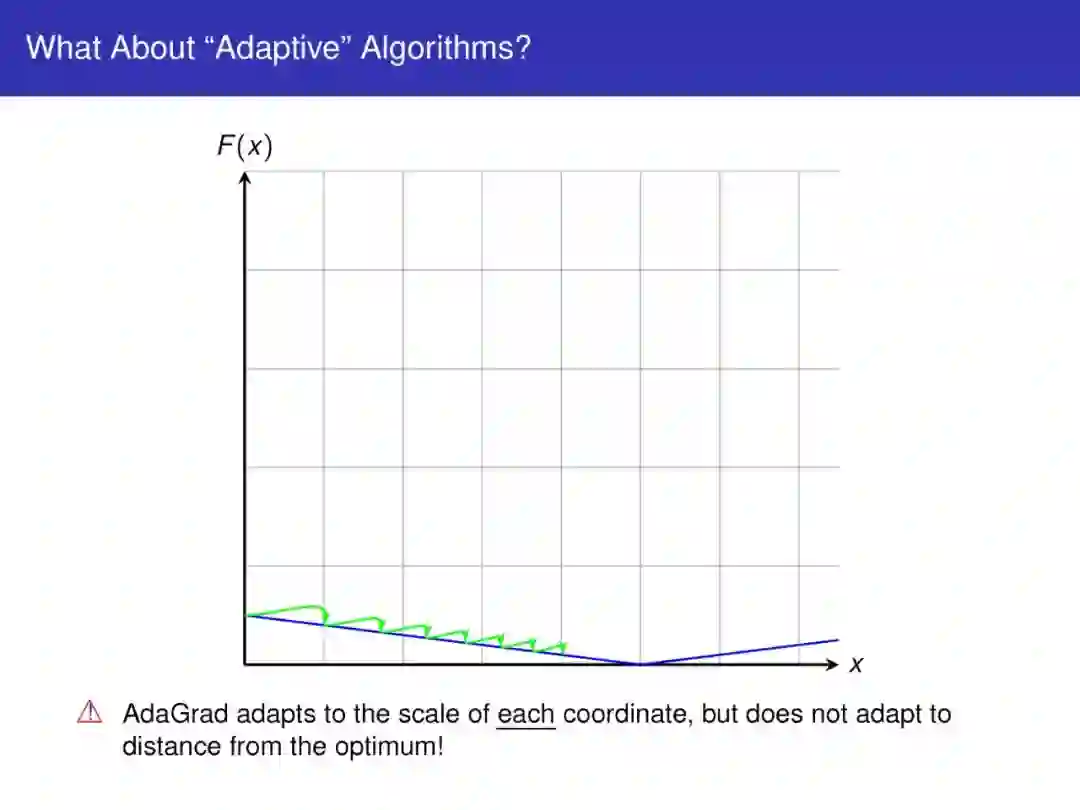

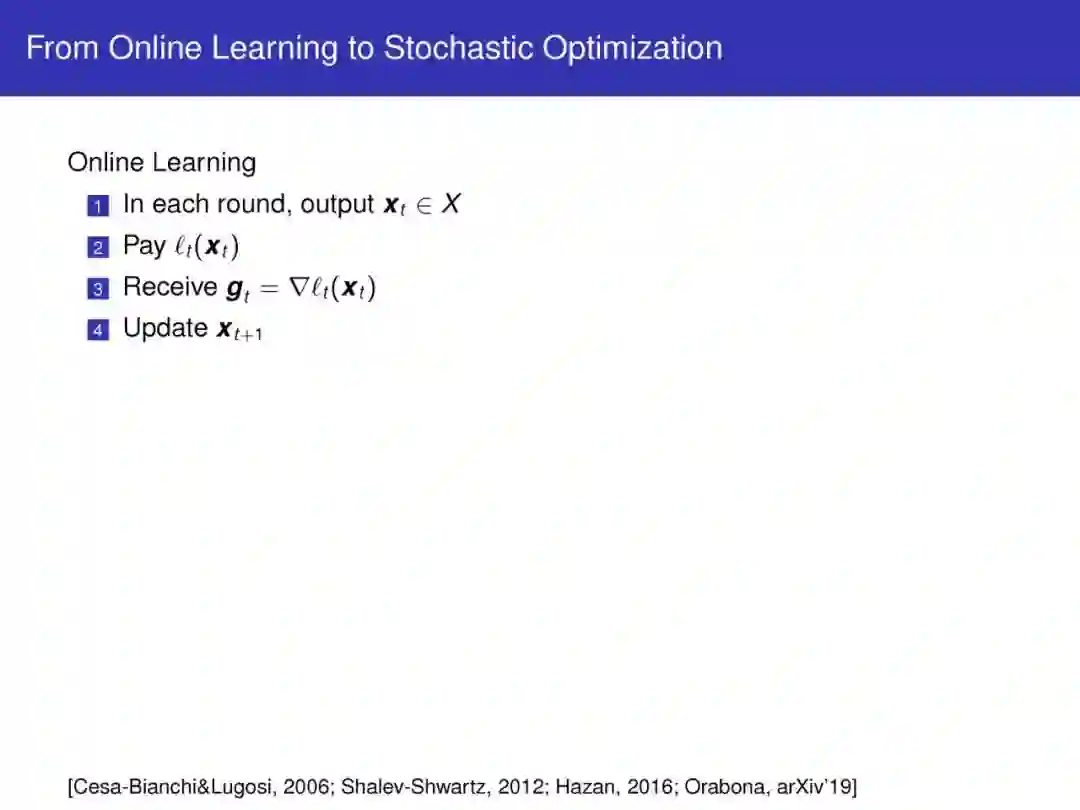

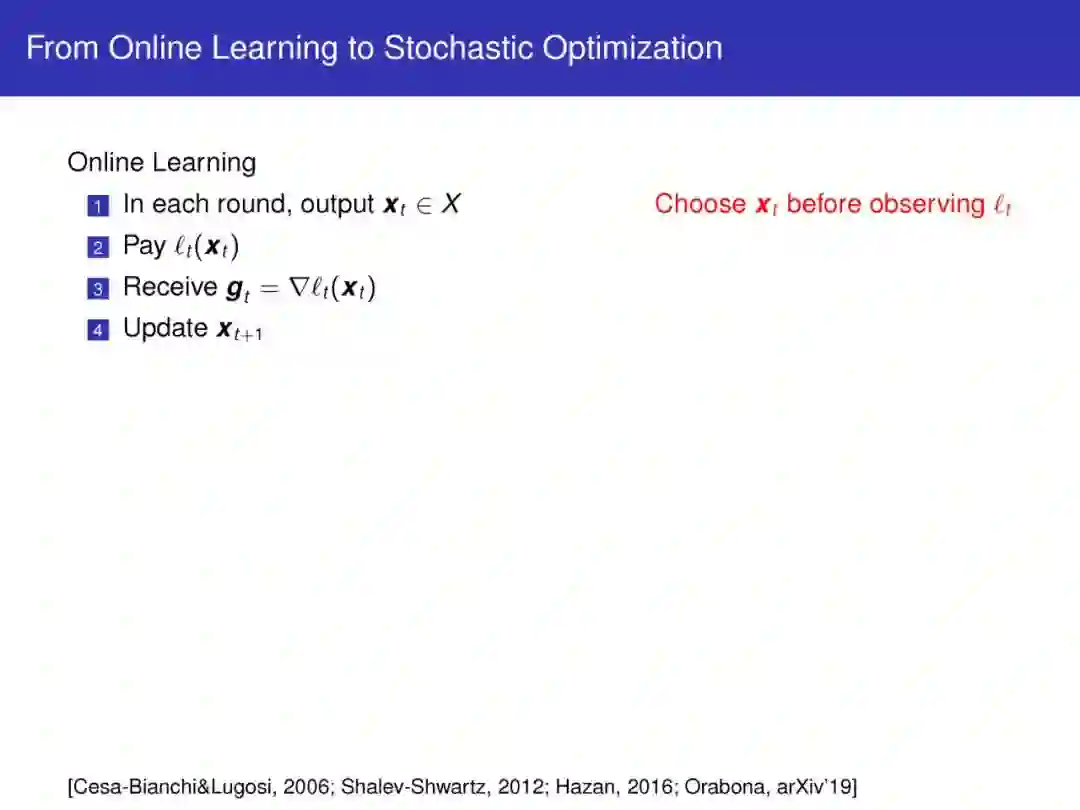

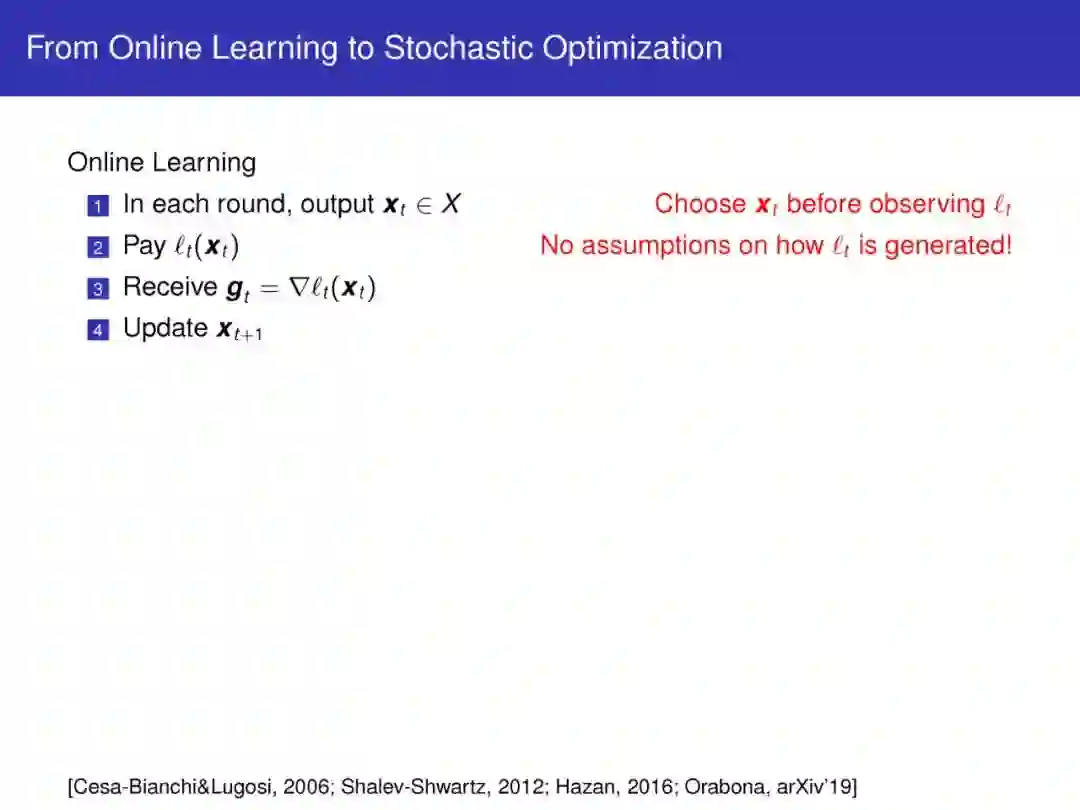

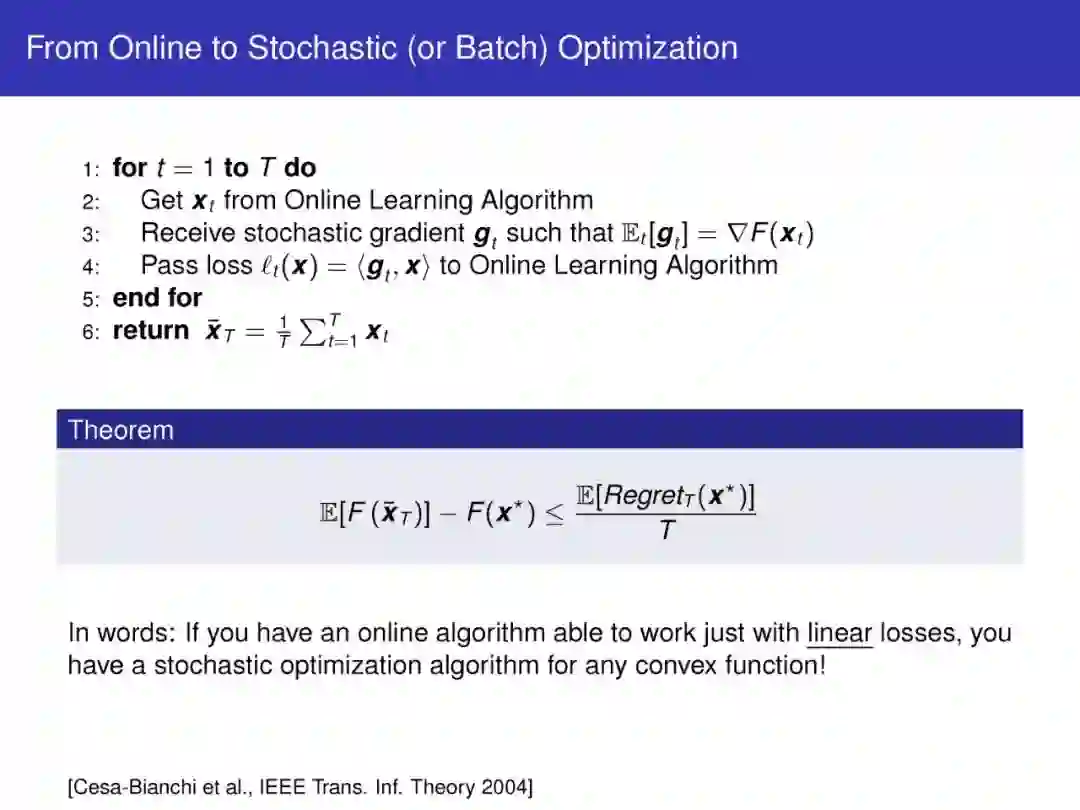

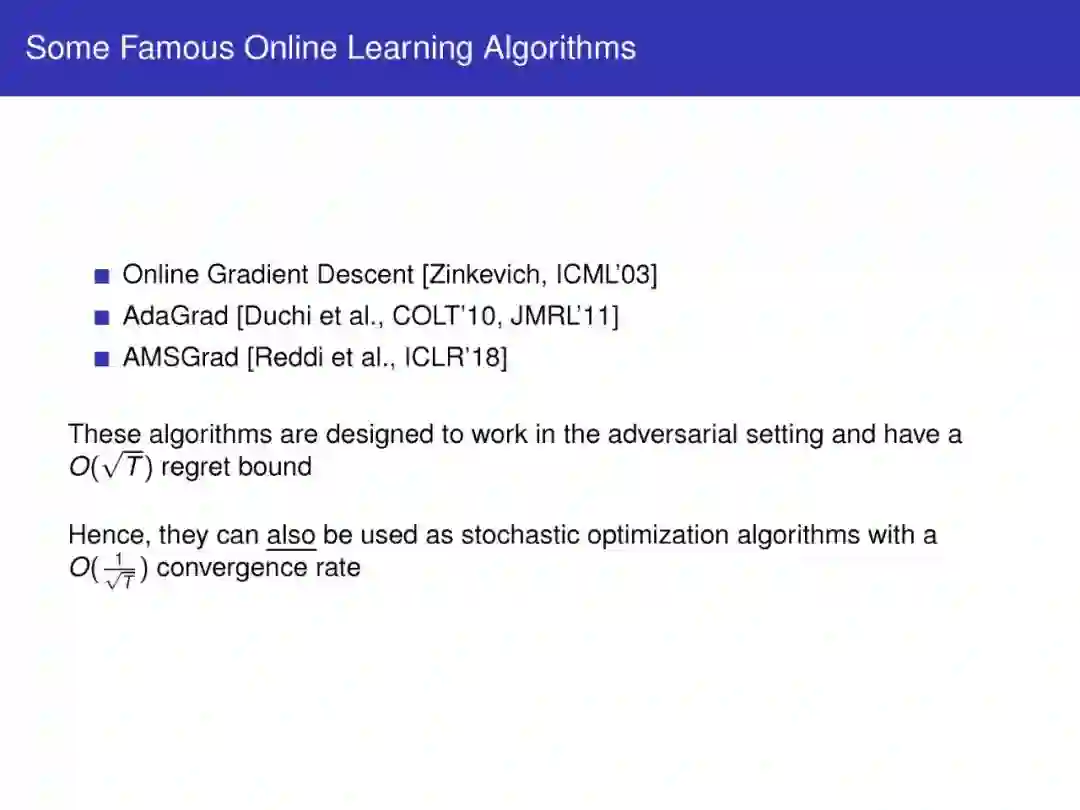

为了解决这一问题,近年来许多无参数算法已经被开发用于在线优化和在线学习。无参数算法对数据的性质不作任何假设,但收敛速度与最优优化算法一样快。

这是一项令人兴奋的工作,现在已经足够成熟,可以教授给普通观众了。实际上,这些算法还没有得到机器学习社区的适当介绍,只有少数人完全理解它们。本教程旨在弥补这一差距,介绍使用和设计无参数算法的实践和理论。我们将介绍该领域的最新进展,包括优化、深度学习和使用内核学习的应用。

https://parameterfree.com/icml-tutorial/

专知便捷查看

便捷下载,请关注专知公众号(点击上方蓝色专知关注)

后台回复“PFO” 可以获取《【ICML2020】机器学习无参数在线优化,294页ppt》专知下载链接索引

登录查看更多

相关内容

Arxiv

11+阅读 · 2020年2月18日