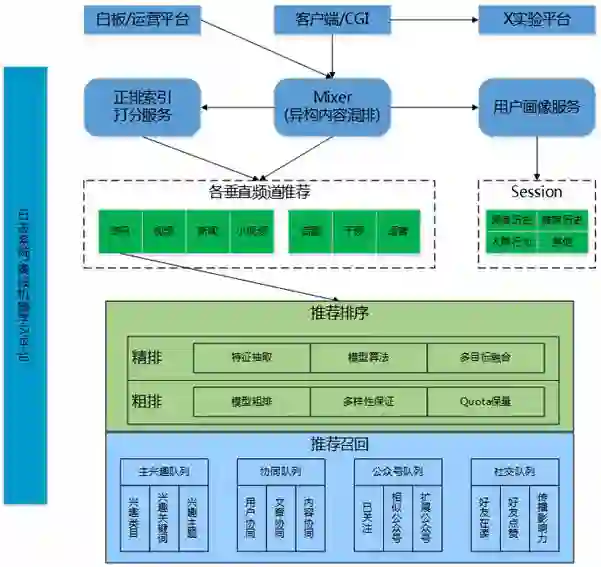

微信"看一看"个性化推荐:排序篇

在微信AI背后,技术究竟如何让一切发生?我们将为你一一道来。今天起,微信AI推出技术专题系列“微信看一看背后的技术架构详解”,干货满满,敬请关注。以下为本专题的第一篇《微信看一看推荐排序》。

背 景

整体架构

基础数据和召回

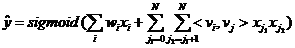

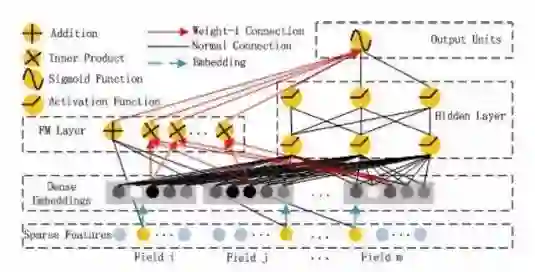

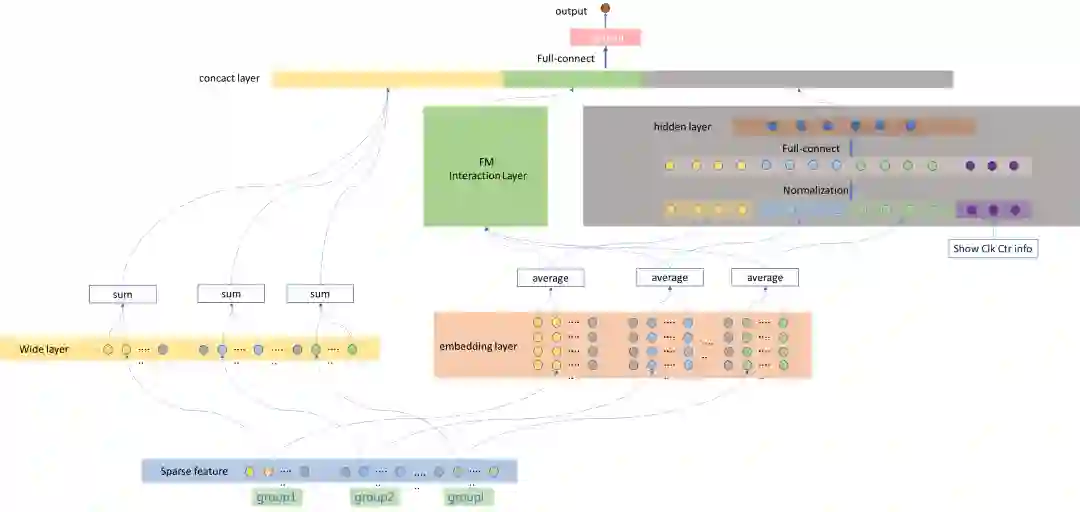

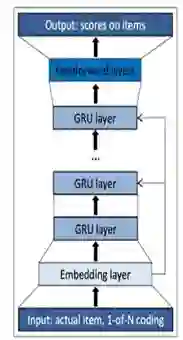

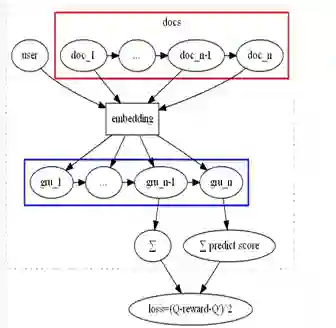

排 序

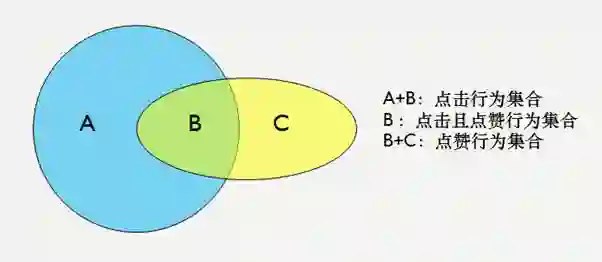

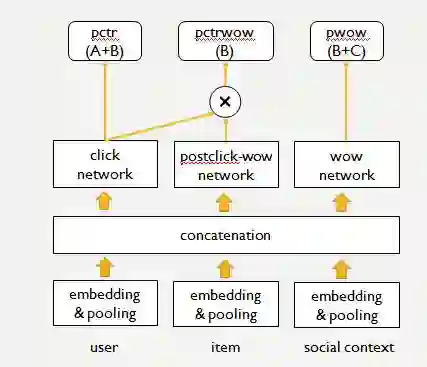

多目标

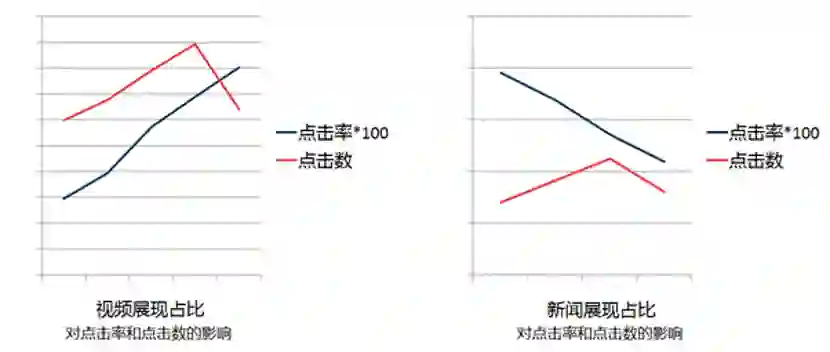

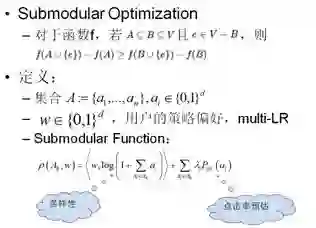

重排与多样性

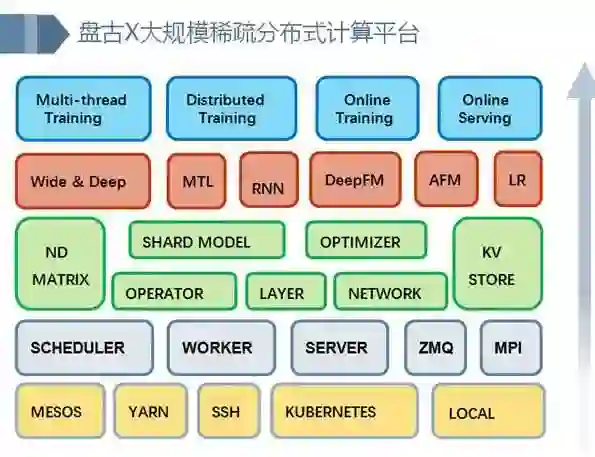

工程挑战

后 记

今天的分享就到这里了,谢谢大家!

社群推荐:

登录查看更多

相关内容

Arxiv

5+阅读 · 2018年4月5日