何恺明团队神经结构搜索最新力作:设计随机连接网络,效果超ResNet

新智元报道

新智元报道

来源:arXiv

编辑:肖琴

【新智元导读】FAIR何恺明团队近日发表神经结构搜索NAS方面的最新力作,通过随机连接的神经网络,探索了更多样化的连接模式,所提出的RandWire网络ImageNet基准测试中获得了有竞争力的准确度。

用于图像识别的神经网络经过大量的人工设计,已经从简单的链状模型发展到具有多个连接路径的结构。ResNets 和 DenseNets 的成功在很大程度上归功于它们创新的连接规划。

目前,神经结构搜索 (NAS) 的研究正在探索连接 (wiring) 与操作类型 (operation types) 的联合优化,然而,由于可能的连接空间受到限制,尽管采用了神经结构搜索,优化仍然是由人工设计驱动的。

近日,FAIR 何恺明等人发表最新论文,探讨了在图像识别中NAS方法的优化。研究人员通过随机连接的神经网络,探索了更多样化的连接模式。

论文地址:

https://arxiv.org/pdf/1904.01569.pdf

作者首先定义了一个随机网络生成器 (network generator) 的概念,该生成器封装了整个网络生成过程,从而提供了 NAS 和随机连接网络的统一视图。

然后,研究人员采用三种经典的随机图模型来生成网络的随机连接图。

实验结果令人惊讶:这些随机生成器生成的网络实例在 ImageNet 基准测试中获得了有竞争力的准确度。

研究人员表示,这些结果表明,专注于设计更好的网络生成器的研究可以通过探索更少约束的搜索空间,为新设计提供更多空间,从而带来新的突破。

不过,该研究被指其思想早已在2013年PCA-Net论文中提出过,在算法设计思想方面没有本质的创新。

何恺明等人的这一新研究到底意义如何?本文对这篇论文进行了译介:

今天我们所称的深度学习是从连接主义方法发展起来的,这一范式反映了这样一种假设,即计算网络的连接方式对构建智能机器至关重要。

与这一观点相呼应的是,计算机视觉领域的最新进展是由使用链状连接的模型向更精细的连接模式 (如 ResNet 和 DenseNet) 的转变所驱动的,这些连接模式之所以有效,在很大程度上是因为它们的连接方式。

在这一趋势的推进中,神经结构搜索 (neural architecture search, NAS) 已经成为联合搜索连接模式和执行操作方式的一个有前景的方向。NAS 方法专注于搜索,同时隐式地依赖于一个重要但常常被忽视的组件 —— 网络生成器 (network generator)。

NAS 网络生成器定义了一系列可能的连接模式,并根据可学习的概率分布对网络进行采样。然而,就像 ResNet 和 DenseNet 中的连接模式一样,NAS 网络生成器是手工设计的,允许的连接模式的空间被限制在所有可能的图的一个小的子集中。从这个角度来看,我们会问:如果我们放开这种约束,并设计新的网络生成器,会发生什么 ?

我们通过随机网络生成器采样的随机连接神经网络来探讨这个问题,其中人工设计的随机过程定义了生成。

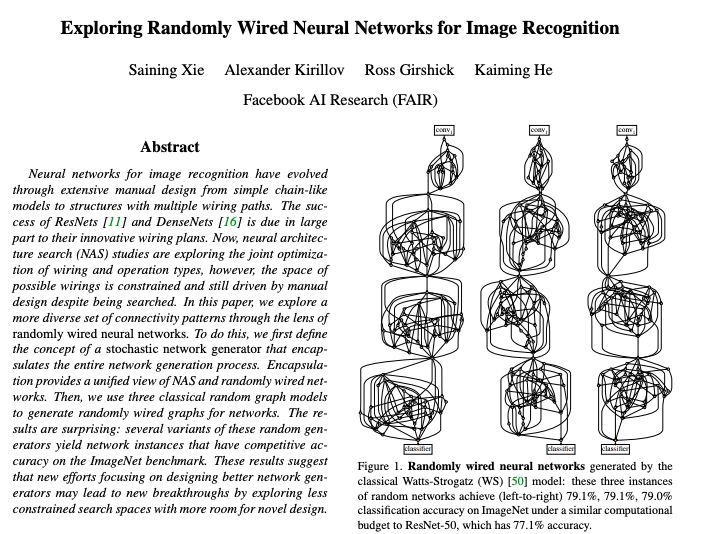

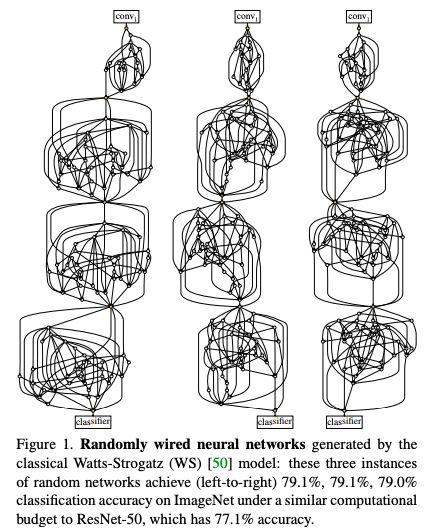

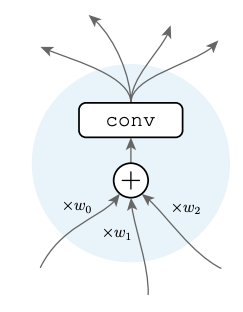

图1:随机连接网络的计算图

我们使用了三个经典的随机图模型:Erdos-R˝enyi (ER) ,Barabasi-Albert (BA),以及Watts-Strogatz (WS) 模型。

如图1所示,随机连接网络的三个实例在ImageNet基准测试中分别达到79.1%、79.1%和79.0%的精度,超过了ResNet-50的77.1%。

为了定义完整的网络,我们将一个随机图转换成一个有向无环图 (DAG),并应用从节点到其函数角色 (例如,到相同类型的卷积) 的一个简单映射。

结果令人惊讶:这些随机生成器的几个变体在 ImageNet 上产生了准确率上具有竞争力的网络。

使用 WS 模型的最佳生成器生成的多个网络性能优于或可与完全手工设计的同类网络和通过各种神经结构搜索方法找到的网络相媲美。

我们还观察到,对于同一生成器生成的不同随机网络,精度的方差较低,但不同生成器之间存在明显的精度差距。这些观察结果表明,网络生成器的设计很重要。

最后,我们的工作表明,从设计单个网络到设计网络生成器的新过渡是可能的,类似于如何从设计特征过渡到设计学习特征的网络。

我们建议设计新的网络生成器来生成用于搜索的新模型家族,而不是主要关注使用固定生成器进行搜索。设计的网络生成器的重要性还意味着机器学习尚未实现自动化 —— 底层的人工设计只是从网络工程转变到网络生成器工程 (network generator engineering)。

接下来介绍网络生成器的概念,这是随机连接神经网络的基础。

网络生成器 (network generator)

我们定义一个网络生成器为从参数空间 Θ 到神经网络结构空间 N 的一个映射g,表示为g:Θ→N。对于一个给定的θ∈Θ,g(θ) 返回一个神经网络实例n ∈ N。N 通常是一组相关网络,例如 VGG nets、ResNets 或 DenseNets。

生成器 g 决定了计算图的连接方式。

随机连接神经网络 (Randomly Wired Neural Networks)

对 NAS 的分析表明,网络生成器是人工设计的,并且是人类知识的先验编码。网络生成器的设计很可能起了相当大的作用,如果是这样的话,目前的方法还没有实现“AutoML”,仍然需要大量的人工。

为了研究生成器设计的重要性,仅比较相同 NAS 生成器的不同优化器是不够的;有必要研究新的网络生成器,它们与 NAS 生成器有本质的不同。

这就引出了我们对随机连接神经网络的探索。也就是说,我们将定义网络生成器,这些生成器生成具有随机图的网络,受不同的人类特定先验影响。

我们在研究中使用了三个经典的随机图模型 (如上文所述)。生成随机连接网络的方法涉及以下概念:

生成通用的图 (general graphs)。

网络生成器首先生成一个 general graph,包含一组节点和连接节点的边,而不受限于图和神经网络的对应关系。这允许我们自由地使用图理论中的任意通用图生成器(ER/BA/WS)。一旦生成一个图,它就被映射到一个可计算的神经网络。

边操作 (Edge operations)。

假设生成的图是有方向的,我们定义边是数据流,即有向边将数据 (张量) 从一个节点发送到另一个节点。

节点操作 (Node operations)。

有向图中的节点可以具有一些输入边和一些输出边。如图 2 所示。

图2:节点操作

输入和输出节点。

到目前为止,即使给定边 / 节点操作,通用图也不是一个有效的神经网络,因为它可能有多个输入节点和多个输出节点。对于典型的神经网络,如图像分类,最好有一个单一的输入和输出。我们应用了一个简单的后处理步骤。

阶段 (Stages)。

由于具有唯一的输入和输出节点,一个图就足以表示一个有效的神经网络。然而,特别是在图像分类中,始终保持完整输入分辨率的网络是不可取的。通常的方法是将网络划分为逐步向下采样特征映射的阶段。

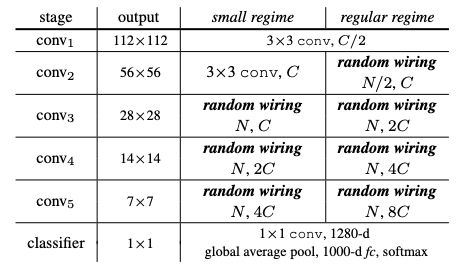

表1:RandWire架构

表 1 总结了我们实验中使用的随机连接神经网络,称为 RandWire。网络以一个分类器输出结束 (表 1,最后一行)。

图 1 显示了三个随机连接网络样本的完整计算图。

我们对 ImageNet 1000 类分类任务进行了实验。训练在~1.28M 图像的训练集上进行,并在 50K 验证图像上进行测试。

实验结果如下:

随机生成器

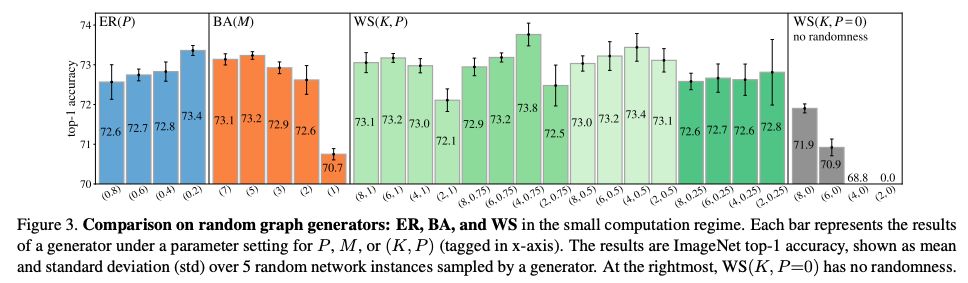

图3

图 3 比较了小型计算环境中不同生成器的结果:每个 RandWire 网络有~580M FLOPs。

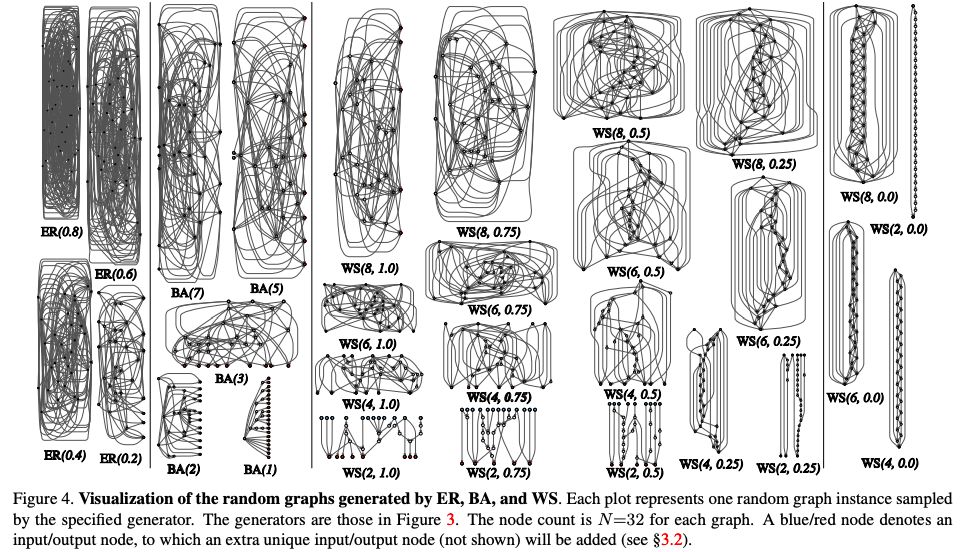

图4

图 4 显示了每个生成器的一个示例图。图生成器由随机图模型 (ER/BA/WS) 及其参数集指定,如 ER(0.2)。我们观察到:

所有随机生成器在所有 5 个随机网络实例上都提供良好的准确度,而且它们没有一个不收敛。

此外,随机网络实例之间的差异很小。图 3 中的几乎所有随机生成器的标准偏差 (std)都为 0.2 ~ 0.4%。

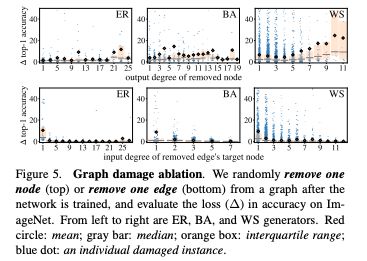

Graph damage.

我们通过随机移除一个节点或边来探索 Graph damage。

图5

当删除边时,我们评估了精度损失与该边的目标节点的输入程度 (图 5,底部)。

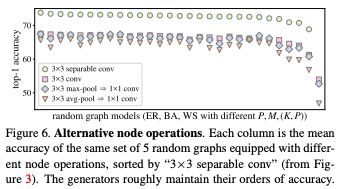

节点操作

图6

图 6 显示了图 3 中列出的每个生成器的平均精度。

结果比较

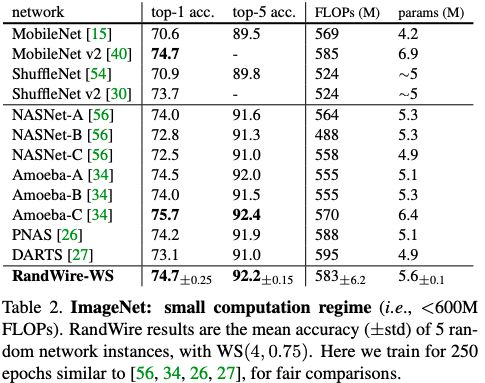

小型计算设置

表2

表 2 比较了在较小计算条件下的结果,这是现有 NAS 论文中研究的一种常见设置

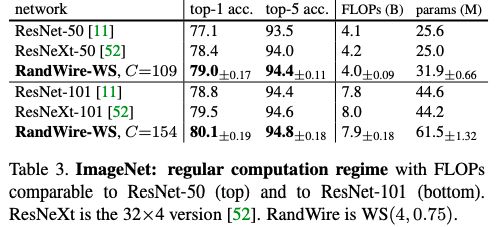

表3

表 3 比较了 RandWire 与 ResNet 和 ResNeXt 在与 ResNet-50/101 类似的 FLOPs 的情况下的性能。RandWire 的平均准确率分别比 ResNet50 和 ResNet-101 高 1.9% 和1.3%,比 ResNeXt 高 0.6%。

更大的计算条件

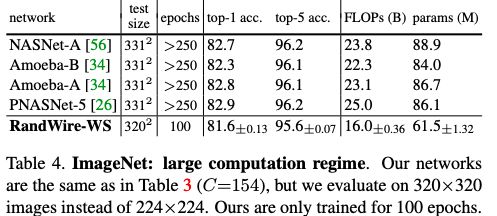

表4

表 4 比较了在更大计算条件下的结果

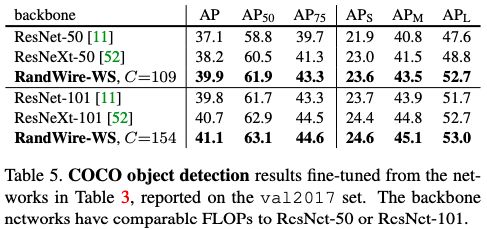

COCO 对象检测

最后,我们报告了通过微调网络进行 COCO 对象检测的结果。我们使用 Faster R-CNN和 FPN 作为目标探测器。

表5

表 5 比较了对象检测结果。观察到的趋势与表 3 中的 ImageNet 实验相似。这些结果表明,我们的随机连接网络学习到的特征也可以迁移。

论文地址:

https://arxiv.org/pdf/1904.01569.pdf

【2019 新智元 AI 技术峰会精彩回顾】

2019 年 3 月 27 日,新智元再汇 AI 之力,在北京泰富酒店举办 AI 开年盛典 ——2019 新智元 AI 技术峰会。峰会以 “智能云・芯世界 “为主题,聚焦智能云和 AI 芯片的发展,重塑未来 AI 世界格局。

同时,新智元在峰会现场权威发布若干 AI 白皮书,聚焦产业链的创新活跃,评述 AI 独角兽影响力,助力中国在世界级的 AI 竞争中实现超越。

嘉宾精彩演讲: