DALL-E 2允许用户「画脸」了!OpenAI:船新审核机制,不怕Deepfake作乱

![]()

新智元报道

新智元报道

【新智元导读】「AI艺术家」DALL-E 2宣布,准备允许用户上传和编辑人脸,自称安全机制已更新,不怕Deepfake泛滥。

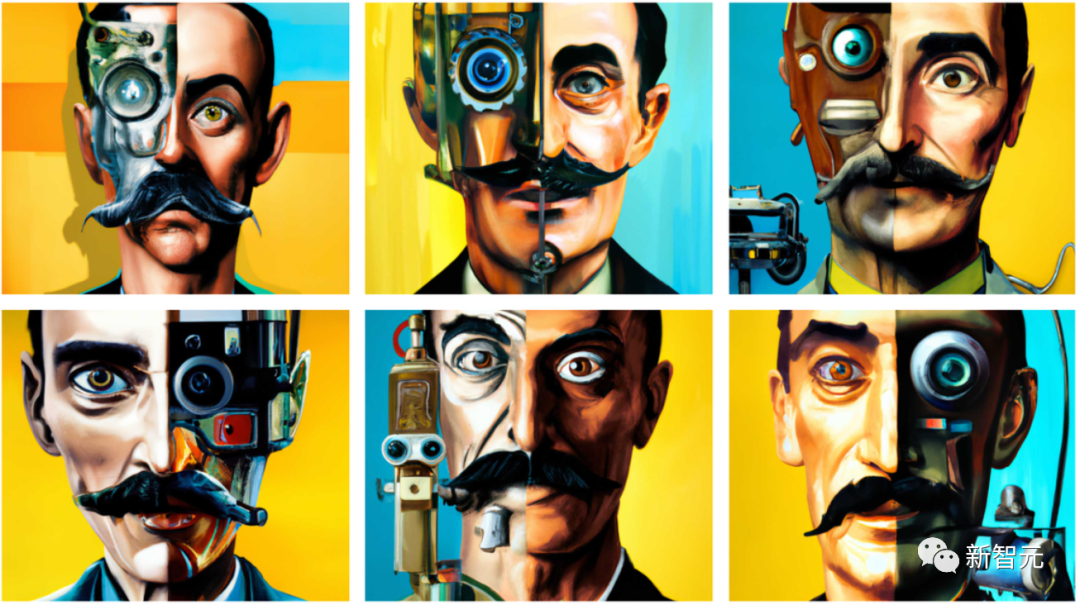

近来大火的「AI艺术家」DALL-E 2的东家 OpenAI 最近宣布,未来打算允许用户和DALL-E 2一起搞艺术创作,就从人脸开始。

OpenAI表示,有权访问DALL-E 2的客户可以使用AI驱动的图像生成系统上传人脸照片,并进行编辑。

这个功能此前是禁用的,OpenAI只允许用户使用和分享包含人脸的图片,但禁止上传任何可能描绘真实人物的照片,包括知名名人和公众人物的照片,更禁止编辑。

现在,OpenAI表示,由于安全系统得到了改进,可以将Deepfake以及关于性、政治和暴力内容的「潜在危害最小化」,所以,人脸图片的编辑功能可以开放。

在给客户的一封电子邮件中,OpenAI 表示:

很多人对我们讲,说怀念能用DALL-E为自己设计服装和发型,编辑家庭照片的背景的时候。一位整形外科医生告诉我们,他一直在使用DALL-E帮助病人生成可视化结果。电影制作人说,他们希望能够编辑与人在一起的场景图像,加快创作过程……所以我们建立了新的检测和响应技术,以防止滥用。

OpenAI的政策变了,允许开放,也不意味马上开放。

OpenAI的服务条款,恐怕还将继续禁止上传未经用户同意的照片或用户没有权利上传的图片——尽管目前还不清楚该公司在执行这些政策方面的一贯态度。

无论如何,这将是对OpenAI审核机制的一次真正考验。

过去,一些客户曾抱怨该技术「过于热心」,总是频频提醒,但这种提醒有时候并不准确。

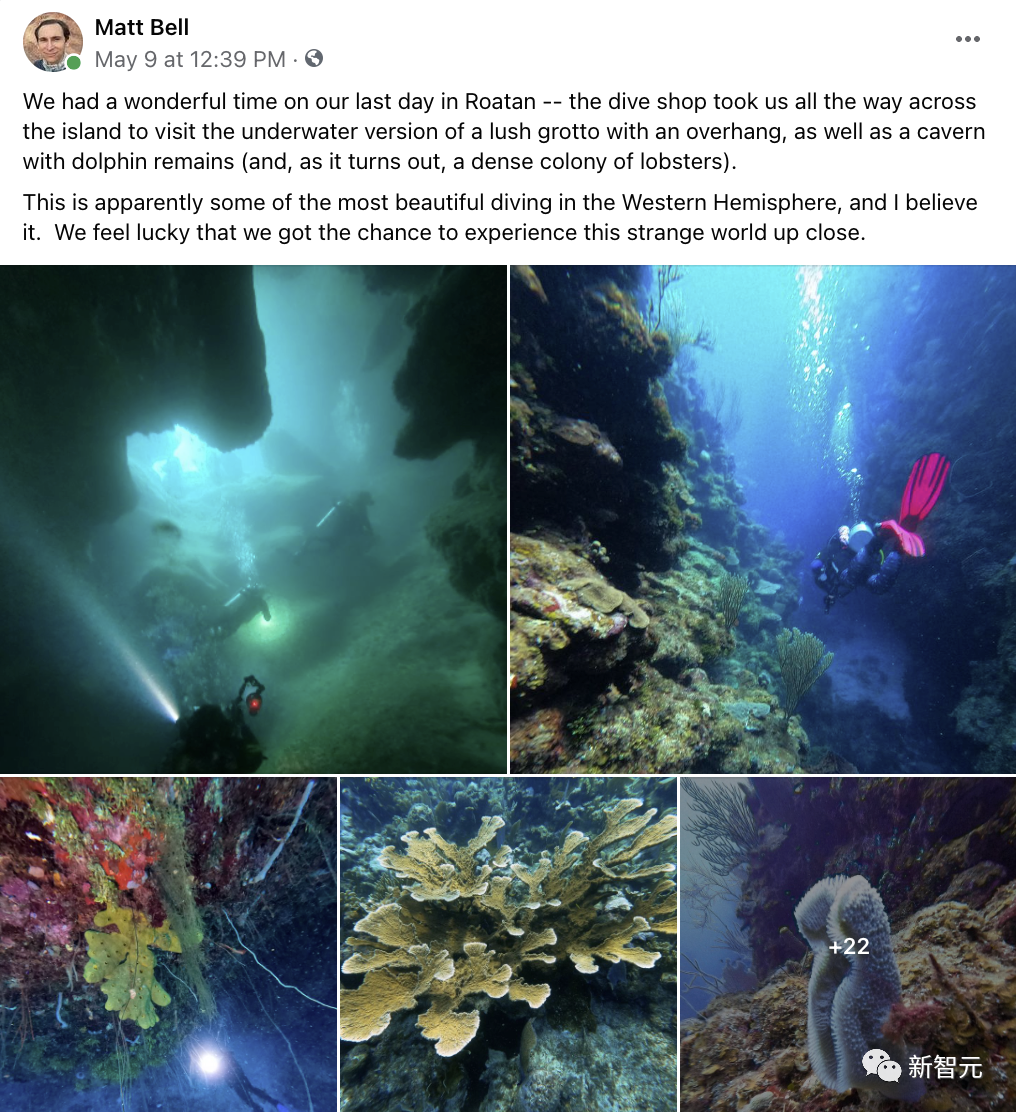

Deepfake有很多种形式,比如假的度假风景照:一个用户在Facebook上晒出了一些度假潜水时拍的照片。

实际上,这20多张照片中有4张是DALL-E 2 生成的图像。他把真假照片混在一起放在网上让大家猜,结果发现没有几个人能辨得出真假。

实际上,有83%的人根本没看出下面这4张照片是DALL-E 2生成的。

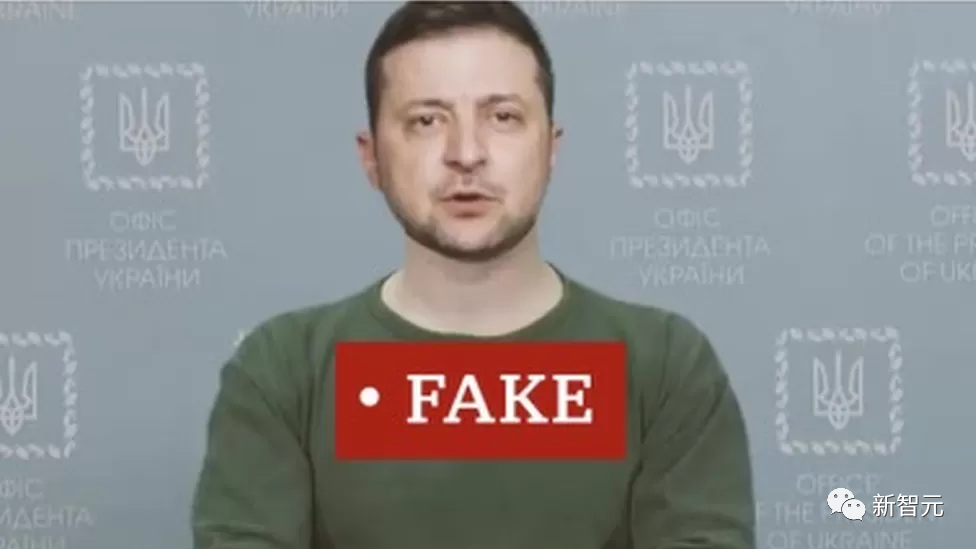

还有饱受战争蹂躏国家的总统照片,可以说,就没有Deepfake造不了假的图像。

如果说每出现一种Deepfake图像,都要做出一番解释,将是一场永无止境的战斗,在某些情况下,风险也非常大。

毫无疑问,得到了微软和包括Khosla Ventures在内的知名风投公司的支持的OpenAI,可不想像Stable Diffusion那样,将自己置于「引战」的位置。

此前,科技博客TechCrunch曾分析道,用不了多久,可以编辑脸部图像的Stable Diffusion就会被一些人用来制作带有色情的、未经授权的Deepfake名人照片。

迄今为止,OpenAI将自己定位为Stability AI之外的另一种选择:Stability AI崇尚自由,毫无限制,OpenAI则强调品牌亲民,遵纪守法。

由于DALL-E 2在最新的面部编辑功能依然有限制,可以认为该公司维持了现状。

目前,DALL-E 2仍然是处于测试版,用户没有开放注册,仍为邀请制。

8月底,OpenAI宣布,已经有超过100万人在使用这项服务。