真正的博士是如何参加AAAI, ICML, ICLR等AI顶会的?

(图源自视觉中国)

整理 | 一一

出品 | AI科技大本营(ID:rgznai100)

源于对学术的热爱,让很多人走上了博士这条求索之路,而热爱会让他们勤奋付出,勤奋让他们成为佼佼者。

在刚刚过去的 ICML 大会上,来自布朗大学计算机科学的博士生 David Abel 详细整理了一份 87 页的 ICML 大会笔记,包括 Tutorials, Main Conference, Workshops, 的会议内容和论文干货,并进行公开分享,随后学术界的朋友们开始转发收藏。

Tutorials 会议上主要介绍了 PAC-bayes 理论和元学习的内容。

此外,还介绍了深度强化学习,强化学习理论,多任务和终身学习和强化学习理论,强化学习和深度学习理论。

Workshops 部分包括用 AI 应对气候变化,强化学习用于真实生活场景以及真实世界的顺序决策三大部分。

David Abel 的每一篇论文笔记基本上不超过两页,是一分mini版本的论文概要,对论文的每一部分都做了简要总结。以 ICML 2019 主会上的一篇最佳论文《 Challenging Assumptions in Learning Disentangled Representations》为例,他先提出了是否能以无监督方法学习解耦表示的关键问题,随后定义问题,提炼了几点实验发现,最后给出了作者结论中的关键要点。

完整笔记下载链接看这里:

https://david-abel.github.io/notes/icml_2019.pdf

很多博士生可能觉得论文眼花缭乱看都不看不过来,更不要说整理出一份详细的笔记。而对很多还没有机会参加 ICML 这样顶级大会的人来说,显然,David Abel 的笔记成了他们的福音,有人说快要完全依赖他的笔记过活了。

事实上,优秀的人的优秀不是间隙性的,而是一种持续性的习惯。

除了 ICML 2019 的会议笔记外,这位小哥还曾在参加今年 2 月和 5 月举办的 AAAI 大会和 ICLR 顶会后做了详细的笔记,并进行公开分享。

ICLR 2019 大会笔记:

https://david-abel.github.io/notes/iclr_2019.pdf

AAAI 2019 大会笔记:

https://david-abel.github.io/notes/aaai_2019.pdf

当然,从 2017 年起参加的 7 次顶会后,他都做了相关笔记。

根据 David Abel 在自己主页的介绍,他在布朗大学专注于强化学习,师从主要从事强化学习 Michael Littman 教授,后者也从事机器学习、博弈论、计算机网络、马尔可夫决策过程等领域的研究工作,并 2018 年由于其“为人工智能的顺序决策算法的设计和分析做出的贡献”而被选为 ACM Fellow。

当然,作为一个如此认真的博士生,David Abel 也有一定的学术能力和研究成果。

在 AI 研究方面,他的研究调查了机器学习的基础及其在科学和社会挑战中的应用。

目前,他专注于理解抽象及其在 agency 中的作用,研究理性智能体如何模仿它们所处的世界,重点关注那些有效学习和规划的代表性实践。他通常使用强化学习范例,借鉴计算学习理论、概率和信息理论的工具。

他也非常关心 ML 对世界相关问题的负责任的应用,如计算可持续性的使命。

在主页里,David Abel 列出了他与其导师 Michael Littman 等人在各顶会上发布的数篇学术成果。

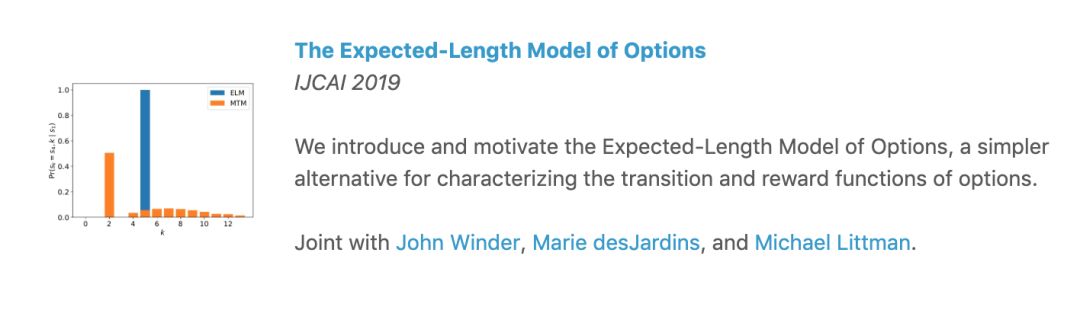

在 IJCAI 2019 上,发表了一篇《The Expected-Length Model of Options》的论文,他们引入并激励选项的期望长度模型,这是一个用于表征选项的过渡和奖励功能的更简单的选择。

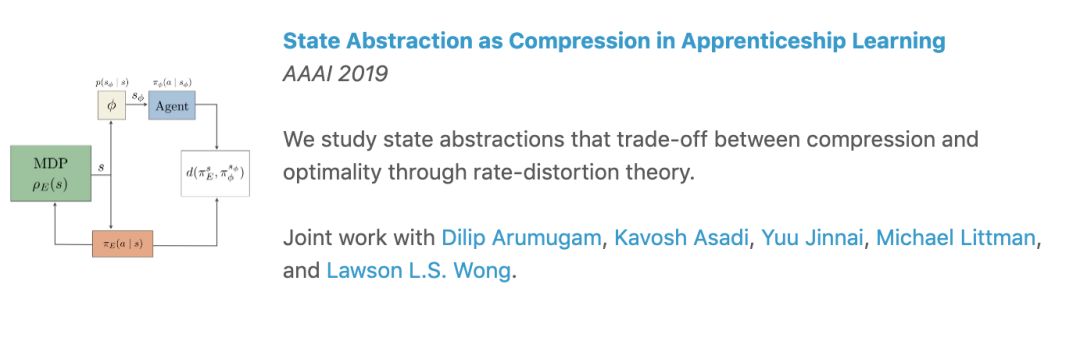

而在 AAAI 2019 上,发表了一篇《状态抽象作为学徒学习中的压缩 》(State Abstraction as Compression in Apprenticeship Learning )。他们通过速率 - 失真理论(rate-distortion theory)研究了状态抽象(state abstractions),以在压缩和最优性之间进行权衡。

同样在 ICML 2019,发表了《通过探索最小化覆盖时间来发现选项》(Discovering Options for Exploration by Minimizing Cover Time ),他们提出了一种基于最小化覆盖时间探索的选项发现方法。

在 preprint 2018 上,发表了《在基于模型的强化学习中减轻计划器的过度拟合》(Mitigating Planner Overfitting in Model-Based Reinforcement Learning),他们探索了不同的方法来避免基于模型的 RL 中规划过度拟合。

发论文之余,David Abel 还有不错的的教学经历。

2017 年夏天,他在布朗大学的 STEM II 夏季课程中教授“人工智能与社会”课程,该课程探讨了人工智能的核心思想,以及人工智能和自动化会对社会产生的影响。

此外,他自己还制作了一份简单的 Python 教程。

David Abel 主页地址:

https://david-abel.github.io/

(*本文为 AI科技大本营整理文章,转载请微信联系 1092722531)

◆

精彩推荐

◆

想跟NVIDIA专业讲师学习TensorRT吗?扫码进群,获取报名地址,群内优秀提问者可获得限量奖品(定制T恤或者技术图书,包邮哦~)

NVIDIA TensorRT是一种高性能深度学习推理优化器和运行时加速库,可以为深度学习推理应用程序提供低延时和高吞吐量。通过TensorRT,开发者可以优化神经网络模型,以高精度校对低精度,最后将模型部署到超大规模数据中心、嵌入式平台或者汽车产品平台中。

推荐阅读