学界 | 谷歌联手OpenAI等发布可视化机器学习平台Distill,创始人详述创立背景

机器之心报道

参与:微胖、蒋思源

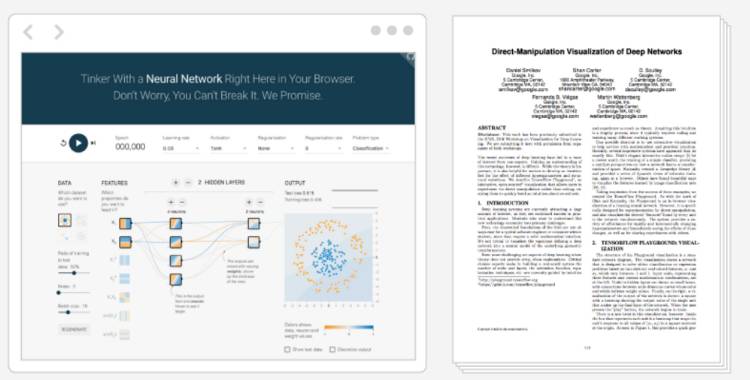

传统学术发表形式是 PDF 文件。但是,这种文件形式阻碍社区以一种新的互动创造性的方式共享科研成果。Distill 是一个现代的交互、视觉化期刊平台,面向现有以及新的机器学习研究成果。Distill 使用了现代用户界面,注重对研究的理解与诠释。这个平台包括三部分:一份期刊,一份奖金,还有各种创作互动文章的工具。

官方网址:http://distill.pub/

一种新的交互视觉化期刊平台 Distill 今天正式启动。

Distill 的发布得到了社区巨大支持,谷歌大脑的 Chris Olah 和 Shan Carter 是创始人,也是 Distill 整体愿景勾勒和执行的关键人物。

和每个科学研究领域一样,在机器学习领域,学术交流重要性在怎么强调都不会过分。

机器学习社区一直欢迎新的科研交流形式。现有的交流方式是在传统期刊上发表论文,在 arXiv 上托管,由代码库以及社区力量予以支持,比如 JMLR 和 JAIR,通过会议和调查、海报、博文、视频、演示、播客以及访谈的方式进行传播交流。

在这一背景下,Distill 做出了自己独特的贡献:以一种新的互动创造性方式分享科研成果。

网页是一种分享新思考方式的强大媒介。过去几年中,我们已经看到过许多富有想象力的这方面例子(http://colah.github.io/)。Distill 是一个新的独立、基于网页的媒体,面向清晰、开放(解密)的机器学习研究。包含三个部分:一个期刊,一份奖金,还有创作互动文章的各种工具。

Olah 在博客中表示,「我并没打算在这个网站上(http://colah.github.io/)写更多的关于深度学习的文章,我会成为 Distill 的联合编辑。Distill 是一个机器学习领域里的虚拟、交互期刊,侧重点是读者理解。我相信,这个平台能让我更好地服务研究社区。如果你喜欢我的博客,你最好首先在 Distill 上找我的文章。那上面的文章肯定比这里的内容要好很多。」

Distill 以标准方式集成到传统学术出版系统中(ISSN 和 CrossRef 等)。Distill 的文章将显示在谷歌学术中,这将有助于作者获得学术影响力。Distill 的文章也将根据知识共享署名许可证(Creative Commons Attribution licenses)进行许可。

诞生背景:「研究欠债」

Olah 表示,colah.github.io 很让我引以为傲。这些文章的阅读量已经超过 200 万次,有些文章已经成为大学课程的必读参考文献。但是我还是想解释一下为什么要搬到 Distill。

事实上,我对自己的研究工作已深感不安。我对研究社区做出的首要贡献就是除了理解机器学习,就是还知道如何将这种理解描绘出来(让他人更直观进行理解)。当然,我也做过一些有用的研究贡献。但是,我着力的地方是解释和消化其他人的研究发现。我很难不去认为,较之好的研究,这类研究的重要性仅是第二位的。

大约一年前,一些事情让我对此感到不安。我开始担心自己没法尽自己所能做出最好的研究,我感觉自己的研究工作有点不那么正统。我试着抛开这些想法,但是没用。我必须为自己找一个合理的解释。

我的答案是研究欠债(Research Debt)。

当人们都冲向新发现而不注重交流沟通这些新发现时,就会出现研究欠债的问题。

比如,当我们匆忙改完论文以满足大会的最后期限时,通常会有一些交流上的可读性和清晰性等问题。读者很难理解作者的想法,这可能给整个社区带来严重影响。

研究领域会变得嘈杂,能量也会随之被耗尽。在这样一个环境下,有人注重增进理解、清晰和交流沟通会非常有价值,这些人扮演着某种「研究蒸馏器(research distiller)」的角色。清晰的写作让每个人受益。

Distill 的价值意义

1、合法化非传统研究作品。

许多研究人员想要从事的研究工作并不能轻易包含在传统 PDF 论文中,这些人也无法获得从事这类工作的支持。作为研究社区的成员,如果没有将这些非传统、精彩研究作品视为真正的学术贡献,我们是在辜负这些研究人员的心血。

对我来说,这么做并不仅仅是看起来很重要。我希望看到更多的人去做这类工作。当然,已经有不少人或多或少在这片领域里耕耘了,但是这些研究只占他们工作的一小部分,而且还是非正式的方式。通过与他们交流,我开始发现,对此感到不安、倍受压力的人并非我一人。

我希望他们得到更多的支持。我特别想要支持那些可能『以此为生』的人,虽然会有一些很漂亮的工作等着你,如果你成了一名优秀的『研究蒸馏器』,但是,其中运行机制是非正式的,外部人也看不到它们,这确实是在冒险。我们能做的更漂亮些。

Distill 是一个机遇,我们可以开始打造这种生态系统。Distill 期刊会为这类研究工作提供渠道,将其正统化成为一种真正的学术贡献。Distill Prize(我拿出了 2 万 5 千美元)将会颁给这一领域的杰出研究工作。当然,还有很多工作要做,这仅仅是第一步。

另外,科学研究不是一个人的单打独斗,而是协作。无论是新研究还是解释性工作,都是如此。当你试着解释新研究时,更是如此。

不幸的是,个人博客并不能有效实现这一点。博客会给博主以及组织博客带来更多声誉,但排除了组织之外的协作者,也常常降低了个体贡献者的重要性。

Distill 是一个中立平台。就像传统的论文,我们也会在论文顶部列出作者及其所属机构的名称。不过,Distill 会深入创作背景,聚焦作者和他们的研究工作。

2、作为新的平台,Distill 提供了让新发现成为可能的新思维方式。

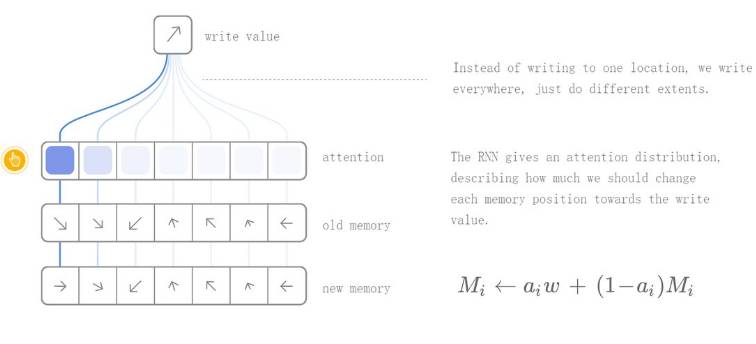

一些新的符号、视觉化以及思想模型都能加深我们的理解。通过孕育这类新的思维方式,Distill 为新发现创造可能。

3、机器学习需要更多的透明性。

机器学习会从根本上改变人类与计算机的交互方式。因此,让这些技术变得透明非常重要,借此我们也能了解和安全掌控系统运作方式。Distill 会为生动展示这些思想提供平台。

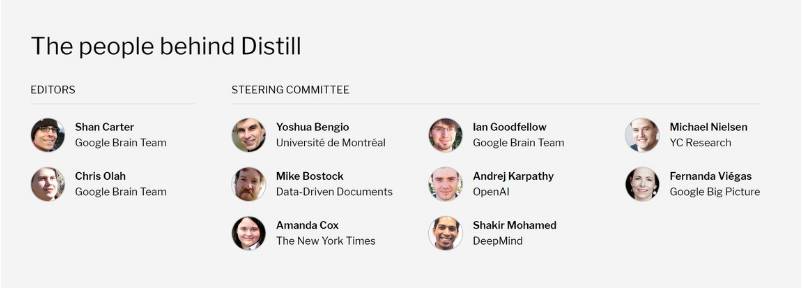

幕后团队

Distill 的发布得到了社区巨大支持。谷歌大脑的 Chris Olah 和 Shan Carter 是创始人,也是 Distill 也是整体愿景和执行的关键人物。

Chris 和 Shan 在创造超高品质解释文章和视觉材料方面有着大量的经验。他们致力于支持作者创造高品质博文、视觉和动态元素。

OpenAI 的 Andrej Karpathy 在指导委员会负责文章发表,Greg 协助筹集奖金。

DeepMind 也是 Distill 奖金(Distill prize)的赞助者。Shakir Mohamed 是指导委员会成员,其他成员还有 Yoshua Bengio, Ian Goodfellow 等人。

colah.github.io 的命运

Colah 还谈到了一点愿望:希望将不同类型的文章分配给不同的平台。

随着 colah.github.io 崭露头角,我也得到了回报,但也会有些不舒服。

一方面,它为自己的写作提出了非常高的标准。几乎所有文章都花去自己 50 到 200 个小时的时间。我觉得自己不能辜负每篇博文的水准,但这也意味着不投入巨大精力就不能把自己的想法写出来。

另外,这里也不方便谈论其他议题。我对动物福利怀有强烈的情感,或许其他人对此持异议。我也有些不寻常的经历,比如大学退学以支持被起诉的恐怖分子,这些也是我想写的内容。但是,如果写出来又有点像滥用了深度学习社区给予我的知名度,毕竟这个平台是用来讨论深度学习问题的。

如果将深度学习方面的写作专门独立出来,我就有更多的空间来谈论我的私人兴趣。或许未来你们会看到这样的文章:和 Chris 一起做素食(Vegan Cooking with Chris)

目前,平台已经有了一些「存货」。有兴趣的读者可以前往:

神经网络中的注意力:http://distill.pub/2016/augmented-rnns

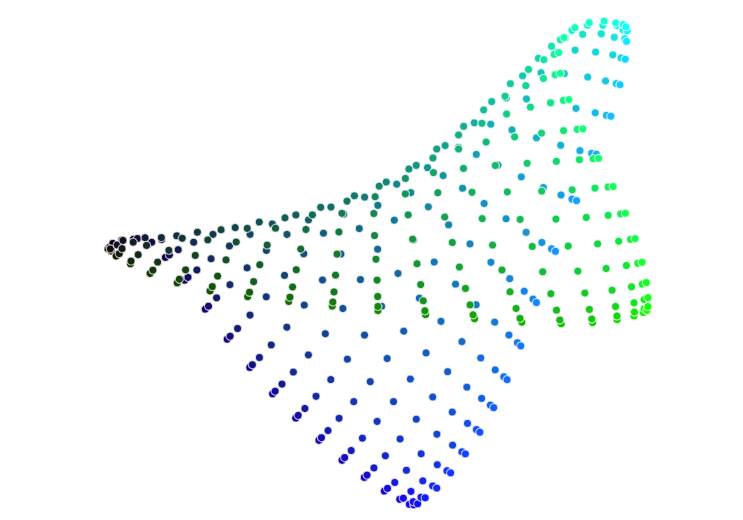

使用 t-SNE 可视化高维数数据:http://distill.pub/2016/misread-tsne/

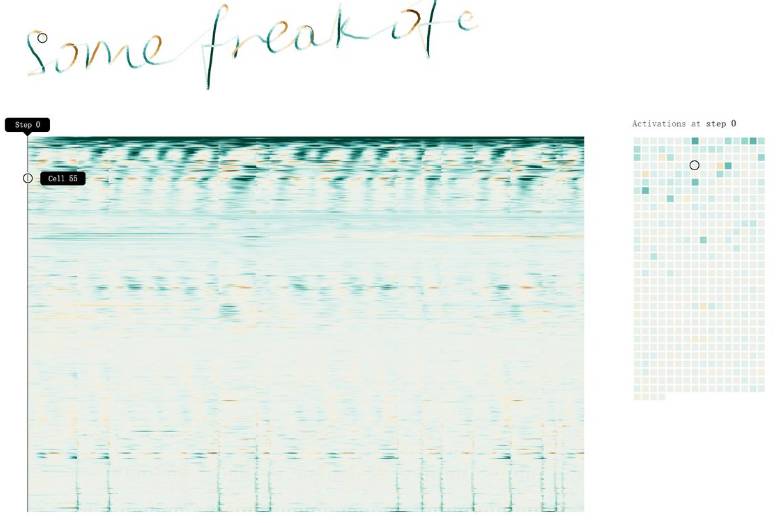

使用神经网络生成手写体:http://distill.pub/2016/handwriting/

本文为机器之心编译,转载请联系本公众号获得授权。

✄------------------------------------------------

加入机器之心(全职记者/实习生):hr@jiqizhixin.com

投稿或寻求报道:editor@jiqizhixin.com

广告&商务合作:bd@jiqizhixin.com