老黄狂拼CPU!英伟达掏出800亿晶体管显卡,外加世界最快AI超算Eos

![]()

新智元报道

新智元报道

编辑:编辑部

【新智元导读】「拼装」CPU,4纳米显卡,世界最快AI超算,还有游戏开发者的元宇宙。这次,老黄的百宝箱里都有啥?

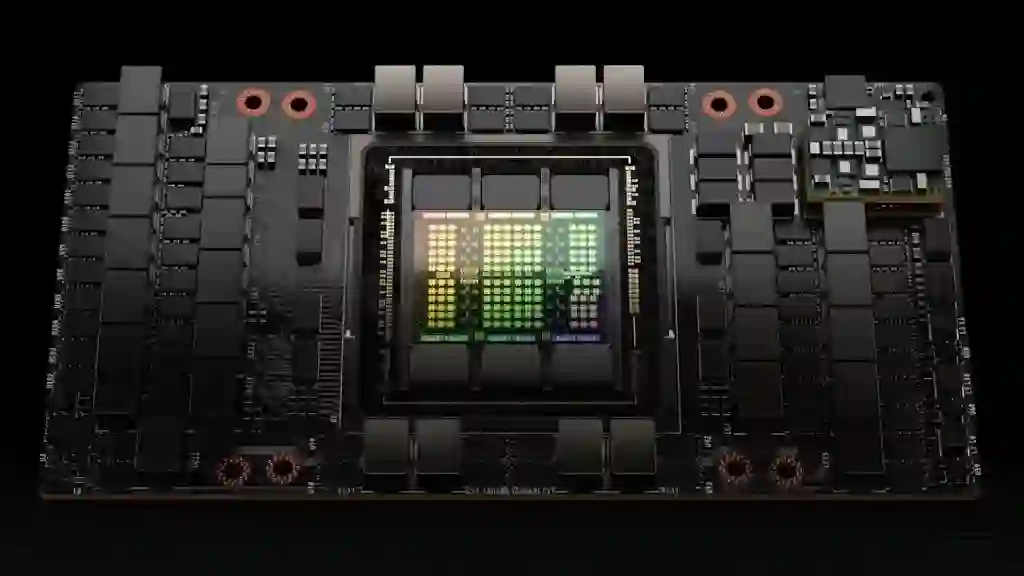

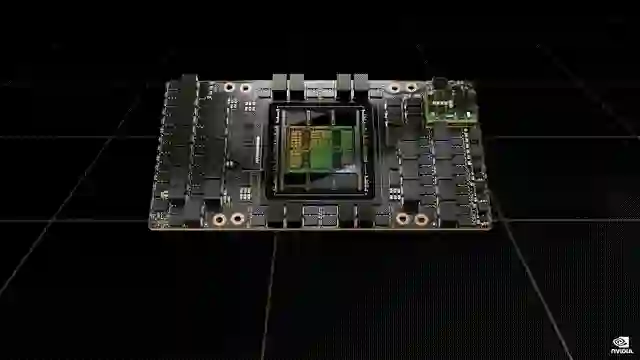

800亿个晶体管的Hopper H100

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

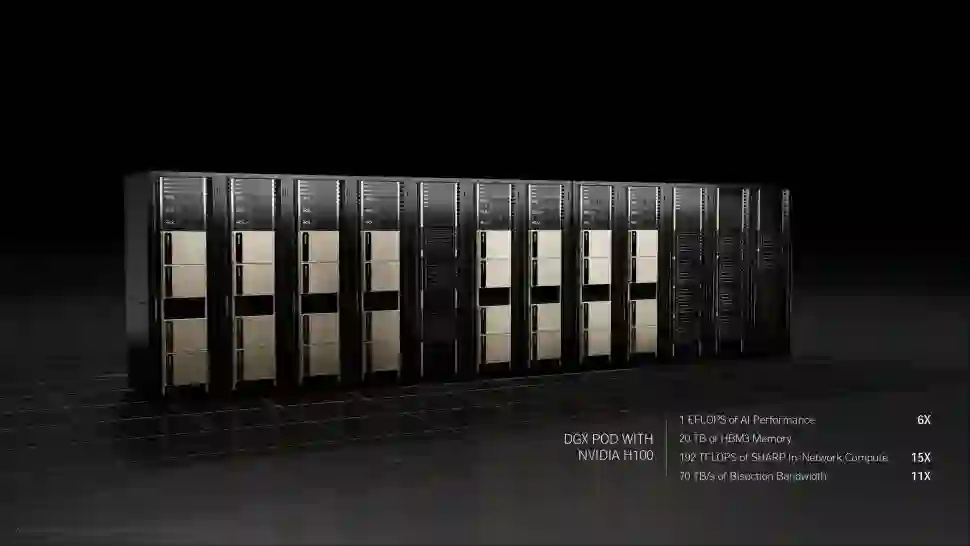

DGX服务器系统

世界上最快的AI超算

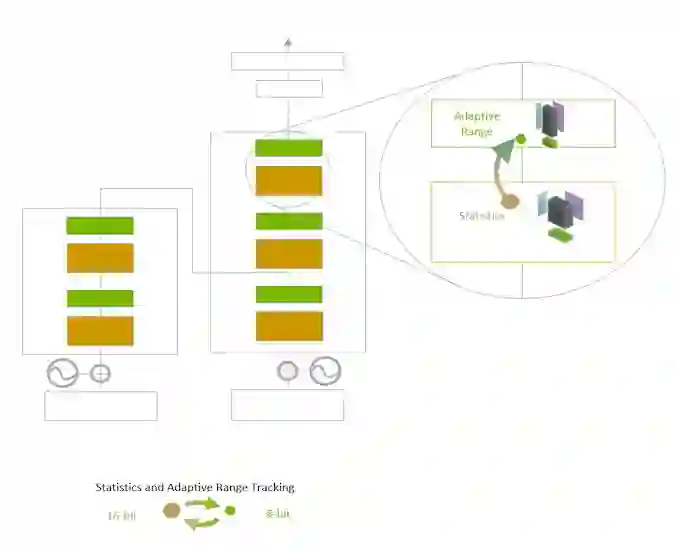

Transformer Engine

Grace CPU超级芯片

Grace CPU超级芯片

-

2个72核芯片,高达144个Arm v9 CPU核心 -

采用ECC技术的新一代LPDDR5x内存,总带宽为1TB/s -

SPECrate 2017_int_base得分预计超过740 -

900GB/s 一致性接口,比PCIe 5.0快7倍 -

封装密度比DIMM解决方案提高了2倍 -

每瓦性能2倍于当今领先的CPU

安培架构再添新品

安培架构再添新品

游戏开发者也有元宇宙了

游戏开发者也有元宇宙了

-

Omniverse Audio2Face ,一款由NVIDIA AI驱动的应用,使角色艺术家通过音频文件生成高质量的面部动画。Audio2Face支持完整的面部动画,艺术家们还能控制表演的情感。有了Audio2Face,游戏开发者可以快速、轻松地为其游戏角色添加逼真的表情,促进玩家和游戏角色之间更强的情感连接,增强沉浸感。

-

Omniverse Nucleus Cloud 现已开放抢先体验版,可实现Omniverse场景的一键式简单共享,无需在本地或私有云中部署Nucleus。通过Nucleus Cloud,游戏开发者可轻松地在内、外部开发团队之间实时分享和协作3D资产。

-

Omniverse DeepSearch 是一项AI服务,现在可供Omniverse企业用户使用,它允许游戏开发者使用自然语言输入和图像来即时搜索其整个未标记的3D资产、物体对象和角色目录。

-

Omniverse Connectors 实现第三方设计工具和Omniverse之间的「实时同步」协作工作流的插件。全新虚幻引擎5 Omniverse Connector允许游戏艺术家在游戏引擎和Omniverse之间交换USD和材料定义语言数据。

将数据中心转变为「AI工厂」

将数据中心转变为「AI工厂」

参考资料:

https://www.nvidia.cn/gtc-global/keynote/

登录查看更多

相关内容

NVIDIA(全称NVIDIA Corporation,NASDAQ:NVDA,发音:IPA:/ɛnvɪdɪə/,台湾官方中文名为輝達),创立于1993年4月,是一家以设计显示芯片和芯片组为主的半导体公司。NVIDIA亦会设计游戏机核心,例如Xbox和PlayStation 3。NVIDIA最出名的产品线是为个人与游戏玩家所设计的GeForce系列,为专业工作站而设计的Quadro系列,以及为服务器和高效运算而设计的Tesla系列。

NVIDIA的总部设在美国加利福尼亚州的圣克拉拉。是一家无晶圆(Fabless)IC半导体设计公司。"NVIDIA"的读音与英文"video"相似,亦与西班牙文evidia(英文"envy")相似。现任总裁为黄仁勋。

Arxiv

0+阅读 · 2022年4月20日