人机游戏有着悠久的历史,已经成为验证人工智能关键技术的主流。图灵测试可以说是人类首次进行人机对抗测试,这激发了研究人员设计各类 AI 来挑战职业人类玩家。例如,1989 年研究者开发了国际跳棋程序 Chinook,目标是击败世界冠军,1994 年 Chinook 打败了美国西洋跳棋棋王 Marion Tinsley。在之后的时间里,IBM 的深蓝在 1997 年击败国际象棋大师 Garry Kasparov,开创了国际象棋史上的新纪元。

近年来,我们见证了游戏 AI 的快速发展,从 Atari、AlphaGo、Libratus、OpenAI Five 到 AlphaStar 。这些 AI 通过结合现代技术在某些游戏中击败了职业人类玩家,标志着决策智能领域的快速发展。

AlphaStar(DeepMind 开发的计算机程序) 和 OpenAI Five(美国人工智能研究和 OpenAI 开发)分别在星际争霸和 Dota2 中达到了专业玩家水平。现在看来,目前的技术可以处理非常复杂的不完美信息游戏,特别是在最近大火的王者荣耀等游戏中的突破,它们都遵循了类似 AlphaStar 和 OpenAI Five 的框架。我们不禁会问:人机游戏 AI 的未来趋势或挑战是什么?来自中国科学院自动化研究所以及中国科学院大学的研究者撰文回顾了最近典型的人机游戏 AI,并试图通过对当前技术的深入分析来回答这些问题。

![]()

论文地址:https://arxiv.org/pdf/2111.07631.pdf

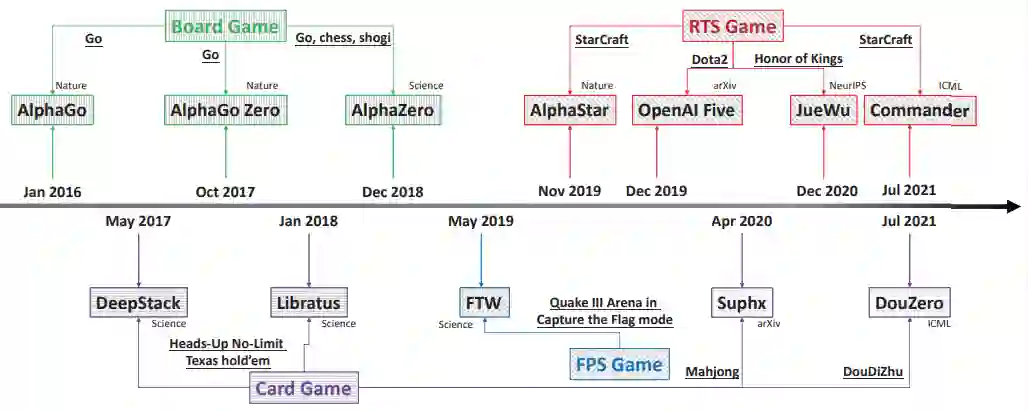

具体而言,该研究总共调查了

四种典型的游戏类型

,即围棋棋盘游戏;纸牌游戏(德州扑克 HUNL、斗地主和麻将);第一人称射击类游戏 (FPS)(雷神之锤 III 竞技场);实时战略游戏 (RTS)(星际争霸、Dota2 和王者荣耀) 。上述游戏对应的 AI 包括 AlphaGo、AlphaGo Zero 、AlphaZero、Libratus、DeepStack、DouZero、Suphx、FTW、AlphaStar、OpenAI Five、JueWu 和 Commander。图 1 为一个简短的概要:

![]()

总体而言:在第 2 节中,该研究描述了本文涵盖的游戏和使用的AI;第 3-6 节分别阐述了棋盘游戏、纸牌游戏、FPS 游戏和 RTS 游戏对应的 AI;在第 7 节总结并比较了各类游戏所使用的不同技术;在第 8 节展示了当前游戏 AI 面临的挑战,这些挑战可能是该领域未来的研究方向。最后,第 9 节对论文进行了总结。

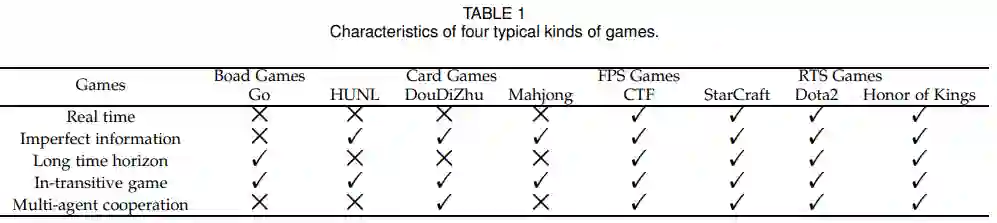

下表提取了不同游戏挑战智能决策的关键因素,如表 1 所示:

![]()

上表列出了不同游戏的优缺点,我们需要根据不同的游戏类型,分配不同的 AI。因为不同的游戏具有不同的特点,其解决方案也各不相同,因此研究者开发了不同的学习策略来构建 AI 系统。在本文中,AI 被进行不同的分配:AlphaGo、AlphaGo Zero、AlphaZero 用于棋盘游戏;Libratus、DeepStack、DouZero 和 Suphx 分别用于纸牌游戏 HUNL、斗地主和麻将;FTW 用于 FPS 游戏中的雷神之锤 III 竞技场;AlphaStar、Commander、OpenAI Five 和 JueWu 分别用于星际争霸、Dota2 和王者荣耀。

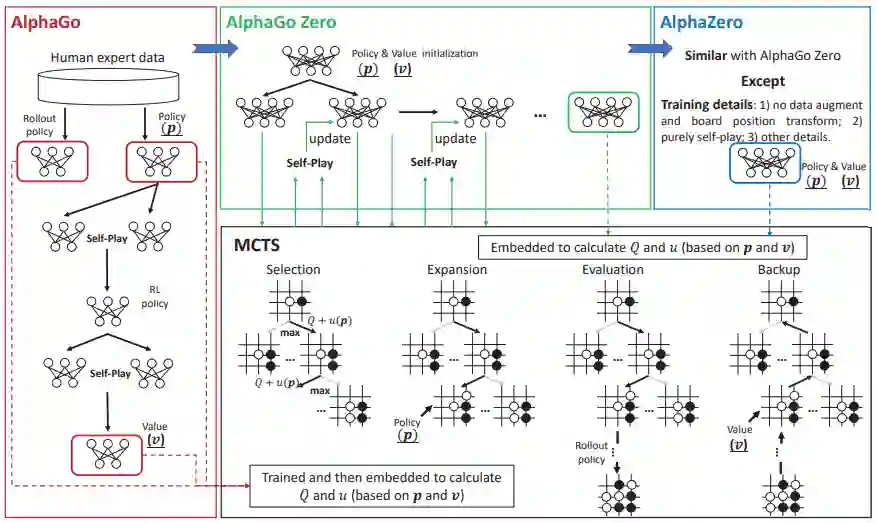

AlphaGo 系列由 AlphaGo、AlphaGo Zero 和 AlphaZeo 组成。2015 年问世的 AlphaGo 以 5:0 击败欧洲围棋冠军樊麾,这是软件首次在全尺寸棋盘对职业棋手的比赛中取得这样的成绩。之后,DeepMind 为 AlphaGo Zero 开发了新的训练框架,事先无需专业的人类对抗数据,取得了卓越的表现。AlphaZero,是一种通用强化学习算法。AlphaGo 系列总结如图 2 所示:

![]()

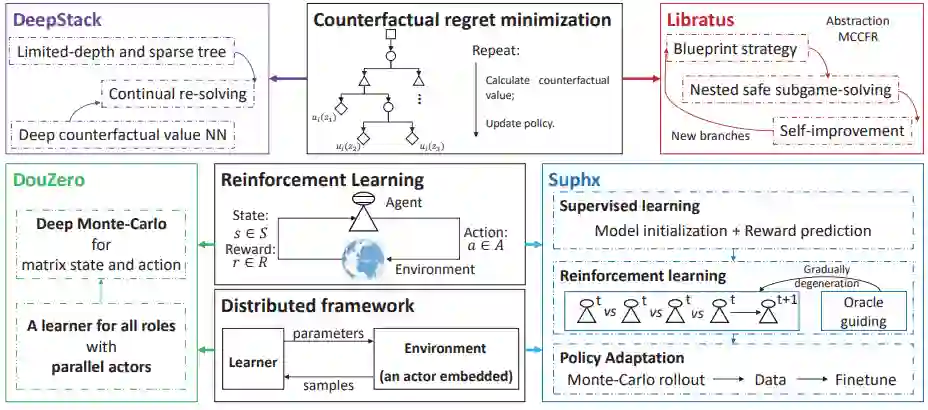

纸牌游戏作为典型的不完美信息游戏,长期以来一直是人工智能的挑战。DeepStack 和 Libratus 是在 HUNL 中击败职业扑克玩家的两个典型 AI 系统。它们共享基础技术,即这两者在 CFR 理论上相似。之后,研究人员专注于麻将和斗地主这一新的挑战。由微软亚洲研究院开发的 Suphx 是第一个在麻将中胜过多数顶级人类玩家的人工智能系统。DouZero 专为斗地主设计,这是一个有效的 AI 系统,在 Botzone 排行榜 344 个 AI 智能体中排名第一。纸牌游戏 AI 的简要框架如下图所示:

![]()

雷神之锤 III 竞技场是一款典型的 3D 多人第一人称视角电子游戏,其中两个对立的团队在室内或室外地图中相互对抗。CTF 设置与当下多人电子游戏有很大不同。更具体地说,CTF 中的智能体无法访问其他玩家的状态,此外,团队中的智能体无法相互通信,这样的环境是学习智能体进行通信和适应零样本生成最优测试平台。零样本意味着智能体进行协作或对抗不是经过训练而来的,可以是人类玩家和任意的 AI 智能体训练而来,仅基于像素和人类等游戏点作为智能体的输入,学习智能体 FTW 框架可以达到人类级性能。游戏 CTF 的 FTW 框架如下图所示:

![]()

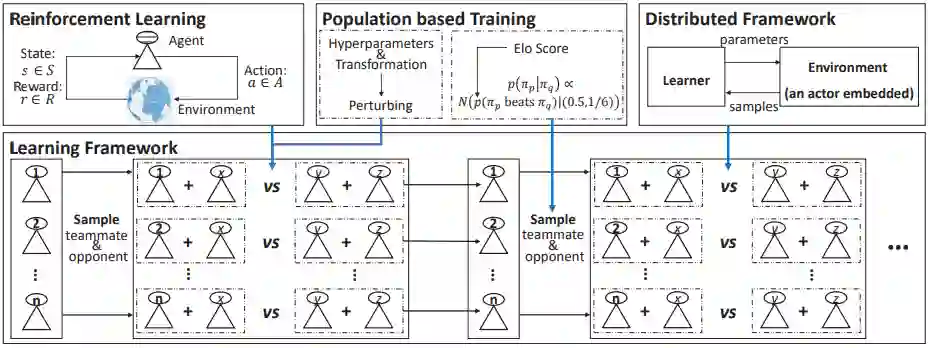

RTS(即时战略)游戏作为一种典型的电子游戏,多达数万人相互对战,RTS 通常被作为人机游戏的试验台。此外,RTS 游戏通常环境复杂,比以往游戏更能捕捉现实世界的本质,这种特性使得此类游戏更具适用性。DeepMind 开发的 AlphaStar 使用通用学习算法,在星际争霸的所有三个种族中都达到了大师级别,其性能超过 99.8% 的人类玩家(总数约 90000 名玩家)。Commander 作为轻量级的计算版本,遵循 AlphaStar 相同的训练架构,使用更少的计算量级,并在现场赛事中击败两名特级高手。OpenAI Five 旨在解决 Dota2 游戏,这是第一个在电子竞技游戏中击败世界冠军的 AI 系统。作为与 Dota2 比较相似的电竞游戏,《王者荣耀》面临的挑战最为相似,觉悟成为第一个可以玩完整 RTS 游戏而不限制英雄池的 AI 系统。典型 RTS 游戏的简单 AI 框架如下图所示:

![]()

尽管计算机游戏已经取得了很大的进步,但当前技术仍然面临着诸多挑战,例如大量依赖计算资源等,这将激发未来的研究。

如今,大模型,尤其是预训练大模型,正在从自然语言处理发展到计算机图像处理,从单模态到多模态。即使在零样本设置中,这些模型也证明了其在下游任务的巨大潜力,这是探索通用人工智能的一大步。

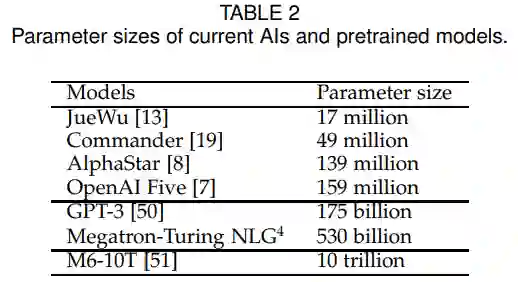

OpenAI 开发了 GPT-3,它拥有超过 1750 亿个参数,并在各种语言相关任务中表现出良好的性能。然而,游戏中的大模型基本没有,当前复杂游戏的模型比那些参数多的大模型要小得多。如表 2 所示,AlphaStar 和 OpenAI Five 分别只有 1.39 亿和 1.59 亿的参数:

![]()

考虑到大模型是对通用人工智能的一个比较好的探索,如何在游戏中为人工智能设计和训练大模型,可能会为那些时序决策领域提供新的解决方案。为了进行这样的尝试,该研究认为至少应该仔细考虑两个问题:

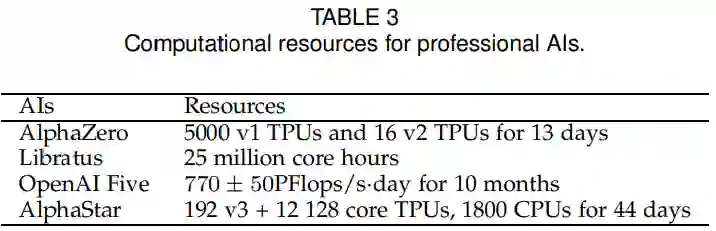

为了在复杂环境中训练专业级 AI,通常需要大量的计算资源。从表 3 得出我们需要大量的资源投入来训练 AI。

![]()

我们不禁会问,是否可以在资源有限的情况下训练出专业级的人工智能。一个直观的想法是引入更多的人类知识来辅助学习,强化学习可以说是未来的一个发展方向。另一方面,开发出理论和易于计算的进化策略,将是低资源人工智能系统的关键一步。

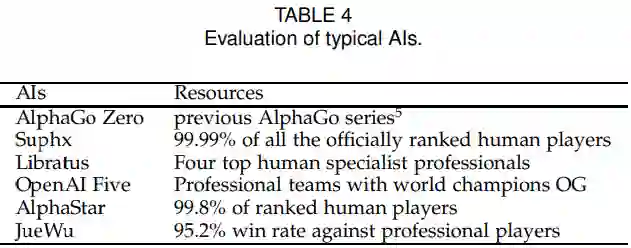

目前,对智能体的精确评估成为一个难题。人机游戏通常采用基于获胜概率(对职业人类玩家)的评价标准,如表 4 所示。但是,这种评价比较粗糙,尤其是在有限的非迁移游戏测试下。如何为大多数游戏制定一个系统的评价标准是一个重要而开放的问题。

![]()

通过这篇文章,研究者希望初学者能够快速熟悉游戏 AI 这个领域的技术、挑战和机遇,并能启发在路上的研究人员进行更深入的研究。

详解NVIDIA TAO系列分享第2期:

基于Python的口罩检测模块代码解析——快速搭建基于TensorRT和NVIDIA TAO Toolkit的深度学习训练环境

第2期线上分享将介绍如何利用NVIDIA TAO Toolkit,在Python的环境下快速训练并部署一个人脸口罩监测模型,同时会详细介绍如何利用该工具对模型进行剪枝、评估并优化。

TAO Toolkit 内包含了150个预训练模型,用户不用从头开始训练,极大地减轻了准备样本的工作量,让开发者专注于模型的精度提升。本次分享摘要如下:

-

-

-

利用TAO Toolkit快速训练人脸口罩检测模型

-

![]()

© THE END

转载请联系本公众号获得授权

投稿或寻求报道:content@jiqizhixin.com