业界|David Patterson教授加入谷歌TPU团队,跟英伟达的好戏才刚刚开场

AI科技评论按:前几天我们刚刚强势围观了英伟达发布专门为机器学习设计的V100 GPU,成倍的性能提升让人眼红,也让人为谷歌的TPU捏一把汗。但是谷歌也没闲着,AI科技评论了解到,计算机架构方面的重量级人物,加州伯克利大学的David Patterson教授已经公开宣布了自己加入谷歌TPU团队的消息。另外,虽然谷歌TPU团队已经有多人集体出走自行成立公司做芯片研发,但这另一方面也表明了TPU会作为独立的一项商品走上计算硬件市场。好戏才刚刚开场。

2016年5月,加州伯克利大学的David Patterson教授决定退休了。学校给他举办了一个退休典礼,纪念他在计算机架构方面的40年学术生涯。Patterson教授自己做了一个视频,从他高中和大学时训练摔跤、在加州大学洛杉矶分校学习数学专业,一直记录到在休斯飞机公司找到工作,然后在伯克利的学术研究中度过了40个春秋。

Patterson教授是RISC的支持者之一。相比普通计算机,RISC(Reduced Instruction Set Computer精简指令集计算机)通过去除不常用的单元、专注于最常用单元的方式,降低了设计制造难度,能以类似的性能大幅度降低功耗。手机用的ARM处理器就是一种RISC处理器。Patterson教授在伯克利大学带领团队长期进行着RISC的研究,对全世界RISC处理器的研发和相关应用做出了巨大贡献;他与斯坦福大学John Hennessy教授合署的两本书《计算机架构:一种量化的途径》和《计算机的组织和设计:硬件软件界面》自1990年来就广泛用作研究生和本科生的课本,影响力巨大;他在2003年到2005年间是美国总统信息技术咨询委员会成员,2004到2006年间任国际计算机学会主席;他还是磁盘阵列RAID的研发者之一。

合著影响全球的书,还有在国际计算机研究协会任主席,都是旁人看来很成功的事情。Patterson教授在退休典礼上向听众分享了他的成功秘诀:一次只做一件大事。

他的下一件大事很有可能会做得很大、非常大。

TPU的故事

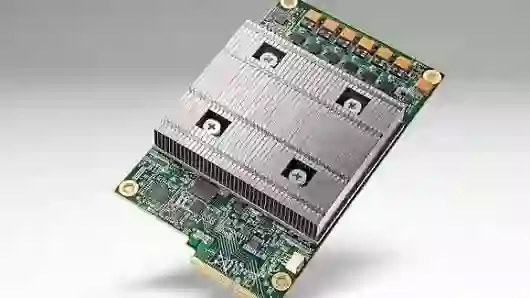

别人退休以后一般都去沙滩舒舒服服晒太阳去了,但是Patterson教授在5月退休以后,同年7月就去了谷歌。谷歌那时已经在野心勃勃地开发一款新的芯片,想要比当时市面上的处理器至少快10倍,而且它还要能足够全面,能够搞定人工智能对复杂计算能力的要求。

谷歌把它称作TPU(Tensor Processing Unit,张量计算单元),Patterson教授去谷歌担任了主力研发人员。最近他才给伯克利大学的100多个学生和老师们讲了自己在谷歌研发TPU的消息,这时他的退休典礼都快满一周年了。

“4年前谷歌内部就有这种担心,然后公司高层出面做了决定”。他们担心,如果每一个安卓用户每天有三分钟的对话要通过谷歌的机器学习技术进行翻译的话,“我们现有的数据中心可能需要再翻一倍”。说这话的时候,今年69岁的Patterson教授穿着谷歌的研发部门Google Brain的T恤衫。

谷歌母公司Alphabet购买资产的支出已经达到了每年10亿美元,很大一部分都用来新建数据中心。现在数据中心有了一个新的主题,谷歌把它叫做“人工智能的复兴”。深度神经网络,也就是能够运行特定的模型,然后随着训练数据的变多和变复杂来不断学习、不断变得更聪明的计算机,正渴求着计算效率的革命性提升。

Google上个月发布了一份关于TPU性能的报告,Patterson教授就是核心作者之一。5月4日的时候,Patterson教授也在斯坦福大学演讲,讲述了这份报告。报告中说,与同一代的英特尔处理和英伟达计算卡相比,TPU不仅运算速度要高15到30倍,相同功耗下的计算能力更是它们的30到80倍。

这份由75位工程师撰写的报告,也会提交给下个月在多伦多举行的计算机体系结构国际研讨会(ISCA)。这份报告是Patterson教授在谷歌的首演作品。他每周去山景城的谷歌总部一天、去旧金山的办公室两天。他的直接主管是在谷歌工作了18年的老将、Google Brain的总负责人Jeff Dean。

这并不是Patterson教授第一次帮谷歌做事,他2013到2014年学术休假的时候就在谷歌做了一些工作。这次,他作为资深工程师加入谷歌TPU开发项目。他加入的时候距谷歌首次在数据中心中使用TPU刚刚一年,距Patterson教授从学校退休仅两个月。

并不是真的退休

Patterson教授是一个从来不喜欢闲着的人。2013年的时候他参加了一项举重比赛,还打破了他那个年龄段成绩的加州记录。

Mark Hill博士说:“现在回过头来想,他不可能真的退休,我们只不过把那个晚会称作退休典礼而已。”他是Patterson教授1987年的博士生,也是典礼上的致辞者之一。

Hill博士现在是威斯康星大学麦迪逊分校计算机系的主任,在他看来,Patterson教授在计算机架构方面是“20世纪后50年里最杰出的几个人之一”。他说Patterson教授与Hennessy教授合著的那本计算机架构书是这个领域近25年来最有影响力的教科书。

谷歌声称TPU已经在全公司进行了大规模测试和使用。TPU不仅用在搜索命令的执行、地图和导航中,去年在首尔击败顶尖围棋选手李世石的AlphaGo也靠的是TPU。

不过谷歌并没有打算在半导体市场跟Intel和NVIDIA形成正面竞争。想要使用谷歌TPU强大计算能力的外部开发者只能使用谷歌的云计算服务和TensorFlow这样开源的机器学习库。

“谷歌制造的新工具是为了服务自己,而不是为了服务别人的”,初创深度学习公司Skymind的联合创始人和CEO Chris Nicholson这样说。“他们从来就不擅长做硬件,而且我觉得他们不会把硬件作为自己的目标”。

很可能会有创业公司去谷歌不做的这个方向里寻找机会。TPU项目里的几个工程师已经和投资人Chamath Palihapitiya建立起团队,准备成立一家起名叫Groq的创业公司。

TPU的生命才刚刚开始。不过目前它已经在深度学习的第二个阶段“推理”中展现出了高效的表现。第一个阶段是训练,目前据我们所知谷歌还是靠别家现成的处理器完成的。

不过谷歌也有对最前沿的项目保密的习惯,也许谷歌还开发了什么我们不知道的硬件。

在伯克利大学的演讲的时候,有人问Patterson教授他们团队下一步的规划是什么,不过Patterson教授没有上当回答他。

Patterson教授说他在谷歌学到了一件事情,就是与学术不同,他不能在公众场合讨论未来的产品。“我只能说谷歌从来都不会停下来。这段经历挺有意义的。他们从来不会放弃,也没有人被踢出团队。”

AI科技评论招聘季全新启动!

很多读者在思考,“我和AI科技评论的距离在哪里?”答案就是:一封求职信。

AI科技评论自创立以来,围绕学界和业界鳌头,一直为读者提供专业的AI学界、业界、开发者内容报道。我们与学术界一流专家保持密切联系,获得第一手学术进展;我们深入巨头公司AI实验室,洞悉最新产业变化;我们覆盖A类国际学术会议,发现和推动学术界和产业界的不断融合。

而你只要加入我们,就可以一起来记录这个风起云涌的人工智能时代!

如果你有下面任何两项,请投简历给我们:

*英语好,看论文毫无压力

*理工科或新闻相关专业优先,好钻研

*对人工智能有一定的兴趣或了解

* 态度好,学习能力强

简历投递:

深圳:lizongren@leiphone.com