开源工具推荐:高性能计算辅助工具MegPeak

在算力需求爆炸的大背景下,如何发挥出已有硬件的最大算力变得非常重要,直观一点是:我们需要对现有算法针对特定的处理器进行极致的性能优化,尽量满足目前 AI 算法对算力的高要求。

为了能够做到极致的性能优化,我们可能的方向有:

-

优化算法,使得算法能够在满足准确度前提下,访存和计算量尽量小 -

优化程序,使得实现这些算法的程序最大限度发挥处理器性能

在优化程序的过程中,首先要解决的问题是:如何评估程序发挥了处理器几成的算力,以及进一步优化空间和优化方向。

为了更懂我们的处理器,旷视 MegEngine 团队开发了一个工具 MegPeak,可以帮助开发人员进行性能评估,开发指导等,目前已经开源。点击文末的阅读原文,可了解更多 MegPeak 的使用方法、原理等。

GitHub项目地址:

https://github.com/MegEngine/MegPeak

通过 MegPeak ,用户可以测试目标处理器:

-

指令的 峰值带宽 指令延迟

内存峰值带宽

任意指令组合峰值带宽

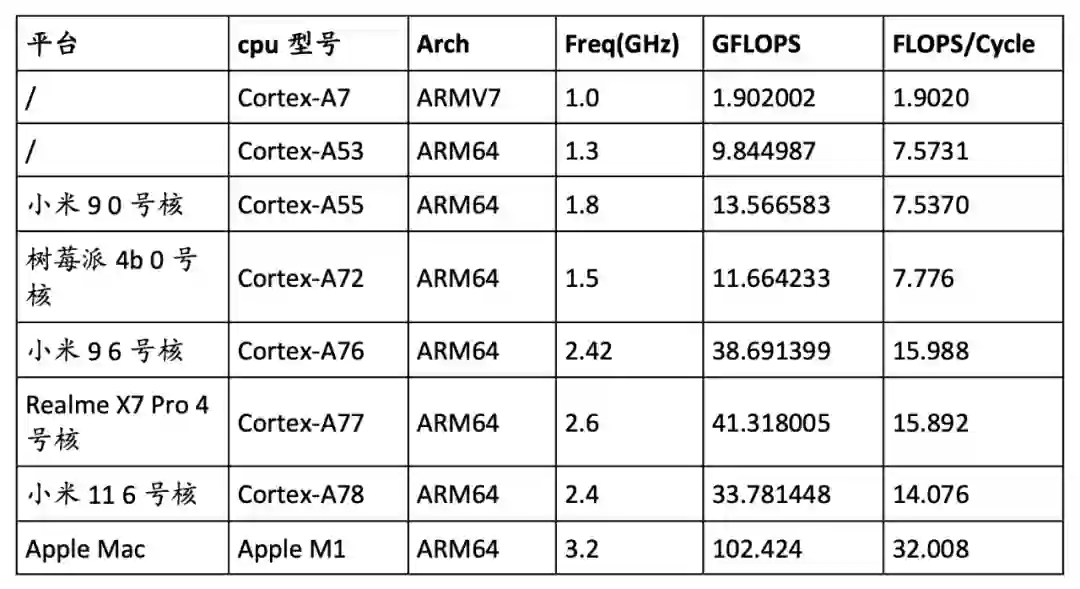

虽然上面的部分信息可以通过芯片的数据手册查询相关数据,然后结合理论计算得到,但是很多情况下无法获取目标处理器详尽的性能文档,另外通过 MegPeak 进行测量更直接和准确,并且可以测试特定指令组合的峰值带宽。MegEngine 团队使用 MegPeak 在几种常用 ARM 架构 CPU 上进行测试,根据对指令 fmla 的测试结果整理出下表。

其中,GFLOPS 指标可以衡量设备的算力,而 FLOPS/Cycle 指标可以帮助推测 CPU 的硬件特征。下面以 A55/A77/Apple M1 分别举例说明。

A55:由于每条指令 fmla 可执行两次浮点运算(包括一次乘法和一次加法),且测试得到的 FLOPS/Cycle 指标接近 8,故可以推测 A55 的后端执行单元有一个 128 位浮点向量乘加单元或有两个 64 位浮点向量乘加单元。

A77:其 FLOPS/Cycle 指标约为 16,所以每个周期 A77 可以执行 2 条 SIMD 的 fmla 指令,所以其后端有两个 SIMD fmla 执行单元,且后端至少是双发射的。

Apple M1:Apple M1 的 FLOPS/Cycle 指标达到了 32,说明其拥有 4 个 SIMD 执行单元。

MegPeak 可以测试出处理器的内存带宽,指令的理论计算峰值,指令的延迟等信息,因此可以帮助我们:

-

绘制 Roofline Model 指导我们优化模型性能 -

评估程序的优化空间 -

探索指令组合的理论计算峰值

另外 MegPeak 还可以提供对理论的验证,如我们通过处理器频率*单核单周期指令发射数量*每条指令执行的计算量可以计算出理论计算峰值,然后我们可以通过 MegPeak 进行实际测量进行验证。

绘制指令相关的Roofline Model

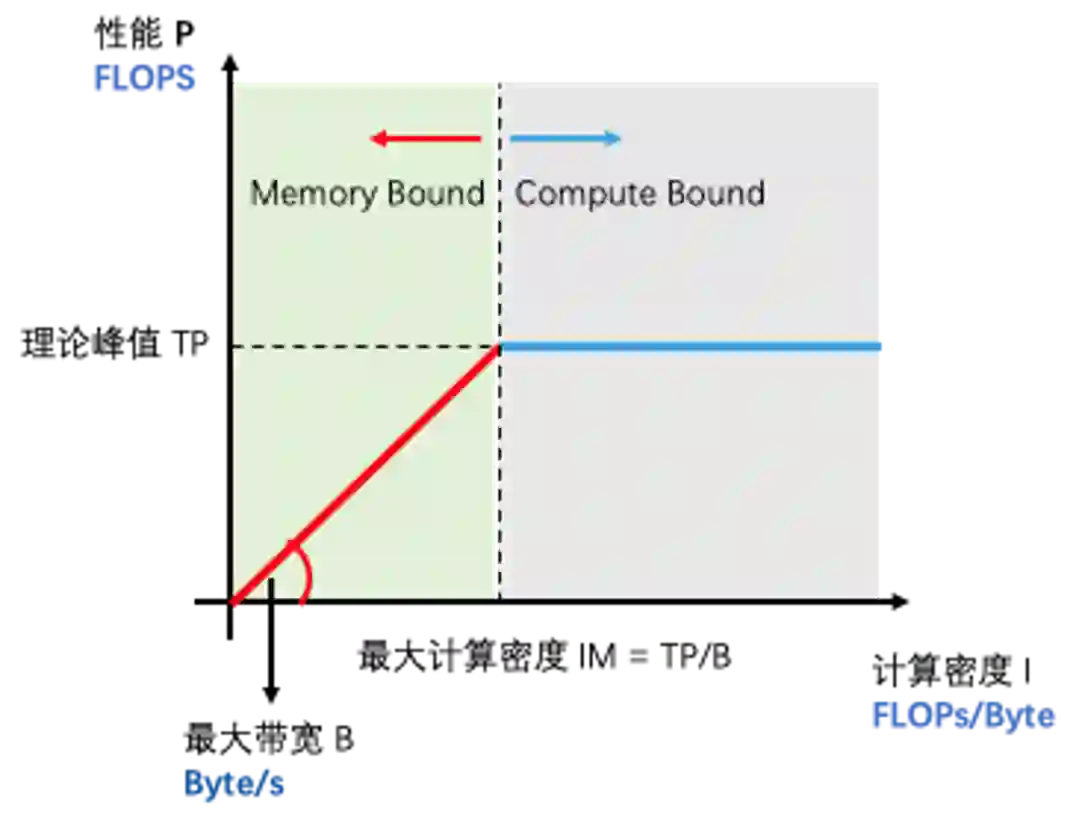

Roofline 模型被大量的使用在高性能计算中,是评估算法的可优化程度和优化方向的重要工具。使用 MegPeak 可以绘制出更加具体的关于指令对应的 Roofline 模型,如:在CPU中,不同的数据类型,虽然访存带宽不会改变,但是计算峰值差距比较大,比如在 arm 上 float 的计算峰值和 int8 的计算峰值差距很大。

评估代码优化空间

在优化具体算法的时候,可以通过 MegPeak 测试出 kernel 里面的主要指令的最大峰值,如在 Arm 上优化 fp32 Matmul 的时候,主要用到的指令是 fmla 指令,这时候可以测试程序实际运行的峰值,指令的峰值和程序的峰值差距越小,说明代码优化的越好。

另外,可以根据算法实现计算出计算量和访存量,并使用 MegPeak 绘制出上面的 Roofline,通过计算实际的计算密度,然后再对应到 Roofline 中,如果计算密度落在上图中的绿色区域,说明程序需要更多考虑优化访存,提供更优的访存模型,如分块,提前 pack 数据等。如果计算强度的点落在灰色区域说明,代码已经最优了,如果还想进一步提速,只能考虑从算法角度进行优化了,如:在卷积中使用 FFT,Winograd 等算法进行优化。

探索最优指令组合

很多 Kernel 的优化不是单纯的某一条指令就可以衡量,可能需要多条指令的组合才能代表整个 Kernel 的计算,因此我们需要探索如何组织这些指令使其达到处理器最优的性能。下面列举在 A53 小核优化 fp32 Matmul 的过程中,由于 Matmul 是计算密集型算子, 考虑通过多发射隐藏访存指令的开销,使用 MegPeak 配合进行分析,探索如何组合指令实现尽可能多的多发射。

因为小核上面资源有限,指令多发射有很多限制:

首先使用 MegPeak 测试出 A53 上 fp32 的 fmla 指令的计算峰值,将其定义为 100% 峰值计算性能。

测试哪些指令组合可以支持双发射:

-

在 MegPeak 中添加 vector load 和 fmla 1:1 组合的代码,然后测试其峰值仅仅为 float 峰值的 36%,表明 Vector load 和 fmla 不能双发射 -

同样可以测得通用寄存器 load 指令 ldr+fmla 的组合可以达到 float 峰值的 93%,说明 ldr 可以和 fmla 双发射 -

同上可以测得 ins + fmla 能双发射,ins + vector load 64 位可以双发射

根据 Matmul 最内层 Kernel 的计算原理,如最内层 Kernel 的分块大小是 8x12,那最内层需要读取:20 个 float 数据,计算 24 次 fmla 计算。

结合上面的 MegPeak 测试的信息,我们需要找到用最少时钟完成这 20 个 float 数据 load,和 24 次 fmla 数据计算的指令组合,因此需要将尽可能多的数据 load 和 fmla 进行双发射,隐藏数据 load 的耗时。

最后的指令组合是:

-

使用 vector load 64 指令 + ldr + ins 组合成为一个 neon 寄存器数据,因为 ldr 和 ins 都可以和 fmla 双发射,把他们和 fmla 放在一起可以隐藏他们的耗时 -

在这 3 条指令中穿插 fmla 指令,并尽可能解决数据依赖

根据上面的指令组合可以使得 Matmul 在小核上达到计算峰值的 70% 左右。

MegPeak 作为一个进行高性能计算的辅助工具,能够使得开发人员轻松获得目标处理器的内在的详细信息,辅助进行对代码的性能评估,以及优化方法设计。但是 MegPeak 也有一些需要丰富的方向:

1. 支持获取更多的处理器性能数据,如:L1,L2 cache 的大小,自动探索各种指令组合的双发射情况,并大概绘制出一个处理器后端的缩略图。如:

https://en.wikichip.org/w/images/5/57/cortex-a76_block_diagram.svg •

2. 支持测量移动端 OpenCL 的更多细节信息,如:warp size,local memory 大小等。

如果有同学对上面的功能感兴趣,欢迎大家提交代码。最后欢迎大家使用 MegPeak。

🔍

现在,在「知乎」也能找到我们了

进入知乎首页搜索「PaperWeekly」

点击「关注」订阅我们的专栏吧