18-23期VALSE Webinar会后总结

俄勒冈州立大学李伏欣教授2018年8月1日VALSE Webinar 成功举办。

李伏欣,Fuxin Li is currently an assistant professor in the School of Electrical Engineering and Computer Science at Oregon State University. Before that, he has held research positions in University of Bonn and Georgia Institute of Technology. He had obtained a Ph.D. degree in the Institute of Automation, Chinese Academy of Sciences in 2009. He (co-)won the PASCAL VOC semantic segmentation challenges from 2009-2012, and led a team to the 4th place finish in the DAVIS Video Segmentation challenge 2017. He has published more than 40 papers in computer vision, machine learning and natural language processing. His main research interests are deep learning, video object segmentation, multi-target tracking, structural prediction and human understanding of deep learning.

李伏欣教授Webinar的题目为:Some Understandings and New Designs of Recurrent and Convolutional Network Structures.

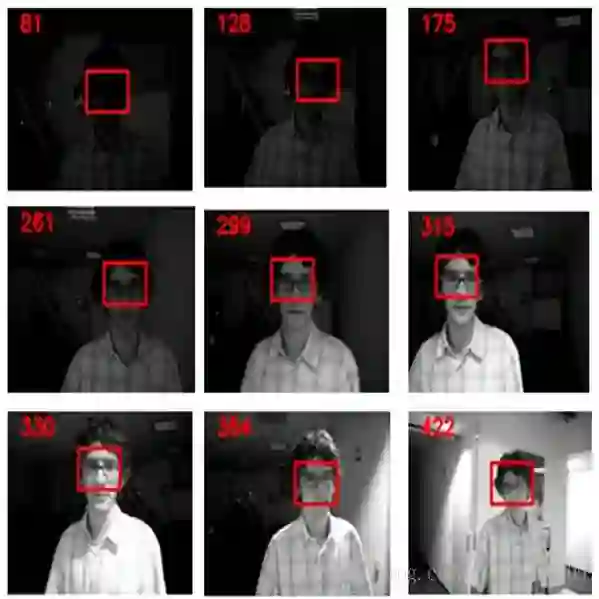

在报告中,李伏欣教授介绍了自己最近工作:关于如何理解和改革LSTM和CNN架构。在第一部分,李伏欣教授首先回顾了LSTM在多目标跟踪中的经验,指出了目前LSTM在长时多目标跟踪中的不同,进而基于经典的循环最小二乘模型,提出了一种新颖的适合多目标跟踪的双线性LSTM模型;新模型在MOT2016和2017两个竞赛中显著地超越传统LSTM。在第二部分,李伏欣教授从不同的角度介绍了对于CNN的理解,包括理解CNN泛化能力的Gaussion复杂度理论和重新设计了特定非自然图像领域的CNN卷积核;同时还提出了解释神经网络,用来生成人能理解的深度网络视觉解释。

问答部分:

问题1:请问bilinear LSTM的名字如何来的,这个bilinear体现在?

回答:bilinear体现在 LSTM与输入是乘的关系,LSTM这边是linear模型,CNN这边也是linear的模型。

问题2:bedroom关注到矩形是不是和训练数据本身有很大的关系?

回答:确实是。explanation neural network (XNN)本身是解释CNN网络,CNN网络训练的时候从训练数据中找到这样的特征。因此可以看出CNN是怎么做的,如果CNN确实是overfit到这些特征上,可以看出来。

问题3:motion lstm是什么?

回答:输入时bounding box 的坐标,输出是predict下一帧的bounding box 的坐标,中间是lstm。

问题4:双线性LSTM的设计当中,转化成的矩阵没有任何约束吗?

回答:是一个长方矩阵,没有任何约束。

问题5:请问bilinear LSTM最多是多少帧?

回答:测过160帧,其实并没有性能的提升。最后用的大概是40-80帧。

问题6:直接使用数据训练?

回答:是的。

问题7:MOTA和IDF1这两个指标的区别?谁更可靠?

回答:MOTA中有每一帧detection的位置,然后减掉identity switch的个数。MOTA指标过于偏重detection的位置,只要位置对,MOTA就高,但这和tracking没有太大的关系。IDF1需要把identity在整个video中维持住,才能达到高的效果。因此IDF1是个更好的指标。

问题8:请问有没有试过更advance的lstm网络?

回答:目前还没有,下一步的工作中会尝试。

问题9:解释Deep Learning时,思想是不是将CNN特征降维来理解?在降维时,同时考虑分类,稀疏性和正交性?请结合鸟和bedroom的例子来阐述一下?

回答:是这样的。稀疏性是指稀疏重建,即重建原来4000维特征的一部分。鸟和bedroom的例子中显示的特征来自于这4000维特征,但我们没有重建所有的特征。用最少数量的特征满足分类。如果没有重建的话是不能有解释性的,因为可以直接用CNN的输出来解释CNN的输出,完全faithful,但是人没办法理解。有了重建这个loss function才有了人可以理解的解释。正交性是希望不同的特征尽量不同。

问题10:请问LSTM的motion model是在某个tracking数据集上预训练的吗,能学出来motion pattern吗,如果是应用到具体的tracking sequence上,还需要online training吗?

回答:是预训练的。Lstm在应用时不需要online training,它在测试sequence上使用中会自动学习新的pattern。

问题11:特征很多是串联或者是相加,那在其他任务上用乘法会不会更好?

回答:希望大家如有兴趣,在更多任务上尝试这一方法。

问题12:请问bLSTM-MOT方法怎么体现了end-to-end training?

回答:确实是end-to-end training的。因为是把整个sequence输入进LSTM,然后输出可以判断一个新的帧是否match整个的sequence。并且除了还使用了MHT以外没有更多的后处理。其它方法有些需要做帧和帧之间的matching,或者motion部分用的不是深度学习方法。

问题13:请问老师,XNN中如果不加入正交约束,通过热图显示的关键区域是否会改变?

回答:会改变。如果不加正交约束,在某些dataset可能不work,会在好几个不同的x-feature(给人解释的feature)中出现同样的热区。

问题14:请问tracking的目前的challenge是什么?

回答:MOT已经不再更新了,目前有一些新的dataset。具体新的challenge需要再查询。

问题15:请问在卷积核范围内的像素越接近泛化性能越好,那么为什么在图片中加入噪音后相邻像素不接近,也会避免过拟合呢?

回答:加噪声,在所有图上平均之后会更接近。可能跟具体公式还有点不同。

问题16:请问lasso优化,比如您提到的求解滤波器形状和cnn训练如何结合?

回答:请看我们的ICLR 2017论文,上面有详细解释。

问题17:在目标存在遮挡的时候有什么好的判断准则吗

回答:基本上是threshold,根据算法算出一个分数,然后基于threshold做一个判断。

问题18:请问多人交换互相遮挡并被景物遮挡导致的ID switch有什么好的解决思路吗?

回答:希望bLSTM的方法能不需要做特殊处理就解决此问题吧。

问题19:请问xnn能解释bilinear lstm吗?

回答:下一步的工作。

问题20: 卷积核一开始设计的是3*3的 您展示的结果图中的形状各异 是怎么由3*3的核变换而来的 ?

回答:不是从3*3变化而言,而是从auto-correlation中学习出来的。细节请看下ICLR 2017文章。

问题21:你们bLSTM中的运动特征是采用AMIR中的运动预测方法吗?

回答:不是。自己训练了一个类似的,而且是和appearance部分jointly训练的。

问题22:对于【XNN】的paper,在解释部分的特征个数是如何选择的,PPT中鸟和床的解释特征都是2个?

回答:实际发现很少超过3个特征。即使选用7个,一般也是2到3个特征。尤其是鸟。

问题23:Milan的RNN-LSTM能直接得到跟踪结果,bLSTM MOT得到的结果是匹配结果还是boxbouding?

回答:匹配结果。我们试过直接预测bounding box坐标,效果不好,Milan的paper效果也不好,可能那个太难了。

问题24: 请问explanation neural network目标函数中orthogonality部分前的系数是什么?

回答:是个参数。有设参数的方法,可以参见我们将要发布的code。

问题25:请问单目标跟踪的相关滤波方向还有发展的空间吗?

回答:难讲。它还是非常好的方法,也许可以和deep learning结合。

问题26:如果是各种不同的鸟的分类,xNN的生成的特性应该会多一些吧?

回答:是的。目前是一类一类做的,因为不同的鸟不知道如何选取合适的子集。

问题27:bLSTM代码能公开吗?

回答:在代码清理好之后会公开在github上。

问题28:能否再简述一下Gaussian complexity理论解释CNN形状和尺寸的思想?

回答:不针对某一张图。在整个训练集中所有pixel的相关性,找出CNN形状,保证泛化性。有boundary的地方是特征,CNN学习特征来达到训练集上的分类精度, 大部分pixel之间没有boundary,保证泛化性。

录像视频在线观看地址:

http://www.iqiyi.com/u/2289191062

PPT链接:

http://vision.ouc.edu.cn/valse/slides/20180801/VALSE_Slides_new(1).pdf

特别鸣谢本次Webinar主要组织者:

VOOC责任委员:杨猛(中山大学)

VODB协调理事:王瑞平(中科院计算所)

活动参与方式:

1、VALSE Webinar活动依托在线直播平台进行,活动时讲者会上传PPT或共享屏幕,听众可以看到Slides,听到讲者的语音,并通过聊天功能与讲者交互;

2、为参加活动,请关注VALSE微信公众号:valse_wechat 或加入VALSE QQ群(目前A、B、C、D、E、F、G群已满,除讲者等嘉宾外,只能申请加入VALSE H群,群号:701662399);

*注:申请加入VALSE QQ群时需验证姓名、单位和身份,缺一不可。入群后,请实名,姓名身份单位。身份:学校及科研单位人员T;企业研发I;博士D;硕士M。

3、在活动开始前5分钟左右,讲者会开启直播,听众点击直播链接即可参加活动,支持安装Windows系统的电脑、MAC电脑、手机等设备;

4、活动过程中,请不要说无关话语,以免影响活动正常进行;

5、活动过程中,如出现听不到或看不到视频等问题,建议退出再重新进入,一般都能解决问题;

6、建议务必在速度较快的网络上参加活动,优先采用有线网络连接;

7、VALSE微信公众号会在每周一推送上一周Webinar报告的总结及视频(经讲者允许后),每周四发布下一周Webinar报告的通知及直播链接。