GANs合辑 | 国庆特辑

国庆节来了,社长我也休息一下。

借此机会,把我们之前发过的内容做一次总结,也方便大家查阅~

今天带来的是GANs合辑。

GANs从去年火起来之后,应用范围越来越广,我们也在努力的跟上,所以也发了一些文章。

每篇文章之间的联系不强,大家可以根据摘要选择文章去读。(封面图这个幽默,你懂了么?)

大家可以把本文收藏下来,这样方便回过头来向各个章节跳转。

GAN 学习指南:从原理入门到制作生成 Demo,总共分几步?

生成式对抗网络(GAN)是近年来大热的深度学习模型。最近正好有空看了这方面的一些论文,跑了一个 GAN 的代码,于是写了这篇文章来介绍一下 GAN。

本文主要分为三个部分:

介绍原始的 GAN 的原理

同样非常重要的 DCGAN 的原理

如何在 Tensorflow 跑 DCGAN 的代码,生成如题图所示的动漫头像,附送数据集哦 :-)

本文会从头介绍生成对抗式网络的一些内容,从生成式模型开始说起,到 GAN 的基本原理,InfoGAN,AC-GAN 的基本科普,如果有任何有错误的地方,请随时喷,我刚开始研究 GAN 这块的内容,希望和大家一起学习。

GAN 网络是近两年深度学习领域的新秀,火的不行,本文旨在浅显理解传统 GAN,分享学习心得。现有 GAN 网络大多数代码实现使用 Python、torch 等语言,这里,后面用 matlab 搭建一个简单的 GAN 网络,便于理解 GAN 原理。

GAN 的鼻祖之作是 2014 年 NIPS 一篇文章:Generative Adversarial Net,可以细细品味。

● 分享一个目前各类 GAN 的一个论文整理集合

● 再分享一个目前各类 GAN 的一个代码整理集合

2017 年 4 月 21-23 日,VALSE(视觉与学习青年学者研讨会)在厦门举行,国内 CV 领域顶级专家学者齐聚一堂,参会的青年学者达 2000 多人。在 VALSE 的「年度进展评述」环节,共有 12 名学者依次上台,对 CV 研究和应用分支领域近年发展做了详细系统的梳理,堪称「12 颗重磅炸弹」。针对近年来 CV 领域火热的方向之一:GAN,哈尔滨工业大学计算机学院教授左旺孟从多方面做了详尽的评述报告。

啦啦啦,现今 GAN 算法可以算作 ML 领域下比较热门的一个方向。事实上,GAN 已经作为一种思想来渗透在 ML 的其余领域,从而做出了很多很 Amazing 的东西。比如结合卷积神经网络,可以用于生成图片。或者结合 NLP,可以生成特定风格的短句子。(比如川普风格的 twitter......)

可惜的是,网络上很多老司机开 GAN 的车最后都翻了,大多只是翻译了一篇论文,一旦涉及算法实现部分就直接放开源的实现地址,而那些开源的东东,缺少了必要的引导,实在对于新手来说很是懵逼。所以兔子哥哥带着开好车,开稳车的心态,特定来带一下各位想入门 GAN 的其他小兔兔们来飞一会。

可能是最好玩的深度学习模型:CycleGAN 的原理与实验详解

CycleGAN 是在今年三月底放在 arxiv 的一篇文章,文章名为 Learning to Discover Cross-Domain Relations with Generative Adversarial Networks,同一时期还有两篇非常类似的 DualGAN 和 DiscoGAN ,简单来说,它们的功能就是:自动将某一类图片转换成另外一类图片。

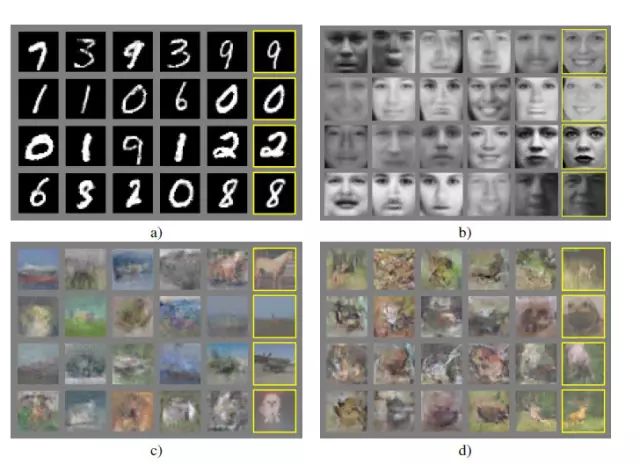

GAN 从 2014 年诞生以来发展的是相当火热,比较著名的 GAN 的应用有 Pix2Pix、CycleGAN 等。本篇文章主要是让初学者通过代码了解 GAN 的结构和运作机制,对理论细节不做过多介绍。我们还是采用 MNIST 手写数据集(不得不说这个数据集对于新手来说非常好用)来作为我们的训练数据,我们将构建一个简单的 GAN 来进行手写数字图像的生成。

此前我们曾编译了一篇英文教程,详细介绍了如何基于 PyTorch 平台用 50 行代码实现 GAN(生成对抗网络),详情参见:在 PyTorch 上跑 GAN 只需要 50 行代码,不试试?近期,针对文中介绍的 “50 行代码 GAN 模型”,有开发者指出了局限性,并基于此模型给出了改进版本,也就是本文将要介绍的 “130 行代码实现 GAN 二维样本”。

对于图像问题,卷积神经网络相比于简单地全连接的神经网络更具优势。

本文将继续深入 GAN,通过融合卷积神经网络来对我们的 GAN 进行改进,实现一个深度卷积 GAN。

如果还没有亲手实践过 GAN 的小伙伴可以先去学习一下上一篇专栏:生成对抗网络(GAN)之 MNIST 数据生成。

本次代码在 NELSONZHAO/zhihu/dcgan,里面包含了两个文件:

dcgan_mnist:基于 MNIST 手写数据集构造深度卷积 GAN 模型

dcgan_cifar:基于 CIFAR 数据集构造深度卷积 GAN 模型

本文主要以 MNIST 为例进行介绍,两者在本质上没有差别,只在细微的参数上有所调整。由于穷学生资源有限,没有对模型增加迭代次数,也没有构造更深的模型。并且也没有选取像素很高的图像,高像素非常消耗计算量。

本节只是一个抛砖引玉的作用,让大家了解 DCGAN 的结构,如果有资源的小伙伴可以自己去尝试其他更清晰的图片以及更深的结构,相信会取得很不错的结果。

Generative Adversarial Network,就是大家耳熟能详的 GAN,由 Ian Goodfellow 首先提出,在这两年更是深度学习中最热门的东西,仿佛什么东西都能由 GAN 做出来。我最近刚入门 GAN,看了些资料,做一些笔记。

上次带大家写了原始版的 GAN,只生成了高斯分布。但兔子哥哥发现在 GAN 论文的底下,有 GAN 生成图片的 example。

因此,这足以说明 GAN 亦有能力生成图片,并非只有 DCGAN 才能生成图片,这一点与我学 GAN 之前的认知大为不同。于是我就开始尝试了使用原始的 GAN 来尝试生成图像,但接下来,我就开始怀疑人生了。

在开始的时候我采用了 MINST 的数据集,按照我上一篇文章兔子哥哥带你从零写一个 GAN 中提及的训练 GAN 的方式中连续训练原始 GAN 多次,得到的仍然全是噪点,并没有一点手写数字的影子。

在尝试多次后,未免让我怀疑我是不是读了假论文,自己是不是一只假兔子。

在查阅多番资料后,在知乎偶遇到,令人拍案叫绝的 Wasserstein GAN - 知乎专栏 (下文简称 WGAN) 一文,不读不知道,读了简直惊为天人。读完之后,我打消了原本打算去学习 DCGAN 的念头,改成继续学习 WGAN。因此,本文兔子哥哥将会带读者一起来领略一下 WGAN 的风采。

文章目录如下:

为什么原始 GAN 训练困难重重?

WGAN 是什么鬼?

WGAN 的个人一些使用经验总结

自 Ian Goodfellow 之后,GANs 还有哪些开拓性进展?

本文由作者 Adit Deshpande 总结,AI 研习社编译整理。Adit Deshpande 目前是 UCLA 计算机科学专业生物信息学方向的大二学生。他热衷于将自己的机器学习和计算机视觉技术应用在健康领域,给医生和患者带来更好的解决方案。

一直以来,Adit Deshpande 都有总结和解释一些深度学习论文的习惯,在本文中,Adit Deshpande 将围绕对抗生成网络(GANs)的主题来展开介绍。

基于生成对抗网络的图像编辑方法—优必选悉尼 AI 研究院王超岳

近些年来,生成对抗网络在许多图像生成和图像编辑任务上都获得了很大的成功,并受到越来越多的关注。对于图像编辑任务,现在面临的两个重要的挑战分别是:如何指导网络向目标图像学习(以提升图像编辑的效果)和如何感知输入图像内容(以提升图像编辑的精度)。

悉尼科技大学 FEIT 三年级博士生,优必选悉尼 AI 研究院访问学生,陶大程教授学生王超岳在 AI 研习社主办的学术青年分享会上结合他的两篇论文 Tag Disentangled Generative Adversarial Networks for Object Image Re-rendering(IJCAI 2017 Best student paper)和 Perceptual Adversarial Networks for Image-to-Image Transformation(arXiv 2017),分享了对图像编辑做出的相应探索。

新人福利

关注 AI 研习社(okweiwu),回复 1 领取

【超过 1000G 神经网络 / AI / 大数据,教程,论文】

入门合辑,不知道该怎么入门的可以看这里 | 国庆特辑

▼▼▼