谷歌特斯拉之争:谁能解开自动驾驶“电车难题”的道德困境?

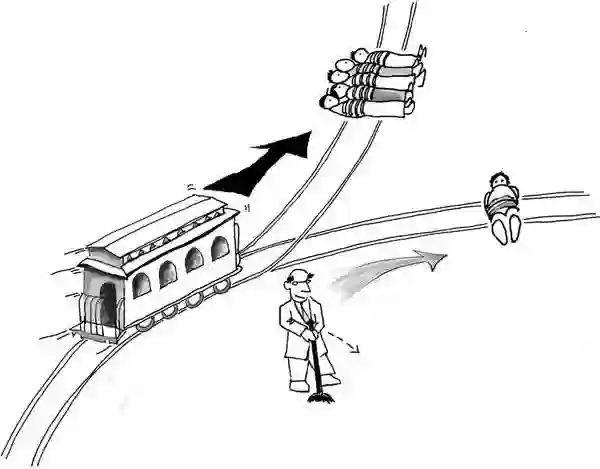

伦理学中,有一个经典的“电车难题”。

如果你看到一辆失控的电车在轨道上高速行驶,电车前方有5个毫不知情的行人。你是否会选择扳动轨道,撞死另外1个无辜的人,拯救这5个人的生命?

如果把这个两难问题套在自动驾驶身上,面临的道德抉择一点都不会减轻。相反,以效率和数字衡量生命价值的做法,将会遭受更严肃的诘问。

不久前,谷歌自动驾驶前CTO克里斯·厄姆森(Chris Urmson),受母校卡内基梅隆大学机器人研究所下属的矢田晃子机器人学纪念讲座邀请做演讲时,讲述了工程师眼中的“终极难题”。

从口吻中,我们可以明显感觉到他的观点:这是一个无聊的讨论。但他仍然提供了论据。此外,他还分享了自动驾驶面临的两大挑战,以及特斯拉和谷歌所坚持的两种技术流派纷争。

厄姆森2009年加入谷歌,任职于谷歌X实验室。2016年8月,他离开谷歌,随后与斯特林·安德森(Sterling Anderson)以及德鲁·巴格奈尔(Drew Bagnell)共同创办了自动驾驶公司Aurora Innovation。

这是一个相当豪华的团队。除厄姆森外,其他两人也都是自动驾驶领域大牛级的人物。安德森毕业于麻省理工学院,曾任特斯拉Autopilot项目总监;巴格奈尔毕业于卡内基梅隆大学,曾是Uber计算机视觉业务负责人。三个人都拥有计算机博士学位。

本文由创新工场(微信ID:chuangxin2009)根据厄姆森的演讲整理,同时结合了我们对自动驾驶的理解。登录YouTube可以观看讲座完整视频(https://youtu.be/BtgBySRrN0Q),转载请联系场工(微信1023396007)。

自动驾驶两大挑战:

数据不完备,“人类意图”不理解

厄姆森在演讲中提到,自动驾驶目前面临两个挑战,一个是大数据不够完备,一个是机器对理解“人类意图”有极大困难。

自动驾驶要精准有效地解决问题,需要尽可能地保证所收集到的大数据的完备性。但事实是,我们现在所掌握的数据漏洞百出。

厄姆森引用了一个官方统计的数据。2015年,美国有630万起警方记录的交通事故,造成3.5万人死亡,244万人受伤。而据他估计,实际的交通事故数量可能是官方数据的2-10倍。

在谷歌期间,厄姆森一共经历了200公里以上的路面测试,其中出现了25次交通事故,但大部分都没有引发警方的注意。

“这样的情况多是小事故,自动驾驶汽车做出了合理的判断,刹车,然后人类撞了上来。”厄姆森说,很多事故往往都是这样发生的。

另外一个挑战,是自动驾驶汽车需要理解、匹配人类司机的想法,包括本车司机,以及其他汽车的司机,而理解人类意图极为困难。

厄姆森举了几个交通事故案例,都是由于自动驾驶汽车对人类意图理解不准确而引发的。

一个是谷歌汽车与公交车相撞。2016年2月14日情人节,谷歌的一辆无人驾驶汽车,在山景城(Mountain View)交叉路口变道时与公交车相撞。当时无人车的行驶速度不到每小时2英里,而公交车的行驶速度约为每小时15英里。

据事故报告,公交车从后方驶来,被谷歌汽车阻挡了路线。在决定变道前,谷歌汽车判断道路剩余的空间十分狭窄,公交车不会继续向前,而公交车司机则觉得自己可以开过去,没有减速,两车因此相撞。

另一个是优步翻车事件。2017年3月24日,优步公司的自动驾驶汽车在亚利桑那州上路测试时,被后车追尾,导致测试车侧翻。

当时,优步自动驾驶汽车行驶在三车道最左边的一道,右边两车道发生了堵车。有一位人类司机想左拐穿过车道,可能在穿越车道时没有看到优步的车,在驶入最左边车道时发生了翻车。警察后来称,优步无需为此事故担责。

特斯拉的策略不可取,

辅助驾驶到无人驾驶有巨大鸿沟

厄姆森将自动驾驶技术分为两个流派,特斯拉为一派,谷歌为一派。

特斯拉一派主张自动驾驶应“从辅助驾驶逐步发展到无人驾驶”;而谷歌则认为,对自动驾驶应有100%的高标准要求,即便在短期内无法进行商业化开发。

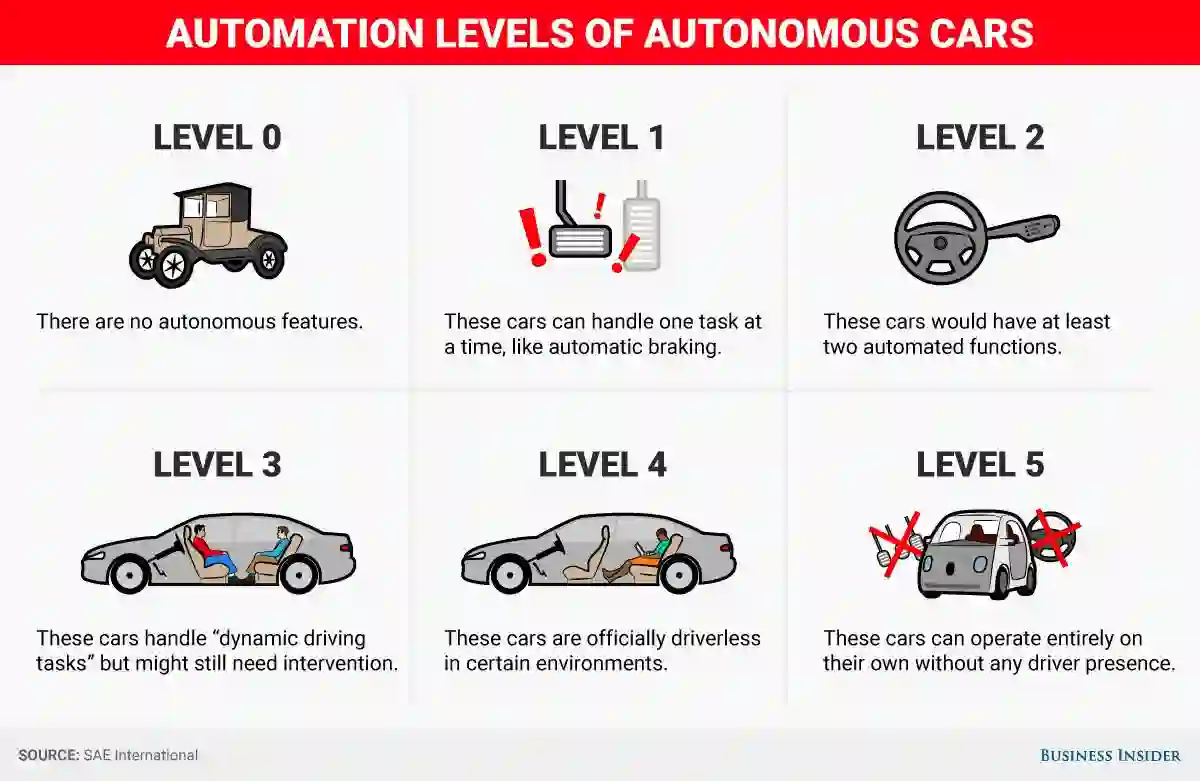

特斯拉和谷歌争论的基础,是自动驾驶过于宽泛的概念界定。目前,业界普遍采用的理论,是国际汽车工程师学会(SAE international)在2014年发布的自动驾驶的六级分类体系。它将自动驾驶分为从0到5六个级别,如下图所示:

按照SAE的分级标准,第1级和第2级技术是辅助驾驶,由机器辅助人类完成自动防碰撞、定速巡航、自动泊车等功能。第3级才属于自动驾驶的范畴。但即使是第3级的自动驾驶,人类驾驶员也必须随时待命,处理机器无法解决的特殊情况,不能在汽车上看手机、上网或者玩游戏。但事实上,很多人做不到这样。

2016年5月7日,发生在佛罗里达州的特斯拉电动汽车致死事故,原因之一就是车主过度信任特斯拉的Autopilot模式(属于第2级自动驾驶技术),对突发情况没能做出及时的人工干预。

为了验证这一点,谷歌曾做过一个有趣的实验。他们在内部招募了一批志愿者,每人发了一辆测试用途的自动驾驶汽车,并告知他们:用于测试的汽车并不完善,仍然需要志愿者坐在驾驶位置,随时准备应对汽车无法处理的路面突发情况。

但谷歌发现,志愿者几乎很少听从这个忠告。因为在绝大多数情况下,谷歌自动驾驶汽车表现得非常好,完全可以自如应对路面上发生的各类复杂情况。这样一来,几乎每个志愿者都会100%放心地将驾驶操作交给汽车,自己则利用乘车的时间,做起任何自己想做的事情来:有乘车时看地图的,有乘车时看视频的,有乘车时躺在后座打盹儿的,有乘车时跟女友亲热的……

这次测试让谷歌明白了一点:一旦自动驾驶汽车达到了足够高的水平,车内乘客就会想当然地将所有操控权交给汽车。无论这时候自动驾驶汽车的软件是否还有风险,无论路面上那些极端的路况是不是能被自动驾驶汽车正确处理,车主都不会保持100%的高度警觉。

因此,谷歌认为,要保证自动驾驶的绝对安全,就一定不能依赖于人的参与,必须让自动驾驶汽车的人工智能技术能够应对所有(至少是极其接近100%的)极端路况。

追求最佳的安全和行驶体验,商业化开发就会被拖缓。这让谷歌自动驾驶团队在许多新闻评论中成了“起个大早、赶个晚集”的揶揄对象。可能也是因为这样,谷歌自动驾驶团队很多技术人员都已离开谷歌,其中就包括厄姆森。

不过厄姆森这次站在老东家一边。他认为,技术发展到一定阶段,就必须放弃人类的干涉。如果执着于开发辅助驾驶技术,会限制我们发展具备完全无人驾驶能力的技术。

创新工场(微信ID:chuangxin2009)认同厄姆森和谷歌的观点。从商业化的视角来看,第2级或第3级的自动驾驶技术,将来只会被用于有限的场合,而直接面向第4级甚至第5级的自动驾驶,才是未来最大的商业机会。

不应用“电车难题”考验自动驾驶

在衡量自动驾驶合理与否时,一个经典的两难问题——“电车难题”经常会被抛出来。

“电车难题”可大致表述为:一辆失控的有轨电车正在加速驶来,前面的轨道上有5个小孩在玩耍,来不及通知并且片刻后就要碾压到这些小孩。幸运的是旁边正好还有一条轨道,但是上面也有1个小孩。在这种情况下,司机是否应该选择变轨?

厄姆森认为,尽管这是一个非常有意义的哲学问题,却不应该以此来衡量是否应当将这项技术推入市场,否则便会“苛求完美而阻碍了伟大的技术”。

事实上,在理解这个问题时,大多数人脑子里会有一个先入为主的道德假设,那就是人类驾驶员造成的事故,已经被视为现行伦理道德体系中的一种客观存在,是人类自身的弱点导致的。但自动驾驶造成事故时,因为操控主体由人变成机器,即便能挽救更多人的生命,这种伦理道德仍然很难被接受。

厄姆森认为,汽车不应当被置于这样的困境中。“如果真的到了这一步,你就已经搞砸了。”无人驾驶汽车应当是保守、安全优先的驾驶员,会预测并避免这类情况出现。“它们不会突然才发现,然后去警告你。”

一个更常面临的困境,可能是保护车主还是行人。厄姆森说,这种情况出现时,汽车应当是有预案的,能够告诉车主并让他做出选择。

“比如,汽车可能会告知车主,行人的安全更重要,那就会为了保护行人而危及车主安全。这样明确的设定要优于人类反应,因为紧急情况发生时,人类往往缺乏足够的判断时间,只能靠本能行事。”(完)

本文由创新工场原创,欢迎转发至朋友圈,转载请联系场工(微信1023396007)

欢迎关注创新工场微信公众号:chuangxin2009。这是一个创新工场和创业者的沟通交流平台,您可以学习创业相关的法务、市场、财务、HR等各个业务领域所需的知识干货,还有机会参与到创新工场举办的创业者培训、沙龙和其他各类活动中。

● 李开复于纽约哥伦比亚大学工程学院毕业典礼演讲| 一个工程师的人工智能银河系漫游指南

● 李开复的美国来信